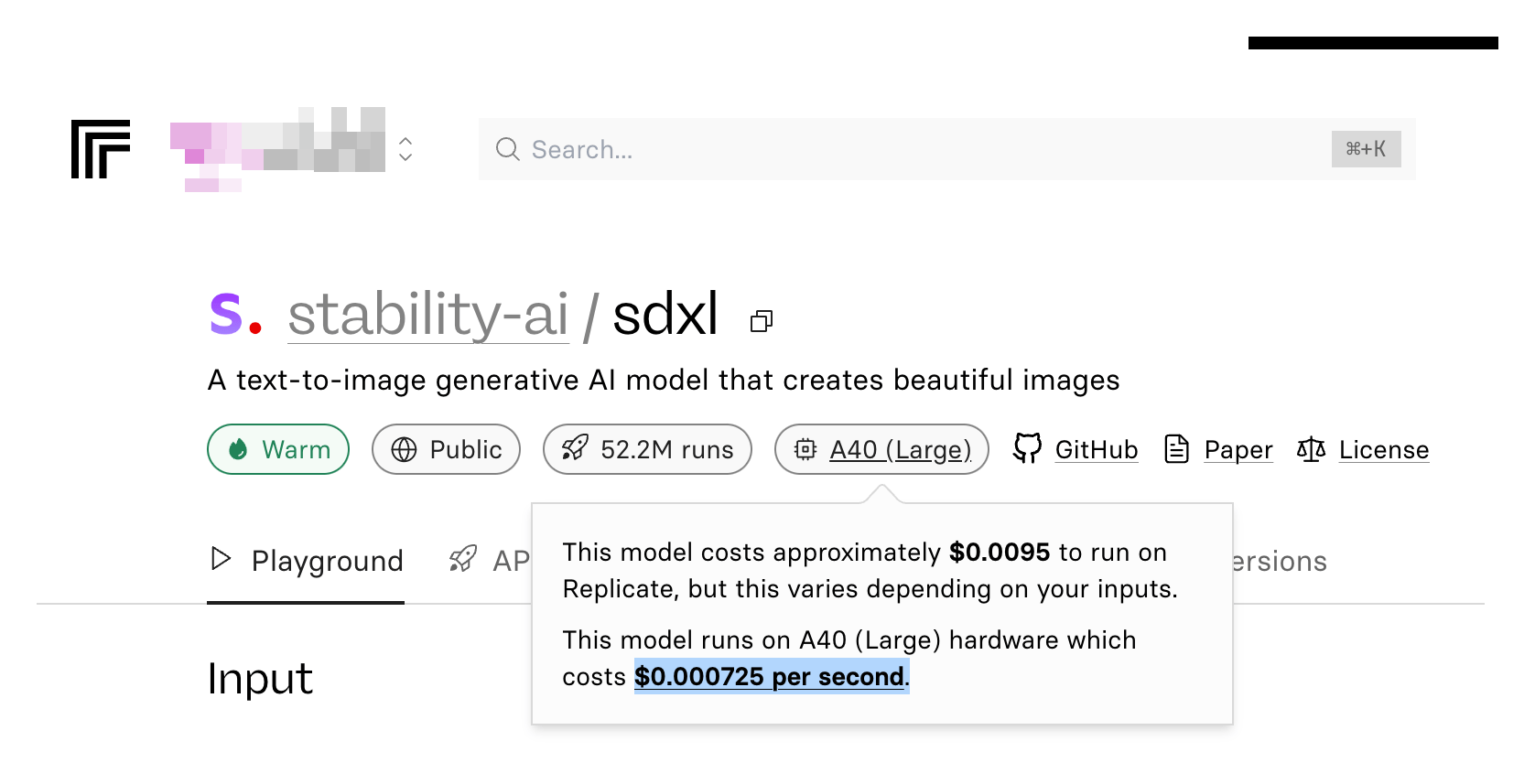

「Replicate」は、クラウド上のGPUを利用して、Llama 3などの大規模言語モデルや、Whisperなどの音声認識モデル、Stable Diffusionなどの画像生成AIなどを、誰でも簡単に実行できるプラットフォームだ。

初心者であっても、ReplicateのWebサイト上で好きなAIモデルを見つけて、実際にブラウザ上で使うことができる。

プログラミング知識ゼロでも、OpenAIが開発する最新の音声認識AI(Speech-to-Textモデル)であるWhisper v3を使って音声の文字起こしが行えたり、Stable Diffusionを使って好きな画像を生成したりできるので、そのメリットは大きい。

また、中上級者・開発者にとっても、Replicateから提供されているAPIを使うことで、Replicate上に存在するAIモデルを、高性能なクラウドGPUを使って自分のアプリ上で動かすこともでき、とても有用なサイトだ。

本記事では、全く知識のない初心者を対象に、Replicateに新規登録をしてから、以下の2つのAIモデルを実際に使ってみるまでの手順を、分かりやすく解説していく。

- OpenAIの音声認識AI「Whisper」を使って、会議音声などのmp3ファイルを正確に文字起こしする

- Stability AIが開発する画像生成モデル「Stable Diffusion XL」を使って、イラストを生成してみる

特に文字起こしは、仕事や学校の授業などでも、会議や講義の録音ファイルをテキスト化できて非常に便利なので、知っておいて損はない。

また、Stable Diffusionについても、Replicateなら高性能なGPUを使って数秒での超高速の画像生成が可能なので、ローカルPC上でStable Diffusionを使用している人は、一度Replicateのスピードを体験してみると良い。

Replicateは無料?アカウントを作成する手順

Replicateの利用料金プラン

Replicateは、使用した時間に応じて1秒単位でGPUの利用コストがかかる。

ただし、初めてアカウントを作成すると、トライアルとして一定時間の無料枠が付与されるので、最初にいろいろ試してみるだけなら完全無料だ。無料期間中はクレジットカードの登録も不要なので、安心して試すことができる。

まずはアカウントを作成してみて、いろんなAIモデルを試してみよう。その中で、実用的かつ自分が気に入って頻繁に利用するものがあったら、ちょっとずつ課金して使ってみれば良い。

またもし仮に課金するとしても、自分で買うと1台で数百万円するような超高スペックのGPU(Nvidia A100、A40などなど)を、1時間あたり2ドルとか4ドルとか、非常に安価に利用できるので、それほどお金はかからない。

例えば、Replicate上に公開されている音声認識AI「Whisper」のカスタムモデルを使って、NVIDIA A40 (Large) を使って文字起こしを行うと、10分間の日本語の音声ファイルを、わずか3.6セント(=約5.6円)ほどでテキスト化できた。

1時間の会社の会議の録音ファイルを書き起こしても、30円ほどで済む計算なので、節約できる労力を考えれば全然問題ない。もちろん、もっとスペックの低いGPUを使えば、スピードが落ちる代わりに、さらに価格は安くなる。

Replicateアカウントの作り方

Replicateに会員登録をするには、Githubでのログインが必要なので、あらかじめGithubのアカウントを作らなければならない。

Githubのトップページにアクセスして、「Sign up」ボタンからメールアドレスなどを登録してアカウントを作成しておこう。

Githubのアカウントが準備できたら、ReplicateのWebサイトにアクセスして、右上の「Sing in」をクリックする。

すると、Githubのアカウントでのログインを要求されるので、先ほど作成したGithubのアカウント情報を入れてログインする。

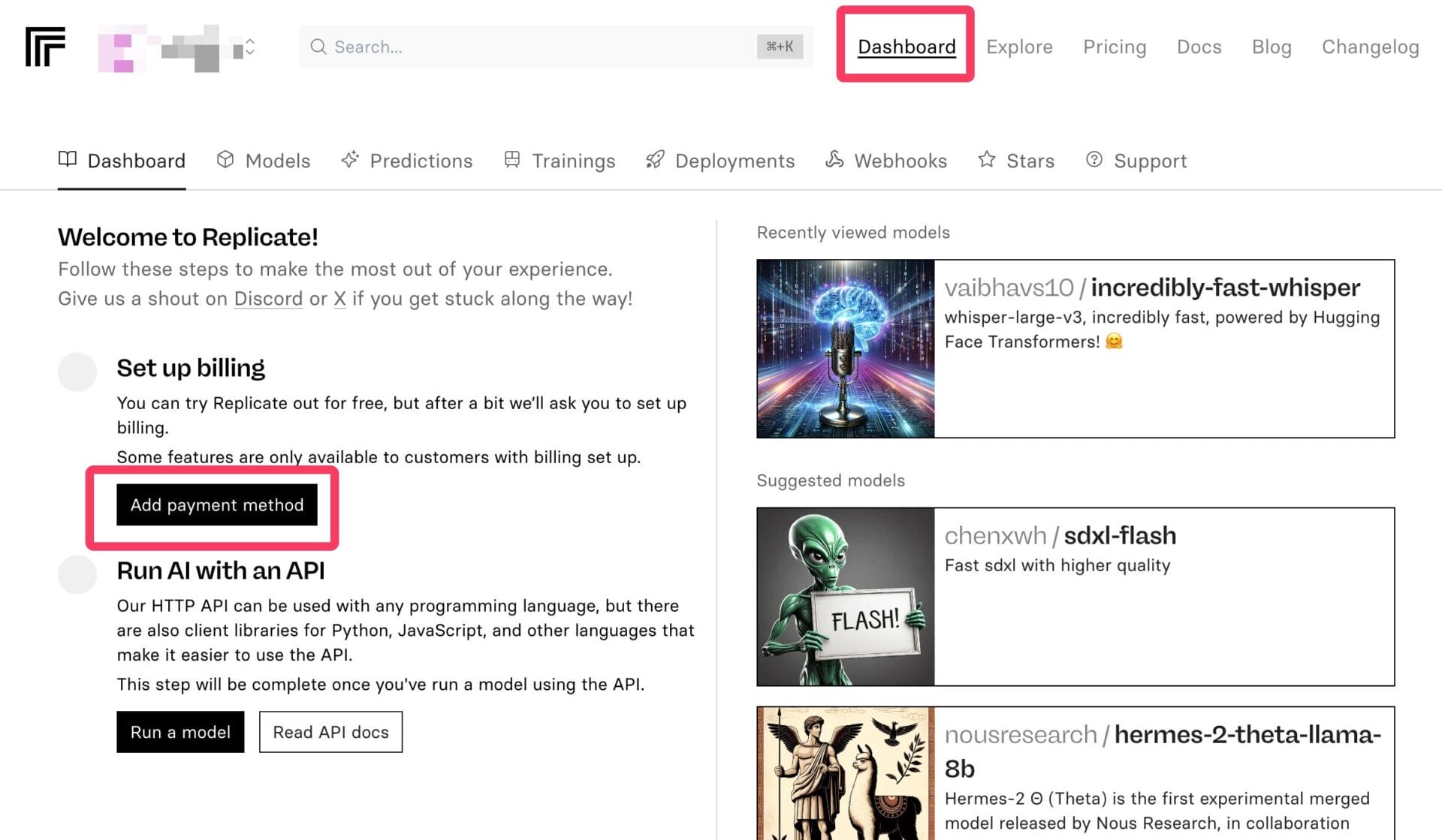

ログインすると「Dashboard」というアカウント情報の管理ページがメニューに現れる。

初回はアンケートなどがいろいろと表示されるが、それらを終えて「Dashboard」にアクセスすると、「Add payment method」からクレジットカード情報を登録できたりする。

ただし、上述の通り、無料枠を使い切るまでは支払い情報の登録も不要なので、しばらくは色んなモデルを触って遊んでみよう。

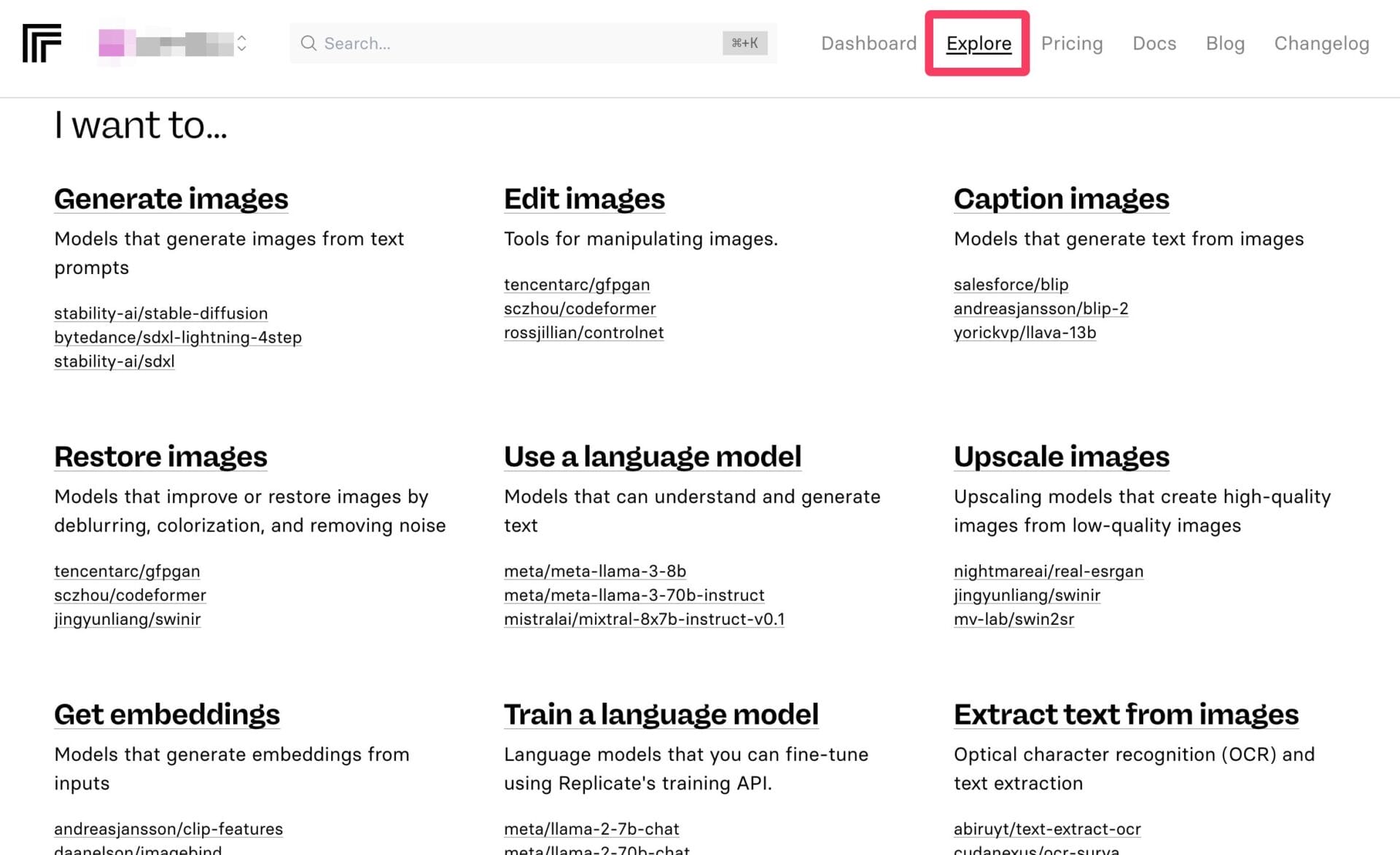

ReplicateでのAIモデルの探し方

Replicateでは、自分のカスタムAIモデルをアップロードして、それをReplicateが提供するクラウドGPUマシン上で動かすことも可能だが、他の人が公開しているモデルを利用するのが中心になる。

OpenAIや、Stability AIなどの大手AIモデル開発者が自ら公開していることもあれば、個人が公開モデルをカスタマイズしたバージョンが人気になっていることもある。

そうしたAIモデルを探すには、「Explore」タブをクリックすると、目的別に整理されたリストを閲覧できる。

例えば、画像を生成したいならStable Diffusionなどが、大規模言語モデルを使いたいならLlama 3などが、画像を高画質化したいのであればReal-ESRGANなどがリスト化されている。

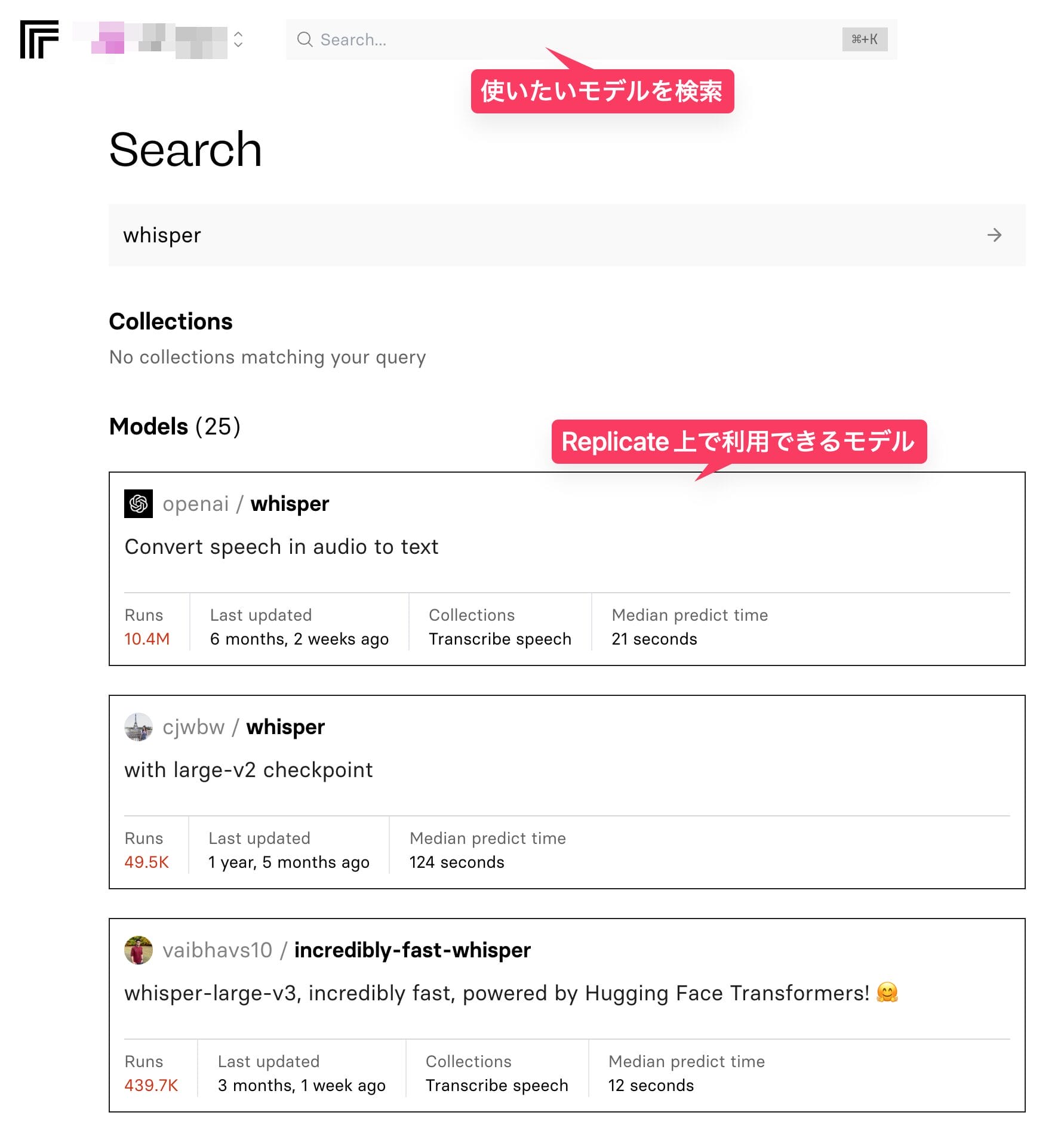

もしくは、すでに使用したいモデルが決まっている場合は、上部の検索バーにモデル名を入れると、Replicate上に公開されているモデルの中から、条件にヒットしたモデルが表示される。

例えば、音声認識AIの「Whisper」で検索してみると、OpenAI公式のモデルと、個人が作成したカスタムモデルが全部で25個ヒットした。

以下では、特に実用性が高く、仕事などでも使う可能性が高いAIモデルを3つピックアップして、Replicate上で実際に使ってみた様子を紹介していく。

OpenAIの音声認識AI「Whisper」で文字起こし

講義の文字起こしや、会議の議事録作成など、使用場面も多いであろう音声認識AI(Text-to-Speechモデル)を使ってみる。

代表的なモデルは、ChatGPTなどで知られているOpenAIが公開している「Whisper」シリーズだろう。現在はバージョン3のモデルが無料で公開されており、Replicate上にも実装されている。

「Whisper」というモデル名で検索をして、OpenAIが公式で提供しているReplicateのWhisper v3モデルにアクセスしてみよう。

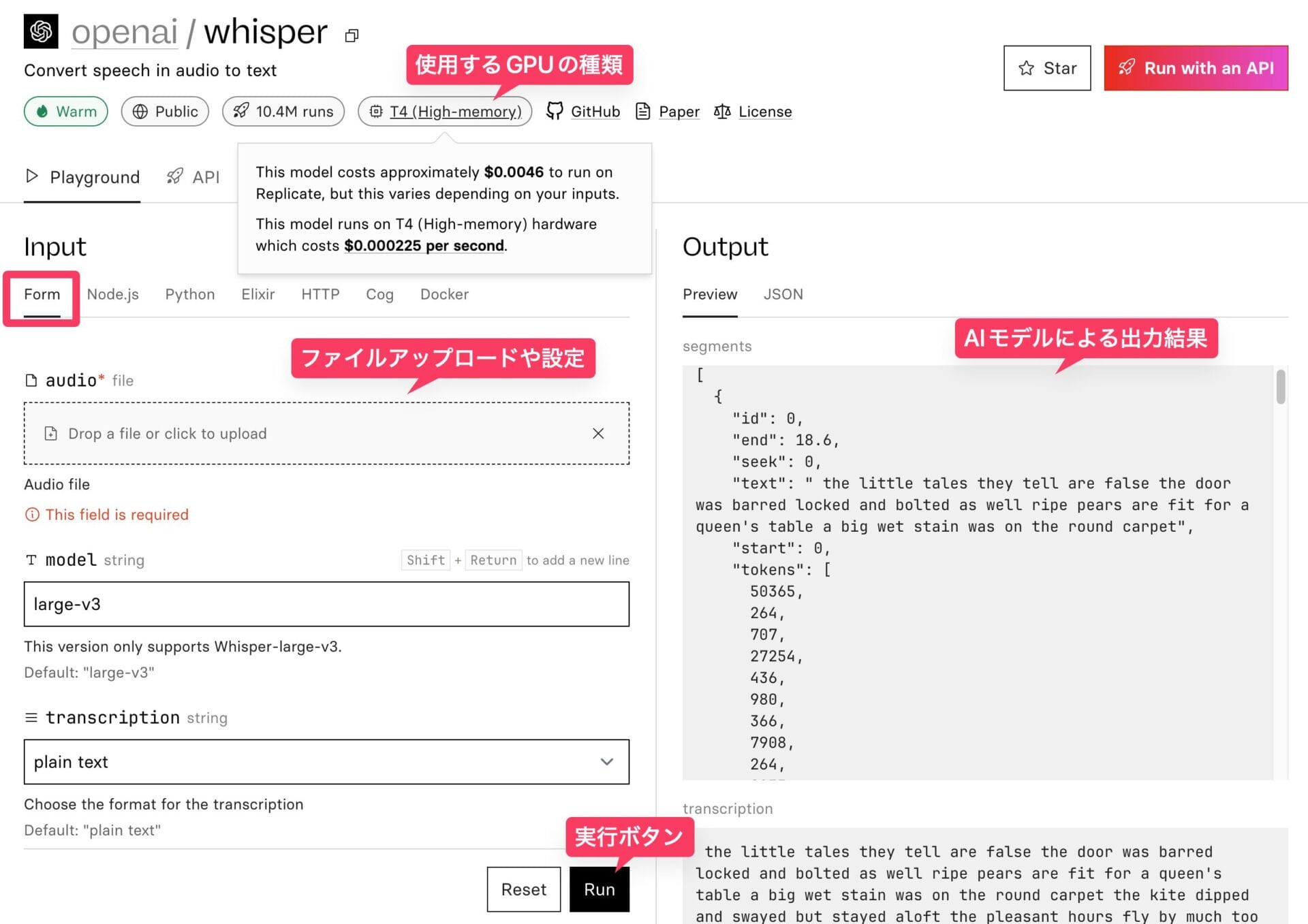

プログラミングの知識がある人は、API経由でReplicate上のモデルを呼び出すこともできるが、知識がない初心者であっても、最も簡単に使えるのは、ブラウザ上のフォーム形式だ。

モデルのページにアクセスすると、左側にユーザーによる入力フォームがあり、下部にある「Run」という実行ボタンを押すと、右側にAIによるアウトプットが表示される。

画面上部には、使用するGPUの種類が表示されている。GPUの種類によって、1秒あたりの利用料金は変動する。無料期間中は気にする必要はないが、OpenAIのwhisperの場合、1秒あたり0.000225ドル(=約0.03円)の「T4」という比較的低スペックなGPU上で動作することが分かる。

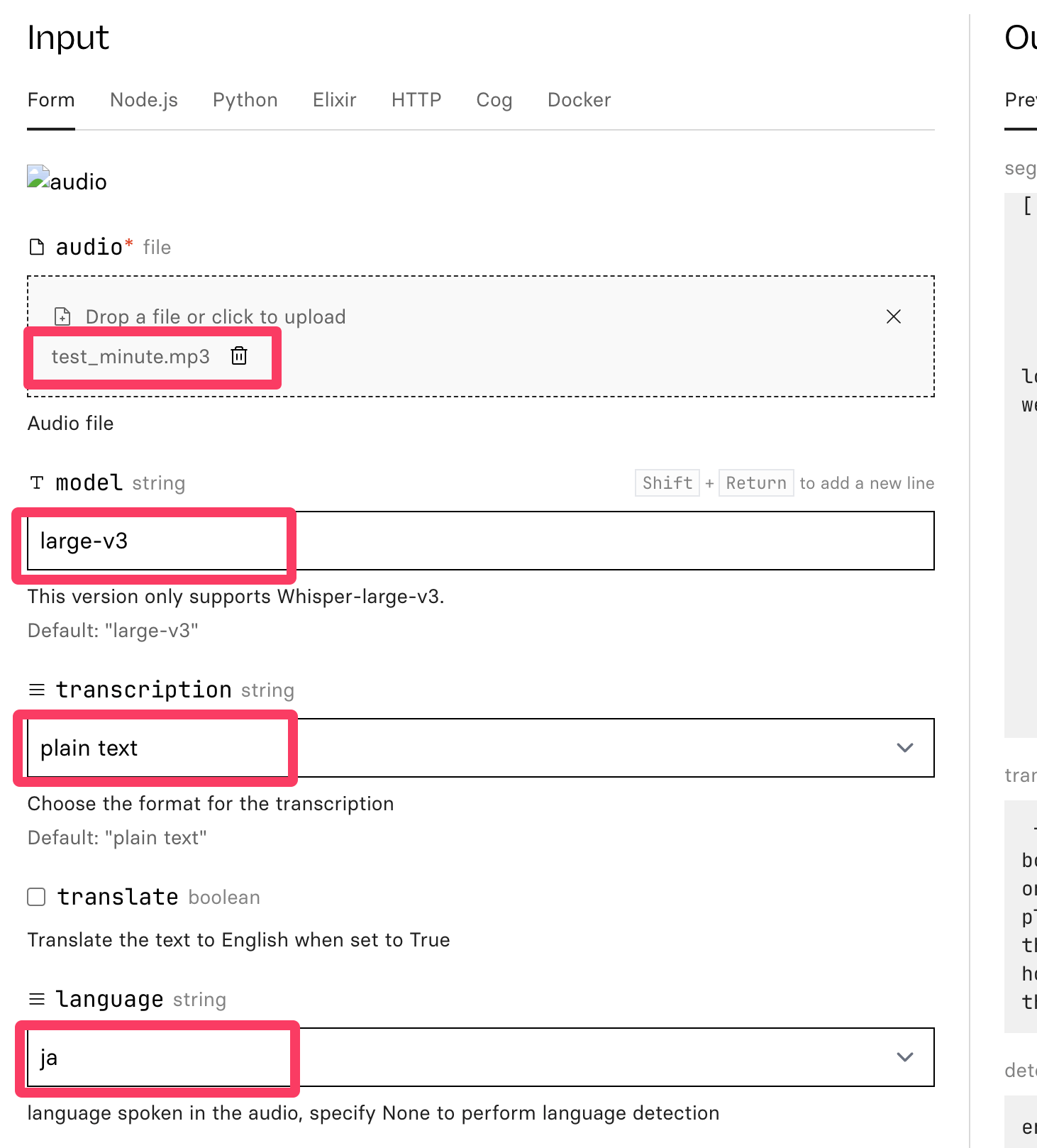

実際に、自分で喋っている音声を録音した1分間の.mp3ファイルを用意して、どれほどのスピードで文字起こしができるのかを試してみる。

かなり細かい設定項目もあるが、以下の4つさえ選んでおけば基本的に問題ない。

- 音声ファイル(

test_minute.mp3というボイスメモを用意した) - Whisperモデルのバージョン(

large-v3という最新の最も大きなモデルを使う) - 結果の表示方法(平文で表示してほしいので

plain textを選ぶ) - 音声の言語(日本語の録音ファイルなので、

jaを選択)

これらを設定した上で「Run」ボタンをクリックすると、Whisperによる文字起こしが始まり、処理が完了次第、画面右側に文字起こしの結果が表示される。

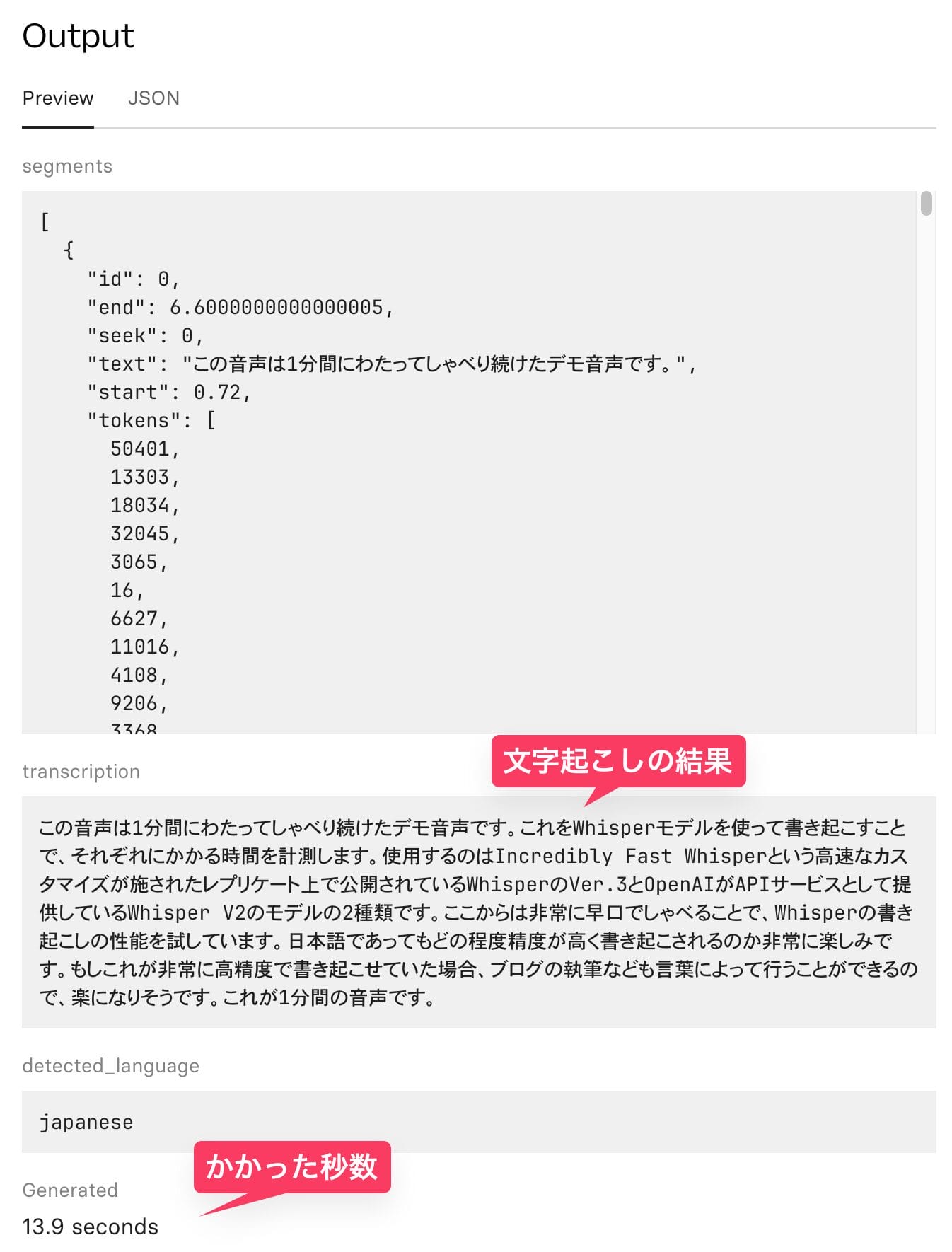

1分間の日本語の音声が、13.9秒で文字起こしされ、聞き間違いなどなく正確にテキスト化されている。英語と日本語が混ざるような文章も、ある程度正確に和文と英文が書き分けられており驚かされる。

仮に無料期間が終わったとしても、T4 GPUで0.000225ドル×13.9秒=0.0031ドル(=約0.46円)しかかからないので、1円以下で1分のテキストの書き起こしが瞬時に実行できたことになる。

ここまではOpenAI公式のモデルを使用したが、個人が作成しているカスタムモデルを、より高速なGPUで使用することもできる。

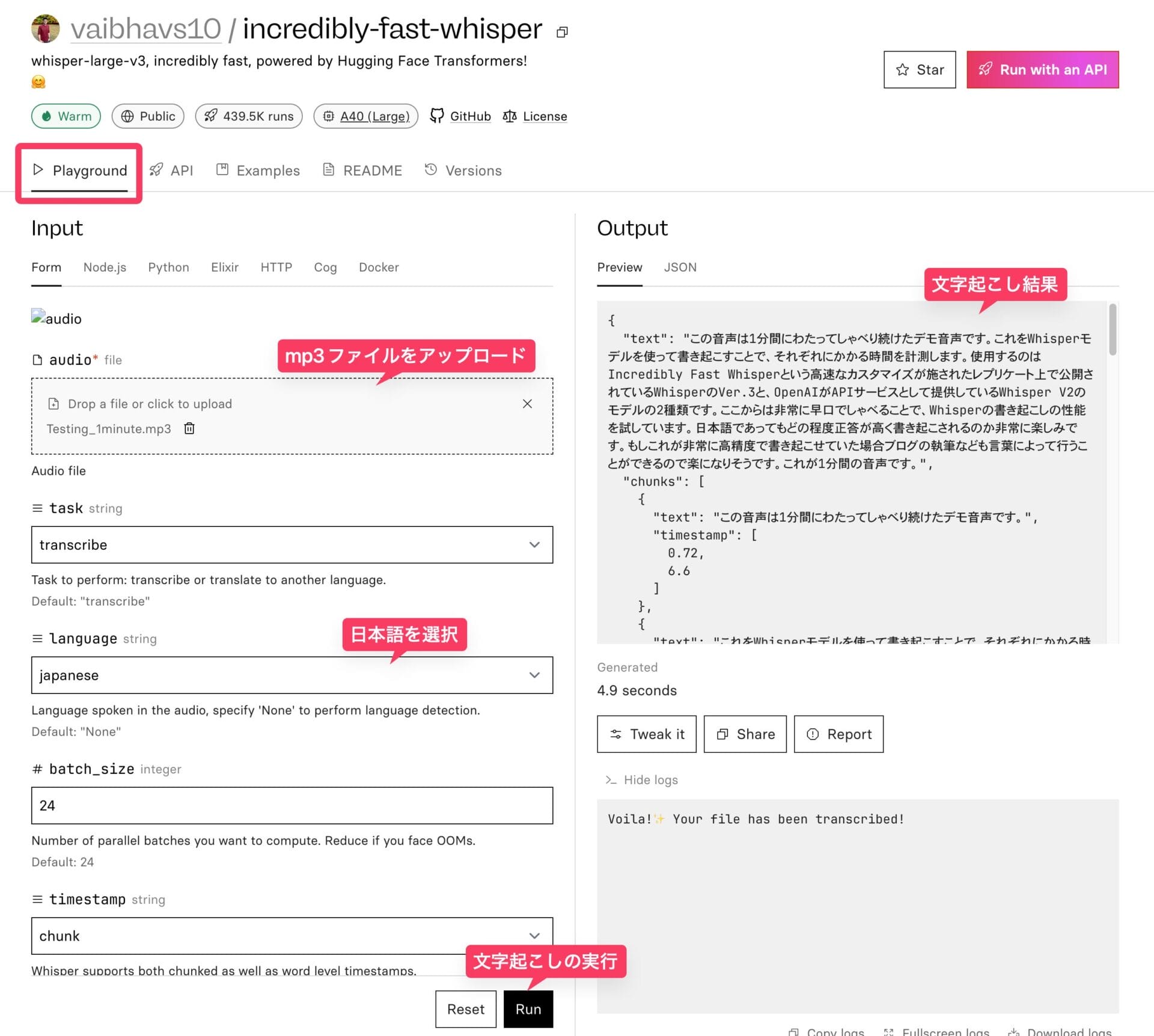

例えば、Vaibhav Srivastav氏がReplicate上で公開しているvaibhavs10/incredibly-fast-whisperモデルは、その名の通り、「すっごい速いWhisper」である。

こちらのモデルは、通常のWhisperよりも高速に書き起こしができるように様々な工夫が施されており、150分の音声を100秒で文字起こしできる、とまで謳われている。

使用しているGPUも、よりハイスペックなA40 (Large) であり、その分1秒あたりの利用料金も0.000725ドルと、T4よりは高くなる。

先ほどと同じく、1分間の音声ファイルをアップロードして、言語を日本語に設定し、「Run」ボタンを押してみる。

T4上で動作するOpenAIのWhisperは13.9秒かかっていたが、A40上で動作するIncredibly-Fast-Whisperは4.9秒で同じファイルを文字起こしすることができた。

1時間を超える音声ファイルを文字起こししたい場合など、スピードが重要な場合には、Incredibly-Fast-Whisperを利用した方が時間効率が上がるだろう。

なお、OpenAIが自社で提供しているWhisperのAPIは、同じファイルを4.3秒で文字起こしできたので、もっと高スペックなGPUを使用していると思われる。

OpenAIのAPIの方がわずかに高速だとはいえ、プログラミング知識がない人がAPIを使うのは難しいし、ブラウザ上で非常に手軽に使えるReplicate上で、OpenAIのAPIとほぼ変わらないスピードで文字起こしを利用できるのは、非常に嬉しい。

また、料金で比べても、OpenAIのWhisper APIは、音声の長さ1分あたり0.006ドルという料金設定であるところ、Incredibly-Fast-Whisperは、1分の音声を4.9秒で処理でき、処理1秒あたり0.000725ドルだ。

したがって、1分の音声の文字起こしかかる料金は、0.000725×4.9秒=0.0035ドルなので、Whisper APIの半額ほどで利用できることになる。

Stability AIの画像生成AI 「Stable Diffusion XL」でイラスト生成

Replicate上には、画像生成AIであるStable Diffusionも公開されているので、ブラウザ上で最新のAIによる画像生成も実行することができる。

Stable Diffusionを開発しているStability AI公式によって公開されているSDXLモデルを、実際にブラウザ上で使用してみよう。

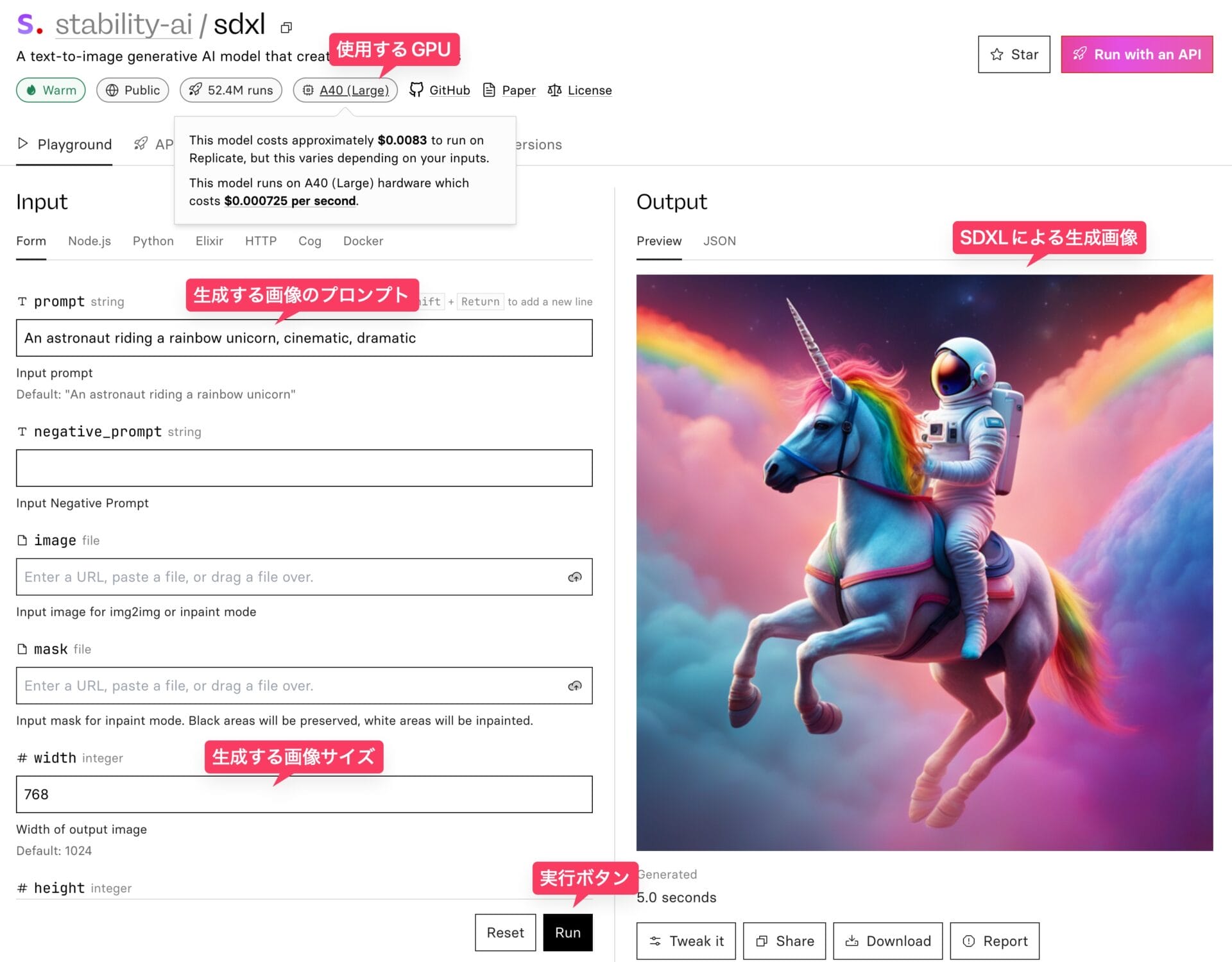

stability-ai/sdxlのページにアクセスすると、左側に生成する画像のプロンプト文やサイズの指定などを行うメニューがあり、「Run」ボタンをクリックすると、右側に画像が生成される。

stability-ai/sdxlで使用されているGPUは、上で紹介したIncredibly-Fast-Whisperと同じNVIDIA A40 (Large)なので、画像生成にかかる時間1秒につき0.000725ドルを要する。

以下のような設定でイラストを生成してみて、画像1枚の生成に何秒かかるかを試してみた。

- Prompt: Japanese girl, street, summer, tokyo, comic, anime

- width: 1024(生成する画像の横幅)

- height: 1024(生成する画像の縦幅)

- num_outputs: 1 (生成する画像の枚数)

そのほかはデフォルトの設定のままとした。すると、以下のようなイラストが生成された。生成にかかった時間はわずか6.9秒だ。

無料トライアルの範囲でも十分使用できるし、仮にGPUの1秒あたりのコストを支払ったとしても、0.75円くらいの計算なので、たくさんのイラストを生成しても数円で済む。

当サイトで導入方法を紹介している通り、Stable DiffusionはMacBookなどのラップトップPCでも動作するが、強力なGPUがないとイラスト1枚の生成に平気で1分間以上かかることもザラなので、6秒で1024px * 1024pxのイラストを生成できるのはGPUクラウドならではの超高速だ。

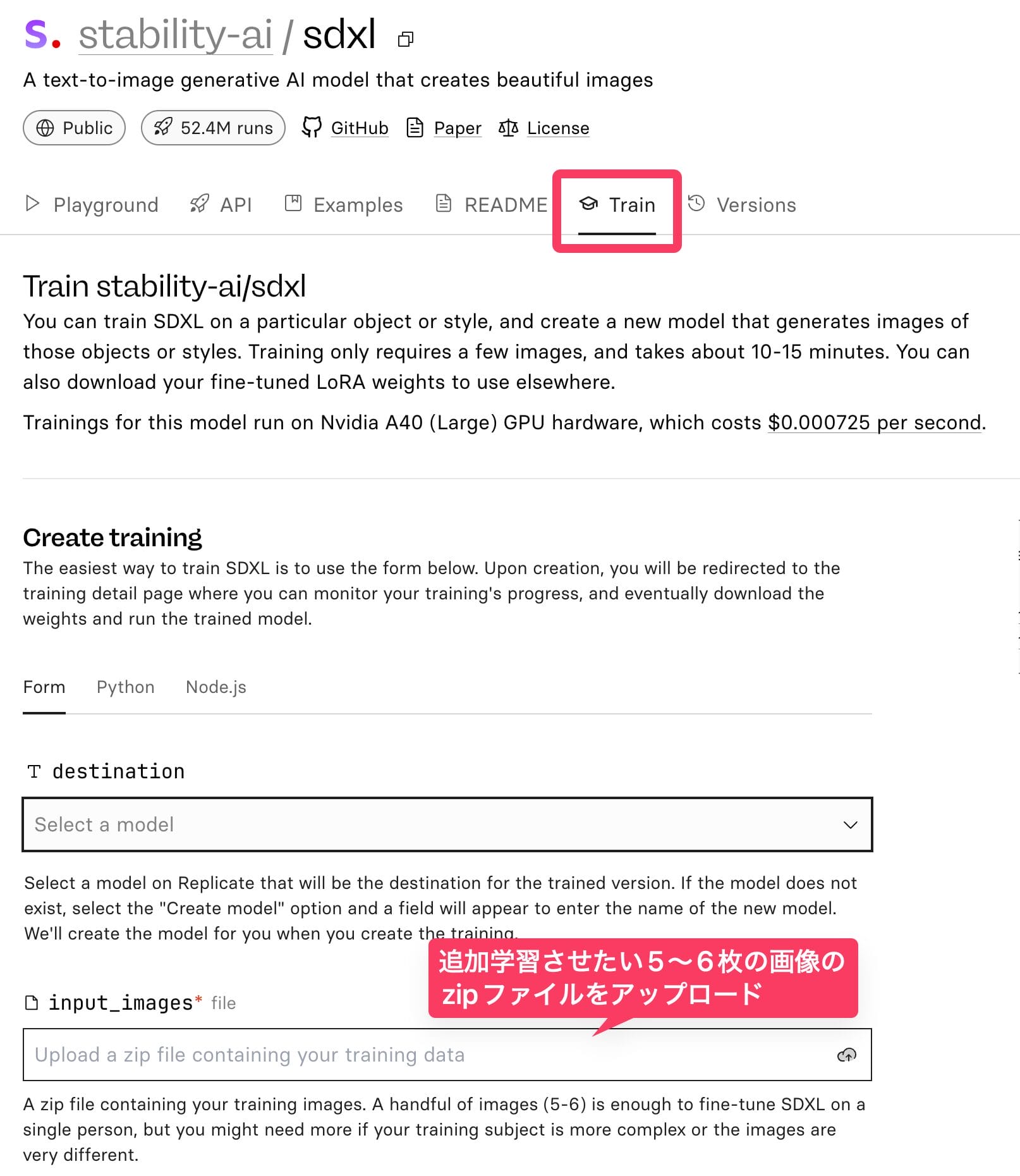

さらに、stability-ai/sdxlには「Train」というタブもあり、Replicate上でモデルのファインチューニングまで行うことができる。

Replicate上には、公式による基本モデルしかないので、Civitai上にアップされているアニメ絵特化モデルなどを使用することはできない。

したがって、よりアニメ絵に特化した生成を行いたいときは、ファインチューニングを行うしかないかもしれない。

「Train」タブで10枚程度のアニメ画像を与えてファインチューンを行い、自分だけのLoRAウェイトを作成するか、他の人が作成したLoRaウェイトを入手してくることで、特定のスタイルを学習させることができる。