Runwayは、米国のAIスタートアップで、テキストプロンプトや既存の画像から動画を生成するサービスで注目を集めている。

2024年6月17日に、次世代モデルのGen-3 Alphaのプレビューを公開したばかりで、恐ろしいほどリアルな映像でネット上を騒がせた。

Gen-3 Alphaは、今後有料ユーザーに徐々に解放されていくようだが、無料ユーザーであっても、Gen-1およびGen-2モデルは利用することができる。

本記事では、Runwayの凄さを体感するため、Runwayの主要機能である「Text/Image to Video」機能の使い方を解説する。

無料ユーザーでも、この記事で紹介している機能は全て使えるので、ぜひ真似してみてほしい。

MidjourneyやStable Diffusionなどの画像生成AIによって作成した画像に、モーションをつけることができるので、クリエイティブの制作の幅が大きく広がる。

用意した静止画と、Runwayで完成したビデオ

「Text/Image to Video」機能を使うと、テキストから全く新しいビデオを生成したり、あるいは既にあるイラストや写真にモーションを持たせることが可能である。

今回は、Midjourneyで生成した以下の画像に、RunwayのGen-2モデルのモーションブラシなどを使って、動きを持たせてみることにした。

Midjourneyでのプロンプトと、生成された画像は以下の通りである。

Back view of a woman standing in a field of flowers, long hair, large clouds in the sky, summer --ar 3:2

Runwayを使ってモーションをつける方法を紹介する前に、実際にモーションをつけた後の完成動画をお見せしておく。

ズームアップしていくカメラと、流れていく空の雲、風になびく女性の髪と花々が、結構自然に動いている。

無料で利用できるGen-2モデルであっても、期待を上回るクオリティを出してくれる。

本記事で紹介する手順で、とても簡単にこのようなビデオが生成できた。

最新のGen-3 Alphaを使えば、もっと自然なモーション付きビデオが大量に生成できるであろうから、インスタグラムやTikTokなどでのコンテンツ制作にも大きな影響を与えそうだ。

Runwayでテキスト/静止画からビデオを生成する方法

まずはRunwayの公式ページにアクセスして、アカウントを作成する。

なお、アカウント登録するだけで、「フリープラン」によって、ビデオ生成などに使える125クレジットが付与される。

例えば、Gen-2モデルでの動画生成は、1秒あたり5クレジットを消化するので、フリープランではGen-2モデルを「25秒分」使える計算になる。

1本の動画が基本的に4秒単位で生成されるので、6本のビデオをお試しで生成できるということだ。

Runwayにログインしたら、「Dashboard」を開いて、Runwayが提供しているAIツール群の中から「Text/Image to Video」ツールを選択する。

他にも、写真と音声をリップシンク(口パク)させたり、静止画を拡張したり、さまざまなクリエイティブ系のAIツールが揃っているので、興味のある人は他のツールも試してみると良い。

それでは、「Text/Image to Video」ツールの操作パネルとともに、以下で具体的に使い方を解説していく。

ビデオにしたい画像が既にある場合

「Text/Image to Video」ツールを開くと、まず最初に、プロンプトを入力するテキストボックスと、静止画をアップロードするパネルが表示される。

静止画は、アップロードしなくても、テキストプロンプトだけで映像を生成することも可能である。

ただ、予めMidjourneyやStable Diffusionで、自分のイメージに合った静止画を生成しておけば、イメージと生成結果の乖離を防止でき、Runwayの使用コストを下げられるのでオススメだ。

今回は、先述の通りMidjourneyで生成した静止画をアップロードした。

また、テキストボックスに、生成したい動画の内容を英語のテキストで打ち込む。

DeepLなどの翻訳ツールで、生成したいビデオの説明文を翻訳してコピペしてくればいいだろう。

今回は、女性の髪の毛が風になびいている花畑の様子、と指定している。静止画をアップロードしているので、そこまで詳細に記載しなくても、イメージ通りのビデオが生成される可能性が高い。

Back view of a woman standing in a field of flowers, her hair blowing in the wind, large clouds in the sky.参考画像がなく、ゼロからビデオ生成をする場合

一方で、画像がない場合には、テキストプロンプトだけで映像を生成する。

その場合、既存の静止画をアップロードする場合とは少し異なる手順を踏むことになる。

テキストプロンプトを入力したら、左側のメニューから、「スタイル」アイコンをクリックする。

ここで、映画風の映像になる「Cine Lens」スタイルや、アニメ風の映像になる「Anime」スタイルなど、生成するビデオの種類を指定することができる。

画像をアップロードした場合には、その画像と同じアスペクト比が自動的に選択されるものの、参考画像がないので、動画のアスペクト比も選択する必要がある。

左側のメニューからアスペクト比を選んで、任意の比率を選択する。

また、運が良ければ、画面下にある「Generate 4s」ボタンの横に、「Free Previews」ボタンが現れる。

テキストプロンプトから、いきなり動画を生成するのはリスクが高いので(クレジットも消化されてしまう)、まずは動画の1フレームだけを静止画としてチラ見せしてくれる機能だ。

もし、これがイメージと違う場合、プロンプトや、スタイルの設定を見直す。

生成された画像がイメージ通りであれば、「Use as Image Input」ボタンをクリックして、プレビューで生成された静止画を、参考画像として指定することができる。

これによって、生成されるビデオの内容を予めコントロールすることが可能になる。

ただ残念ながら、Runway全体の使用量が多い時期などは、「Free Previews」が無効になってしまうので、プレビューを利用できない。

やはり、MidjourneyやStable Diffusionなどで予めイメージを作り込んでアップロードした方が、Runwayのクレジットを節約できて良いだろう。

Runwayにおけるカメラ・被写体のモーションの指定

Runwayでは、アップロードしたイメージ、またはプロンプトから生成されたプレビューイメージについて、ブラシなどを使って細かくモーションの種類や強さを指定することができる。

以下、利用できるモーションの設定と、実際の使い方を解説していく。

全体的な動きの設定

画面下部にある風のようなアイコンをクリックすると、「General Motion」スライダーを使用できる。

ここでは、生成するビデオ全体のモーションの強さを、1から10の範囲で設定することができる。

特定のエリアを指定せずに、とにかく全体的に動きが欲しい!という場合は10にセットすればよい。

「General Motion」は、イメージ全体に適用されるかなり大雑把な設定なので、より細かくモーションを指定したい場合は、「カメラコントロール」や「モーションブラシ」で個別に設定をしていった方が良い。

ちなみに個別の設定を有効にすると、「General Motion」は無効になる。

カメラモーションの設定

左側のメニューから「Camera Control」設定を開くと、カメラの動きの方向と速度を細かく制御できる。

左右の動き(Horizontal)、上下の動き(Vertical)、ズームイン・アウトの動き(Zoom)など、6種類の動きについて、スライダーで細かく調整できる。

今回は、女性の背後にわずかにズームインしていく動きが欲しかったので、「Zoom」を「2.0」に設定しておいた。

モーションブラシの使用

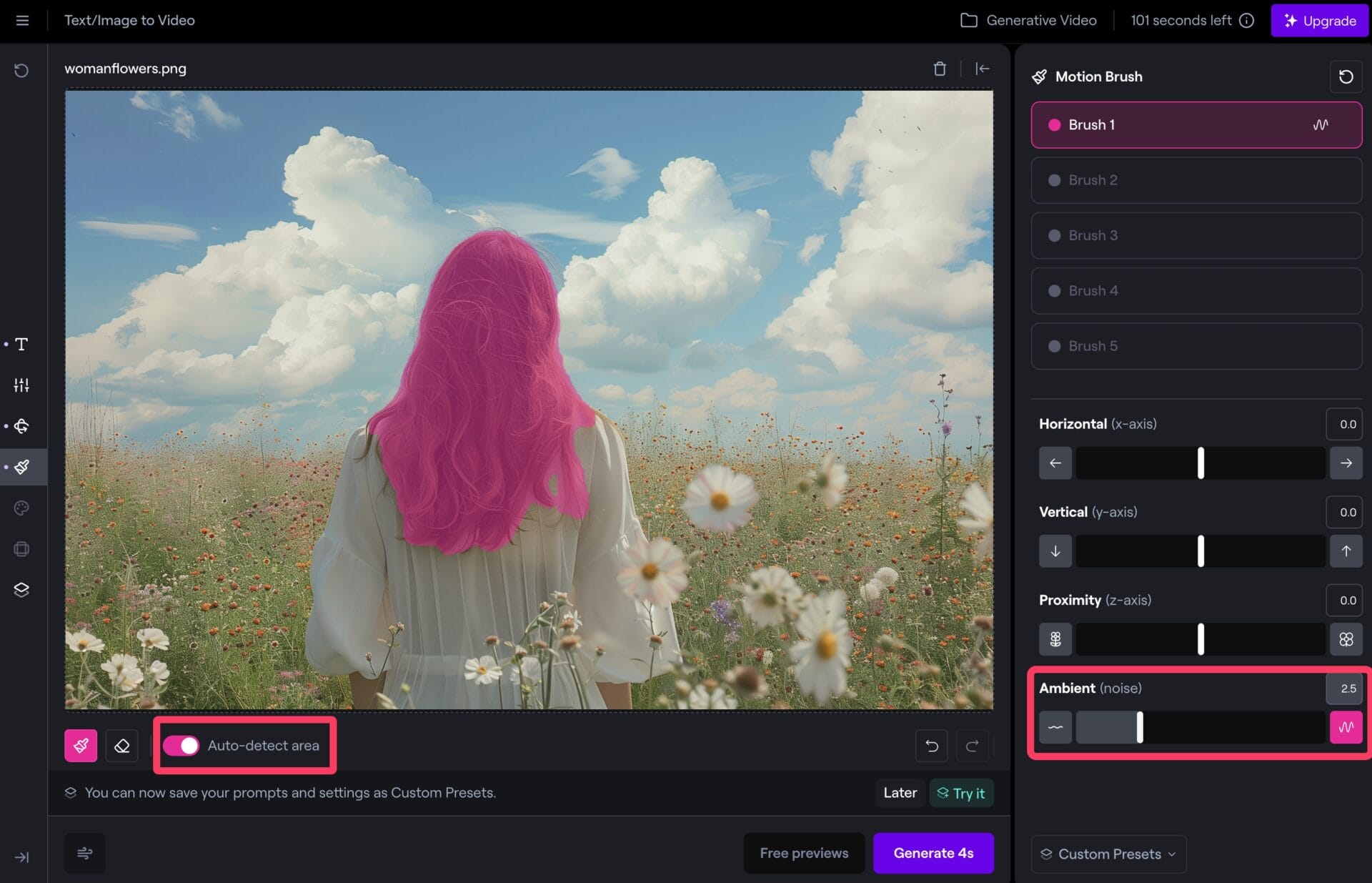

左側のメニューから「Motion Brush」を選ぶと、参考画像の中で、ブラシツールなどを使って最大5つのエリアを指定して、それぞれに細かいモーションの指定を行うことができる。

画面下部にある「Auto-detect area」をオンにすれば、例えば女性の髪の毛などをワンクリックで範囲指定できて便利だ。

選択した各領域に対しては、以下のパラメータを設定することができる。

- Proximity: カメラに対する接近/遠ざかりの動き

- Vertical/Horizontal: 縦/横方向の動き

- Ambient Noise: 非線形な有機的動き(水、煙、火、風などに適している)

女性の髪の毛が風になびく様子は、「Ambient Noise」を2.5ほど付けることによって実現できる。

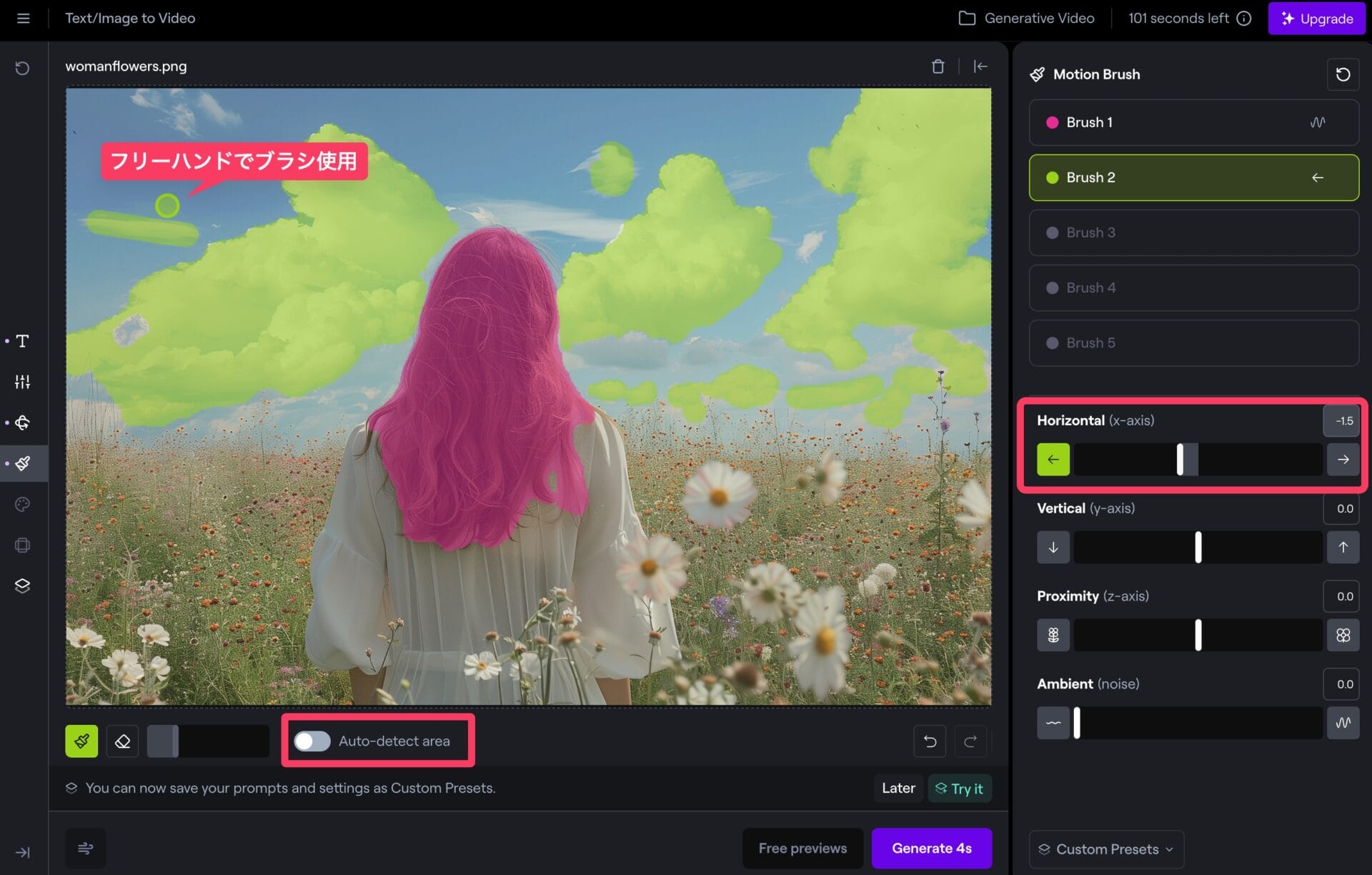

また、「Auto-detect area」をオフにすれば、フリーハンドのブラシツールで、エリアを指定することができる。

空に浮かぶ雲が、自動範囲指定では全てカバーできなかったので、ブラシツールを使って塗ってみた。

雲が風によって流れていく様を表現したいので、「Horizontal」の動きを左に向かって-1.5付けておいた。

Runwayにおけるビデオの生成と拡張

以上の設定が完了したら、右下にある「Generate 4s」ボタンをクリックし、いよいよビデオを生成する。

今回は、以下のようなモーションの指定を行った。

- Camera Controlでズームアップの動きをつける

- 女性の髪の毛、花々が風に揺らぐ様をAmbient Noiseで表現

- 雲が左に向かって流れていく様をHorizontalで表現

Runwayは、4秒単位でビデオを生成することができ、最初に「Generate 4s」ボタンをクリックすると、言葉通り、4秒間のビデオが完成する。

生成スピードは結構早く、30秒ほどの体感だった。

生成されたビデオに対しては、お気に入りに追加したり、.mp4形式でローカルにダウンロードしたり、「Extend」をクリックしてさらに4秒間ビデオを延長したりすることができる。

最大3回までExtend可能なので、MAXで16秒の長さのビデオが生成できるということだ。

Instagram/TikTokなどショート動画SNSに激震かも

こうして、かなり簡単な設定項目を埋めていくだけで、冒頭で紹介したビデオが完成した。

1世代前のGen-2モデルを使っているにも関わらず、若干の合成感はあるものの、かなり自然なモーションが加えられているように感じられる。

Gen-3 Alphaは、Gen-2から大幅に進化していると思われるため、これからYouTube, TikTok, Instagramなどのショート動画をアップロードできるSNSサイトでは、AI生成動画が跋扈する日も近いかもしれない。

縦長の動画も生成できるため、MidjourneyやStable Diffusionで生成した人物を核に、様々なシチュエーションの動画をRunwayで生成できてしまう。

イラスト生成AIによって、イラスト・グラフィック界も大きく影響を受けているが、これからビデオの世界にも、生成AIが影響を与えてくるに違いない。

本記事を参考に、ぜひ最新のビデオ生成AIの世界を体感してみて欲しい。