2024年12月11日、GoogleがGemini 1.5の次世代モデルファミリーである「Gemini 2.0」を発表した。

まずは2.0シリーズのうち、軽量で高速な「Gemini 2.0 Flash」モデルがリリースされた。

「Flash」モデルなので、小型軽量モデル、という位置付けのはずが、従来の大型モデルである「Gemini 1.5 Pro」と同等の性能を示すどころか、Claude 3.5 Sonnetなどトップクラスのモデルに肉薄するベンチマークスコアを叩き出すなど、目覚ましい進歩を見せている。

また、ChatGPTのAdvanced Voice Modeのように、音声による自然なGeminiとの会話が可能な「Stream Realtime」機能がリリースされた。

「Stream Realtime」には、音声だけでなく、カメラ映像の共有や、スクリーンキャプチャの共有など、映像のリアルタイム認識までも実装された。ChatGPTよりも一足早い映像系のストリーミング・マルチモーダル機能の実装となる。

実際にビデオ共有機能を使ってみたが、まさに未来を感じるとんでもない体験だ。

本記事では、発表されたばかりのGemini 2.0の概要をまとめるとともに、「Gemini 2.0 Flash」や「Stream Realtime」、「Deep Research」などの新機能を、実際に試す方法を紹介する。

なんと「Gemini 2.0 Flash」や「Stream Realtime」は無料で利用できるので、ぜひ実際に体験してみることをオススメする。

「Gemini 2.0 Flash」の主な特徴まとめ

Gemini 2.0ファミリーは、これまでのGemini 1.5のように、大型・高性能のProモデルと、小型・高速のFlashモデルで展開されると思われるが、今回リリースされたのは「Gemini 2.0 Flash」のみである。

「Gemini 2.0 Flash」は、高速さと性能とを両立し、なんとClaude 3.5 SonnetやOpenAI o1などの最上位モデルに匹敵するほどのスコアを一部のベンチマークで記録している。

「Flash」ですらこれだけの性能を有するということは、もし「Gemini 2.0 Pro」が登場したら、一体どれほどの性能を有しているのか・・・今から楽しみである。

その主な特徴は以下の通りである。

- 速度と性能:1.5 Proより2倍のスピードを有しながら、1.5 Proよりも優れた性能を実現。Claude 3.5 SonnetやOpenAI o1などトップクラスのモデルに肉薄。

- マルチモーダル入出力:画像・動画・音声入力に加え、画像生成や音声出力をもサポート。

- ネイティブツール利用:Web検索やコード実行、ユーザー定義の関数などの呼び出しにも対応。

第三者の独立系ベンチマークテストの結果を見てみると、LiveBenchの総合平均スコアで、Claude 3.5 Sonnetに肉薄し、GPT-4oを引き離す非常に高いスコアを叩き出している。

さらに上位にいるgemini-exp-1206は、数日前に登場してネットを騒がせたが、もしかするとgemini-exp-1206こそ、上位モデルのGemini 2.0 Proなのかもしれない。

実際にGemini 2.0 Flashを使ってみた:ビデオ共有がヤバすぎる

テキスト、画像、動画、音声、コードなどの「インプット」だけでなく、画像の生成やスピーチ(音声の発話)など、「アウトプット」もマルチモーダルになったので、Geminiとマイクを通してスムーズに会話ができるようになった。

また、映像のインプットも、ビデオファイルをアップロードするのではなく、リアルタイムで画面共有を行ったり、ウェブカメラの映像を見せたり、リアルタイム・ストリーミングが可能になったのは革命的である。

リアルタイムでウェブカメラに映った映像を音声で解説してもらったり、PCの作業画面を共有しながらPCの使い方を音声で解説してもらったり、極めて自然な会話が可能だ。

リアルタイムでの映像共有機能は、Google AI Studioの「Stream Realtime」機能から試すことができる。

例えば、Googleスプレッドシートで集計作業を行なっている画面を共有して、「どうやってカテゴリごとの合計値を出せばいいの?」と聞いてみると、SUMIF関数の使い方を解説してくれた。

この記事の冒頭で紹介したように、テディベアの人形をウェブカメラに映して、「これは何?」と聞いてみると、ちゃんとテディベアの特徴を解説してくれた。

特にカメラを通して視覚情報をAIと共有できるようになると、いよいよ人間のパートナーとして機能しうる存在に進化してきていると感じられる。

また、Google検索やコード実行、ユーザー定義関数など、外部ツールのネイティブな呼び出しをサポートしているのも便利だ。

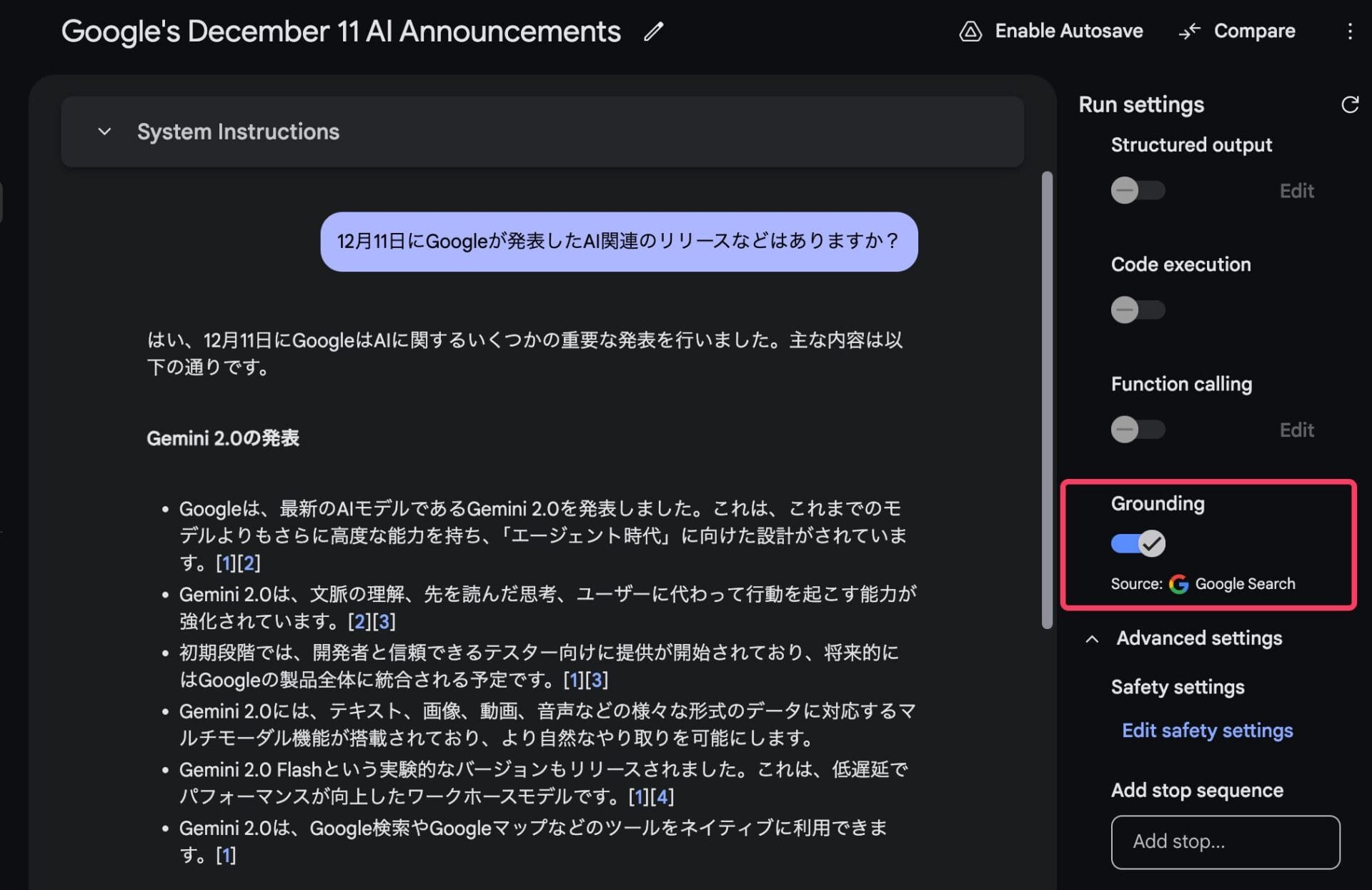

例えば、学習データに含まれていないであろう最新のニュースについて聞いてみると、ウェブ検索の結果を生成する回答に反映して回答してくれる。

今のところ、「Gemini 2.0 Flash」との音声による会話は、英語が最もスムーズで、日本語・中国語などはあまりうまく喋ってくれない。

ただ、自分がマイクに向かって日本語で音声インプットをして、Geminiにテキストで返答をさせると、普通に長文で正確な回答が返ってくる。

テキストを音声化する部分で、若干言語によって得意不得意があるのかもしれない。

Gemini 2.0 Flashを無料で試す方法

現在Gemini 2.0 Flashは無料で開放されており、以下の方法で今すぐ実際に使ってみることができる。

Geminiアプリで「Gemini 2.0 Flash」を試す

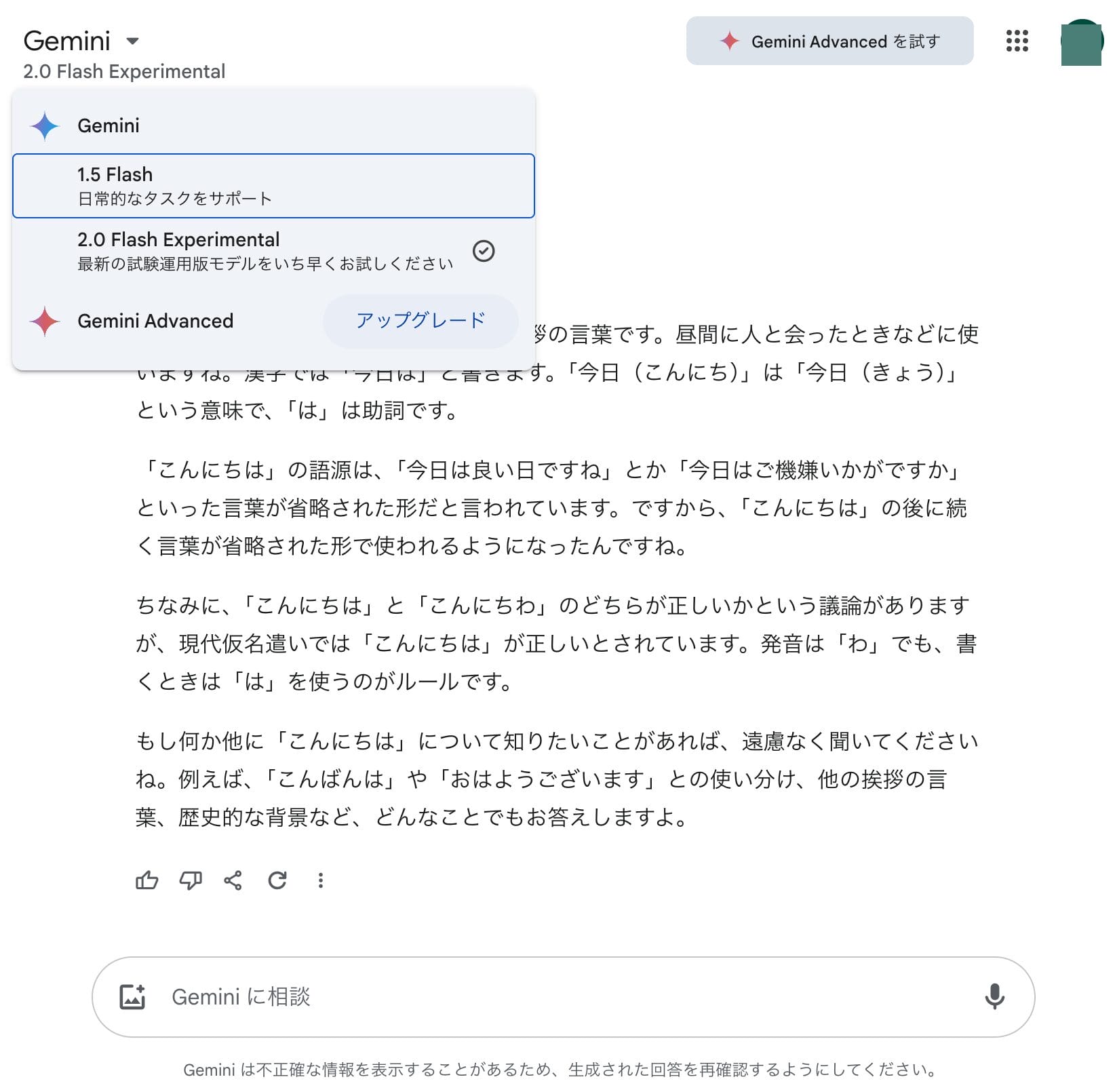

PCのブラウザで Gemini アプリのWeb版にアクセスすると、左上のモデルプルダウンメニューから、「2.0 Flash Experimental」を選択できるようになっている。

これを選ぶだけで、無課金ユーザーであっても、Gemini 2.0 Flashを利用できる。

有料プランである「Gemini Advanced」に加入すると、Gemini 1.5 Proを利用できるようになるが、Gemini 2.0 Proが出るまでは、無料のGemini 2.0 Flashのみでも満足できそうだ。

なお、AndroidスマートフォンなどのGeminiアプリでは、モデルの選択タブがなく、Gemini 2.0 Flashを選択することはできなかった。

2.0 Flashを使うためには、Web版のGeminiにログインする必要がある。

Google AI Studioで全機能を体験する

よりおすすめの方法は、Google AI Studioという開発者向けのインターフェースを使用することだ。

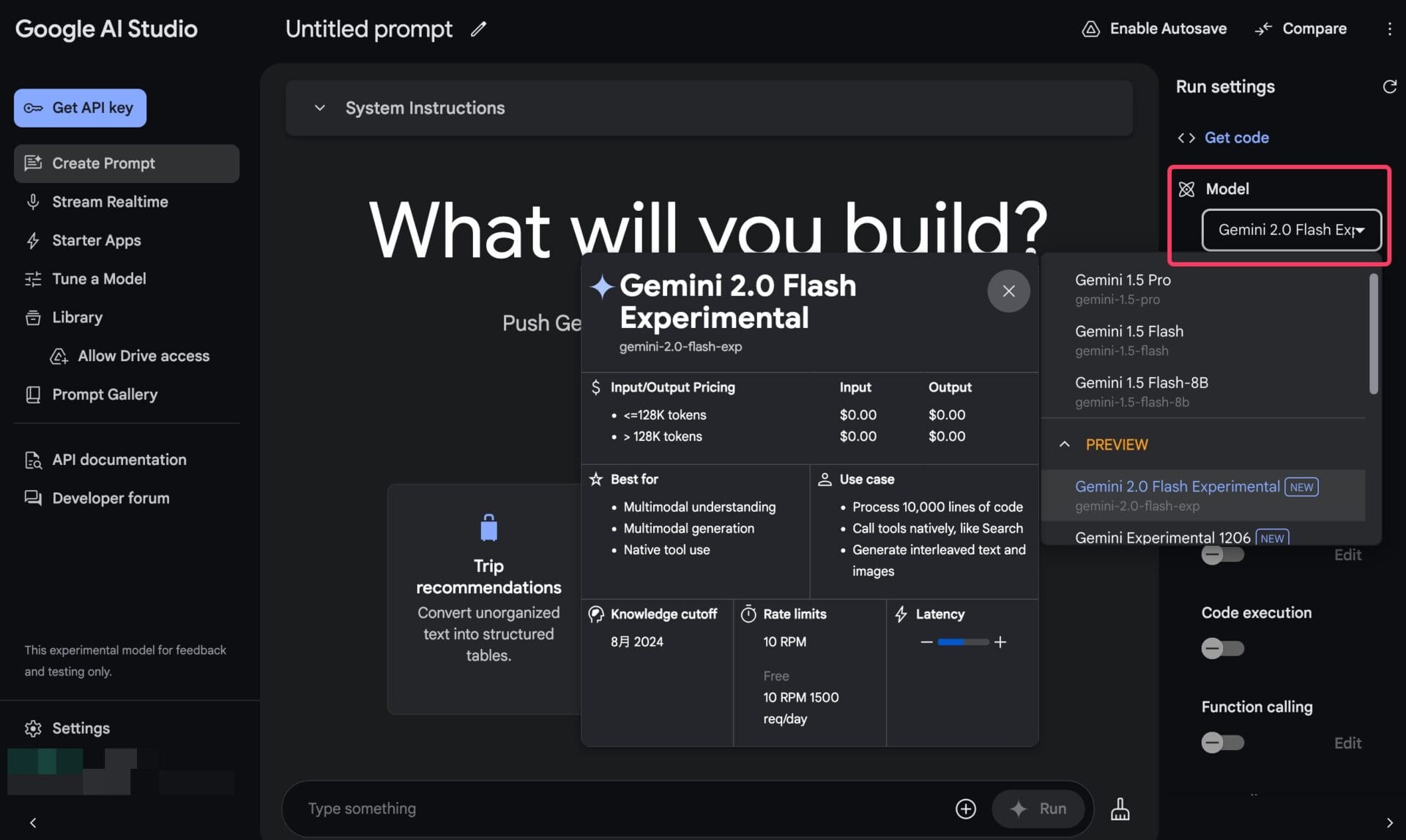

Googleアカウントでログインをして、Google AI Studioにアクセスするだけで、すべてのGeminiのモデルを選択して、チャットを行うことができる。

Google AI Studioの左側メニューで「Create Prompt」をクリックすると、新しいチャットのスレッドを立ち上げられる。

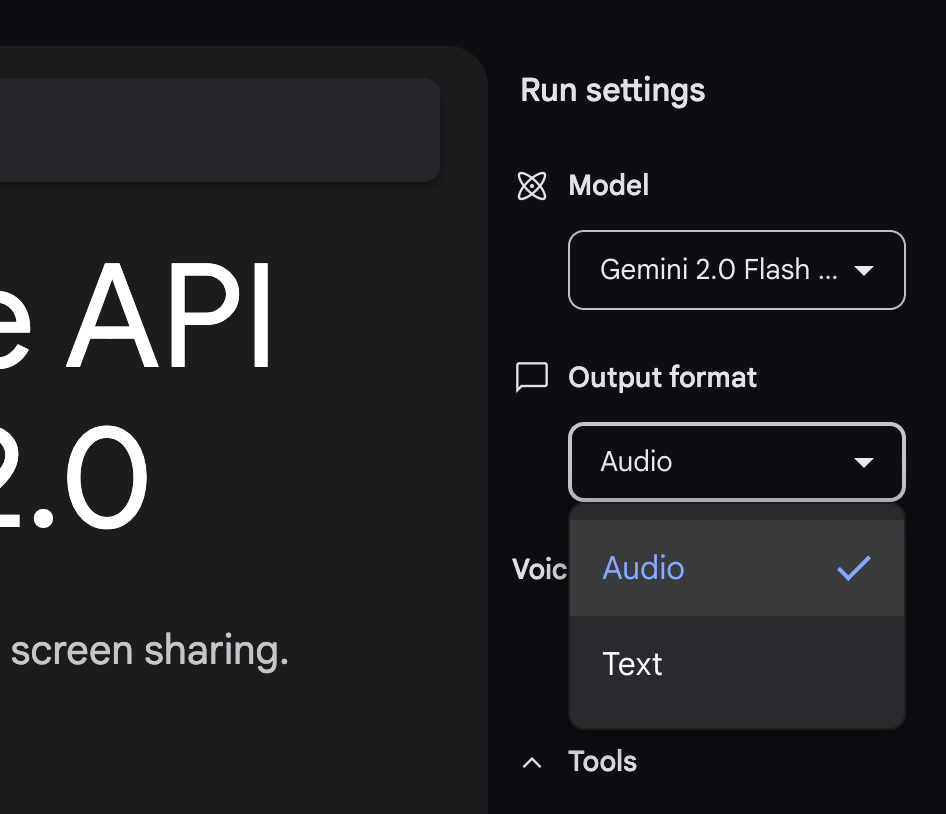

画面右側の「Model」プルダウンから、「Gemini 2.0 Flash Experimental」を選択すると、今回リリースされたGemini 2.0 Flashを利用することができる。

また、Google AI Studio上では、Google検索機能を有効にするかどうかなど、さらに細かいツール使用の設定を行うこともできる。

Web版のGeminiアプリを使うよりも、Gemini 2.0のさまざまな機能を試したり、Gemini 1.5 Proなど旧モデルとの比較を行ったり、出来ることがはるかに多い。

音声会話・ビデオ共有が可能な「Stream Realtime」を無料で試す方法

リアルタイムでの自然な音声会話や、スクリーン共有、ウェブカメラ映像の共有を試したい場合は、「Stream Realtime」を使用するしかない。

まずは、Google AI Studioにアクセスして、左側のメニューから「Stream Realtime」を選択する。

Stream Realtimeでは、テキスト入力、音声入力、カメラ共有、スクリーン共有の4つの方法でGeminiに話しかけることができる。

また、右側のメニューで、Geminiの返答の形式をテキストとするか、音声とするかを選択することができる。

例えばGeminiと英会話の練習をしてみたいのであれば、音声入力、音声出力の設定にして、話しかけてみると、自分が話し終わったら自動的にGeminiがリアクションをしてくれる。

ChatGPTのAdvanced Voice Modeのように、切れ目のない非常に自然な会話が可能になっている。

「Deep Research」:個人専用のAIリサーチアシスタント

英語版限定であるが、有料版のGeminiアプリ「Gemini Advanced」に、「Deep Research」という機能が実装された。

日本では本来利用できないが、当サイトで過去に紹介した「Gemini Advancedの日本未公開機能を日本で利用する方法」の記事の裏技を使えば、日本からでも利用できる。

「Deep Research」は、与えられたリサーチテーマについて、複数のステップからなるリサーチ計画を立て、数分間にわたって大量のウェブサイトの情報を読み込んで、結果を整理して教えてくれる検索・リサーチアシスタントだ。

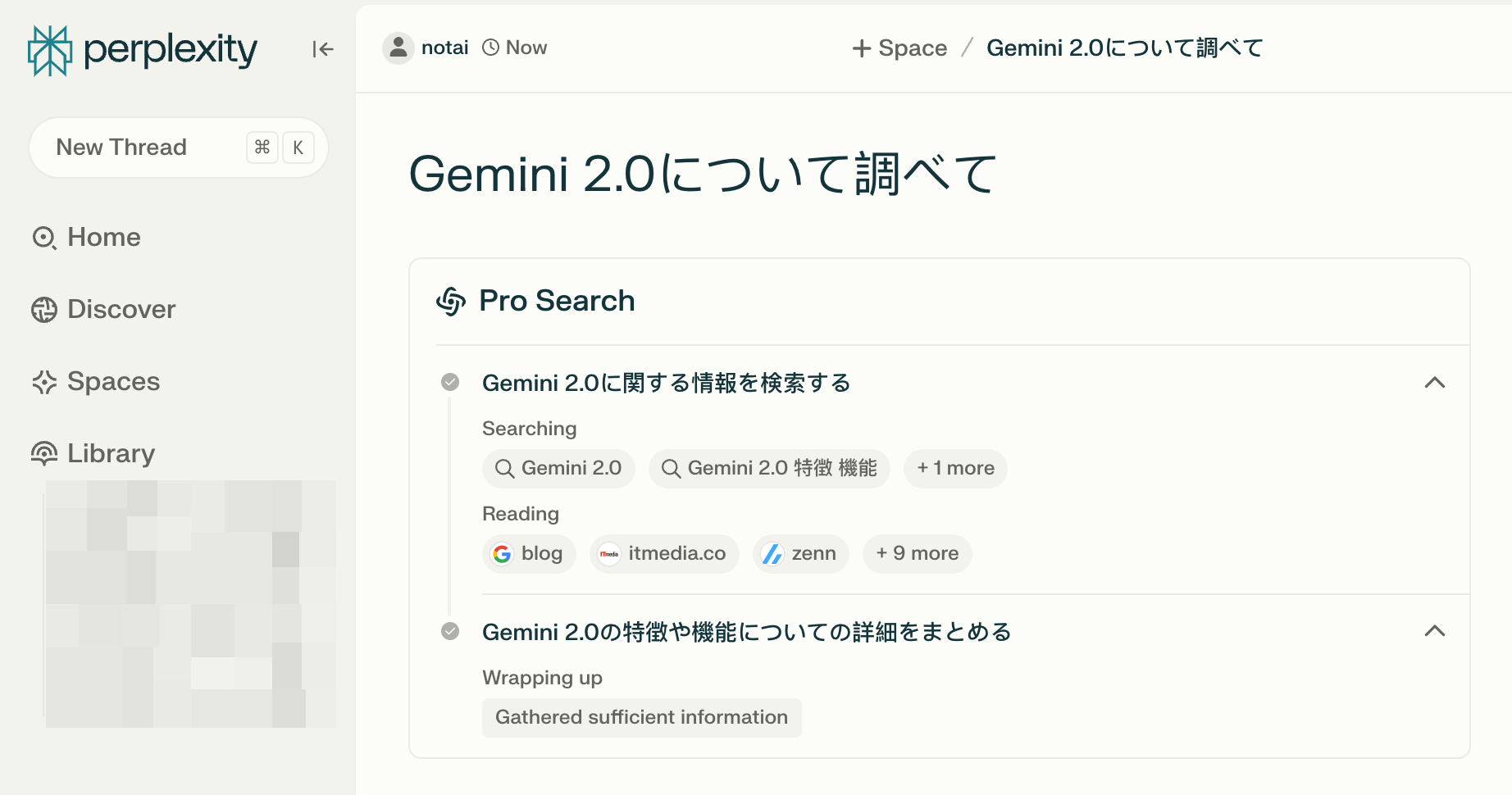

複数のステップを設定して、リサーチを段階的に実行してくれるのは、検索特化AIとして知られるPerplexityのProモードに近いイメージである。

GeminiのDeep Researchの場合、「Deep」という名の通り、さらに深く広く文献を探索してくれるようだ。

Deep Researchは数分間にわたって、ウェブを縦横無尽に「探索」し、興味深い情報を発見すると、それに基づいてさらに新たな検索キーワードを生成し、また次の「探索」へと進むサイクルを繰り返す。

このサイクルを繰り返した後、要点をまとめた包括的なレポートが生成される。

Googleドキュメントへのエクスポートが可能で、追記・編集や新たな質問をGeminiに投げかけることも簡単だ。

本来数時間かかるような情報収集・整理作業を、わずかな時間でAIが代行してくれるので、マーケターやリサーチャーの仕事がかなり効率的になりそうだ。

英語版の「Gemini Advanced」のWeb版で、モデル選択ドロップダウンで「Gemini 1.5 Pro with Deep Research」を選択し、調べたいテーマを入力するだけで利用できる。

2025年初頭にはモバイルアプリへの実装も予定されているとのこと。

進行中の研究プロトタイプ

Googleは、AIエージェントを社会実装するべく、いくつかのリサーチプロトタイプをテストしている。

Googleのアナウンスの中では、Gemini 2.0が、これらの研究プロトタイプの実験に組み込まれること、またその進捗の一部が紹介されている。

いずれも、人間とAIが緊密に連携するAIエージェントの可能性を探るもので、ワクワクするものばかりだ。

ここでは、紹介されている各プロトタイプの概要を簡単にまとめておく。

Project Astra

Project Astraは「ユニバーサルAIアシスタント」の将来像を探るプロトタイプであり、Android端末上でテストが進められてきた。

スマホのカメラで周囲の環境をGeminiに見せると、それをAIが解説してくれる、というようなマルチモーダルならではの日常生活への融合がテストされている。

Gemini 2.0搭載版では、多言語対話能力、検索やLens、Mapsなどのツール利用、最大10分間の連続記憶、過去の会話履歴に基づくパーソナライズが改善されている。また、人間の会話に匹敵する低遅延な音声理解が可能となっている。

今後、Geminiアプリやメガネ型デバイスなどへの展開、テスターの拡大が計画されているという。

Project Mariner

Project Marinerは、ウェブブラウザ内でユーザーの指示に基づきタスク遂行する研究プロトタイプである。

画面上のピクセル、テキスト、コード、画像、フォーム要素を理解し、Chrome拡張機能を介して自動操作を行う。

現段階では速度や精度に課題があるが、WebVoyagerベンチマークで83.5%の成功率を達成し、将来的なブラウザ支援エージェントの可能性を示している。

Jules(開発者向けコードエージェント)

JulesはGitHub上の開発フローへ統合される実験的コードエージェントであり、Issue対応、計画立案、コード実行までを支援する。

この研究は、コーディング領域におけるエージェント活用の可能性を探る長期的な取り組みの一環である。

ゲーム領域への適用

Gemini 2.0を活用したエージェントは、ゲーム内での行動や戦略提案なども可能となる。

画面上のゲーム映像を理解し、リアルタイムでアドバイスを提供したり、外部知識をGoogle検索で参照するなどの利用法が模索されている。

Supercellなどのゲーム開発企業と協力し、戦略ゲームから農場シミュレーションまで、多様なジャンルでの有用性が検証されている。

さらに物理世界への応用として、ロボティクス分野への展開も初期研究段階にある。

映像処理のインパクトは大きい、「AGI」の日は近い

カメラに映っているものについて、リアルタイムでAIと会話ができてしまう・・・。

こんな夢物語が、Gemini 2.0 FlashとStream Realtimeの登場によって、本当に現実のものになってしまった。

最近、次々と高性能なAIが登場して感覚が麻痺しつつあるが、2〜3年前に、前触れなく同じものを見せられていたら、AGI・シンギュラリティ来ちゃったよ、と感じていたに違いない。

無料でこれを試せるなんて本当にありがたい。まだ試していない人は、ぜひGoogle AI Studioにログインして、体感してみることをお勧めする。