2025年1月20日に登場し、o1に匹敵する性能を持つとして話題の中国製推論モデル「DeepSeek R1」。

MITライセンスで完全にオープンソース化されており、モデル本体をダウンロードして、オフライン環境・ローカル環境で使用できるのも大きなメリットだ。

Mac Book Airなどのラップトップのローカル環境でDeepSeek R1を使う方法を以前紹介したが、ついに、スマホでもDeepSeek R1を動かせるiPhoneアプリ・Androidアプリが登場した。

本記事では、DeepSeek R1 の小型軽量版であるdistilled modelsを、実際にiPhoneで動かしてみた様子を紹介する。

ちなみに、記事内ではiPhoneの画面で解説するが、Androidでも同じように実行できる。

誰でも無料で簡単に、スマホアプリを入れるだけで、DeepSeek R1を iPhone / Android のローカル環境で動作させることが可能なので、ぜひ真似してみてほしい。

ローカルLLMをスマホで使えるアプリ「PocketPal AI」

「PocketPal AI」は、オープンソースで開発されているスマホアプリだ。

iPhone向け、Android向けにリリースされており、それぞれApp StoreやGoogle Play Storeからダウンロードできる。

Metaが開発するLlama、Googleが開発するGemma、マイクロソフトが開発するPhiなど、オープンソースのAIモデルを簡単にスマホ内にダウンロードして、チャットアプリとして使用できる。

利用料金は無料で、誰でも簡単に使える、本当にありがたいアプリだ。

まずは、アプリストアでこれをダウンロードしよう。

iPhoneの場合はこちらからダウンロードできる。

Androidの場合も、Google Play Storeから簡単にダウンロードできる。

DeepSeek R1 のサポートが公式に追加

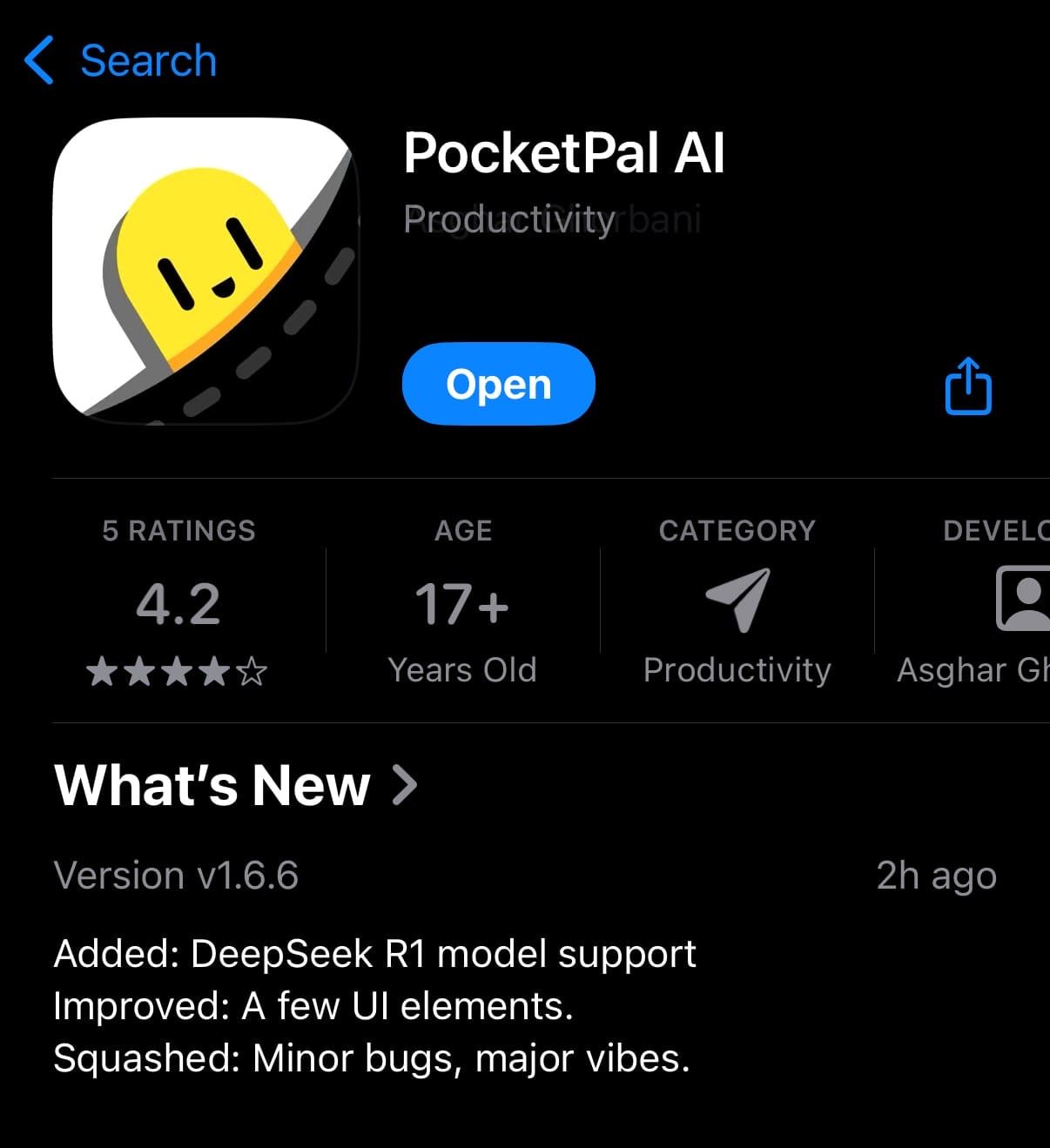

DeepSeek R1が登場して3日後の2025年1月23日、ついに、「PocketPal AI」の開発者から、DeepSeek R1 ファミリーのサポートが発表された。

PocketPal AIのコードが公開されているGitHubのディスカッションページで、Android向け、iPhone向けともにアップデートした旨がアナウンスされている。

「PocketPal AI」の最新バージョンをダウンロードするだけで、複雑な設定など必要なく、誰でも簡単にスマホでDeepSeek R1を使えるようになった。

なお、現時点では、上記のアナウンス内で記載されている通り、全部で6種類存在するDeepSeek R1 の蒸留モデルのうち、「DeepSeek-R1-Distill-Qwen-7B」が推奨されている。

このモデルの元となっているのは、数学のスキルに特化した「Qwen2.5-Math-7B」モデルである。

したがって、現時点では、数学の問題を iPhone / Android ローカルで解くような用途に適している。

| R1の派生モデル | 元となったモデル |

|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | Qwen2.5-Math-1.5B |

| DeepSeek-R1-Distill-Qwen-7B | Qwen2.5-Math-7B |

| DeepSeek-R1-Distill-Llama-8B | Llama-3.1-8B |

| DeepSeek-R1-Distill-Qwen-14B | Qwen2.5-14B |

| DeepSeek-R1-Distill-Qwen-32B | Qwen2.5-32B |

| DeepSeek-R1-Distill-Llama-70B | Llama-3.3-70B-Instruct |

とはいえ、まだ最適化されていないだけで、Qwen 7B以外の他のモデルでも動作する可能性はある。

実際、筆者は「DeepSeek R1 Distill Llama 8B」についても、PocketPal AIでの動作確認をしてみたが、おおむねスムーズに動作した。

スマホで DeepSeek R1 を動かす方法完全ガイド

それでは、実際に「PocketPal AI」を使って、筆者のスマホで「DeepSeek-R1-Distill-Qwen-7B」モデルを動かしてみる。

使用しているスマホは、「iPhone 16 Pro」なので、かなり高スペックな端末を使用していると言えるだろう。それでも動作は比較的ゆっくりだったので、上位スマホでなければ実用的なスピードでは動作しないと思われる。

ちなみに、iPhoneの画面で説明しているが、Androidでも同じことが可能だ。

Hugging Face から DeepSeek R1 の量子化モデルを入手

「PocketPal AI」には、デフォルトで主要なモデルが用意されているが、Hugging Face上にアップロードされているモデルを自由に選んでダウンロードする機能も備わっている。

DeepSeek R1 は、まだデフォルトモデルには含まれていないので、自分でHugging Face上にアップロードされたDeepSeek R1のDistilled Modelをダウンロードしてくる必要がある。

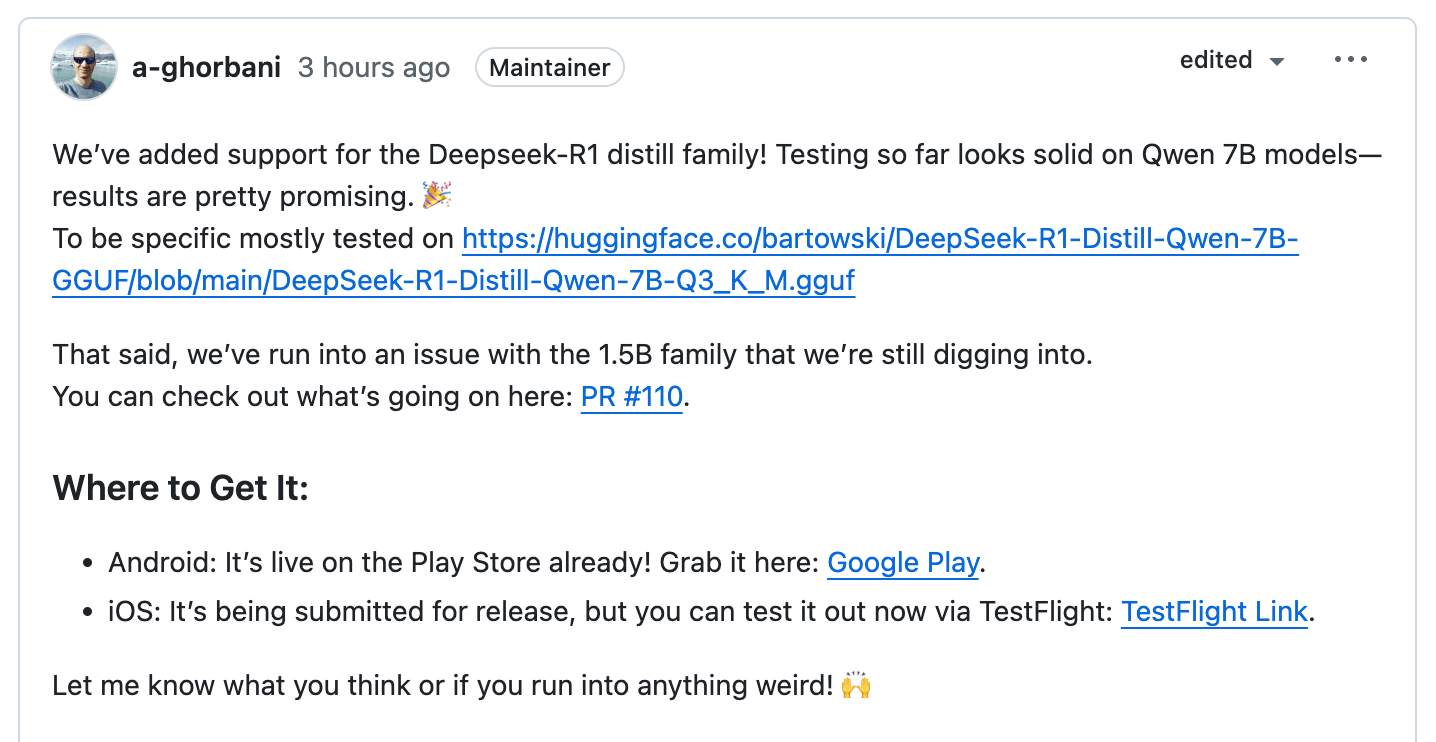

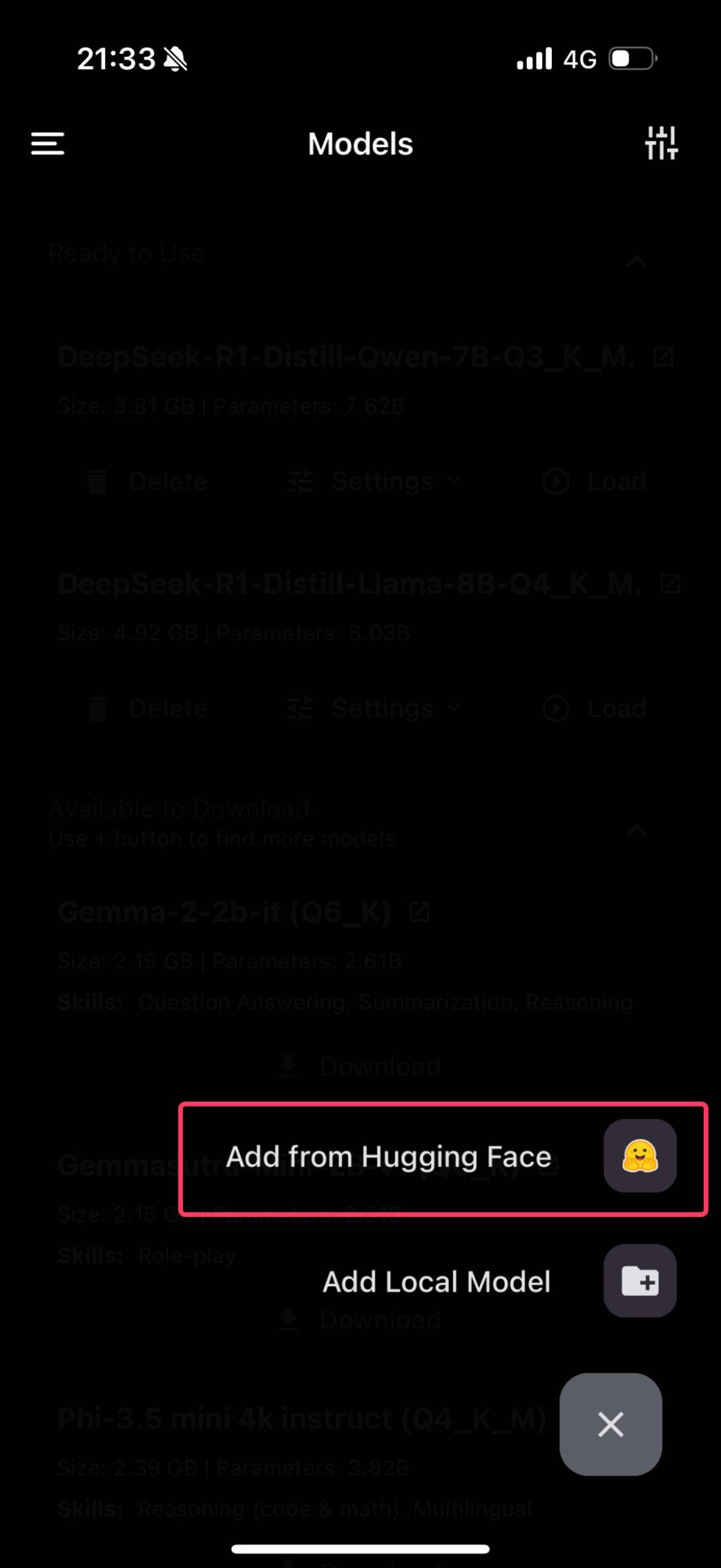

まず、「PocketPal AI」のアプリを開いて、左側のメニューから「Models」をタップする。

デフォルトモデルの一覧が表示されるが、右下の「+」(追加)ボタンを押して、「Add from Hugging Face」を選択する。

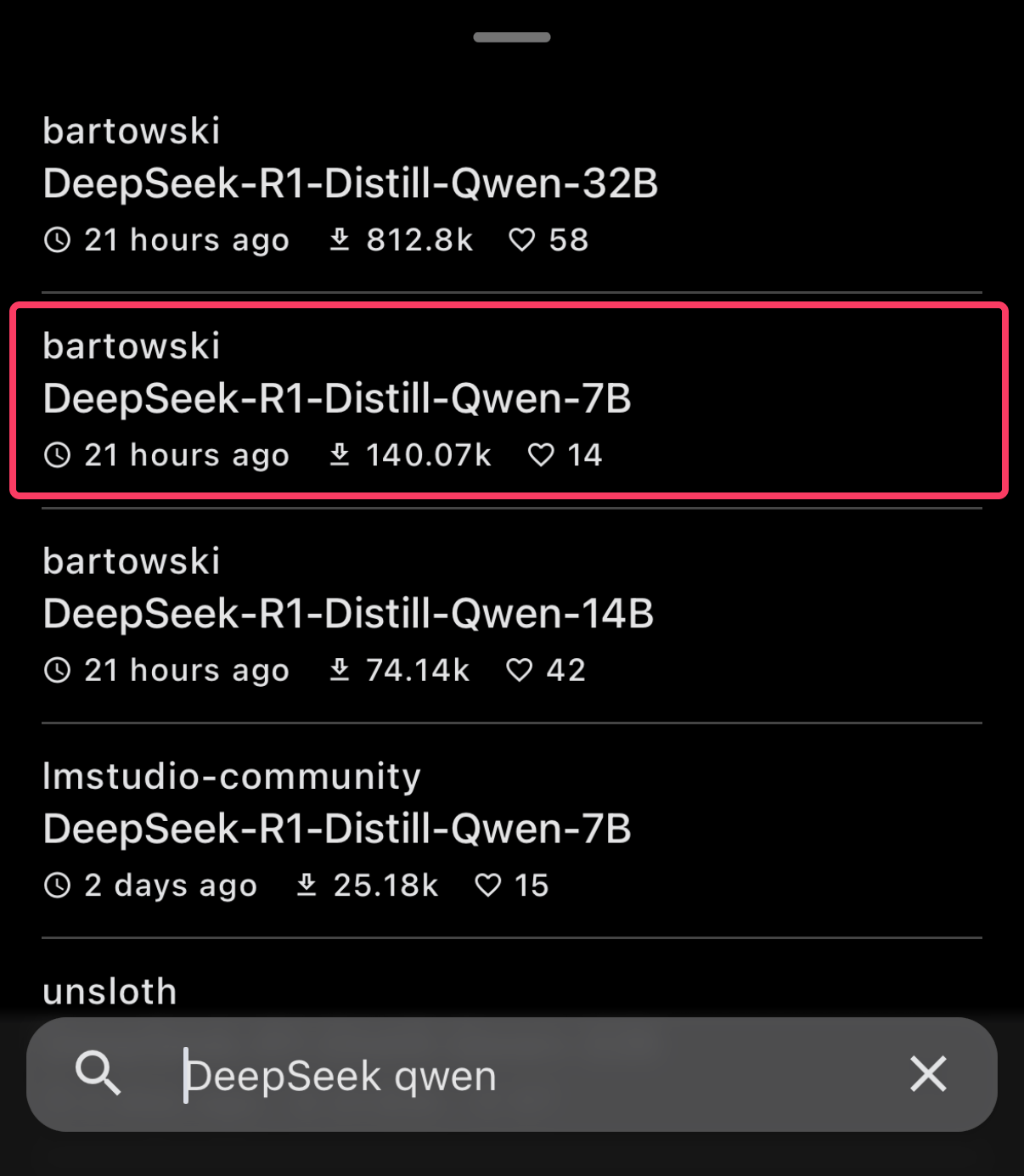

すると、Hugging Face上にアップロードされたモデルを検索することのできる画面になるので、今回のお目当てのモデルを見つけるため、「DeepSeek Qwen」などと検索する。

先述の通り、「PocketPal AI」の今回のリリースでは、動作テストが完了しているのが、Hugging Face上のbartowski/DeepSeek-R1-Distill-Qwen-7B-GGUFモデルのみであるとリリースノートに記載されている。

したがって、今回はそのモデルを選ぶことにする。

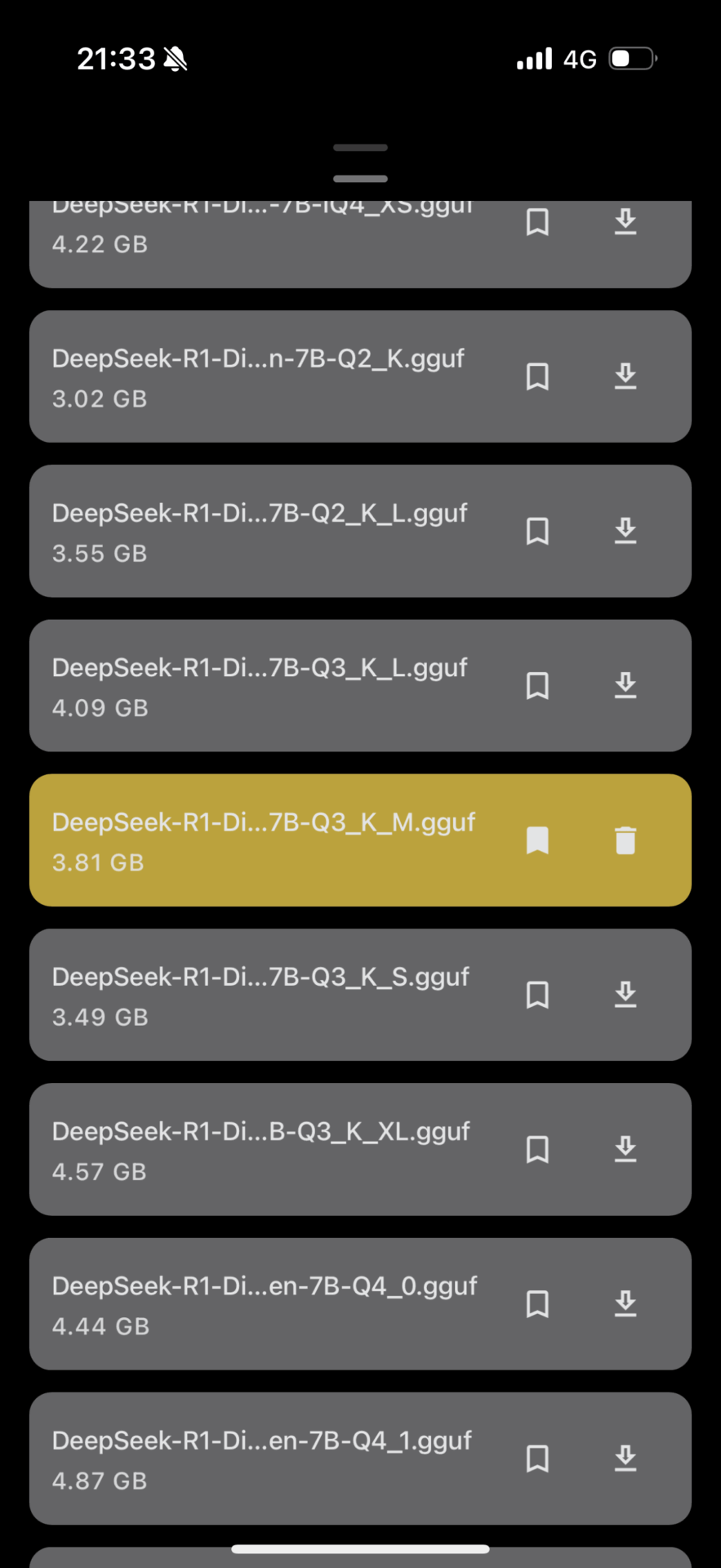

bartowski氏のアップロードしている「DeepSeek-R1-Distill-Qwen-7B」モデルを選択すると、さらにその派生モデルを選択する画面になる。

多数のバリエーションがあるが、ここでは、同じくPocketPal AIのリリースノートで指定されている「Q3_K_M」を選択する。「DeepSeek-R1-Distill-Qwen-7B-Q3_K_M」と表示されているモデルだ。

量子化の知識がないと、Q3やQ4といった表示が何を意味するのか分からないと思うが、要するに、DeepSeekが公式に公開しているQwen 7Bモデルを、さらに圧縮して、より軽量に動くようにカスタマイズしたモデルだ。

(Q3, Q4, Q8と、数字が大きくなるにつれてサイズも大きくなり、性能も高くなる。スマホのスペックの限界から、最も圧縮率が高く軽量なQ3が適切なようだ。)

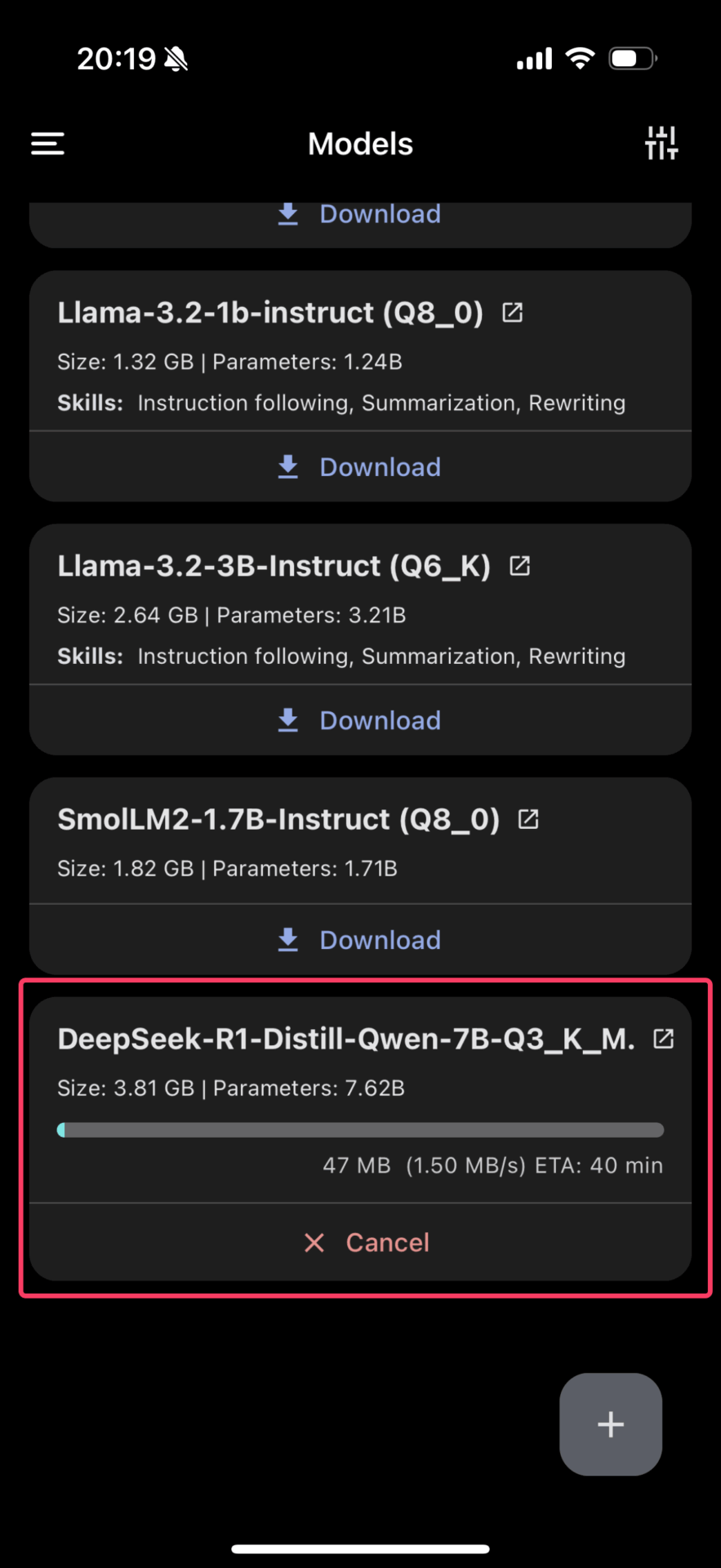

ダウンロードマークのアイコンをタップすると、ダウンロードが始まる。

「DeepSeek-R1-Distill-Qwen-7B-Q3_K_M」は、軽量とはいえ3.81GBもあるので、回線速度次第でそれなりに時間がかかる。

DeepSeek R1 Distill Qwen 7B とチャットしてみた

ダウンロードが完了したら、早速「Chat」メニューを開いて、DeepSeek R1とのチャットをしてみる。

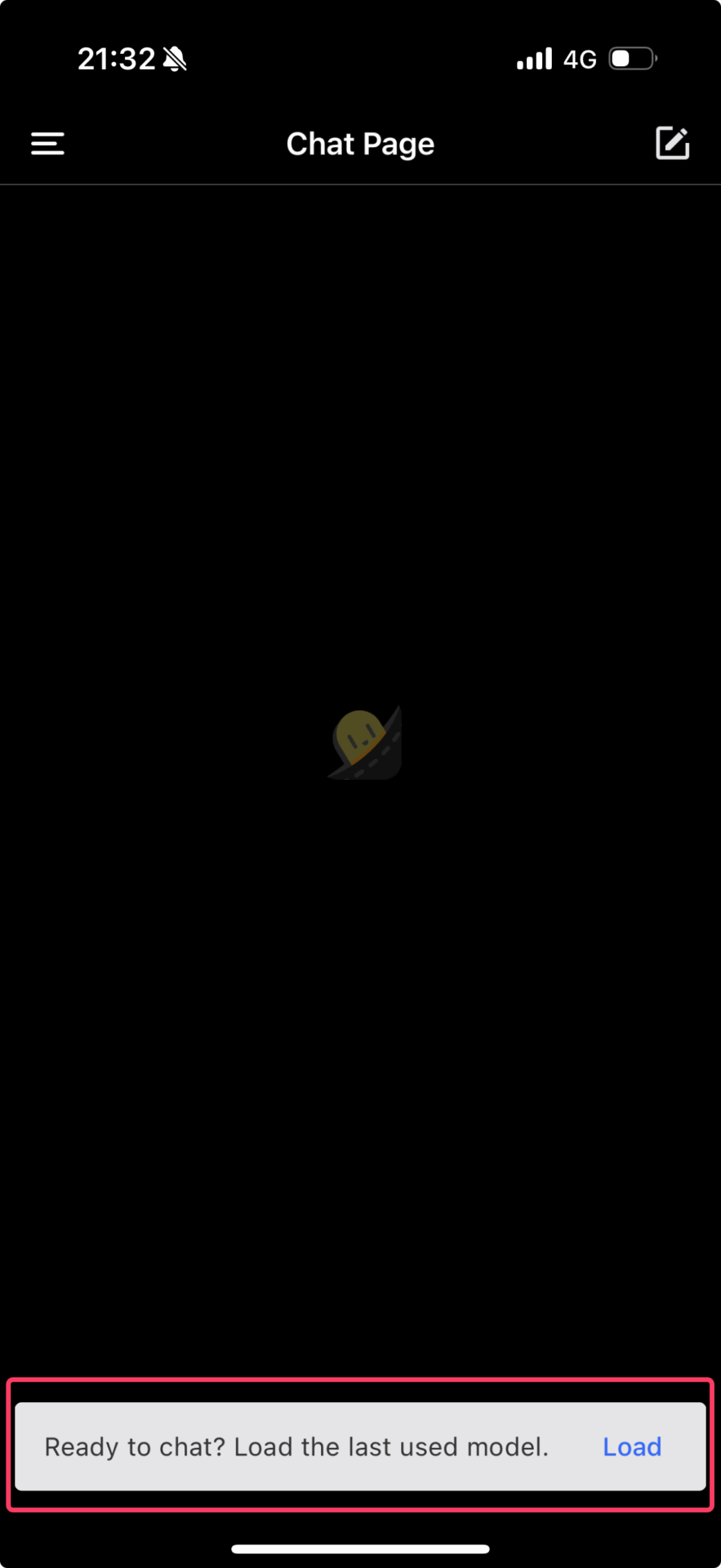

初回起動時など、モデルがロードできていない場合には、「Chat」画面の下部に「Load a model to chat. Go to Models」と表示される。

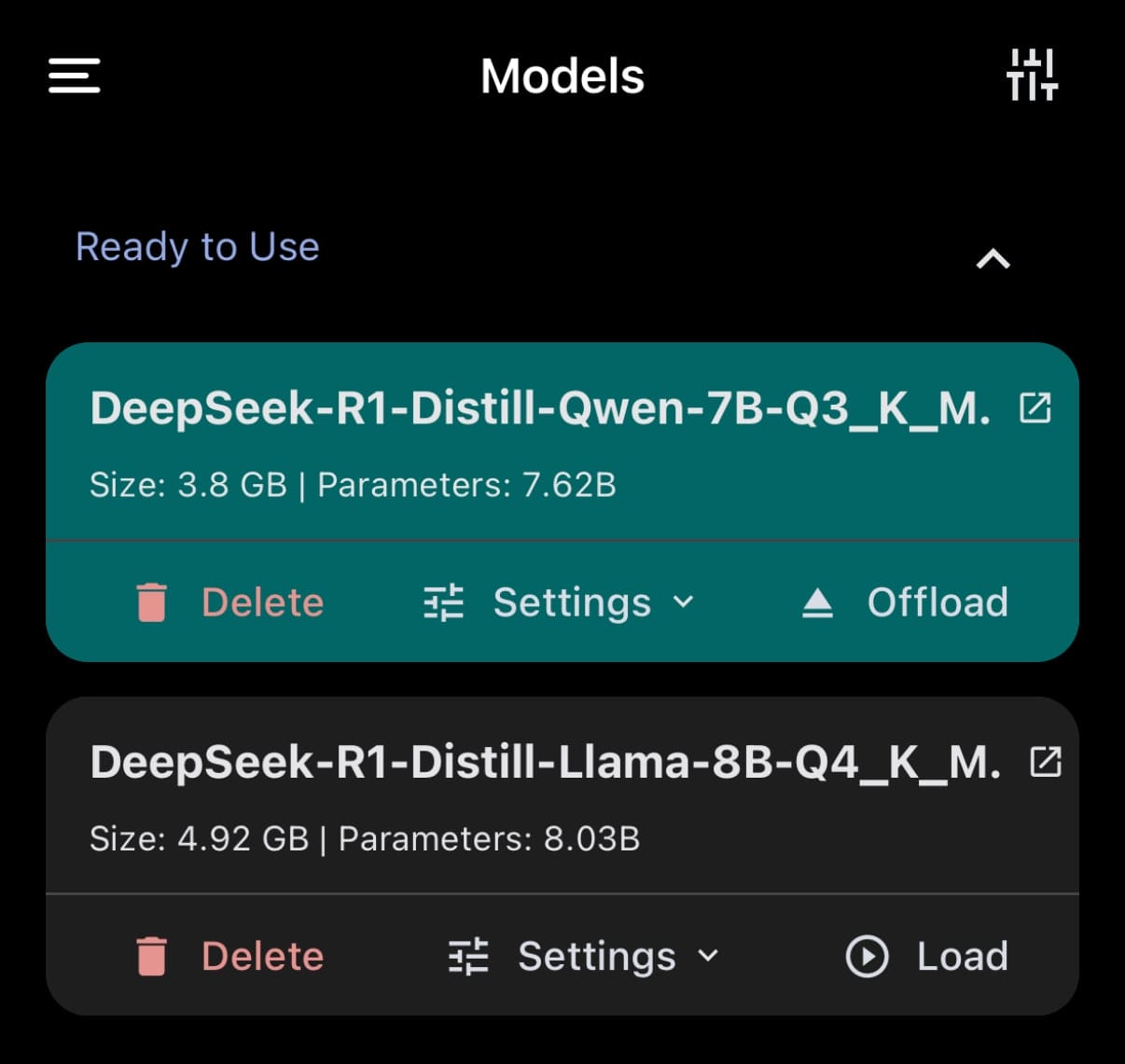

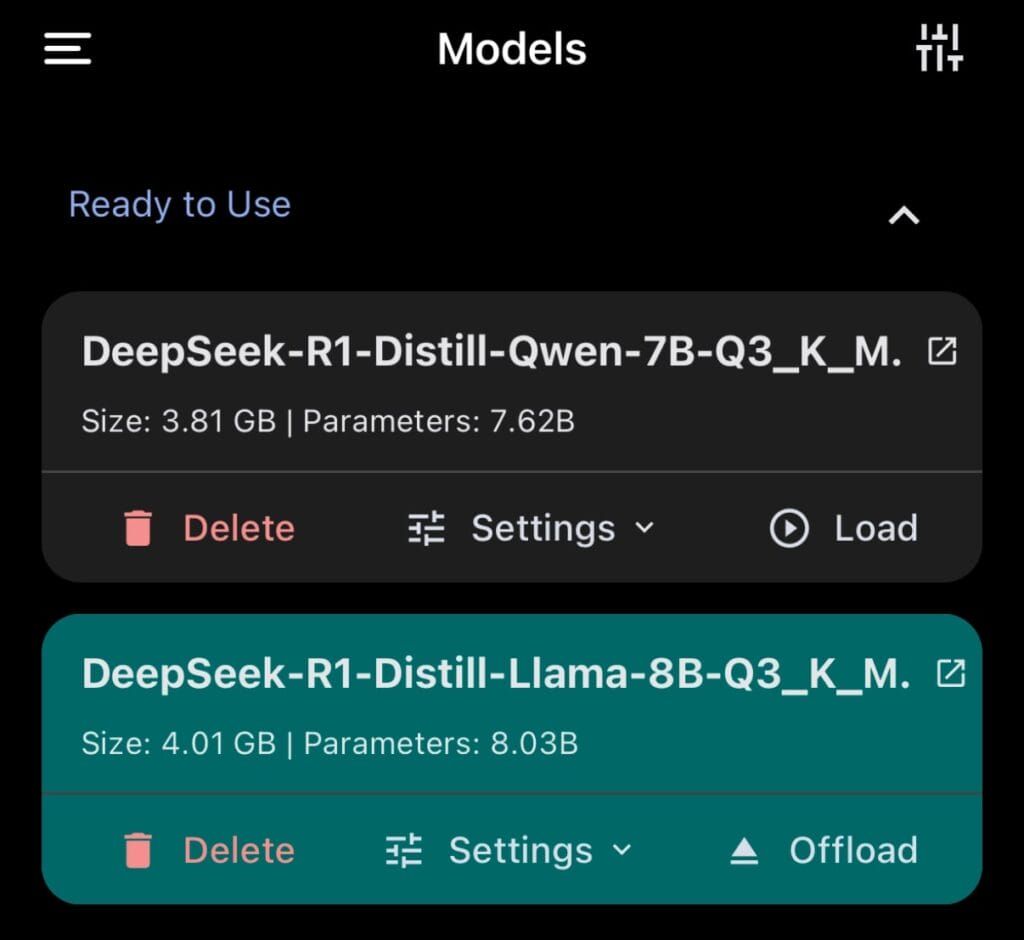

Modelsメニューでは、ダウンロード済みのモデルについては、「Load」というボタンが表示されるようになる。

多数あるモデルの中で、「Load」できるモデルは1度にひとつまでになっている。

今回は、「DeepSeek-R1-Distill-Qwen-7B」モデルをロードした状態にする。

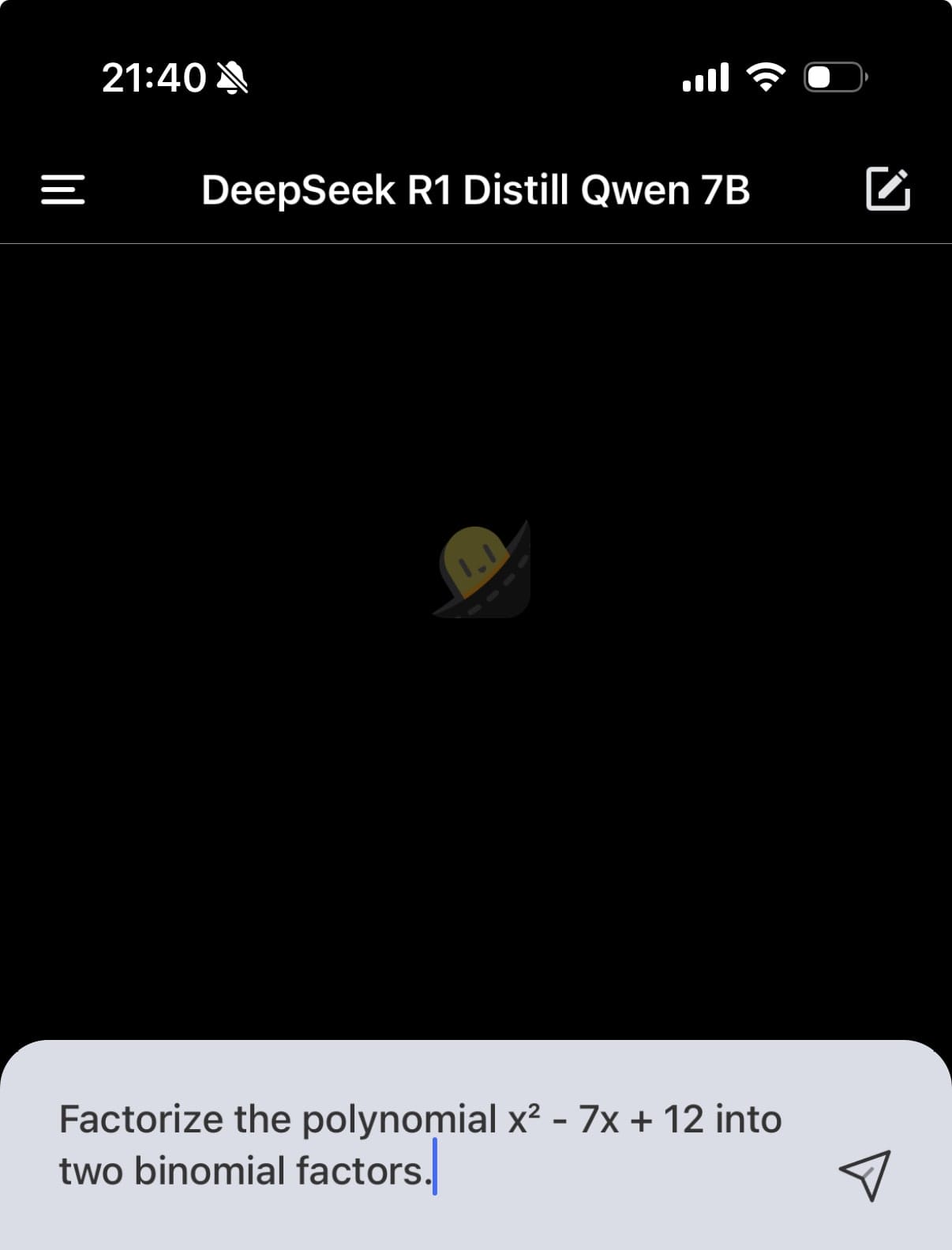

ロードが完了すると、Chat画面の上部に、チャットの相手となるモデル名が表示される。この状態でチャットメッセージを送信すれば、AIが返事を返してくれる。

今回は、ちょっとした因数分解の問題を解かせてみるため、以下のプロンプトを与えた。

Factorize the polynomial x^2-7x+12 into two binomial factors.

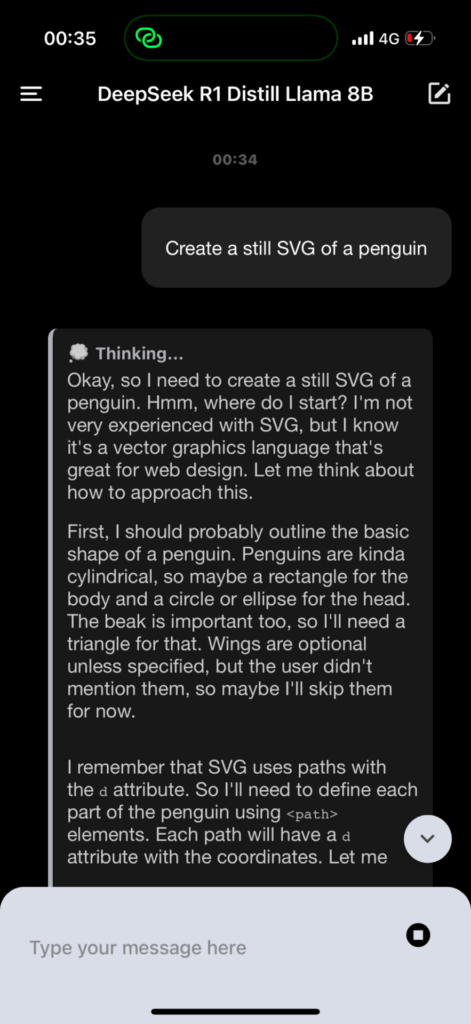

すると、ゆっくりではあるが、DeepSeek R1 Distilled Qwen 7Bモデルが、問題を解き始めた。

DeepSeek R1 の思考過程も、「Thinking…」というボックス内にちゃんと表示してくれる。

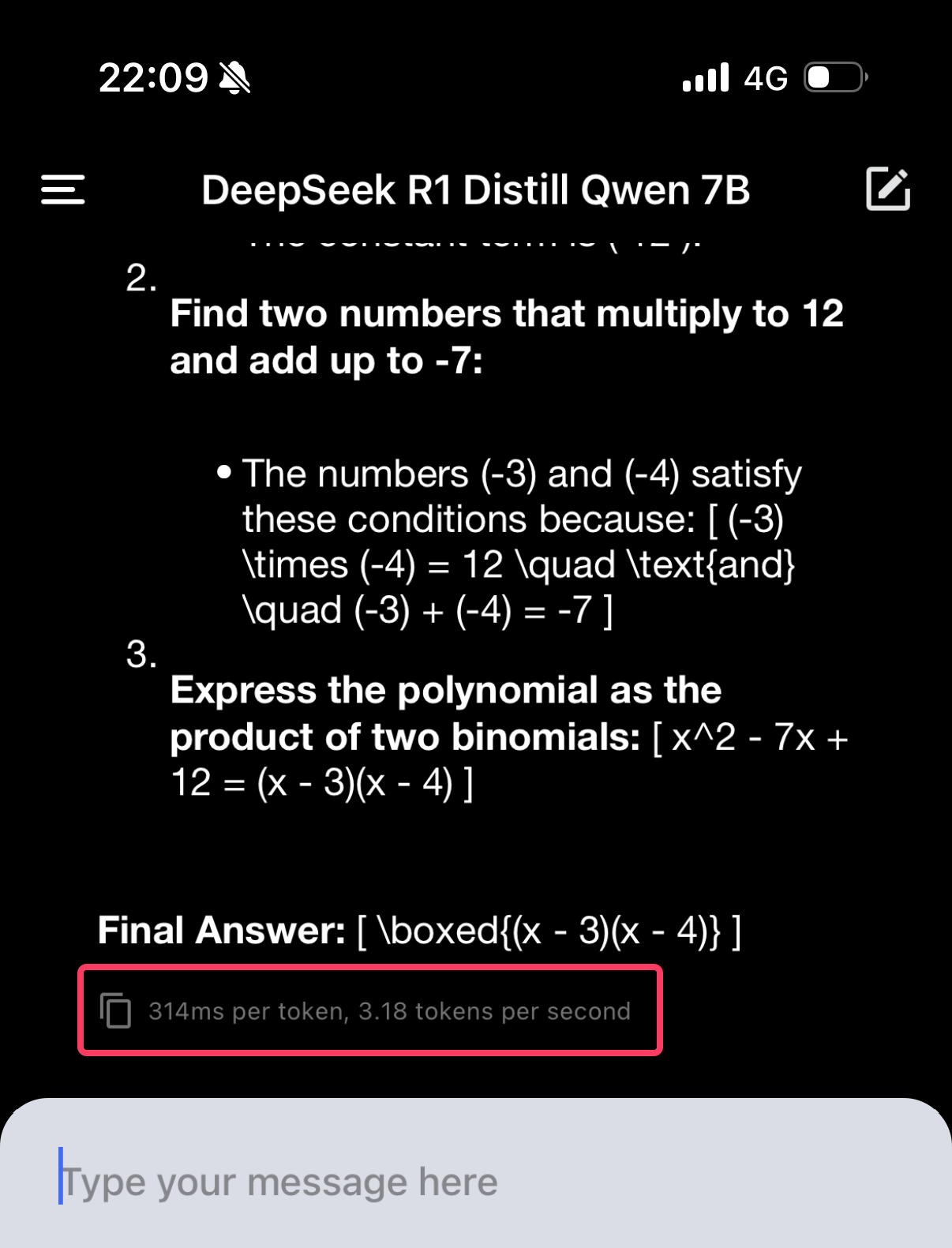

そして、無事に因数分解の正答を導いてくれた。

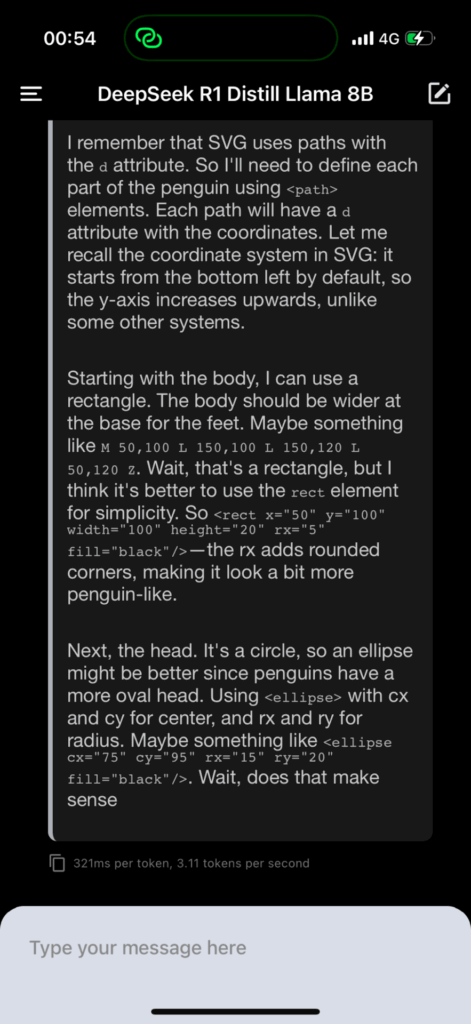

PocketPal AIでは、生成された回答の末尾に、生成に要した秒数と、1秒あたりのトークン数が表示される。

iPhone 16 Proで「DeepSeek-R1-Distill-Qwen-7B-Q3_K_M」を使った場合で、1秒あたりのトークン数は3.18トークンであった。

結構体感としてはゆっくりではあるが、使えないほど遅くはない。

iPhoneやAndroidなどのスマホローカルで、オフラインであっても、このスピードで動作する高性能なAIが使えるというのは、本当にすごい時代だ。

以上のDeepSeekとのチャットを、動画でキャプチャしたものをXに投稿しているので、実際の生成スピードをビデオで確認したい人は確認してみてほしい。

DeepSeek R1 の他のモデルは動作するか?

以上の手順で、数学特化のQwen 7BをベースとしたDeepSeek R1は、無事に動かすことができた。

せっかくであれば、他のモデルも使ってみたい。7Bパラメータでも、iPhone 16 Proではそれなりのスピードで動作することがわかったので、6つのDeepSeek R1 Ditillモデルのうち、Llama 8Bも処理能力的には行けそうだ。

PocketPal AIのバージョン1.6.6では、まだ完全に互換性が確認されていないが、MetaのLlamaをベースとするDeepSeek-R1-Distill-Llama-8Bについても、動作確認をしてみた。

Qwen 7Bをダウンロードした時と同じく、「Models」メニューから、「Add from Hugging Face」をタップして、目的のモデルbartowski/DeepSeek-R1-Distill-Llama-8B-GGUFを検索して見つける。

軽量でなければ動かないと思われるため、bartowski氏が公開している量子化モデルのうち「Q3_K_M」を選択した。

無事モデルロードにも成功し、PocketPal AIのチャットで「DeepSeek-R1-Distill-Llama-8B」との会話をすることができた。特に、思考時間が短い簡潔な質問であれば、サクサクやりとりすることができる。

ただし、思考時間が長くかかりすぎるようなプロンプトを与えると、途中で止まってしまう現象が頻繁に起きた。

例えば、ペンギンのイラストをSVG形式で描け、という指示を与えてみると、序盤は調子良く思考を深めていく様子が見えるが・・・

前触れなく突然生成を停止してしまい、以下のように、思考の途中で回答の生成が終了してしまった。

このような不具合は、PocketPal AIのアプリがまだQwen 7B以外のDeepSeek R1シリーズに最適化されていないため生じるのか、単純にiPhoneのメモリ不足などで生じているのか、厳密には不明だ。

あまり思考時間が長くなりすぎないような質問であれば、特に問題は起きないので、スマホで使用する上ではあまり気にしなくても良いかもしれない。また、今後のPocketPal AIのアップデートで、さらに動作がスムーズに改善していくことに期待したい。

いずれにせよ、「DeepSeek-R1-Distill-Qwen-7B」や「DeepSeek-R1-Distill-Llama-8B」と、スマートフォンでチャットできてしまうというのは、驚くべき話だ。

タスクの種類によっては、GPT-4o並の力を発揮する分野もある蒸留モデルが、一般個人が持っているスマホ端末程度のスペックでも動作してしまうのだから。