2025年1月20日、中国のAI開発スタートアップ「DeepSeek」が、推論モデル「DeepSeek R1」をリリースした。

OpenAIが開発する現状最高精度の推論モデル「o1」と同等の性能を持つと謳われているほか、API価格が OpenAI o1 の25分の1以下というとんでもない価格破壊モデルだ。しかも、自由度の高いMITライセンスでオープンソース化され、誰でもモデルをダウンロードできる。

DeepSeekといえば、昨年のクリスマスに、オープンソース界で世界最大規模の685Bパラメータを誇る「DeepSeek V3」を、突然Hugging Faceに投下して注目を集めた企業だ。

今回のR1も、V3以上の衝撃の発表である。

DeepSeekは、モデルのトレーニングに必要な計算資源・コストを、OpenAIやMetaなど代表的な米国企業が開発するAIよりも大幅にカットすることに成功したとされ、GPUメーカーのNVIDIAの株価が下落するほどの大騒ぎになっている。

「DeepSeek R1」は、すでにWeb上やAPI経由で利用可能になっており、早速筆者も使ってみることができた。

本記事では、登場したばかりの「DeepSeek R1」と「DeepSeek V3」について、簡単に無料で試す方法、APIで利用する方法、そして実際にo1と比較してみた感想を紹介していく。

DeepSeek R1 の概要:性能高すぎ、価格安すぎ

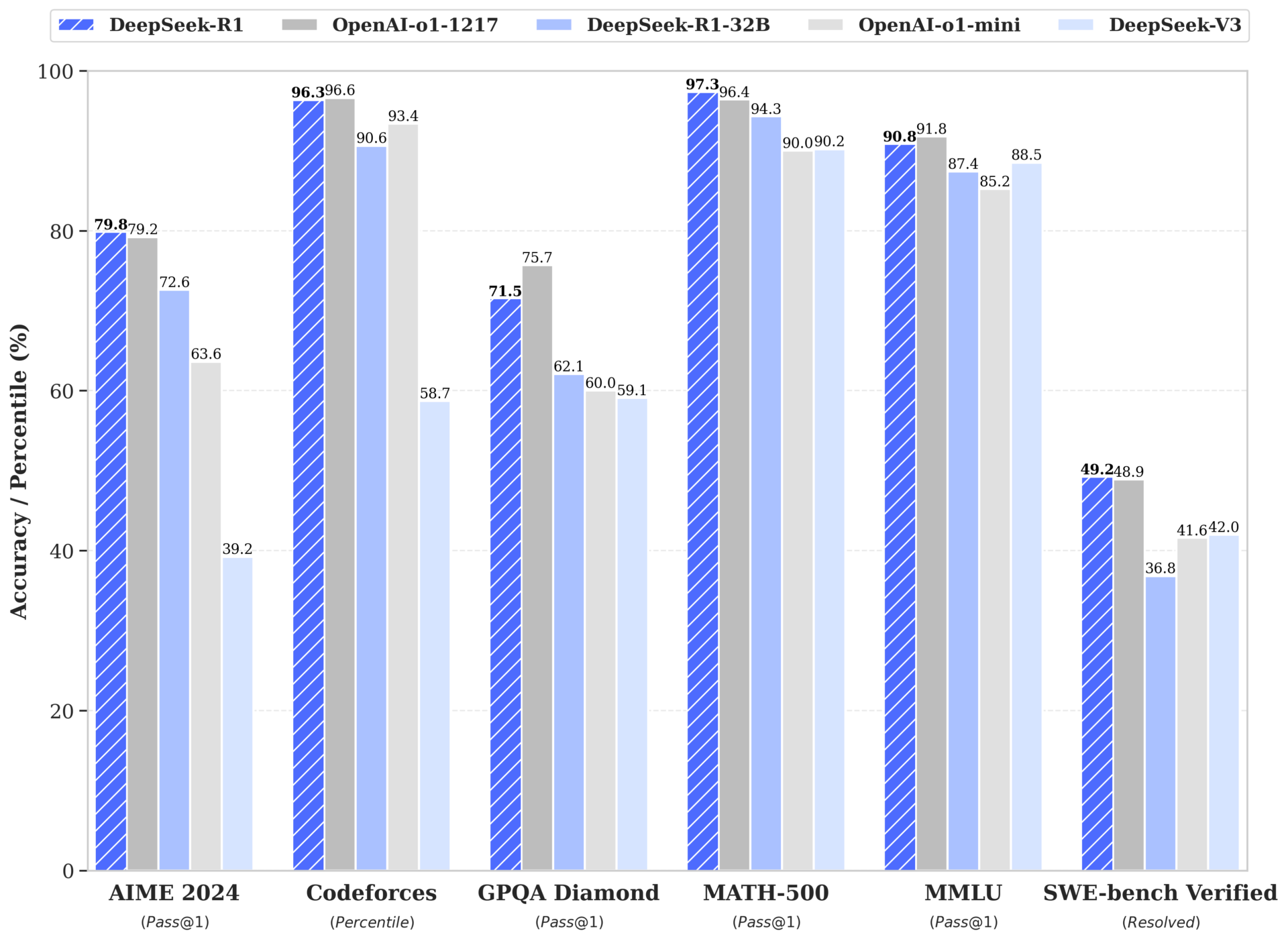

以下は、DeepSeek公式がXに投稿したDeepSeek R1のベンチマークスコアと、o1, o1-mini, DeepSeek V3のスコアを比較したグラフである。

DeepSeek R1は、いずれのベンチマークでも目覚ましいスコアを叩き出している。

例えば、アメリカ数学オリンピック予選の正答率(AIME 2024)では、o1の79.2%を上回る79.8%を記録。また、プログラマーのレーティングサイトのCodeforcesのランクでも、96.3%の人間を抑える高ランクを叩き出している。

なにより注目すべきは、これだけの高性能でありながら、とんでもないほど低コストである、という点だ。

「DeepSeek R1」と、「OpenAI o1」のAPI価格を比較した表が以下である。それぞれ、OpenAIの公式サイトと、DeepSeekの公式Xから価格情報を取得した。

| 項目 | OpenAI o1 | DeepSeek R1 | 割引率 |

|---|---|---|---|

| 入力トークン (キャッシュ有) | $7.50 / 1M tokens | $0.14 / 1M tokens | 98%引き |

| 入力トークン (キャッシュ無) | $15.00 / 1M tokens | $0.55 / 1M tokens | 96%引き |

| 出力トークン | $60.00 / 1M tokens | $2.19 / 1M tokens | 96%引き |

入力トークン(ユーザーの指示テキスト)、出力トークン(モデルが生成した応答テキスト)ともに、o1と比較して96%割引以上の激安価格となっている。

LLMのAPIを、大規模なアプリやサービスに組み込んで使用する場合、API利用料が収益率にダイレクトに影響する。経済的には、もはやDeepSeekを使わない手はないだろう。

また、約1ヶ月前に登場した推論モデルではないチャットモデルのV3も、ユーザー投票によるランキングサイトChatbot Arenaで世界7位で、o1-previewに並ぶ目覚ましい性能を示している。

なぜこれだけの低コストと、高性能が同時に実現できるのか?

DeepSeekが注目を集めている最大の理由は、モデルのトレーニングコストを劇的に圧縮することに成功している点だ。

DeepSeek V3は685Bパラメータの超巨大モデルだが、次点で大きいLlama 3.1 405Bと比べても、なんと11分の1ほどの学習時間しかかかっていないという。そのため、フロンティアモデルの学習コストとしては、破格・激安で済んでいるのだ。

なぜこれ程の効率化が可能になったのかは、V3モデルのテクニカルレポートを読んでも詳細は明かされていないが、なにかしら学習効率を劇的に高める技術を有しているようだ。

DeepSeek R1 を実際に使ってみる方法

「DeepSeek R1」モデルを利用する方法としては、現状以下の3つがある。

- Webインターフェース

- スマホアプリ(iPhone, Android)

- OpenAI互換のDeepSeek APIでモデル「deepseek-reasoner」を使用

これ以外にも、自分でモデルをダウンロードして動かす手もあるにはあるが、流石に個人の所有するPCとGPUでは、スムーズに動作させるのが困難と思われる。

以下、それぞれの方法についてステップバイステップで紹介していく。

DeepSeekのWeb版で、無料で R1 / V3 モデルを試す

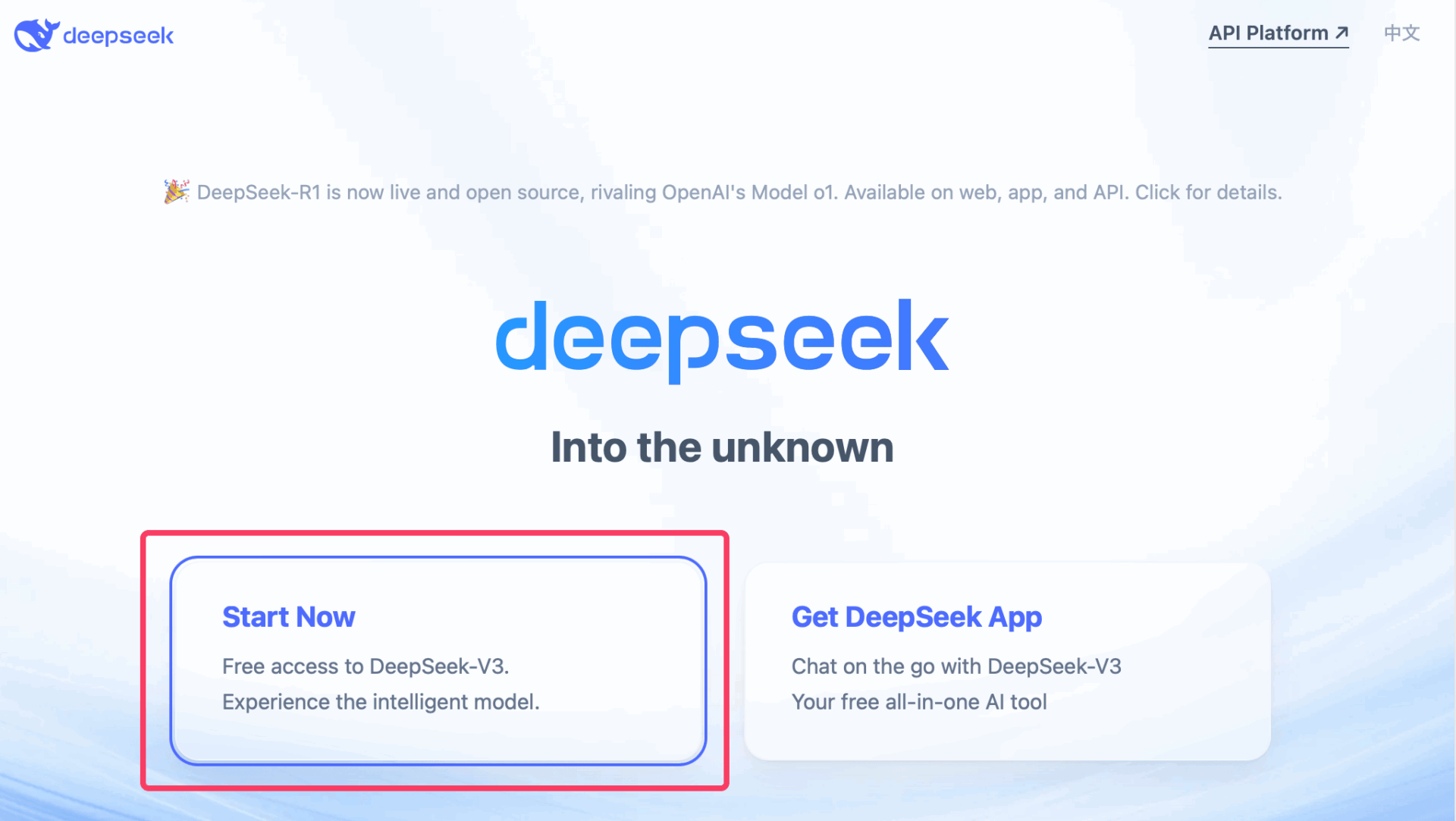

DeepSeekは、公式サイト上で、ChatGPTのようなWebインターフェースを提供しており、アカウントさえ作ればすぐに利用できる。

公式サイトにアクセスして、「Start Now」をクリックし、メールアドレスとパスワードを登録すれば、すぐに無料でWeb版のチャットインターフェースを利用できるようになる。

テキストボックスに質問や指示を打ち込んで送信するだけで、AIが回答してくれる。かなりChatGPTに似たインターフェースなので、使い方は直感的に理解できるだろう。

画像のアップロードや、PDFのアップロードも可能となっている。

OpenAI の o1 モデルは、まだPDFのアップロードに対応していないが、DeepSeek R1 は PDF の読み込みも可能だ。ただし、PDFからテキストと画像を抽出する処理が行われ、アップロード完了までに結構時間がかかる。

利用できるモードとして、推論モデルを使用する「DeepThink」と、Web検索を伴う「Search」モードがある。

デフォルトのチャットは、すべて DeepSeek V3 モデルが回答を生成する。

「DeepThink」をオンにした時だけ、推論モデルである DeepSeek R1 が動作するので、R1を使ってみたい場合には忘れずに「DeepThink」ボタンを押しておく。

DeepSeek R1 モデルは、回答を生成する前段階として、「考える」ステップを踏む。

考えている間のテキストも表示されるので、DeepSeek R1が、ユーザーからの質問を分解して、ステップに分けて、思考している様子を覗き見ることが可能だ。

Web版は無料だが、利用回数に一定の制限がある。現在のところ、1日あたり50回までDeepThinkモードを利用可能であるようだ。

50回を超えて使いたい場合には、後述するAPIなど、別の方法を採る必要がある。

DeepSeekのスマホアプリで無料で R1 / V3 モデルを試す

DeepSeekは、iPhoneアプリとAndroidアプリを公開しており、App StoreやGoogle Play Storeから無料でダウンロードすることができる。

チャットのインターフェースは、アプリ版も、Web版とほぼ同様だ。

「DeepThink」モードでは推論モデルであるDeepSeek R1モデルが利用できる。

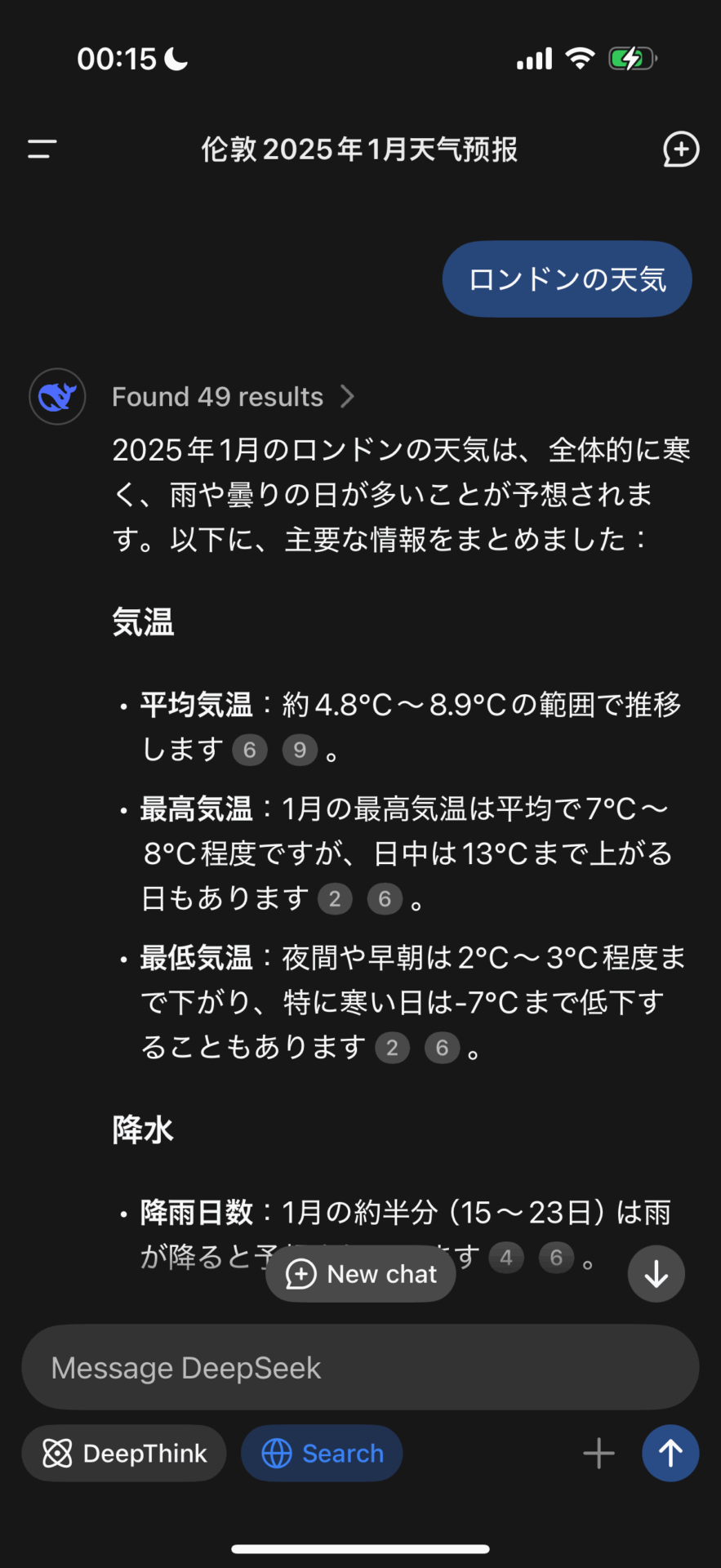

それ以外のモードでは、DeepSeek V3モデルが利用され、「Search」モードではWeb検索した情報を踏まえてV3が回答を生成してくれる。

実際に、アプリ版で推論モードを使用してみた様子が以下である。

Web版と同じく、R1 の思考過程をトグルで開き、覗き見ることができる。

ちなみに、V3モデルを使用するWeb検索モードもかなり実用的で、最新情報を含めた検索結果を要約して回答を生成してくれるので、自分でWeb検索をする手間がかなり省ける。

アプリ版も、現在は無料で利用でき、課金のオプションも存在しない。

Web版と同じく、1日あたりの利用回数は50回に制限されているが、50回もあれば大体の人のニーズは十分満たせてしまうのではないだろうか。

ヘビーユーザーの場合、次で紹介するAPIを使うのがオススメだ。

APIを経由して従量課金・激安でDeepSeek R1 / V3 を使う

Web版とアプリ版は無料だが、利用量に一定の制限があるので、大量に高頻度で使用したい場合は、APIを利用できるようにしておくと便利だ。

DeepSeek APIのプラットフォームにアクセスして、Paypalやクレジットカードで料金をチャージしておくと、使用量に応じてチャージ残高が消化されていく仕組みになっている。

2ドルからチャージできるので、少額をチャージして遊んでみることを勧める。

DeepSeekのAPIは、OpenAIのフォーマットと完全に互換性がある。

既存のOpenAIのモデルを使っているコードの一部を差し替えるだけで、そのままDeepSeekのモデルを利用することができる。

Base URLとモデル名が、APIドキュメントで指定されているので、それを使用する。

現在は、チャットモデルであるDeepSeek V3がdeepseek-chat、推論モデルであるDeepSeek R1がdeepseek-reasonerというモデル名だ。

それぞれ価格は次の表の通りである。概ね、R1モデルの半額がV3モデル、という関係になっている。

| モデル | 1M入力トークン (キャッシュ有) | 1M入力トークン (キャッシュ無) | 1M出力トークン |

|---|---|---|---|

| deepseek-chat | $0.014 | $0.14 | $0.28 |

| deepseek-reasoner | $0.14 | $0.55 | $2.19 |

ちなみに、V3モデルはキャンペーン価格で2月8日まで割引価格となっており、さらに安価に利用できる。

例えば Claude 3.5 Sonnet は、1M入力 $3 、1M出力 $15 (非キャッシュ価格)なので、V3が超低価格なのはもちろん、推論モデルのR1ですら競合他社のチャットモデルより大幅に安価になっている。

DeepSeek API を LibreChat で使う:カスタムエンドポイント作成手順

APIを使用する例として、当サイトでも過去に紹介したことのある「LibreChat」にて、DeepSeekのAPIを使って、R1モデルとV3モデルを呼び出せるようにしてみる。

LibreChatは、あらゆるLLMのAPIを、一つのWebインターフェースで利用できるようにするオープンソースのチャットUIだ。

OpenAI ChatGPT、Google Gemini、Anthropic Claudeなどを、月額課金不要で、1箇所で利用できるので非常に利便性とコスパが高い。

LibreChatの設定ファイルを編集し、「DeepSeek」のAPIをカスタムエンドポイントとして追加し、APIキーを登録すると、LibreChatの画面にDeepSeekの各モデルも現れる。

こちらの記事で紹介しているLibreChatのインストール手順は、すべて完了していると仮定する。

DeepSeekはデフォルトではLibreChatで利用できないので、カスタムエンドポイントを作成する必要がある。

まず、LibreChatのインストールフォルダ内に、docker-compose.override.ymlというテキストファイルを作成し、以下のテキストを記入して保存する。

services:

api:

volumes:

- type: bind

source: ./librechat.yaml

target: /app/librechat.yaml次に、同じ階層に、librechat.yamlというファイルを作成し、以下のテキストを記入して保存する。

ここでは、DeepSeek API のドキュメントに従って、API リクエストの Base URLや、モデルネームを定義しているだけだ。

Base URL として https://api.deepseek.com/v1/ を登録。そして、V3モデルを指す deepseek-chat と、R1モデルを指す deepseek-reasoner の2つのモデルを登録している。

version: 1.2.1

cache: true

endpoints:

custom:

# DeepSeek

- name: 'deepseek'

apiKey: '${DEEPSEEK_API_KEY}'

baseURL: 'https://api.deepseek.com/v1/'

models:

default:

[

'deepseek-chat',

'deepseek-reasoner',

]

fetch: false

titleConvo: true

titleModel: 'deepseek-chat'

modelDisplayLabel: 'deepseek'最後に、DeepSeek API のAPI キーを発行して、環境変数として登録しておく必要がある。

DeepSeek のプラットフォームにアクセスして、「API keys」メニューから、「Create new API key」をクリックして、適当な名前をつけて保存する。

生成された sk- から始まるAPIキーを、忘れずにコピーしておく。

コピーしたAPIキーを、LibreChatのインストールフォルダにある .env ファイルの60行目以降にある「Known Endpoints」の一覧のうち、「DEEPSEEK_API_KEY」の行にペーストする。

これで、LibreChatを再起動すれば、DeepSeekがチャットのメニューから選択できるようになっているはずである。

DeepSeek R1 vs ChatGPT o1 を比べてみた

実際に、DeepSeek R1 の性能をテストするため、いくつかのプロンプトで OpenAI o1 モデルの出力と比べてみた。

総評としては、ベンチマークスコアでo1に肉薄しているというだけあって、全く見劣りしない同じようなクオリティの出力が得られた。

仮想のイラストをSVGで描かせる

SVGファイルとは、線や図形をテキストと数値で表して、文字だけでイラストを描くことのできるフォーマットだ。

大規模言語モデルである DeepSeek R1 であっても、OpenAI o1 であっても、テキストの生成が可能なので、間接的に絵を描かせることができる。

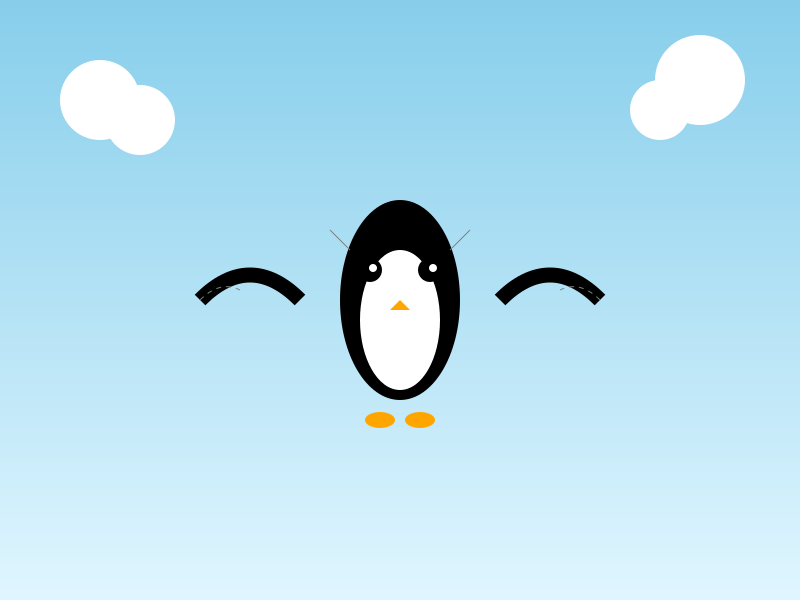

今回は、ペンギンが空を飛ぶ様子、という難易度の高いファンタジーなイラストを描いてもらうことにした。

ペンギンが空を飛ぶ様子を描いた静止画のSVGファイルを作成してくださいDeepSeek R1 が生成した空飛ぶペンギンはこちら。

一方で、OpenAI o1 が生成した空飛ぶペンギンがこちら。

どちらも要件を満たしたSVGを生成してくれた。

甲乙つけ難いが、足の本数などの正確性は、DeepSeek R1 の方が優れていると言えるかもしれない。

ちなみに、GPT-4oモデルでは、以下のように怖いペンギンが生成された。

単純なイラストに見えて、目の輝きや白目の表現などを見比べると、R1 と o1 の優れた表現力が示されていると言えよう。

複雑な思考が必要なクイズを解かせる

2つの容量の異なるバケツを使って、ちょうど「4リットル」を測るのにはどうすれば良いか、という多数の思考ステップを要する問題を出してみた。

いくつかの解き方が存在するので、回答の効率などを評価してみる。

5リットルのバケツと3リットルのバケツを使って、正確に4リットルの水を量るにはどうすればよいですか?他の計量器具はありません。DeepSeek R1 の回答は以下の通り。

5リットルバケツを満たす

→ (5, 0)

5リットルバケツの水で3リットルバケツを満たす

→ 5Lバケツに2L残る

→ (2, 3)

3リットルバケツを空にする

→ (2, 0)

5リットルバケツの残り2Lを3リットルバケツに移す

→ (0, 2)

再び5リットルバケツを満たす

→ (5, 2)

5リットルバケツの水で3リットルバケツを満たす

→ 3Lバケツにはあと1L入るスペース

→ 5Lバケツから1Lを移す

→ 5Lバケツに4L残る

→ (4, 3)OpenAI o1 の回答は以下の通り。

以下の手順で、5リットルのバケツに正確に4リットルの水を量ることができます。バケツ以外の道具は使いません。

1. 3リットルのバケツを満タンにする。

(3リットルバケツ:3L、5リットルバケツ:0L)

2. 3リットルのバケツの水を5リットルのバケツに移す。

(3リットルバケツ:0L、5リットルバケツ:3L)

3. 再び3リットルのバケツを満タンにする。

(3リットルバケツ:3L、5リットルバケツ:3L)

4. 5リットルのバケツがいっぱいになるまで3リットルバケツから水を移す。

このとき5リットルのバケツはちょうど満タン(5L)になり、3リットルバケツには1リットルが残る。

(3リットルバケツ:1L、5リットルバケツ:5L)

5. 5リットルのバケツを空にする。

(3リットルバケツ:1L、5リットルバケツ:0L)

6. 3リットルバケツに残っている1リットルを5リットルのバケツに移す。

(3リットルバケツ:0L、5リットルバケツ:1L)

7. 3リットルのバケツを再び満タンにする。

(3リットルバケツ:3L、5リットルバケツ:1L)

8. 5リットルのバケツに水を移す。

5リットルバケツにはすでに1リットルあるので、3リットルバケツの水を全て移すと合計4リットルになる。

(3リットルバケツ:0L、5リットルバケツ:4L)

これで、5リットルのバケツに正確に4リットルの水を量ることができます。どちらも、最終的に4リットルを測ることに成功はしているが、水を移し替える回数・総ステップの量では、DeepSeek R1 の方がより早く、効率的に「4リットル」にたどり着いている。

これがどこまで推論モデルの実力差を示す指標として妥当かはさておき、R1 は o1 と同等の思考力を有するモデルであることは実感できる。

ローカルで動く小型軽量 Distilled Models もリリース

DeepSeek R1は、完全にオープンソース化されており、モデル自体をダウンロードして、ローカル環境で使用することすらも可能だ。

しかし、R1本体は650GBを超える超大型モデルで、推論の計算負荷が非常に高いため、一般的な個人や中小企業が、ローカル環境で保有しているGPUで実用的なスピードで動作させるのは難しい。

そこで役立つのが、R1と同時にリリースされた6つのDistilled Models (蒸留モデル)たちだ。

LLMにおけるディスティレーション(蒸留)とは、性能の高い上位のモデルを「教師」として、「生徒」である小型の下位のモデルに、特定のタスクに特化した追加学習をさせ、上位モデルに近い性能の獲得を目指す手法だ。

DeepSeek R1のテクニカルペーパーの中では、R1を教師モデルとして、Meta社のLlamaなどをベースに作られた「Distilled Models」6つが紹介されている。

| R1の派生モデル | 元となったモデル | サイズ(ollama配布版) |

|---|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | Qwen2.5-Math-1.5B | 1.1GB |

| DeepSeek-R1-Distill-Qwen-7B | Qwen2.5-Math-7B | 4.7GB |

| DeepSeek-R1-Distill-Llama-8B | Llama-3.1-8B | 4.9GB |

| DeepSeek-R1-Distill-Qwen-14B | Qwen2.5-14B | 9GB |

| DeepSeek-R1-Distill-Qwen-32B | Qwen2.5-32B | 20GB |

| DeepSeek-R1-Distill-Llama-70B | Llama-3.3-70B-Instruct | 43GB |

14Bパラメーターくらいのモデルであれば、個人のMac Book Proなどの高スペックラップトップであっても、実用的なスピードで動作させることが可能だ。

実際に、筆者のMac Book Airのローカル環境で「DeepSeek-R1-Distill-Llama-8B」を動作させるまでのステップを、詳細に解説した記事もあるのでぜひ参考にしてほしい。

また、DeepSeek R1がリリースされた3日後の1月23日、ついにiPhone / AndroidでもDeepSeek R1の蒸留モデルを動かすことのできるアプリが登場したので、以下の記事も参考にしてほしい。

DeepSeek-R1-Liteは1日あたり50回までの制限っぽいですね↓

「目前DeepSeek-R1-Lite在DeepSeek官网上免费可用,每用户每天使用数量限制为50次。在这里不得不吐槽Kimi探索版,每人每天只能用5次,我做个测试还得分几天才能测试完。」

https://blog.csdn.net/weixin_40774379/article/details/143930655

コメントありがとうございました!利用回数について記事に追記しました。

Deepseek寄りすぎではないか。

DSが公開した資料のまま、まるでPR記事すぎない。

テストもあまり少なく参考にならない。