2026年2月4日、フランスのAIスタートアップ Mistral AI が、「Voxtral Transcribe 2」という新たな音声認識モデルをリリースした。

Voxtral Transcribe 2 は、1時間あたり約27円という驚異的な低価格でありながら、Whisperなどの競合モデルを精度・正確性で大きく上回る。

さらに、録音ファイルを文字起こしするモデルと、リアルタイムで瞬時に文字起こしを行うモデルの二つが同時にリリースされている。リアルタイムで喋った内容がテキスト化されていく様子は、かなり感動的だ。

日本語を含む13言語に対応しており、複数人の音声の場合は自動で話者を識別する機能も標準搭載だ。会議の録音の議事録化、インタビュー音声やポッドキャストの文字起こしなど、日々の業務に大いに活かすことができる。

しかも、リアルタイムモデルは、誰でも自由に利用・改変できるライセンス(Apache-2.0)でモデル自体が公開されており、16GB以上のVRAMを備えたGPUがあれば、手元のPCのローカル環境でも動かすことができる。

本記事では、Voxtral Transcribe 2 の概要をまとめるとともに、実際に使ってみる方法まで、詳細に解説していく。

Voxtral Transcribe 2 の概要

Voxtral Transcribe 2は、Mistral AIが開発した音声文字起こし(Speech-to-Text)モデルファミリーである。

2025年7月にリリースされた初代Voxtralの後継にあたり、用途に応じた2つのモデルで構成されている。

- Voxtral Mini Transcribe V2(バッチモデル):録音済みの音声ファイルを高精度に文字起こしする

- Voxtral Realtime(リアルタイムモデル):ライブ音声をリアルタイムに文字起こしする

この2つは、明確に役割が分かれている。

バッチモデルは精度と機能の豊富さに優れ、リアルタイムモデルはレイテンシ(音声が入力されてからテキストとして出力されるまでの遅延時間)の短さに特化している。

以下で、それぞれの特徴を詳しく見ていこう。

バッチモデル:Voxtral Mini Transcribe V2

バッチモデルは、録音済みの音声ファイルを高精度に文字起こしするためのモデルだ。Mistral APIを通じてクラウドで利用する(モデル本体は非公開)。

主な特徴は以下の通りである。

- 価格:$0.003/分(約0.4円/分、1時間あたり約27円)

- 精度:ワードエラー率 約4%

- 対応言語:13言語(英語、日本語、中国語、ヒンディー語、スペイン語、アラビア語、フランス語、ポルトガル語、ロシア語、ドイツ語、韓国語、イタリア語、オランダ語)

- 最大音声長:1リクエストあたり3時間/1GBまで

価格の安さと、精度の高さだけでも十分にインパクトがあるが、Voxtral Transcribe 2は、OpenAI Whisperなどの競合モデルにはない機能が非常に充実している。

- 話者ダイアリゼーション:「誰が発言したか」を自動で識別し、発言者ごとにテキストを整理する。会議の議事録やインタビューの書き起こしで便利。

- コンテキストバイアシング:社名・製品名・業界用語など、最大100個の単語を事前登録し、固有名詞の認識精度を向上させることが可能。現時点では英語での登録に対応。

- 単語レベルのタイムスタンプ:単語ごとに開始・終了時刻が付くため、字幕生成や音声検索に直接活用できる。

- 騒音環境への耐ノイズ性能:従来モデルでありがちなBGMの歌詞や周囲の雑談を誤認識する問題を克服。工場やコールセンターなど騒がしい環境での利用も可能。

話者識別をオンにして、自社でよく使う専門用語を事前登録しておけば、MTGの文字起こしはほぼ完璧に自動化することができそうだ。

リアルタイムモデル:Voxtral Realtime

リアルタイムモデルは、ライブ音声をストリーミングで文字起こしするための専用モデルだ。

音声がマイクから聞こえてきた瞬間に、逐次的に文字起こしを行う独自のストリーミングアーキテクチャを採用している。

- 価格:API経由 $0.006/分(1時間あたり約54円)、ローカル利用は無料

- レイテンシ:80ms(0.08秒)〜2.4秒の範囲で設定可能

- 動作要件:クラウド上、または16GB以上のGPU搭載のPCで動作可能

このモデルの最大の魅力は、音声が入力されてからテキストとして出力されるまでの遅延時間(=レイテンシ)を、用途に合わせて調整できる点だ。

レイテンシを短くすると高速になるが精度が落ち、レイテンシを長くすると低速になるが精度が上がる。

| 遅延設定 | 用途 | 精度 |

|---|---|---|

| 200ms(0.2秒)以下 | ボイスエージェント、音声アシスタント | やや低下するがリアルタイム応答を優先 |

| 480ms(約0.5秒・推奨) | 汎用的なリアルタイム文字起こし | オフラインモデルとほぼ同等 |

| 2.4秒 | 字幕生成 | バッチモデルと同等の高精度 |

レイテンシといっても、そこまで遅くなるわけではなく、480ms(約0.5秒)の遅延設定がMistral推奨の「スイートスポット」だ。

わずか0.5秒の待ち時間で、バッチモデルに迫る精度を、リアルタイムで実現することができるのだから驚きだ。

なぜ超高速なリアルタイム処理が可能なのか?

従来の文字起こしモデルの多くは、録音済みの音声ファイルを丸ごと受け取り、ある単語を認識する際に「その前後に何が話されているか」を手がかりに推測していく設計になっている。

音声ファイル全体を見渡せるので精度は高いが、最後まで録音が終わってから処理が開始され、速度も低速なため、リアルタイム用途には不向きだった。

Voxtral Realtimeは、2つの設計上の工夫で、この課題を克服している。

1つ目は「causal attention」と呼ばれる仕組みだ。

録音ファイルを前後に行き来する従来方式とは異なり、「今までに聞こえた音声だけ」を手がかりにテキストを生成する。人間が会話を聞きながらリアルタイムでメモを取るのと同じ発想で、この先に何が話されるかを待たずに即座に処理できる。

2つ目は「sliding window attention」だ。

AIの文字起こしモデルは、音声中のあらゆる時点同士を互いに照合して文脈を把握する。

10分の音声なら10分×10分の組み合わせ、1時間なら1時間×1時間の組み合わせを計算するため、音声が長くなるほど計算量とメモリ消費が急激に膨らむ。

sliding window attentionは、常に直近の一定範囲(窓=window)だけに注目し、古い部分は窓をスライドさせて処理対象から外していく方式だ。これにより、理論上は何時間でも途切れなく文字起こしを続けられる。終日の会議やライブ配信でも、メモリ不足で止まる心配がない。

既存の文字起こしモデルとの精度比較

Voxtral Transcribe 2のパフォーマンスを、他の競合モデルと比較するため、主要なモデルの情報を集めた。

表中の「エラー率」はWER(Word Error Rate)と呼ばれる指標で、100語の音声のうち何語を間違えるかを示している。低いほど文字起こしの精度が高く、正確だ。

数値は独立した評価機関Artificial Analysisが、会議音声や決算説明会の録音など実際のビジネスシーンに近い条件で測定した結果に基づいている。

| モデル | エラー率(低いほど正確) | 1時間あたりの料金目安 | オープンウェイト |

|---|---|---|---|

| Voxtral Mini Transcribe V2 | ~4%(Mistralの自社測定) | 約27円 | No |

| ElevenLabs Scribe v2 | 14.0% | 約60円 | No |

| AssemblyAI Universal | 14.5% | 約23円 | No |

| Whisper large-v3 | 16.8% | 約4〜54円 | Yes |

| Deepgram Nova-2 | 17.3% | 約39円 | No |

| Gemini 2.5 Flash | 19.2% | 約17円 | No |

| GPT-4o mini Transcribe | 20.1% | 約27円 | No |

Voxtral Transcribe 2 は、ワードエラー率が極めて低く、また料金も GPT-4o mini などと並ぶ低価格だ。価格性能比での優位性が非常に高いと言える。

ただし、Artificial AnalysisのVoxtral V2 の評価結果がまだ公開されておらず、上記の約4%というエラー率は、Mistral自身による測定値であり、テストの条件が揃っていない点に注意してほしい。

とはいえ、初代Voxtral Miniも、Artificial Analysisの同条件で15.8%を記録していたので、Voxtral V2が他のモデルよりも高性能・低価格であることはほぼ間違いないだろう。

Voxtral Transcribe 2 を実際に試してみる方法

ここからは、Voxtral Transcribe 2を実際に触ってみる方法を、ハードルの低い順に紹介していく。

方法1:Hugging Faceのライブデモで体験する(コード不要)

最も手軽な方法は、Hugging Faceで公開されているVoxtral Realtimeのライブデモを使うことだ。ブラウザさえあれば、コードを書く必要もアカウント作成も不要である。

実際に筆者も試してみたが、日本語の音声であっても、かなりスムーズに文字起こしが行われて驚いた。漢字やカタカナの使い分けまで正確に行われていることがわかる。

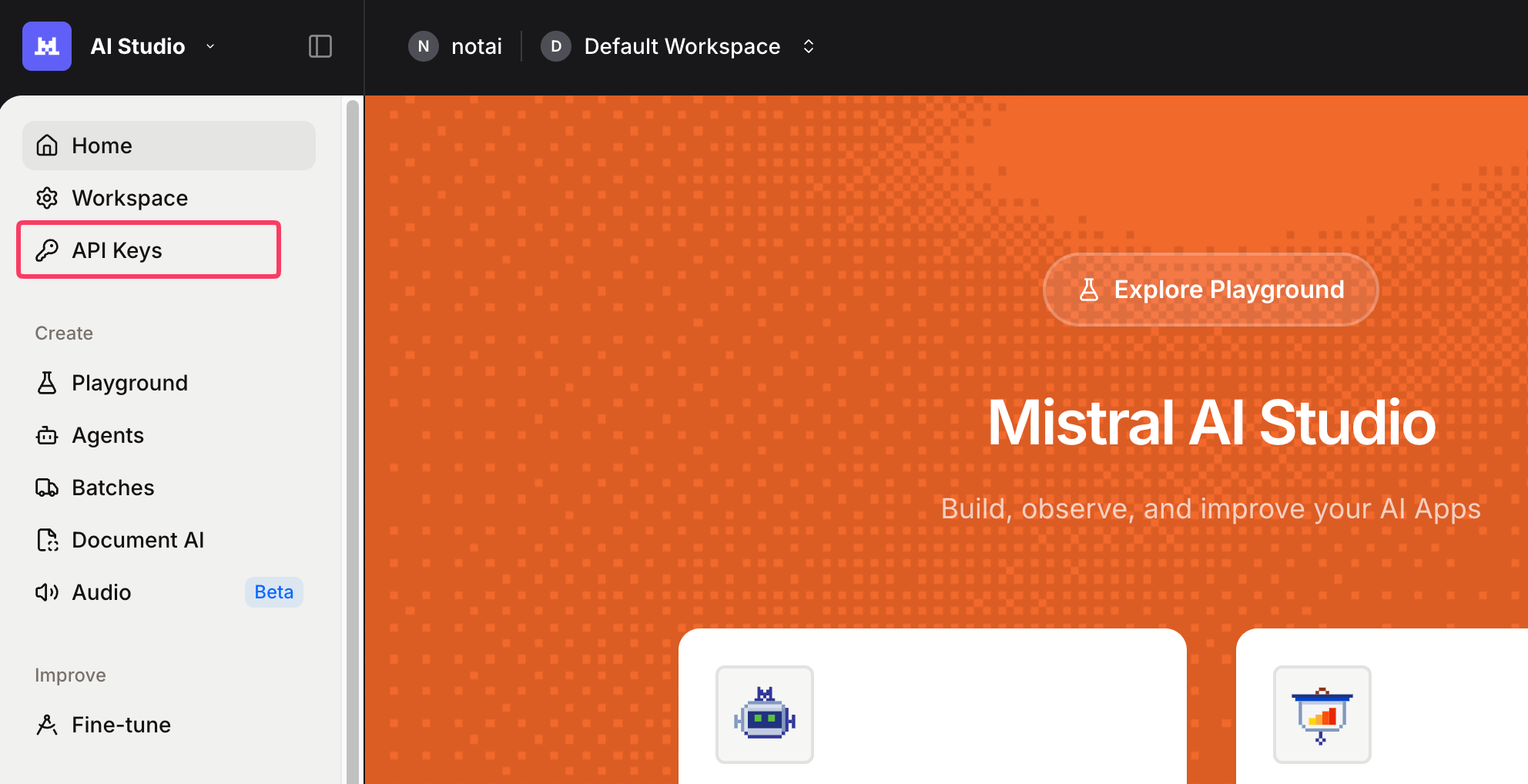

当初は無料で利用できたが、現在はMistralのAPIキーを入力する必要があるので、まずはMistralのアカウントを作成してAPIキーを発行しよう。

APIキーを取得したら、Voxtral Realtimeのライブデモを開き、APIキーをペーストする。

「Record」ボタンをクリックすると、ブラウザからマイクの使用許可を求められるので「許可」を選択し、マイクに向かって話しかけると、リアルタイムで文字起こしが開始される。

Hacker Newsのコミュニティでも「Eminemのラップをリアルタイムで正確に文字起こしできた」という報告が上がるなど、速度と精度の両面で驚きの声が多い。

方法2:Mistral Studioのオーディオプレイグラウンドで試す

バッチモデル(Voxtral Mini Transcribe V2)を試すなら、Mistral Studioのオーディオプレイグラウンドがおすすめだ。音声ファイルをアップロードするだけで、ダイアリゼーション付きの文字起こし結果が得られる。

利用にはMistralのアカウントが必要だが、無料枠が用意されている。

まずは、Mistral Consoleにアクセスし、アカウントを作成・ログインする。

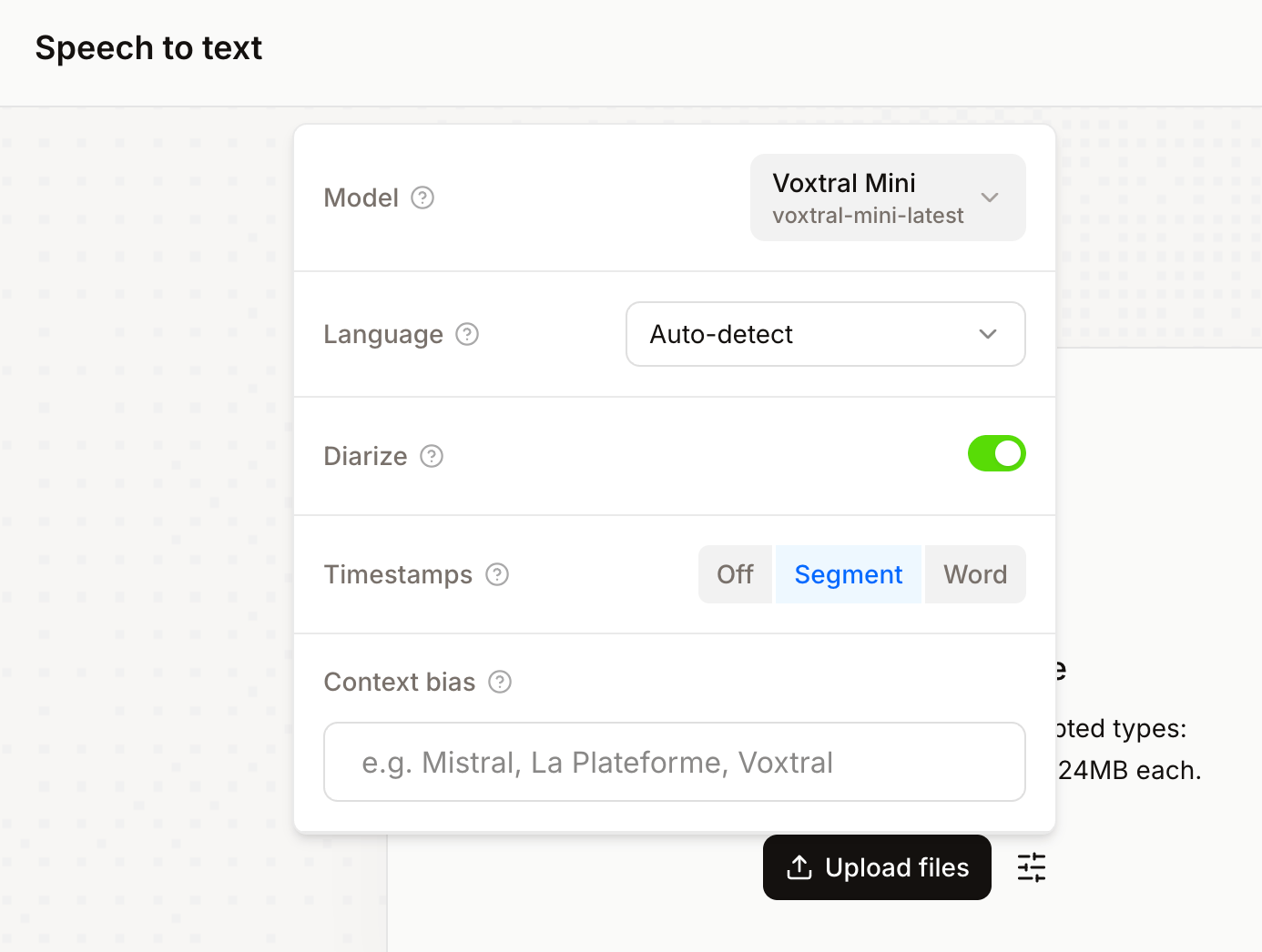

左側メニューから「Audio」→「Speech to Text」を選択すると、以下のように音声ファイルをアップロードする画面になる。

設定アイコンをクリックすると、話者識別などの以下のオプションを設定できる。

- Diarize:ONにすると話者識別が有効になる

- Timestamps:タイムスタンプなし(off)、または「segment」ごと、「word」ごとを選択

- Context Bias:固有名詞や専門用語を登録できる(英語に最適化)

あとは「Transcribe」をクリックするだけで、文字起こし結果がテキスト、SRT、JSON形式でダウンロード可能になる。

方法3:Python APIで文字起こしする

プログラマーであれば、APIを直接叩いてワークフローに組み込むのが最も柔軟な方法だ。

- Mistral ConsoleでAPIキーを取得する

- Python環境に Mistral SDK をインストールする

pip install mistralaiPythonでの実装も非常にシンプルである。

from mistralai import Mistral

client = Mistral(api_key="YOUR_API_KEY")

with open("meeting-recording.m4a", "rb") as audio_file:

result = client.audio.transcriptions.create(

model="voxtral-mini-latest",

file=audio_file,

diarize=True,

timestamp_granularities=["segment"],

)

print(result.text)パラメータの意味は以下の通りだ。

model:使用するモデル名。バッチモデルはvoxtral-mini-latestを指定file:文字起こしする音声ファイルdiarize:trueにすると話者識別が有効になるcontext_bias:カンマ区切りで固有名詞・専門用語を指定(最大100個)timestamp_granularities:segment(発話単位)またはword(単語単位)を選択

リアルタイム文字起こし(マイク入力)

リアルタイムモデルをAPI経由で使う場合は、WebSocket接続でストリーミング処理を行う。

公式ドキュメントにはPyAudioを使ったマイク入力のリアルタイム文字起こしのサンプルコードが公開されている。

完全なサンプルコードは公式ドキュメントに掲載されているので、そちらを参照してほしい。

方法4:ローカルでのデプロイ(上級者向け)

リアルタイムモデル(Voxtral Realtime)はApache 2.0ライセンスのオープンウェイトとしてHugging Faceで公開されている。

BF16形式で約8.87GBのダウンロードサイズであり、16GB以上のVRAMを搭載した単一GPUで動作する。

現時点で公式にサポートされている推論フレームワークはvLLMのみである。TransformersやLlama.cppへの対応は、コミュニティの貢献待ちの状態だ。

ローカル実行は、音声データを一切外部に送信しない完全プライベートな文字起こし環境を構築したい場合や、API利用コストを抑えたい大量処理のケースに適している。

セットアップの詳細はHugging Faceのモデルカードを参照してほしい。

音声文字起こしの可能性はどこまで広がるか

本記事では、Voxtral Transcribe 2の2つのモデル――バッチモデルとリアルタイムモデル――の技術的な特徴、競合モデルとの精度比較、そして実際に試してみる方法を紹介した。

1時間あたり約27円という破格のコスト効率、競合を上回る精度、リアルタイムモデルのオープンウェイト公開、日本語を含む13言語への対応。Voxtralは、WhisperやGPT-4oに変わる強力な選択肢となった。

筆者としては、低価格・高精度・オープンウェイトの3拍子が揃ったことで、音声文字起こしの応用が一気に広がることに期待したい。

高精度なリアルタイム文字起こしが低コストで手軽に使えるようになれば、聴覚に障害のある方が、周囲で交わされている会話をスマートフォンやスマートグラス越しにリアルタイムで把握できる未来も、決して遠くないはずだ。

また、ビジネスの世界で言えば、コールセンターやカスタマーサポートにも役立つはずだ。Voxtral Realtimeで通話をリアルタイムに文字起こしし、その内容をバックエンドに逐次処理すれば、顧客が説明し終える前にオペレーターの画面へ関連情報を表示する、といった活用も可能となる。

さらに、ローカル環境・オンプレミスでも利用可能なため、医療・法律・金融などのコンプライアンス上の制約の大きい業界でも利用でき、応用の幅は無限に広がる。

まずはHugging FaceのデモかMistral Studioのプレイグラウンドで、その実力を確かめてみてほしい。