2025年4月29日、中国アリババグループのAlibaba Cloudが、新たなオープンソースの大規模言語モデル「Qwen3」ファミリーをリリースした。

推論モードと非推論モードの両方を利用できるハイブリッドモデルであり、数学やコーディングなどのベンチマークで、Deepseek-R1やOpenAI-o1などの競合モデルを超える性能を示している。

しかも、商用利用や改変・複製・再配布などが可能な「Apache 2.0」ライセンスで配布されているので、最高水準のLLMを、自社専用のローカル環境等でも自由に活用できる。

モデルサイズも、超小型軽量モデル(Qwen3-0.6B)から超大型MoEモデル(Qwen3-235B-A22B)まで、8種類ものバリエーションで提供されており、iPhoneからMac miniまで、幅広い環境での応用が考えられる。

本記事では、Qwen3の概要をまとめるとともに、実際にQwen3の各モデルを手軽に無料で使うことができる方法を紹介する。

Qwen3 の概要と特徴:アリババが開発するオープンソースモデル

Qwen3には、サイズやタイプによって8つのモデルが存在する。

大きくは、MoEアーキテクチャを採用した2モデルと、そうではない6モデルに分けることができる。8つのモデル全て、Hugging FaceなどでApache-2.0ライセンスで配布されている。

- Denseモデル: Qwen3-0.6B, Qwen3-1.7B, Qwen3-4B, Qwen3-8B, Qwen3-14B, Qwen3-32B

- MoEモデル: Qwen3-30B-A3B (30B total / 3B active), Qwen3-235B-A22B (235B total / 22B active)

Mixture of Experts(MoE)とは、モデルを複数のサブネットワーク(「エキスパート」)に分割し、入力に対して一部のエキスパートのみを活性化することで(”疎”な活性化)、計算負荷を大幅に削減しながらも、モデルの大型化の恩恵を受けることのできる仕組みだ。

例えば「Qwen3-30B-A3B」は、総パラメータ数30Bのうち、推論時に活性化するのは3Bのみであるため、高い性能を発揮しつつも、計算コストを極端に抑えられる。

それに対して、MoEを採用せず、計算負荷の高い”密”(Dense)な活性化を行うのが上に挙げたDenseモデルのラインナップである。

Qwen3は、それぞれのモデルが2つの思考モード (/think または /no_think) を切り替えることのできる「Hybrid Thinking Mode」を採用している。

推論モードをオンにすると(/think )、結論を出す前に、モデルが自問自答を繰り返して”考えて”から、最終的な回答を生成する。

Claude 3.7 Sonnet にも同様の機能があるが、思考に割くトークン数を「Thinking Budget」として制限することも可能である。

数学やコーディングのような複雑な論理思考が必要な質問では推論をオンにして、スピード重視で回答して欲しい場合にはオフにする、といった使い方が可能である。

Qwen3 のベンチマーク結果:OpenAI o1 や o3-mini にも迫る性能

Qwen3は、LLMの主要なベンチマークにおいて、Deepseek R1などの既存のオープンソースモデルの性能を上回っているほか、OpenAIやGoogle, xAIなどの商用クローズドモデルにも匹敵する性能を示している。

流石に最新のo3などのフラグシップを超えてはいないものの、o1やo3-mini-mediumのスコアは上回っており、オープンソースモデルの中では最高峰の性能と言えるだろう。

中でもQwen3の最大パラメータを誇るフラグシップモデルと言える「Qwen3-235B-A22B」は、米国数学オリンピック(AIME2025)の正答率や、コーディング能力のランキングサイトCodeForcesのELOレーティングで、目覚ましいスコアを叩き出している。

| ベンチマーク | Qwen3-235B-A22B (MoE) | Qwen3-32B (Dense) | Deepseek-R1 | OpenAI-o3-mini (Medium) | OpenAI-o1 (2024-12-17) |

|---|---|---|---|---|---|

| ArenaHard | 95.6 | 93.8 | 93.2 | 89.0 | 92.1 |

| AIME’25 | 81.5 | 72.9 | 70.0 | 74.8 | 79.2 |

| LiveCodeBench | 70.7 | 65.7 | 64.3 | 66.3 | 63.9 |

| CodeForces | 2056 | 1977 | 2029 | 2036 | 1891 |

| Aider | 61.8 | 50.2 | 56.9 | 53.8 | 61.7 |

| LiveBench | 77.1 | 74.9 | 71.6 | 70.0 | 75.7 |

| BFCL | 70.8 | 70.3 | 56.9 | 64.6 | 67.8 |

| MultiIF | 71.9 | 73.0 | 67.7 | 48.4 | 48.8 |

非MoEのDenseモデルの最大サイズ「Qwen3-32B」も、Deepseek R1と肩を並べるスコアを出している。このサイズのモデルであれば、64GBのメモリを積んだMacなどで十分動作しうるので、非常に高性能なLLMが、誰でも無料で、ローカル環境で利用できることを意味する。

また、各モデルは日本語を含めて119言語をサポートしており、マルチリンガル性能も高い。

筆者がQwen3-235B-A22Bで様々なプロンプトを試してみたところ、日本語能力は非常に高いと感じた。ほとんど違和感のない日本語で会話をすることができる。

Qwen3 を試す方法:ローカル環境から欧米のGPUホスティングまで

Qwen3は、リリース初日から多くのフレームワークやツールでサポートされている。

Hugging FaceのTransformersライブラリ、ローカル環境で簡単にLLMを実行できるOllama、Appleシリコンでの実行に特化したmlx-lmなど、主要なツール群との調整が事前に行われていたようである。

ここでは、無料で手軽にQwen3の各モデルを試す方法をいくつか紹介する。

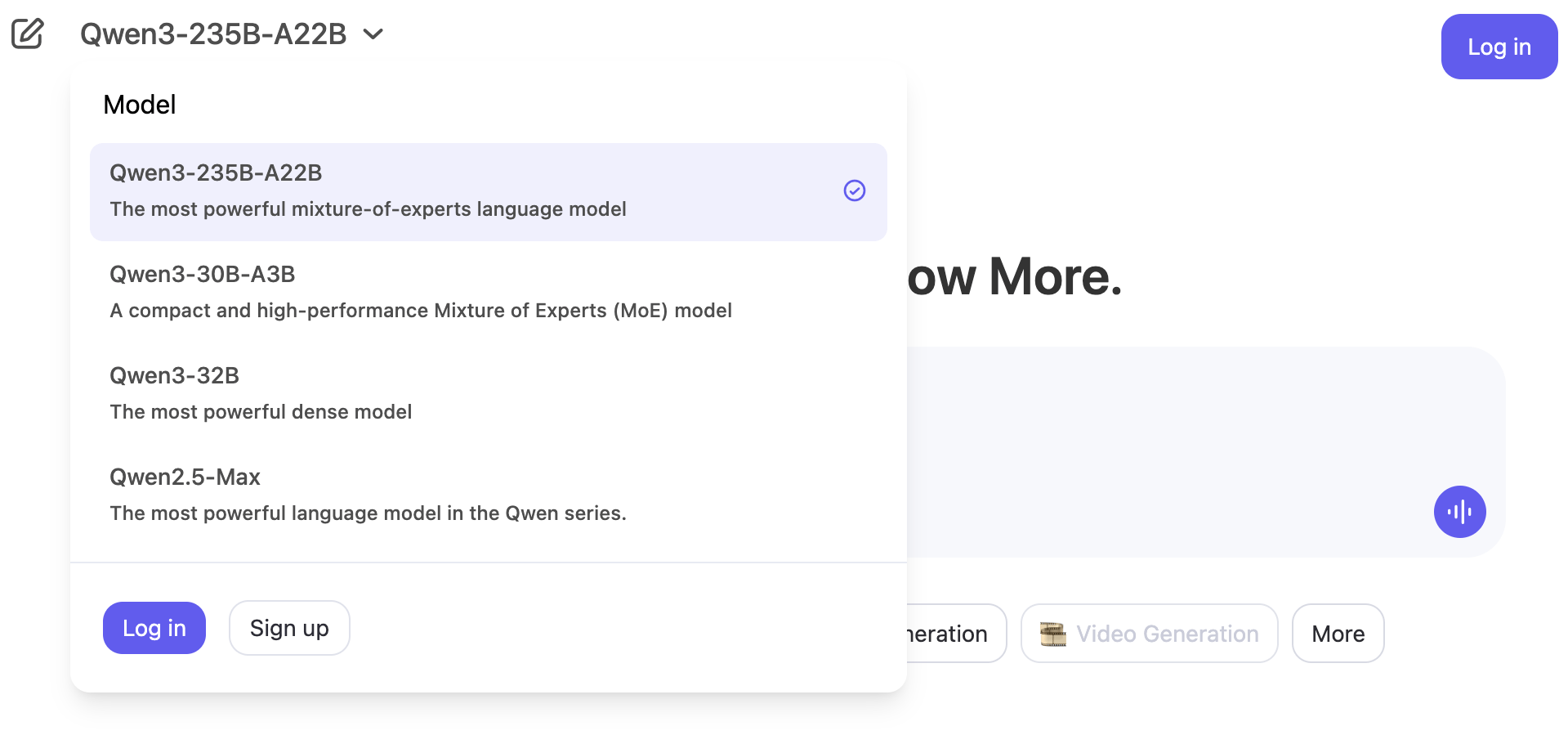

公式Webアプリを使って手軽に Qwen3 の主要モデルを使う

最も手軽にQwen3を試す方法は、Alibaba Cloud 公式のWebアプリを経由して利用する方法だ。

ChatGPTのような見慣れたチャットUIインターフェースで、Qwen3-32B、Qwen3-30B-A3B、Qwen3-235B-A22Bなどの上位モデルを利用することができる。

会員登録すらも不要で、ブラウザ上で無料で利用することができるので、とりあえずQwen3の性能をサクッと確認したいだけ、といった用途では、これが最も手軽だ。

ただし、チャット履歴などを利用したい場合には、会員登録が必要である。

Web検索機能のオンオフや、Thinkingモードのオンオフも、分かりやすいボタン操作で変更することができる。

プライベートな情報や機密情報を含んだプロンプトを送信しないのであれば、特に気にする必要はなさそうだが、会員登録するとアリババクラウドに個人情報を提供する必要があるというのがデメリットである。

OpenRouter を使って Qwen3 を米国サーバー上で使う

Qwen3はモデル自体が公開されているので、クラウドコンピューティングサービス各社の中から、Qwen3をホストしている欧米の企業を探せば、欧米のサーバー上のQwen3を使用することもできる。

とはいえ、各サービスのアカウントをいちいち作るのは面倒だ。そんな時に便利なのが、「OpenRouter」というAIサービスだ。

OpenRouterは、異なるプロバイダーが提供する多種多様な大規模言語モデルを、一箇所にまとめてAPI経由で利用できるAIサービスである。

「Qwen3 235B A22B」など呼び出したいモデルを指定すると、その瞬間に最も安く、最も安定しているプロバイダに自動でルーティングしてくれる。各クラウドサービスと別々の契約や支払いをする必要がなく、OpenRouter上でまとめて管理・決済できるので楽だ。

記事執筆現在(4月29日)、OpenRouterで「Qwen3 235B A22B」のプロバイダを確認すると、米国のクラウドコンピューティングサービスである「Deepinfra」や「Parasail」経由で利用できるようになっている。

DeepinfraやParasailは、プロンプトの履歴がトレーニングに使用されないことがプライバシーポリシーで保証されているので、アリババクラウド公式のWebアプリを利用するよりも安心感がある。

ただし有料なので、利用するにはOpenRouterのクレジットをチャージしておく必要がある。

一方、送信したプロンプトなどの情報がトレーニングに使用されても良いのであれば、Qwen3のすべてのモデルについて、無料で利用できる選択肢も存在する(例:Qwen3 235B A22B (free))。

自分の用途から考えて、セキュリティ・プライバシーを重視する場合は有料版を、そうでもない場合は無料版を利用すると良い。

OpenRouterの各モデルは、APIを利用してPythonプログラム内などで呼び出すことができるが、Web上でモデルページから「Chat」ボタンを押すと、チャットUIでのチャットも利用できる。

この方法であれば、プログラミングの知識がなくても、Qwen3を簡単に利用できるのでおすすめだ。

Ollamaを使ってMacBook AirでQwen3を動かす

MacなどPCのローカル環境でQwen3を使用したいのであれば、「Ollama」というツールを利用するのがおすすめだ。

Ollamaをインストールするだけで、Macであれば「ターミナル」アプリなどのコマンドラインツール上で、簡単なコマンドでQwen3やLlama 3.3、Deepseek R1などのオープンソースLLMを動かすことができるようになる。

ここでは、筆者のMacBook Airで利用した例を紹介するが、WIndowsやLinuxにも対応している。

Ollamaを公式サイトからダウンロードして開いたら、コマンドラインツールのインストールを求められるので、画面の指示に従ってインストールする。

Ollama公式サイトのモデル一覧から、利用したいモデルをプルダウンで選択すると、コマンドライン上で打ち込むべきコマンドが表示されるので、それをそのままコピペする。

今回は、非常に軽量なQwen3 1.7Bモデルを、Macに導入してみる。

ターミナルで、ollama run qwen3:1.7bというコマンドを打ち込むだけで、モデルがローカル環境にダウンロードされ、さらにそのままチャットを開始できる。

このサイズであれば、M3 MacBook Air (16GBメモリ) であっても、非常に高速で実用的なスピードで利用できる。

オフライン環境で動作するので、機密性の高い情報などにも適用できるのがメリットだ。さらにPCのメモリが大きければ、Qwen3-32Bなどの高性能なモデルも動かせるはずである。

総評:現状最高性能のオープンソースモデルの新標準

今回発表されたQwen3は、LLM界隈で世界中を席巻したDeepseek R1の衝撃にも匹敵する、目覚ましい性能を誇る中国発のオープンソースモデルだ。

Metaが4月上旬にリリースした「Llama 4」シリーズが、非推論モデルのみのリリースであったのに対して(参考:当サイトのレビュー記事)、「Qwen3」シリーズは全モデルが推論モードに対応したハイブリッドモデルとなっており、軽量ながら優れたアウトプットをしてくれる。

実際、各ベンチマーク結果に現れている通り、数学、コーディングなどの分野で非常に高い性能を示している。流行りのMCPなどのツール群の呼び出しにも最適化されており、Qwen3の公式リリースの中では、MCPを組み合わせて使用するデモまで示されている。

しかも、上位の大型モデルでは、MoEアーキテクチャを採用することで、必要な計算資源を抑えつつ、高速な推論が可能である。

計算負荷が低いが高性能ということで、中小企業や個人のローカル環境でも実用的なスピードで動作させることができる。

ただし、現状ではマルチモーダルには非対応で、画像や音声の読み込みには対応していない。

前世代のQwen2.5では、マルチモーダルに対応した「Qwen2.5-VL」や、音声のアウトプット(発話)まで可能な「Qwen2.5 Omni」などがリリースされていたので、Qwen3についてもマルチモーダル対応のモデルのリリースを待ちたい。