散々ニュースでも話題のOpenAIの最新AIモデルを使ってみたいけれど、ChatGPTの有料プランに月20ドルも課金するほどではない、という人が、筆者の周囲には結構いる。

サブスク契約をするのを躊躇して、現在もGPT-3.5など無料プランで利用できるモデルしか利用経験がなく、GPT-4などの最新モデルを使用したことがない人は、実は多いのではないか。

OpenAI社の最新・最上位モデルであるGPT-4や、Anthropic社の最新・最上位モデルであるClaude 3 Opusは、無料で使えるGPT-3.5などと比べると、全く別物と言っていいほど圧倒的に性能が高く、ビジネスシーン等でも実用的なので、ぜひ体験してもらいたいところだが、気軽に試せるオプションがないのが辛いところだ。

その点、GPT-4であっても、APIキーを使って簡単なプログラムを書けば、使った分だけの激安料金(およそ英文750単語の入力で1.5円/出力で4.5円)で、最新のAIモデルを利用する方法はある。

しかし、いかんせんAPIキーと言われると、プログラミングの知識がないと難しそう…と思う人が大半だろう。

そこで、無料で誰でも使えるGoogle Colabというサービスを使って、プログラミングの知識が全くなくても、OpenAIの最新AIモデルを試せるミニWebアプリを作成してみた。

言語モデルの代表格GPT-4、さらに画像の読み取りが可能なGPT-4 Vision、画像生成のDALL-E 3、音声書き起こしのWhisper、テイストから音声を合成するTTSモデルなど、OpenAIの全ての最新AIモデルをGoogle Colabに実装している。

本記事で全てのノートブックを公開しているので、それらのリンクを開くだけで、すぐに使うことができる。

AIに興味があるけどプログラミングはちょっと…という人も、この記事を読めば、OpenAIの最新のAIモデルを色々触って遊んでみることができる。

使い方をゼロから解説していくので、ぜひ参考にしてみてほしい。

Google Colab上でOpenAIのモデルを使う下準備

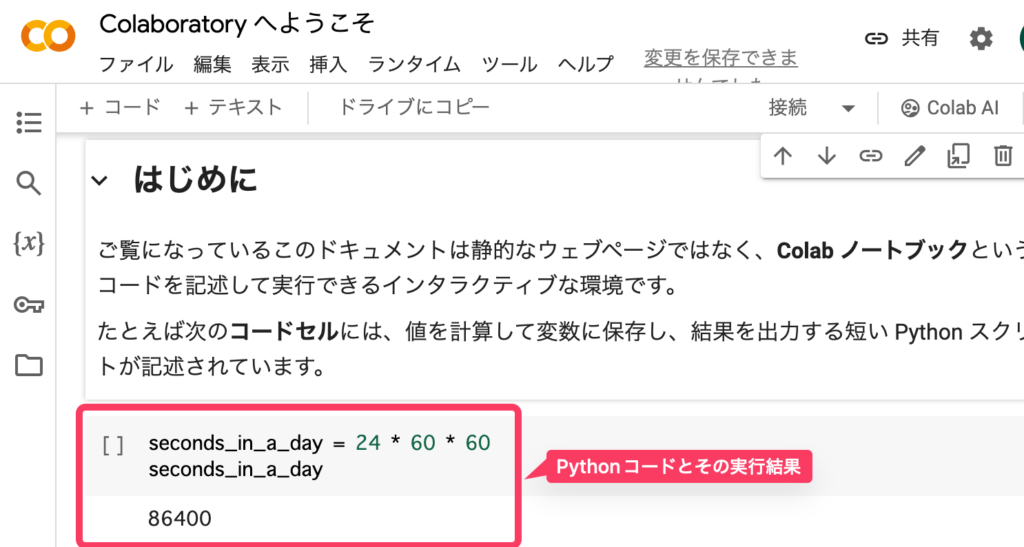

Google Colaboratoryは、Googleアカウントさえ持っていれば、誰でも無料で利用することができるPythonというプログラミング言語の動作環境である。

Google Colabでは、プログラムのコードと通常のテキストをまとめて一つの「ノートブック」として保存することができ、このノートブックをGoogleドライブ経由で共有すれば、他の人が作ったプログラムを自分のGoogleアカウント上で簡単に動かすことができる。

この記事では、OpenAIの各AIモデルをPythonを使って動かす「ノートブック」を用意してあるので、それをコピーするだけで簡単に使える、というわけだ。

しかし、一点だけ、OpenAIのモデルを呼び出すのは有料なので、あなた専用の「APIキー」を手元に準備しておく必要がある。APIキーとは、サービスを利用するための自分専用のパスワードのようなものだ。

OpenAIのサーバーに対して、GPT-4モデル等の回答をリクエストする際に、APIキーを添付することで、その利用料がAPIキーの持ち主に課金されるような仕組みになっている。

そこで、まず最初に、OpenAIのAPIキーを発行して、Google Colabに自分のAPIキーを登録する方法を説明する。

まずはOpenAIのAPIキーを入手する

OpenAIのAPIページを開き、アカウントを登録したことがない場合は登録をする。ChatGPTにログインしたことがあれば、そのアカウントをそのまま使うことができる。

ログインが完了すると、ChatGPTとAPIの管理画面のどちらを開くかを選択することになるので、今回は「API」を選択する。

そうすると、OpenAIのAPI関連の情報がまとまったページが表示されるので、左側のメニューから「API keys」を選択する。過去に発行したAPIキーが表示され、追加・削除などをすることができる。

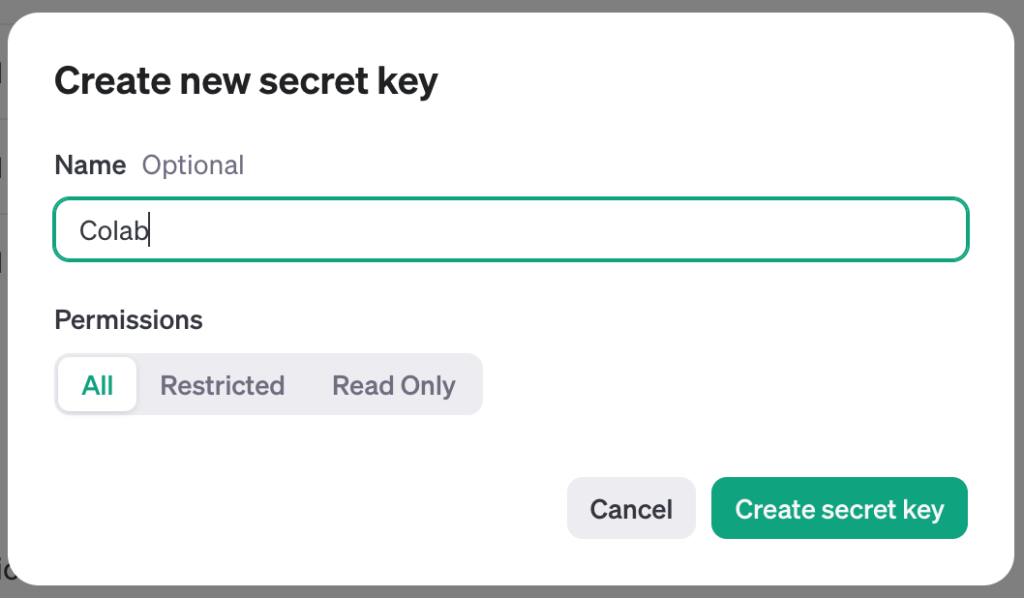

初めてAPIキーを発行する場合は、「Create new secret key」をクリックして、新規作成する。

今回はGoogle Colabで使うためのAPIキーを作成するので、「Colab」などと名前をつけて保存しておくと分かりやすいだろう。

APIキーを作成したら、1度だけ画面にキーが表示される。

このキーは、他の人に知られないように、大切に保管しなければならない。忘れてしまわないようにコピーして、すぐにGoogle Colabに登録する作業を行った方がいい。

作成したAPIキーをGoogle Colaboratoryに登録する

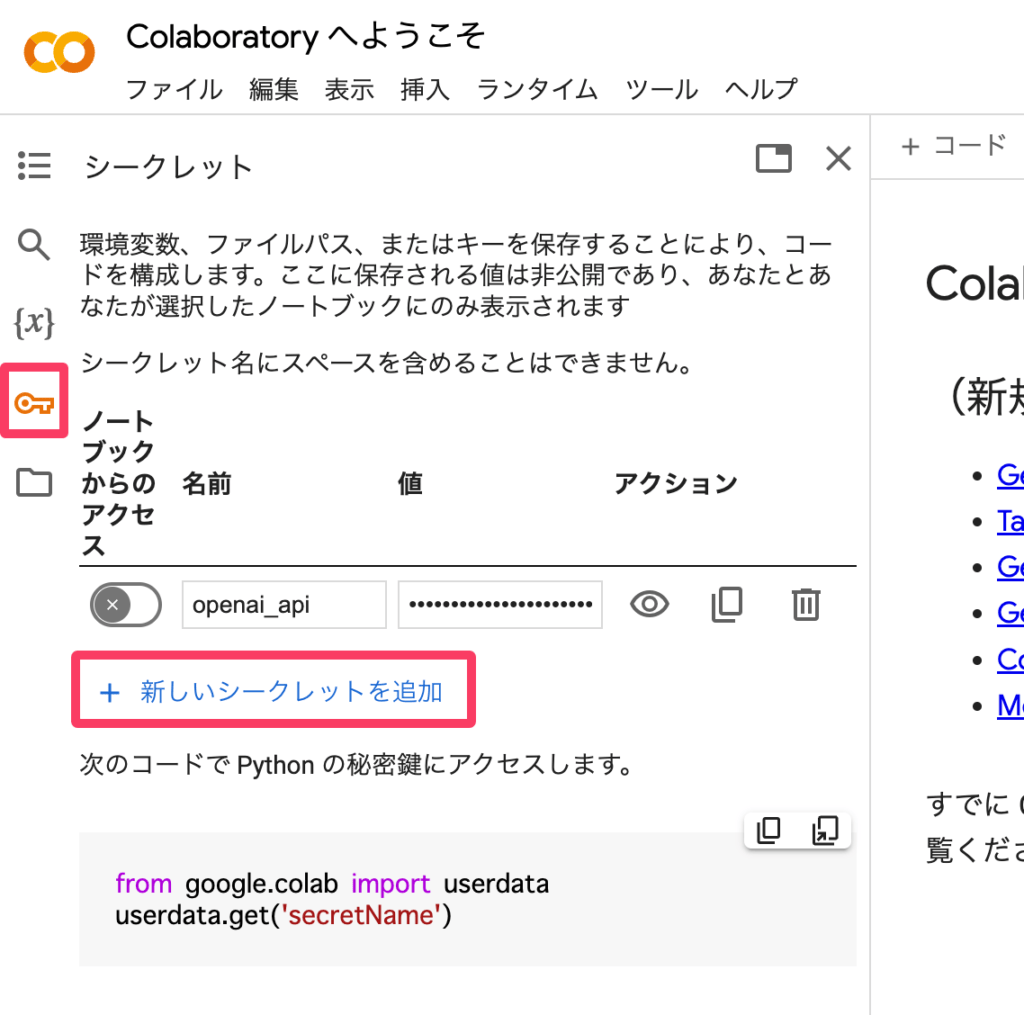

Google Colaboratoryを開いて、自分のGoogleアカウントにログインした状態で、左側のメニューの鍵のマークをクリックする。

すると、様々なサービスのAPIキーなどを登録しておくことのできる「シークレット」という機能が利用できる。「新しいシークレットを追加」して、先ほど作成したOpenAIのAPIキーを、「openai_api」という名前をつけて保存する。

一度登録しておけば、今後、Google Colabのノートブック内で、「openai_api」という変数を呼び出せば、すぐにAPIキーにアクセスできる状態になる。

APIの利用料金をチャージしておく

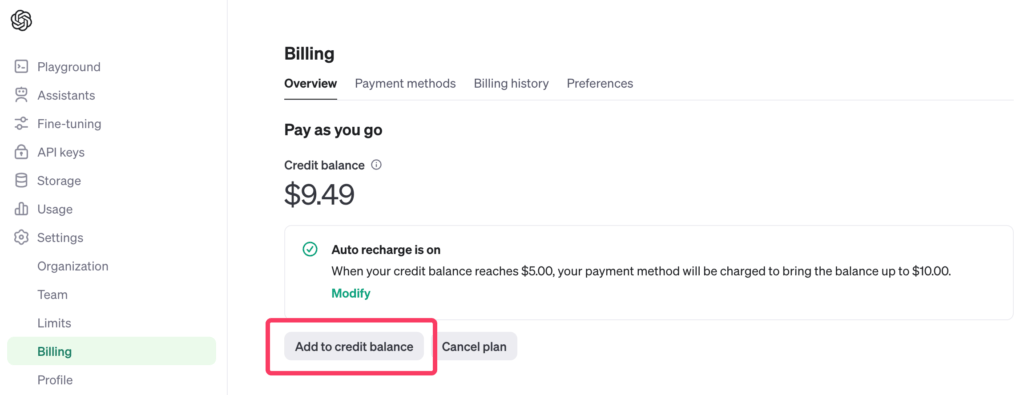

OpenAIのAPIの利用料金は、クレジットをチャージしておくプリペイド方式だ。

APIの管理画面で、「Settings」「Billing」と進んで、チャージ残高が表示されるので、「Add to credit balance」をクリックして、5ドルなり10ドルなり、クレジットカードで支払いを行なっておくとよい。

10ドルもあれば、十分この記事で紹介する色々なモデルを触って遊ぶことができるだろう。

ちなみに、メニューの「Limits」から、1ヶ月あたりの利用料金の上限や、メールでアラートを出す基準金額を設定することもできる。

例えば、ChatGPTの有料プランの金額である20ドルを絶対に越えたくないのであれば、Monthly Budgetを20ドルにセットしておくと良い。

API利用料金の目安を知っておく

2024年4月現在、OpenAIが提供する大規模言語モデルのうち、最上位モデルであるGPT-4 Turboの利用料金は、以下の通りだ。

- 入力トークン: 1,000トークンあたり$0.01 (約1.5円)

- 出力トークン: 1,000トークンあたり$0.03 (約4.5円)

1トークンは、AIモデルの料金表示によく使われる単位で、英単語でいうと約0.75単語に相当する。つまり、1,000トークンは、約750単語の英文ということになる。750単語の英文は、日本語だとざっくり450文字程度だ。

原稿用紙1枚(400字)の指示を出して、原稿用紙1枚の回答をもらった場合、5〜6円かかるようなイメージだ。

月額20ドルのChatGPTの有料プランは、日本円にして約3千円なので、APIを使った従量課金の方が、多くの人にとっては安価であると思われる。

APIキーは、利用しない月は料金が一切発生しないので、利用量にアップダウンがあるような場合にも、サブスクより効率的だろう。

最も高性能な大規模言語モデル:GPT-4 Turbo

チャット形式のUIで、AIとの会話をすることができるサービスである「ChatGPT」だが、裏側では、OpenAIが開発するGPT-3.5やGPT-4と呼ばれる大規模言語モデルが使われている。

APIで提供されているGPT-4モデルを利用すれば、ChatGPTの有料サブスクプランで利用できるのと全く同じモデルを、トークン数に基づく従量課金で利用できる。

記事執筆時点(2024年4月)で、最新かつ最も高性能なモデルは、4月9日に公開されたばかりのGPT-4 Turboの改善版である(gpt-4-turbo-2024-04-09)。

GPT-3.5など、ChatGPTの無料版でも使える旧モデルは、やはりGPT-4に比べると性能が劣り、アウトプットされる文章の質も全くレベルが違うので、せっかくAPIを使ってチャットを試すのならば、最新最強のGPT-4にしておくことをオススメする。

以下のGoogle Colabノートブックを開いて説明通りに実行すると、全くコーディングなどの知識がなくても、あなたのAPIキーを使って、簡単にGPT-4 Turboとのチャットをすることができる。

上記のノートブックを開いたら、画面上部のメニューから、「ランタイム」「すべてのセルを実行」をクリックする。

すると、ノートブック内のすべてのPythonコードセルが実行され、最下部にチャット用のテキストボックスが表示されるはずだ。

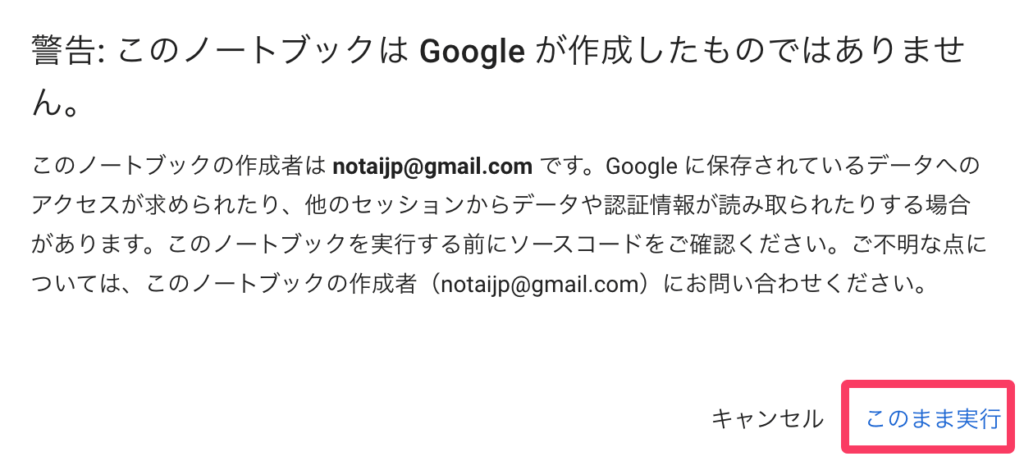

途中で、他人が作成したノートブックを実行していいかの確認が表示されるので、「このまま実行」をクリックする。

ノートブックには、チャット履歴をGoogleドライブにテキストファイルとして保存する機能をつけてあるため、Googleドライブにアクセスする許可を求めるメッセージも表示される。

「Googleドライブに接続」をクリックして、自分のGoogleドライブへの接続を許可しておくと、チャットした後の履歴を保存できる。

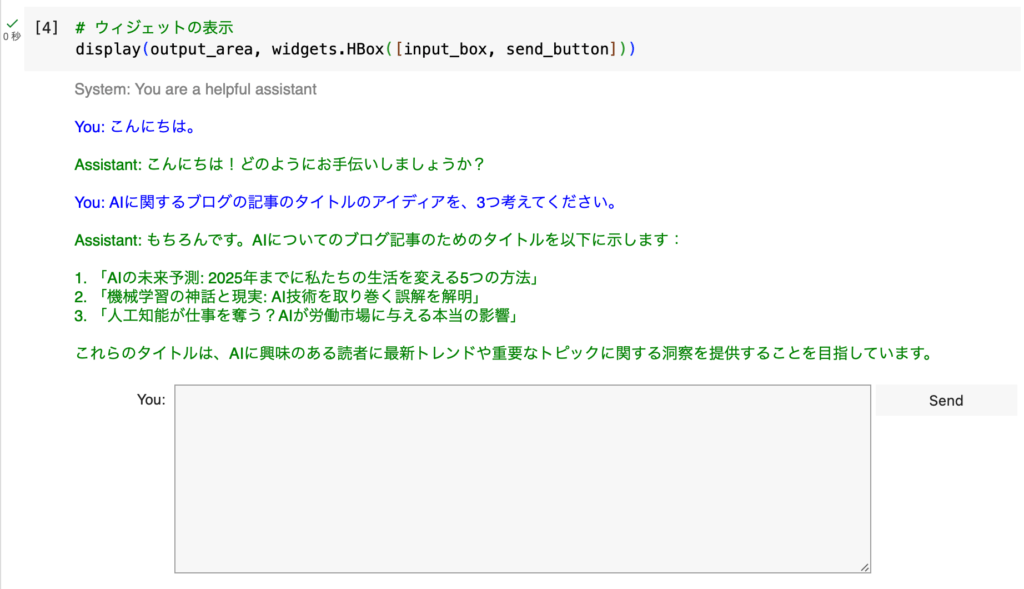

以上のメッセージを全て承諾していくと、以下のようなテキストボックスと、「Send」ボタンが表示されるはずだ。

このテキストボックス内に、ChatGPTなどと同じように、AIに聞きたいことを書いて、「Send」ボタンをクリックしてしばらく待っていると、GPT-4 Turboモデルによる回答が表示される。

自分の発言は青字で、AIからの回答は緑字で表示されるようになっている。

ChatGPTのような豪華なインターフェースではないが、Pythonでインタラクティブなウィジェットなどを表示できるipywidgetsというパッケージを使って、チャット感のある使い心地になるように実装してある。

なお、API経由でGPT-4を利用すると、入力した情報がトレーニングに使われず、プライバシーが守られるという大きな利点がある。

ビジネスユーザーなど、情報漏洩のリスクが心配な人は、無料のChatGPTやBing Chat、Copilotなどを使うのは言語道断だが、APIキーを使って、Google Colab上でGPT-4とのチャットを利用すれば、幾分安心感がある。

もちろん、個人情報や機密情報については、例えAPIと言えど気をつける必要があるが。

画像認識が可能な大規模言語モデル:GPT-4 Vision

4月9日に公開されたばかりのGPT-4 Turboの改善版(gpt-4-turbo-2024-04-09)は、そのまま画像のインプットにも対応している。

写真やスクリーンショットをアップロードして、その写真に何が写っているかを説明させたり、スクショ内の表を読み取らせてテキスト化させたりといったことが可能だ。

先ほどのGPT-4 Turboをチャット風のUIでGoogle Colab上に実装したノートブックをベースにして、画像のアップロードを可能にしたノートブックが以下のものである。

同じくノートブックの画面上部のメニューから、「ランタイム」「すべてのセルを実行」をクリックすると、最下部に、以下のようにテキストボックスと、今度は画像をアップロードするための「Upload」ボタンが表示されるはずだ。

テキストと画像の両方を扱えるマルチモーダルAIであり、画像をアップロードしなければ、単にGPT-4 Turboモデルと会話しているのと同じことだ。

筆者の個人的な使い方としては、ちょっとした画像やPDFから、必要なテキスト情報を抜き出すOCR的な使い方が多い。

例えば、PDF内にある表が上手くコピペできない時に、その表をスクリーンショットして、GPT-4 Visionに「この表をマークダウン形式のテーブルとして書き出せ」という指示をすると、結構正確にテーブルを出力してくれる。

もちろん書き起こされたテキストが正しいかどうかは人間によるダブルチェックが必要だが、ちょっとした面倒な作業を、たった数円で代行してくれる秘書的な存在として活用することができる。

イラスト・写真を生成可能な画像生成モデル:DALL-E 3

OpenAIが開発するDALL-E 3は、テキストから画像を生成するAIモデルだ。

ユーザーが言葉で表現したアイデアやコンセプトを、驚くほどクオリティの高い画像に変換することができる。

ビジネスのスライドで使われるようなベクターイラストやアイコンを生成することもできるし、Web広告で使うマーケティング画像を生成することもできるし、日本アニメ風の美少女の画像を生成することもできる。

DALL-E 3で作成した画像は、商用利用も含めてユーザーが自由に活用できることから、趣味からビジネスまで、幅広く役立つシーンがあるだろう。

以下のノートブックでは、テキストプロンプトを打ち込むと、AIが画像を生成してくれ、かつ生成された画像をダウンロードできるように、DALL-E 3を使いやすく実装している。

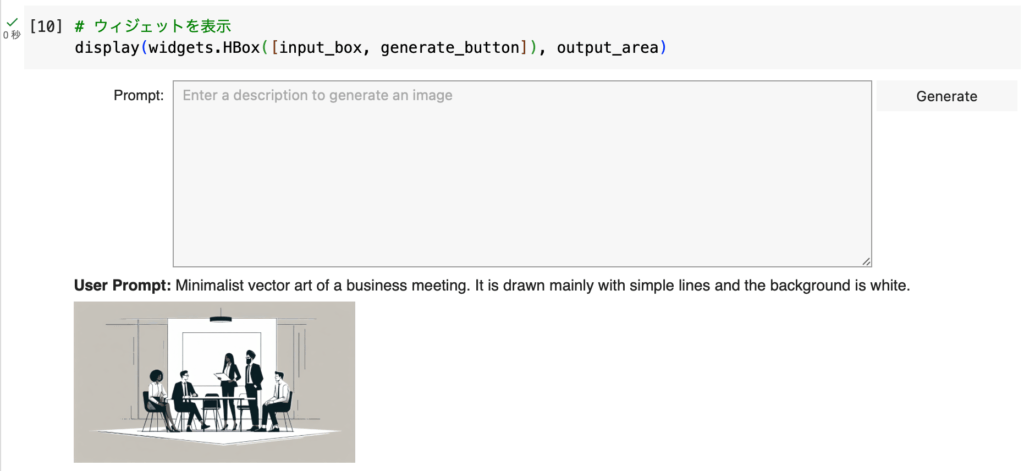

上述のGPT-4 Turboなどと同じように、「すべてのセルを実行」をクリックすると、最下部に以下のようなテキストボックスと、「Generate」ボタンが表示される。

テキストでどのような画像が欲しいかを書き込んで(日本語でも可能)、「Generate」ボタンをクリックするだけで、DALL-E 3がイメージに合う画像を生成してくれる。

当サイトのサムネイル画像も、基本的にすべてDALL-E 3で生成しており、試行錯誤しながらプロンプトをうまく設定すれば、特定のカラースキームやデザインテーマにあった画像を生成することもできる。

自分のイメージに合った画像が生成されるまで、プロンプト文を試行錯誤してみると良い。

音声認識(Speech-to-text)モデル:Whisper

OpenAIが開発する音声認識AIである「Whisper」は、音声を自動的にテキストに変換するモデルだ。

Whisperは、インターネット上から収集した68万時間におよぶ多言語の音声データを用いて学習されており、英語や日本語をはじめとする多くの言語の音声を、高い精度で文字起こしすることができる。

会社内での議事録の作成はもちろんのこと、YouTubeにアップする動画のテロップ付けに使えたり、苦手な英語の音声のディクテーションに使えたり、可能性は無限大だ。

筆者は、Macの音声入力機能を、ショートカットアプリを使ってWhisperとGPT-4を組み合わせて魔改造し、非常に正確に喋った内容を書き起こしてくれる機能を作ってみたりしている。

OpenAIは、Whisperのモデルとコードをオープンソースで公開しているため、APIを使わず、Google Colabノートブック上で直接Whisperモデルを動かすことも可能だ。

APIを経由して高速に書き起こしてもらうか、ゆっくりでも良いのでオープンソースモデルを使って書き起こすかは、用途次第といったところ。

ここでは、両方のノートブックを用意したので、それぞれ使い方を開設しておく。

API版Whisperで高速・シンプルな文字起こし

以下のノートブックでは、OpenAI公式のAPIで、Whisperモデルによる音声認識を利用できるようにしてある。

APIキーを使うので、音声の長さに応じて料金が発生するが、オープンソースモデルを使ってGoogle ColabのGPUで書き起こしを行う場合と比べると、圧倒的にサーバーの性能が良いので、高速で処理が完了するのが特徴だ。

APIの利用料金は、1分あたり0.006ドルなので、10分間の音声でおよそ9円だ。非常に安価なので、1時間の会議の書き起こしなども、手動でやるくらいなら50円ほど払ってWhisperにやらせた方が、圧倒的にコストパフォーマンスが高いだろう。

使い方は上述のGPT-4 Turboモデルなどと基本的に同じで、上から順にコードセルを実行していき(「すべてのセルを実行」でも同じこと)、音声ファイルの内容を補足するテキストを入力し、言語を選択したら、「Submit」ボタンを押すだけだ。

API版のWhisperでは、どのような内容に関する音声ファイルなのかを、プロンプトで補足してあげることで、書き起こしの精度が向上する。

例えば、iOSやiPhoneに関する会議音声を書き起こして欲しいのであれば、「この音声は、Appleの販売するiPhone向けのアプリ開発に関する会議を、録音した音声です。」などとプロンプトすると、主題・固有名詞を書いてあげることでAppleやiPhoneといった固有名詞の聞き取りの精度を向上させ、文体も句読点が適切に使われて出力される。

なお、書き起こし対象の音声ファイルは、Googleドライブ上にアップロードしておく必要がある。

デフォルトでは、Googleドライブのマイドライブ直下の「your_file.mp3」という音声ファイルを書き起こすようになっているので、書き起こしたい音声ファイルの名前を「your_file.mp3」に変更して保存しておく。

あるいは、ノートブック内で音声ファイルの場所を指定しているPythonコードを書き換えて、任意の場所にあるファイルを書き起こすこともできる。

その場合、以下のコードセルの「audio_file_path」の部分を、任意のフォルダ・ファイルに書き換える必要がある。

公開モデル版Whisperをダウンロードして無料文字起こし

先述の通り、OpenAIが公開しているWhisperモデルを使って、APIキーなしで、完全に無料でGoogle Colab上で音声認識を行うことも可能だ。

以下のGoogle Colabノートブックでは、公開モデルをGoogle Colabにインストールして、音声ファイルを文字起こしするコードを実装している。

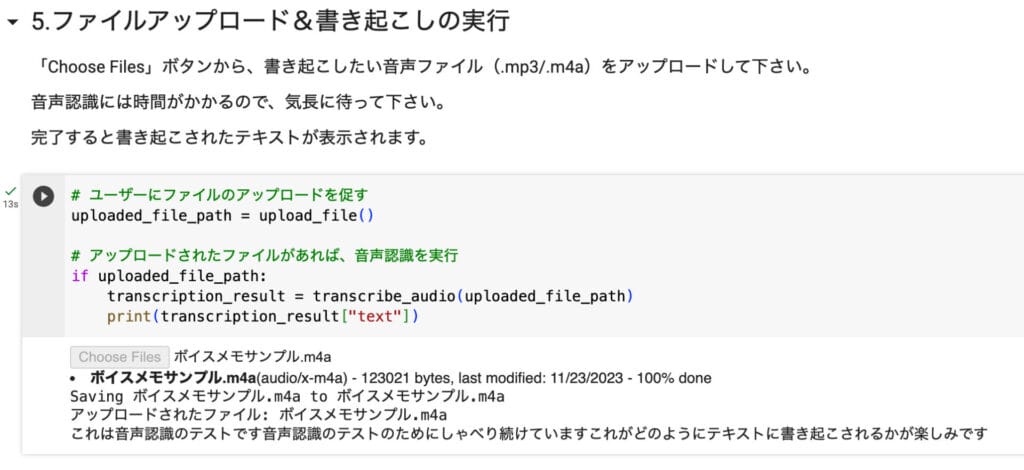

よりPythonコードを触らずに使えるよう、API版のノートブックと違い、ユーザーがボタンをクリックしてアップロードした音声ファイルを書き起こせるようになっている。

音声ファイルのアップロードが、Safariなどのブラウザではうまく動作しないので、このノートブックを使うときは、必ずGoogle Chromeを使う必要がある点には注意してほしい。

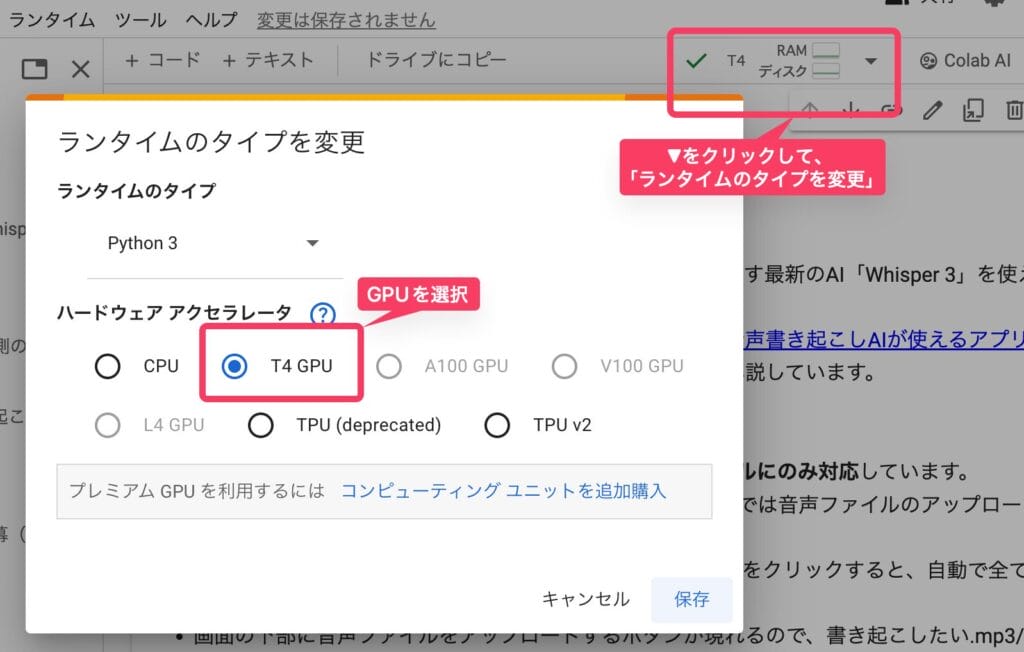

このノートブックを使う前の注意点として、Google Colabの動作環境を、GPUを利用したランタイムに変更する必要があることに注意してほしい。

ノートブックを開いて右上にある小さな三角形をクリックすると、「ランタイムのタイプを変更」というメニューが選択できるので、そこをクリックして、「ハードウェアアクセラレータ」で「T4 GPU」を選択する。

Whisperモデルによる書き起こしは、GPU上で行った方が圧倒的に高速であるためだ。

あとは、本記事で紹介してきた他のノートブックと同様に、上から順にコードセルを実行していくか、ランタイムメニューから「すべてのセルを実行」する。

すると、ノートブックの下部に書き起こしたい音声ファイルをアップロードするための「Choose Files」ボタンが現れるので、そのボタンから任意の音声ファイルをアップロードする。

1時間の音声だと20〜30分はかかる可能性があるので、音声ファイルをアップロードした後は、処理が完了するまで、気長に待ってみてほしい。

音声合成(Text-to-speech)モデル

OpenAIが開発するText-to-speech (TTS) モデルは、テキストを自然な音声に変換する最先端の技術だ。このモデルは、大量の多言語音声データを用いて学習されており、入力されたテキストを高い精度で読み上げることができる。

OpenAIのTTSモデルには、6種類の男女の声色が用意されており、ユーザーは用途に合わせて最適な声を選択することができる。

日本語のテキストにも対応しており、例えば日本のニュースのテキストなどを打ち込んでみると、自然な声で読み上げられる。

今のところ、日本語の音声は、完璧な日本人の発話には聞こえず、どうしても「日本語の上手い外国人」が喋っているような印象を受ける。

とはいえ、我慢できなくはない程度の訛りなので、記事の朗読や、アプリケーション内での音声出力など、幅広い用途に活用することができそうだ。

英語のテキストを読み上げさせる方が、より自然で完璧な音声が取得でき、実用的かもしれない。

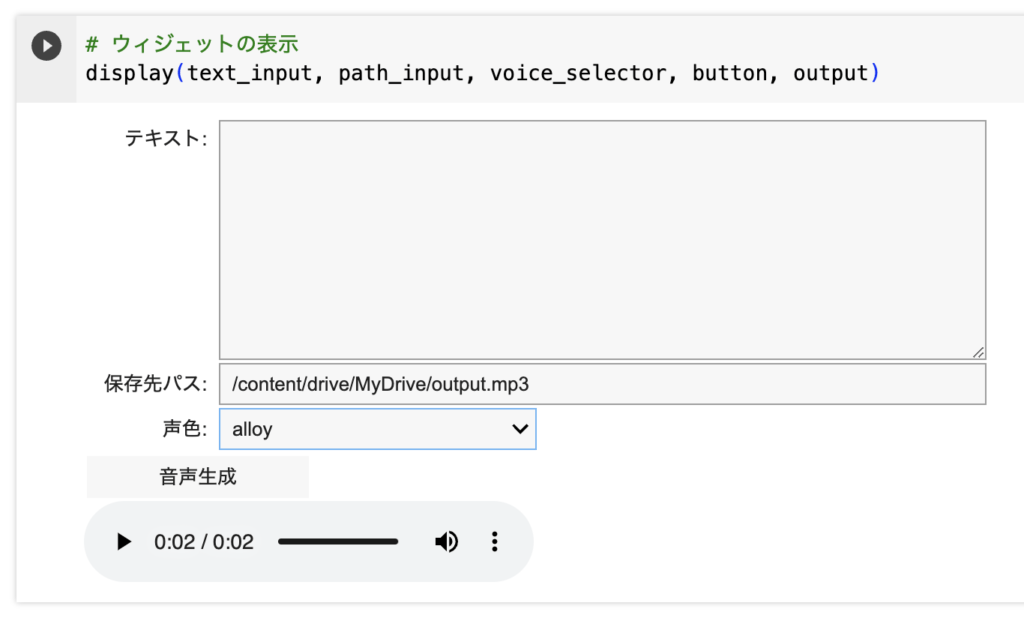

以下のGoogle Colabノートブックでは、テキストを入力し、6種類のボイスのどれを使うかをプルダウンリストで指定して、TTSモデルによって音声ファイルを生成・再生できる機能を実装している。

これまた、この記事の他のノートブックと同様に、上部メニューの「ランタイム」から「すべてのセルを実行」をクリックすることで、ノートブックの下部に以下のようなテキストボックスが表示される。

「テキスト」ボックスには、AIに読み上げてほしい原稿をテキストで書き込む。お試しという意味では、Yahooニュースの直近のニュースの段落をコピペしてみると、AIが日本語でニュースを読み上げてくれる。

TTSモデルによって生成された音声ファイルは、自動的にGoogleドライブにmp3ファイルとして保存されるようになっている。デフォルトでは、マイドライブ直下に「output.mp3」というファイルが保存される。

保存先を変更したい場合は、「保存先パス」のテキストボックスの中身を書き換えれば良い。

「声色」で、6種類のボイスプリセットから、希望の声を選択することができる。

これらの設定を終えたら、「音声生成」ボタンをクリックして少し待つと、再生ボタンが表示されるはずだ。

高速で進歩するAIの世界。ひとまず実際に使ってみよう

本記事では、OpenAIが提供している最新のAIモデル、GPT-4 Turbo、DALL-E 3、Whisper、TTSをGoogle Colabで実装し、プログラミングの知識がなくても簡単に使えるノートブックの使い方を解説した。

AIの技術は日進月歩で進化しており、ChatGPTやDALL-Eのように、私たちの生活やビジネスに大きなインパクトを与えるモデルが、目まぐるしく次々と登場している。

こうした最新のAIを、とりあえず触ってみて、どの程度自分の業務などに「使える」のかを把握しておくことは、AIを活用し生産性を上げるために、必要不可欠なことに思える。

例えば、GPT-4 Turboを活用することで、日々のメールや議事録などの文章作成の効率化が図れるし、Whisperは音声データの文字起こしやビデオへのテロップ付けの作業を圧倒的に高速化してくれる。

これらのAIモデルを使いこなすことで、全くAIを使ったことがない人と比べると、業務効率に大きな差が生じてくるように思える。

本記事で紹介したGoogle Colabのノートブックを活用すれば、プログラミングの知識がなくても、最新のAIモデルを手軽に試すことができる。

ノートブックに用意された手順に沿って進めるだけで、GPT-4 Turbo、DALL-E、Whisper、TTSをそれなりに使いこなせるようになるはずだ。

本記事が、最新のAIモデルに触れる機会となれば嬉しい。