2025年4月16日、OpenAIは新たな推論モデル 「o3」 と 「o4‑mini」 を公開した。

ChatGPTの非・推論モデルでのみ利用できた「ファイル解析」「検索機能」「Python実行環境」「画像生成機能」などの「ツール」を、複数組み合わせ自由に呼び出すことができるようになったのが大きな特徴だ。

これまで、ChatGPTでファイルを添付したり検索したりが必要な場合には、非・推論型の下級モデルを使わざるを得なかったが、今回のアップデートでようやく、超高性能の推論モデルで一連のツールを活用できるようになったのは嬉しい。

また、「o3」も「o4-mini」も、 コーディング、数学、科学など幅広い分野で、前世代モデルを大きく上回る性能を示しており、全体的に性能が向上している。

本記事では、「o3」と「o4-mini」モデルの特徴、ベンチマーク結果、ChatGPTで体験できる新機能を、実際の活用例とともに紹介していく。

o3, o4-mini の概要とベンチマーク

今回発表されたo3とo4-miniは、Web検索、データ分析(Python)、画像生成、視覚情報の深い理解といったツールを状況に応じて「自律的に使いこなす」能力を持つ。

しかも、検索→思考→検索→思考→Python環境利用→…といった形で、1回きりのツール使用で思考を止めずに、多段ステップで推論を進行していく。

OpenAIのライブ配信デモでは、o3 が、物理学のポスター画像を読み取り → Python で数値抽出 → 文献検索 → 結果を論文比較というステップを自律的に実行する様子が紹介された。

人間が途中に介在することなく、画像・テキスト・プログラムを縦断し、自律的に問題解決をする様は、まさに「AIエージェント」の未来に近づきつつある。「検索」などの機能を明示的にユーザーが指定しなくとも、勝手に必要に応じて実行してくれる。

モデル自体の性能だけでなく、ツール群のパワーが加わることで、ChatGPTに頼めることが大幅に広がった。

「o3」の概要:フラッグシップの推論SOTAモデル

o3は最先端の推論能力を追求したフラッグシップモデルであり、o4-miniは速度とコスト効率を重視しつつ高い性能を実現したモデルだ。

o3の主な特徴をごく簡単にまとめると次の通りだ。

- 史上最高の推論力:Codeforces や SWE‑bench、MMMU などで SOTA を達成。特に視覚入力(画像・図表)の理解とコードリポジトリのバグ修正の能力が高い。

- マルチモーダル対応:画像の理解、生成まで可能に。複数ツールを組み合わせ、Pythonを用いた画像の解析なども可能。

- 20万トークンの長コンテキスト:巨大コードベースや長い論文も一括で扱える。

- フルツールアクセス:検索、Python、ファイル解析、画像生成などのツールを、自律的に連続で呼び出し問題を解決する

- コスト効率の改善:o1 より安価で高速

o3は、Codeforces(競技プログラミング)、SWE-bench(実環境ソフトウェアエンジニアリング)、MMMU(マルチモーダル理解)などの難関ベンチマークで、現存するLLMの中で最も高性能なパフォーマンスを持つSOTA(State-of-the-Art)モデルとして君臨している。

マルチモーダル対応により、画像・グラフ・図表などの視覚情報を理解して、さらにそれ基づいてPythonを用いて計算する、なんてことも可能だ。

仮に画像が見えにくければ、Pythonで画像編集ツールを呼び出して、縮尺を変更したり回転したりするなど、人間さながらの言語+視覚を組み合わせた問題解決ができる。

「o4-mini」の概要:高速・低コストながら驚異的な性能

o4-miniは、o3よりも小型で、高速かつコスト効率に優れたモデルである。

miniと言いつつも、数学やコーディングなど一部のベンチマークで「o3」を超えるスコアを叩き出しており、分野によってはo4-miniを使った方が良い場合すらあり得そうだ。

- サイズと価格を抑えつつ推論力向上:一部の数学やコーディング分野のベンチマークで「o3」すら上回る最高成績

- マルチモーダル対応:o3と同じく画像の理解、生成、他のツールと組み合わせた解析が可能

- 利用上限が高く大量処理に最適:ChatGPTの無料枠でも提供、 API価格もo3-miniと同価格で安価(キャッシュあり時は更に値下げ)

o4-miniは、o3よりも大幅に高い利用制限(レートリミット)が設定されており、推論能力が求められるタスクを大量に、あるいは高頻度で処理する必要がある場合に最適な選択肢となる。

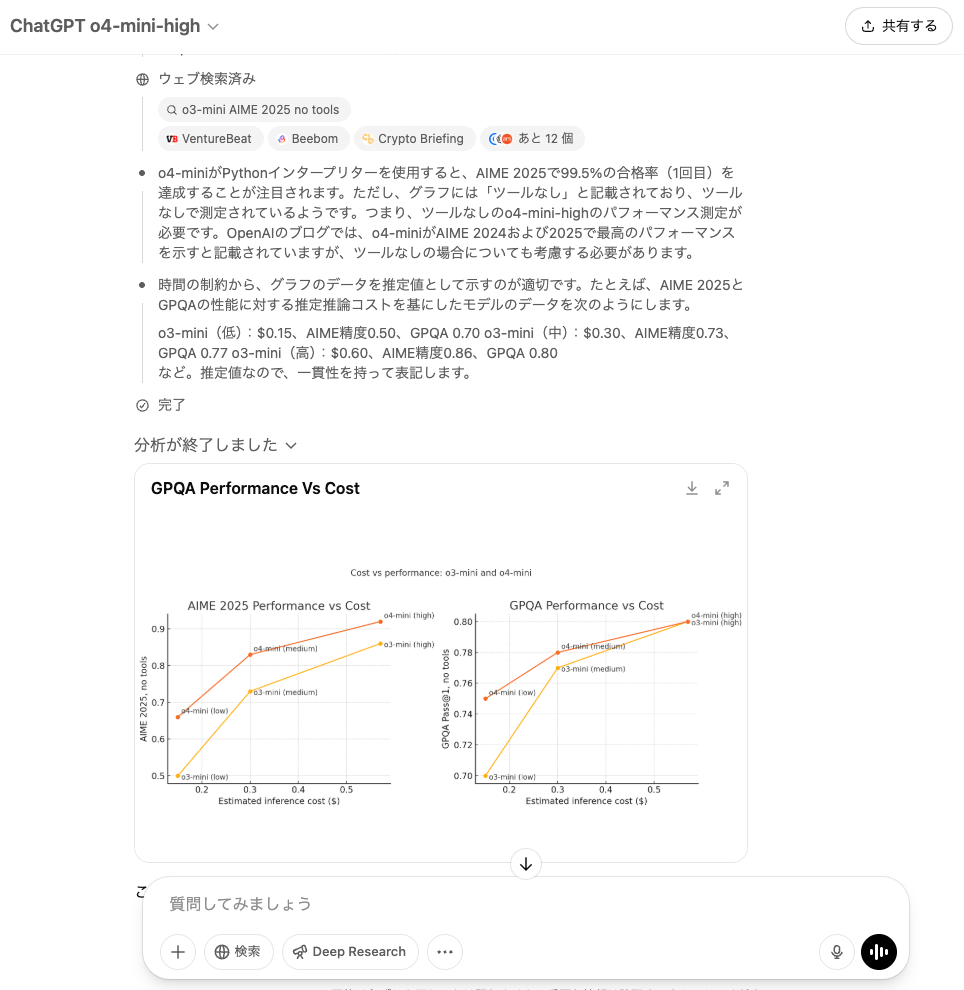

主要ベンチマーク結果:o3 と o4-mini の逆転現象も

OpenAIは、o3とo4-miniの性能を示すために、多数のベンチマーク結果を公開している。

ごく一部のみを引用するが、特に数学やコーディング分野でのo3, o4-miniの性能の向上は目覚ましい。また、o4-miniが、”mini”という名称にも関わらず、o1よりも大幅に性能が向上しており、o3すらも上回るスコアを持つ分野も見られる。

AIME 2025の米国数学オリンピック予選ではo1の79.2%を大きく引き離し、o3が88.9%、さらにはo4-miniがトップの92.7%を記録している。

また、o3, o4-miniの両方とも、Codeforces ELOレーティングで2700超(人間のトップ0.05%相当)、ソフトウェアエンジニアリングのベンチマークでもo1, o3-miniと比べ大幅に性能が向上しており、コーディング支援に大いに役立ちそうだ。

また、o3, o4-miniはマルチモーダルに対応し、画像の理解・思考ができるようになっている。視覚関係のベンチマークでも、o3もo4-miniも従来モデルを引き離すSOTA性能を示している。

なお、視覚関係のベンチマークスコアを見ると、当然o3がo4-miniより優れたスコアを出しているが、OpenAIの内部の人物のHackernewsでの投稿によれば、画像の解析性能はo4-miniの方が実は優れている、なんて情報もある。

ベンチマーク(の結果)にもかかわらず、実は4-miniはo3よりもかなり優れた視覚モデルです。これは、o3-mini-highがo1よりもはるかに優れたコーディングモデルであったのと同様です。視覚(画像認識)に関わるあらゆるタスクにおいて、o3よりもo4-mini-highの使用を推奨します。

ChatGPT, APIでのアクセス方法

o3, o4-miniは、早速ChatGPTやAPIで利用可能になっている。

- ChatGPT:

- Plus, Pro, Teamユーザー: モデルセレクターにo3, o4-mini, o4-mini-highが登場している。

- Freeユーザー: メッセージ送信前に「Think」オプションを選択することで、o4-miniを試すことができる。

- o3-pro: 数週間以内にツール完全サポート付きで、Proユーザー向けにリリース予定

- API:

- o3とo4-miniは、Chat Completions APIおよびResponses APIで提供

- Responses APIでのツール利用機能も、近日中に追加される予定

ChatGPTの場合、画面左上のモデルセレクターを開くと、すでにo3, o4-mini, o4-mini-highが登場しているはずだ。

APIでも、すでに両モデルともロールアウトされ、利用可能になっている。

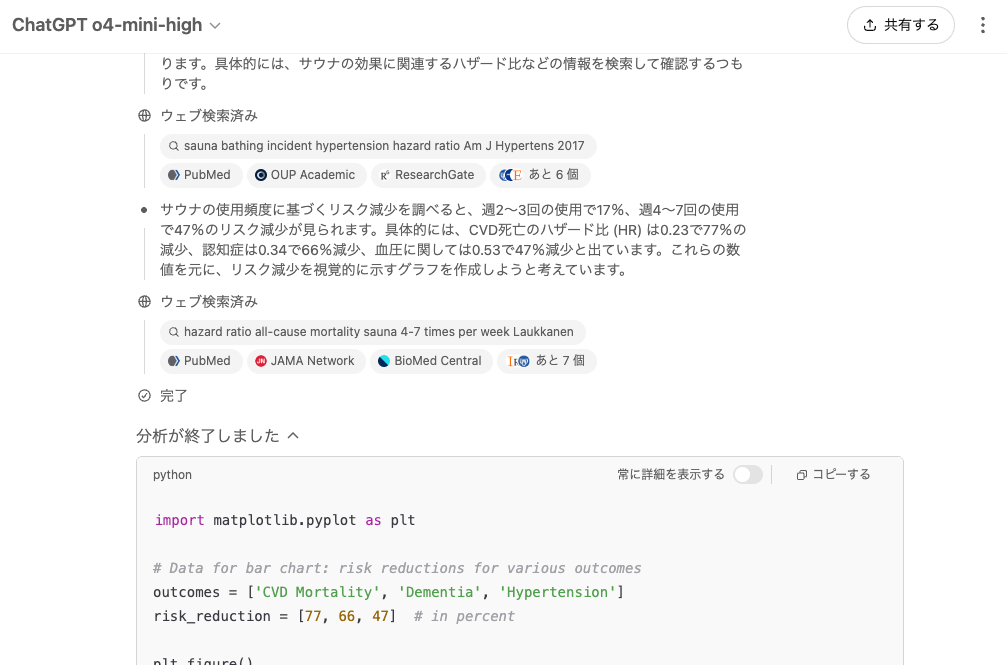

ただし、APIではこれまでの課金額によってTierが決定するが、記事執筆現在、Tier 1〜3の場合には、「Organization Verification」を行わなければ「o3」にアクセスすることができない。

これは、写真付き身分証明証を用いてアカウント認証を行うプロセスで、APIプラットフォームにログインして、設定メニューの「General」から「Verifications」を行う必要がある。

エージェント的なツール利用がすごい

今回のアップデートの最大の特徴は、モデルが自らの判断でChatGPT内のツール(Web検索、Pythonによるデータ分析、画像生成、ファイル分析など)を組み合わせて使用できるようになった点である。

例えば、「カリフォルニアの今夏のエネルギー使用量は昨年と比較してどうなるか?」という質問に対し、モデルは以下のような一連の行動を自律的に実行できる可能性がある。

- Web検索で公共事業のデータを検索する。

- Pythonコードを書き、データを分析して予測モデルを構築する。

- 結果を視覚化するためにグラフや画像を生成する。

- 予測の背後にある主要因を説明する。

途中で情報が不足していると判断すれば、再度Web検索を行うなど、状況に応じて戦略的にツールを使い分ける。

これにより、モデル自身の知識だけでは答えられない、リアルタイム情報や複合的な分析が必要なタスクに対応できるようになった。

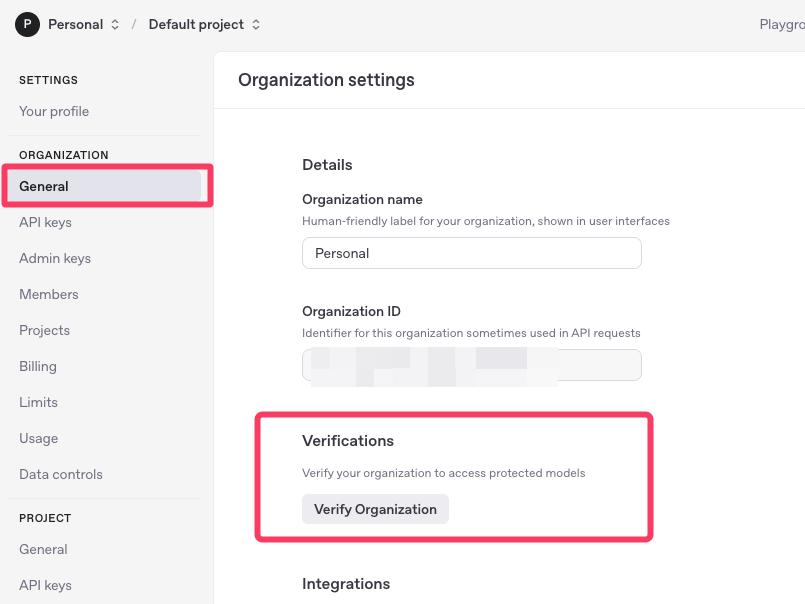

例えば、数値が載っていない棒グラフをアップロードして、Pythonのグラフで再現して欲しいと頼んでみると、グラフから情報を読み取って、関連するキーワードでWeb検索を何度も行い、数値データを探索して、Pythonコードに落とし込んでくれた。

一度のツール呼び出しで終わらず、多段ステップで勝手に行動してくれる様は、部下に指示をして作業をしてもらうようなもので、エージェントの世界に一歩近づいた。

Codex CLI:ターミナルで使えるコーディングエージェントも登場

o3, o4-mini自体とは別に、「Codex CLI」というツールも同時に発表された。

オープンソースでGithub上で公開されており、OpenAIのAPIキーを用いて、MacやWindowsのターミナル上で自律的に動くコーディングエージェントが利用できる。

ユーザーは、コマンドラインから自然言語で指示を与え、スクリーンショットや簡単なスケッチといったマルチモーダルな情報を入力として渡し、「このアプリを作って」「このサイトにダークモードを実装して」などという指示ができる。

Codex CLIが、ユーザーの指示に基づいて、ローカルのコードベースにアクセスし、サンドボックス環境内でコマンド実行・コード編集などを行なってくれる。

o3やo4-miniといった最新モデルの推論能力を、ローカル環境で最大限に活用することができるツールだ。

o3 と o4-mini のコーディング力を試す

最近ではAIモデルの性能があまりにも高度化しているため、単純なプロンプトでは、その真の実力を見極めることが難しくなっている。

最も効果的な評価方法は、自分の実際のワークフロー内にo3やo4-miniを組み込み、これまでのモデルでは解決できなかった問題が解決できるかどうかを確認することだ。

ただ、せっかくなので、o3とo4-miniのコーディング能力の片鱗を確認するために、シンプルなプロンプトで両モデルの性能比較を行ってみよう。

両モデルに与えたプロンプトは、以下のものだ。

車を運転する猫のSVG画像を書き出してください。SVG画像とは、XMLベースのマークアップ言語を使って、グラフィックスを文字で記述するファイル形式だ。通常の画像と異なり、テキストエディタで作成・編集できるという特徴がある。

「車に乗る猫」という現実にはあり得ない組み合わせを、テキストベースの推論能力と想像力のみで、どこまで正確かつ創造的に表現できるかを評価するためのプロンプトである。

以下がo3が描いたイラストだ。

次に、o4-miniのthinking effort = highで描いたイラストが以下である。

比較対象として、GPT-4oが描いたイラストが以下である。