2026年2月12日、OpenAIがAIコーディングエージェント「Codex」を超高速化したGPT-5.3-Codex-Sparkをリリースした。

なんと毎秒1,000トークン以上を生成することができる超高速コーディングモデルである。

速さと引き換えに、精度は落ちるものの、Codexを使ったコーディング体験を大きく変えうる新モデルだ。

AIコーディングエージェントを使っていて、最もストレスを感じる瞬間は、「指示を出してから結果が返ってくるまでの待ち時間」だ。

ちょっとしたUIの修正を頼んだだけなのに数分待たされ、その間に集中力が途切れ、結局タスクを完了するのに時間がかかってしまう、という経験のある人は少なくないはずだ。

この記事では、Codex-Sparkの概要から使い方、既存のGPT-5.3-Codexとの使い分け、そしてその裏側にあるハードウェアの話まで、開発者として知っておくべきポイントを整理する。

15倍速!?モデル自体の小型化で速さを稼いだ専用モデル

従来のGPT-5.3-Codexが、毎秒約70トークンで動作するのに対し、Sparkは毎秒1,000トークン以上となっている。

ただし、注意が必要な点として、GPT-5.3-Codex-Sparkは、GPT-5.3-Codexを高速化したものではない。

OpenAI公式は、「a smaller version of GPT-5.3-Codex」と明言している。従って、オリジナルのGPT-5.3より、モデルサイズ自体を小さくすることによって速度を稼いでいる。

とはいえ、モデルサイズだけでなく、ハードウェア面でも改善が行われている。この速度を実現しているのは、NVIDIA GPUではなくCerebrasのWafer Scale Engine 3(WSE-3)という専用チップだ。

OpenAIが本番モデルをNVIDIA以外のハードウェアで提供するのは、これが初めてとなる。

ベンチマークで見る「速度と精度」のトレードオフ

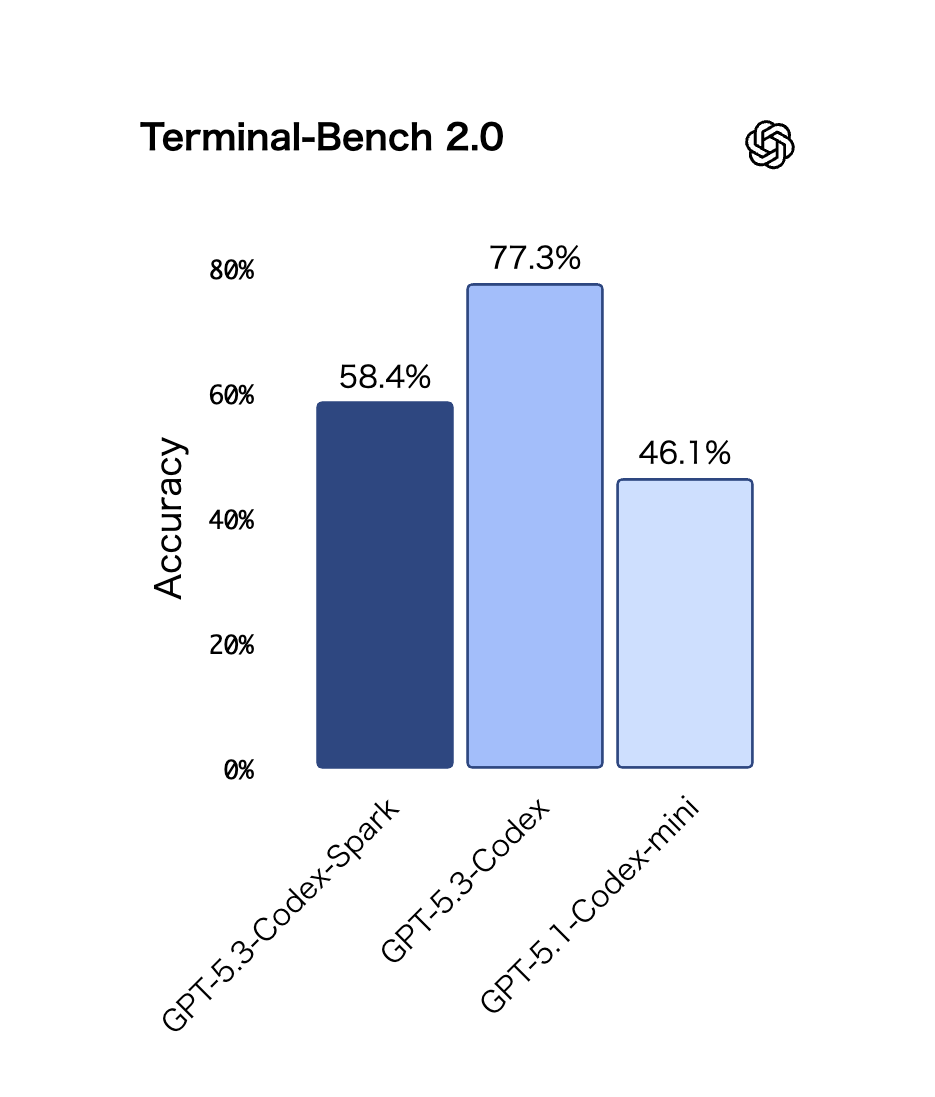

速さの代償として、精度はGPT-5.3-Codexより明確に劣る。OpenAIが公開しているエージェント型ソフトウェアエンジニアリングベンチマーク2種の結果を見てみよう。

| ベンチマーク | GPT-5.3-Codex-Spark | GPT-5.3-Codex | GPT-5.1-Codex-mini |

|---|---|---|---|

| Terminal-Bench 2.0 | 58.4% | 77.3% | 46.1% |

| SWE-Bench Pro | 約46〜52%(1〜3分で完了) | 56.8%(3〜17分で完了) | — |

Terminal-Bench 2.0では約19ポイントの差がある。一方で、旧世代のGPT-5.1-Codex-miniよりは12ポイント以上高く、小型モデルとしては健闘している。

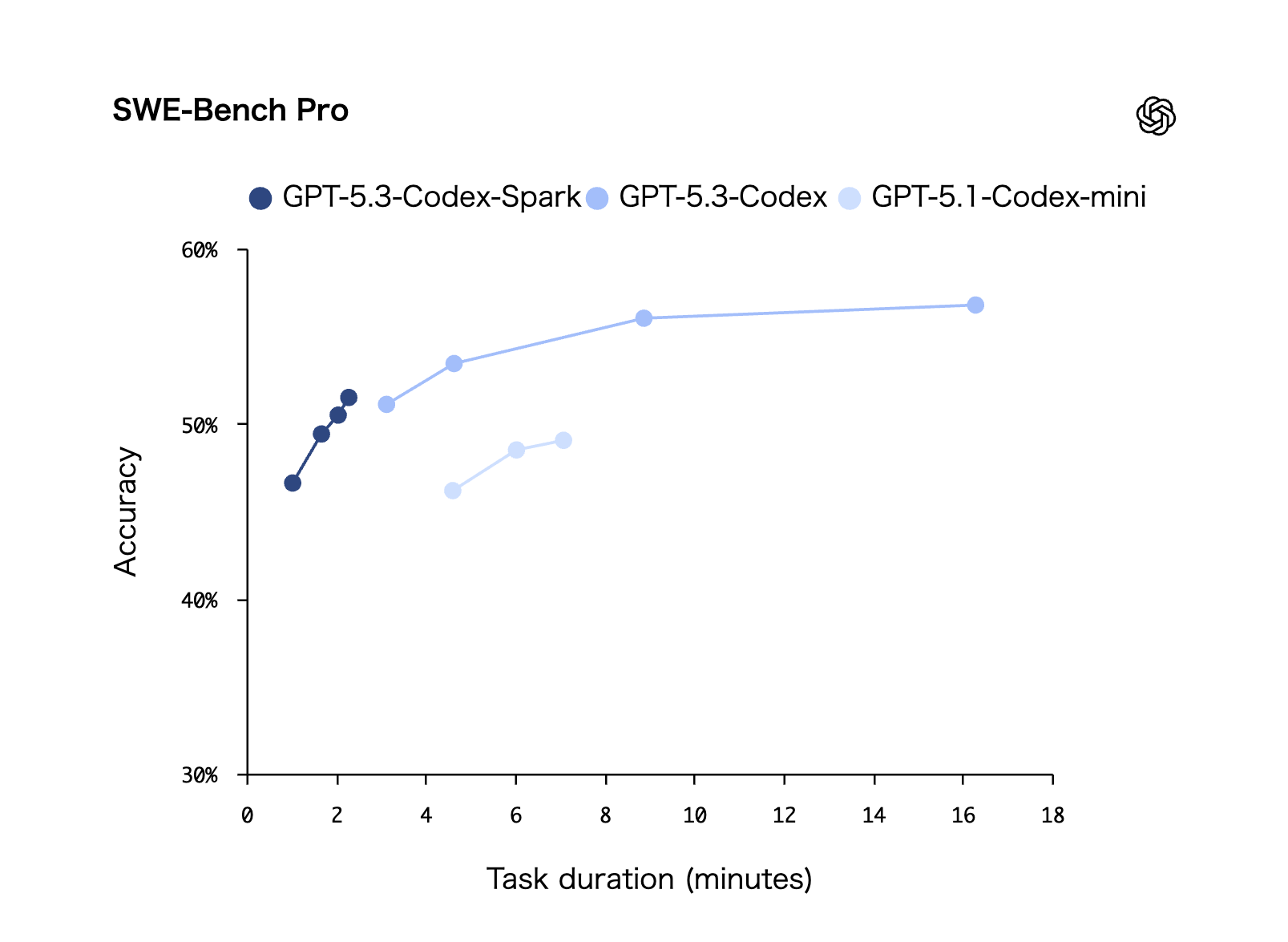

SWE-Bench Proについては、OpenAI公式は具体的な数値をテキストで公開していない。公式ブログに掲載されたチャートを読み取ると、Sparkは約46〜52%の精度で1〜3分、GPT-5.3-Codexは約51〜57%で3〜17分という分布になっている。精度差は5〜10ポイント程度だが、完了時間は3〜6倍速い。

つまり、単純なスコアだけを見れば精度は確実に落ちるが、時間あたりの成果という軸で見ると評価が変わる。

同じ時間で3回Sparkを回せるなら、1回のCodexより多くの問題を解決できる可能性がある。

一方で、Sparkがいくら早くても、複雑な問題に対して見当違いの方向に高速で突き進み、後から全て無駄になる恐れもある。

GPT-5.3-Codexで仮に3分かかったとしても、一発で正しいアプローチを見つけてもらった方が結果としてタスクの完了が早い、というのも現実だ。

速度が速いモデルをうまく活用できるかどうかは、ユーザーのタスク難度の判断スキルも重要となる。

Claude Code Fast Modeとのアプローチの違い

先週リリースされたAnthropicの[[Claude CodeのFastモード解説:2.5倍速のOpus 4.6を使いこなす方法|Claude Code Fast Mode]]と比較すると、両者のアプローチの違いが鮮明になる。

| 特性 | GPT-5.3-Codex-Spark | Claude Code Fast Mode |

|---|---|---|

| 高速化の手法 | 小さい専用モデル + 専用チップ | 同一モデル + インフラ最適化 |

| 速度向上倍率 | 約15倍(vs GPT-5.3-Codex) | 約2.5倍(vs 通常Opus 4.6) |

| 品質への影響 | あり(精度低下) | なし(同一モデル) |

| 追加コスト | Proプラン($200/月)に含まれる | 通常の6倍(Extra Usage扱い) |

| ハードウェア | Cerebras WSE-3 | Anthropic推論インフラ |

Claude Code Fast Modeは「同じモデルをインフラ変更で速くする」アプローチで、品質を一切犠牲にしない代わりに速度向上は2.5倍にとどまる。

また、月額サブスクプランに追加で、非常に高額なAPI利用料がかかってしまう。

一方、Codex-Sparkは「モデル自体を小さくして専用チップで動かす」アプローチで、速度は桁違いだが精度は落ちる。

品質維持を重視するならClaude Code Fast Mode、速度最優先で高速イテレーションしたいならCodex-Sparkという棲み分けだ。

開発者コミュニティの評価:Codex-Sparkの使い所は難しい

Hacker Newsのスレッドでは、Sparkの実用性について活発な議論が交わされている。

筆者が注目した論点を整理する。

- AGENTS.mdへの準拠度が低い:GPT-5.3-CodexやClaude Code Opus 4.6などの高性能なモデルはプロジェクトのAGENTS.md / CLAUDE.mdに記載されたルールによく従ってくれるが、Sparkでは追加のプロンプトを明示的に与えないと指示を拾えないケースが度々ある

- コンテキスト効率の問題:Sparkはコンテキストの扱いが粗く、頻繁にコンパクション(古いコンテキストの圧縮・切り捨て)が発生するとの報告がある。長い対話を重ねるタスクでは、途中で文脈が失われるリスクがある

- 中程度のタスクでも不安定:比較的簡単なタスクでも結果がぶれるという声があり、モデルの小型化に伴う限界が見える

- 「Sparkで高速イテレーション → GPT-5.3-Codexで仕上げ」の二段階ワークフロー:複数のユーザーがこのパターンを実践しており、速いモデルで方向性を探り、精度の高いモデルでクリーンアップするという使い分けに可能性がありそう

対話的な作業には低レイテンシのモデル、自律的な長時間タスクには深い推論を持つモデル、という棲み分けは、現実的な運用として定着しそうだ。

ちなみに、モデル間の速度の違いを具体的に理解するために、HNユーザーが独自に実施した速度ベンチマークも紹介する(Bluey Benchという独自ベンチマークテスト)。

これによると、Spark(low effort)が20秒でタスクを完了したのに対し、GPT-5.3-CodexやClaude Code Opus 4.6では1分以上かかった。

一方、Sparkの推論設定をxhighまで上げると1分09秒となり、GPT-5.3-Codex(low)の1分04秒とほぼ変わらなくなったという。推論の深さを上げるほど速度の優位性は薄れていく。

Codex-Sparkの使い方:今はChatGPT Pro限定

現時点での利用条件は以下のとおりだ。

- 対象プラン: ChatGPT Pro($200/月)のみ

- 利用環境: Codex app、Codex CLI、VS Code拡張

- ステータス: Research Preview

- API: ローンチ時は利用不可(一部のデザインパートナーにのみ提供)

Codex-Sparkの利用にはChatGPT Proプラン($200/月)への加入が必要だ。Plus($20/月)やBusinessプランでは利用できない。また、API経由での利用はローンチ時点では一般公開されていない。

GPT-5.3-Codex-Sparkを有効にする方法

起動時にモデルを指定する場合は以下のコマンドを使う。

codex --model gpt-5.3-codex-sparkすでにセッションを開始している場合は、/model コマンドでモデルを切り替えられる。

Codex CLI起動後や、IDE内のCodexで使用する場合、Composerのモデルセレクターから「GPT-5.3-Codex-Spark」を選択するだけだ。

表示されない場合は、アプリや拡張機能を最新バージョンにアップデートする必要がある。

Codex-Sparkの使用量は、通常のCodexレート制限にはカウントされない。専用ハードウェアで動作するため、別枠のレート制限が適用される。

全モデルに恩恵があるインフラ改善

Codex-Sparkの開発過程で、OpenAIはリクエスト-レスポンスパイプライン全体の最適化も同時に実施したという。

公式ブログによれば、これらの改善はSpark以外のモデルにも適用される。

- クライアント/サーバー間のラウンドトリップオーバーヘッド: 80%削減

- トークンあたりのオーバーヘッド: 30%削減

- Time-to-First-Token(TTFT、最初のトークンが出るまでの時間): 50%削減

- 永続WebSocket接続の導入: Codex-Sparkではデフォルト有効。今後全モデルに拡大予定

特にWebSocket接続の導入は注目に値する。従来のHTTPリクエスト-レスポンス方式と比べ、接続の維持と再利用によりオーバーヘッドが大幅に減る。

OpenAIはResponses APIのWebSocketパスを近日中にGA(一般公開)する予定としている。

これらの改善は全モデルに適用されるため、ChatGPT ProではなくPlusプランのユーザーも、GPT-5.3-Codexをはじめとする既存モデルのレスポンス改善の恩恵を受けられるものと思われる。

Sparkを使わなくても、Codex全体が速くなるのだ。

Cerebrasチップと「脱NVIDIA」の文脈

Codex-Sparkの速度を支えるのは、NVIDIA GPUではなくCerebras社の専用チップ「WSE-3」だ。OpenAIが本番モデルをNVIDIA以外のハードウェアで提供するのは、これが初めてとなる。

なぜGPUではないのか。現在のAI推論のボトルネックは、計算能力よりもメモリ帯域幅にある。GPUはデータをチップ外部のメモリから読み書きする必要があり、そこが速度の足かせになるのだ。

WSE-3は、チップ内部に大容量メモリを搭載し、NVIDIAの最上位GPU(Blackwell B200)の約20倍のトランジスタ数を持つ巨大チップで、このボトルネックを正面から解消している。

この背景には、OpenAIのNVIDIA依存脱却という大きな戦略がある。2025年にはAMDとの大型契約、Amazonとの380億ドルのクラウド契約を締結し、TSMCへの委託による独自チップ設計も進めている。

2026年1月に発表されたCerebrasとの100億ドル超の複数年契約もこの一環だ。契約からわずか4週間でCodex-Sparkという最初の成果物が出てきたスピード感は注目に値する。

GPUベンダーの独占体制が崩れるかは今後の展開次第だが、最大手が実際にNVIDIA以外で本番モデルを提供し始めたことは、業界全体にとって意味のある一歩だ。

速度と精度のトレードオフをうまく使いこなそう

GPT-5.3-Codex-Sparkは、「精度を多少犠牲にしてでも、圧倒的な速度でコーディングを回したい」という開発者のための選択肢だ。

現時点で利用するには、ChatGPT Proプラン($200/月)に加入していることが必要だ。

また、仮に利用できるとしても、使い所は速度重視でも問題のない軽量タスク(プロトタイピング、UI調整、スタイル修正など)が中心となる。

大規模で複雑な自律タスクが中心の場合、今まで通りGPT-5.3-Codexのほうが適任だ。

Research Previewの段階であり、機能・レート制限・利用範囲はすべて変更される可能性がある。

OpenAIは今後、より大きなモデルの追加、コンテキストウィンドウの拡大、マルチモーダル入力への対応を予告している。

精度は劣るとはいえ、毎秒1,000トークンの世界を一度体験すると、従来の速度には戻れなくなるかもしれない。Proプランユーザーであれば、まず試してみてほしい。