2025年3月20日、OpenAIが、新たな音声モデル3種類を発表した。

画期的なのは、「何を話すか」だけでなく「どのように話すか」までコントロール可能なテキスト読み上げ(Text-to-Speech)モデルの登場だ。感情表現や抑揚など、人間のようなリアルな発話をしてくれるので、カスタマーサポートなどで音声AIが普及する日も近そうだ。

また、今回リリースされた音声認識(Speech-to-Text)モデルも、従来モデル「Whisper」の精度・性能を大きく上回るという。

今回の発表の要点は以下の通りである。

- 新しい音声認識(Speech-to-Text)モデル

- GPT-4o Transcribe

- GPT-4o mini Transcribe

- 新しいテキスト読み上げ(Text-to-Speech)モデル

- GPT-4o mini TTS

- Agent SDKの大幅アップデート

- 既存のテキストエージェントを音声エージェントに変換するためのサポート機能を追加

マルチモーダル対応のGPT-4oモデルが、音声ファイルの読み込みに対応し、さらにGPT-4o自身がテキストの読み上げにまで対応しまう、というアップデートだ。

本記事では、各モデルの概要をまとめるとともに、各モデルを使った文字起こしや、音声読み上げを、実際に試す方法も紹介する。

Googleドライブ上で、手軽にGPT-4oによる文字起こしを試せるColabノートブックも用意したので、ぜひ活用してほしい。

音声認識(Speech-to-Text)モデルの詳細

音声認識モデルとしては、gpt-4o-transcribeと、それを蒸留した小型軽量モデルのgpt-4o-mini-transcribeの2種類のモデルが登場した。

これらは、テキストだけでなく音声、動画、画像などマルチモーダルに対応した「GPT-4o」をベースにした最新の音声認識モデルである。

従来は、文字起こしといえば、音声ファイルの読み込みのみに対応した「Whisper」モデルが定番だったが、ついに世代交代が始まることになる。

gpt-4o-mini-transcribeは、gpt-4o-transcribeの小型化・効率化バージョンであり、より高速で低コストでの運用が可能となっている。

Whisperと比べてあらゆる言語の聞き取り精度が向上しており、日本語でのWord Error Rate(単語エラー率)を表にまとめると以下のようになる。小型軽量のgpt-4o-mini-transcribeですら、Whisperのv3よりも優れた性能を有している。

| モデル | Word Error Rate |

|---|---|

| gpt-4o-transcribe | 3.06% |

| gpt-4o-mini-transcribe | 4.05% |

| whisper-large-v3 | 4.64% |

| whisper-large-v2 | 5.49% |

精度は向上しているが、Whisperと同じ価格が維持されており、miniの場合にはさらに半額で利用することが可能だ。

- GPT-4o Transcribe:1分あたり0.6セント(従来のWhisperと同価格)

- GPT-4o Mini Transcribe:1分あたり0.3セント(半額)

また、背景の雑音などのノイズ耐性も改善されているという。連続して音声入力/テキスト出力が可能なストリーミングや、ユーザーが話し終えたタイミングを認識して自動的に音声を分割するアクティビティ検出などにも対応している。

GPT-4o Transcribeで文字起こしをする方法

gpt-4o-transcribeも、gpt-4o-mini-transcribeも、Whisperと同じコードで呼び出すことが可能だ。

これらのモデルには、ChatGPTのようなWebインターフェースは用意されていないので、APIを経由して、多少なりともコードを書く必要がある。

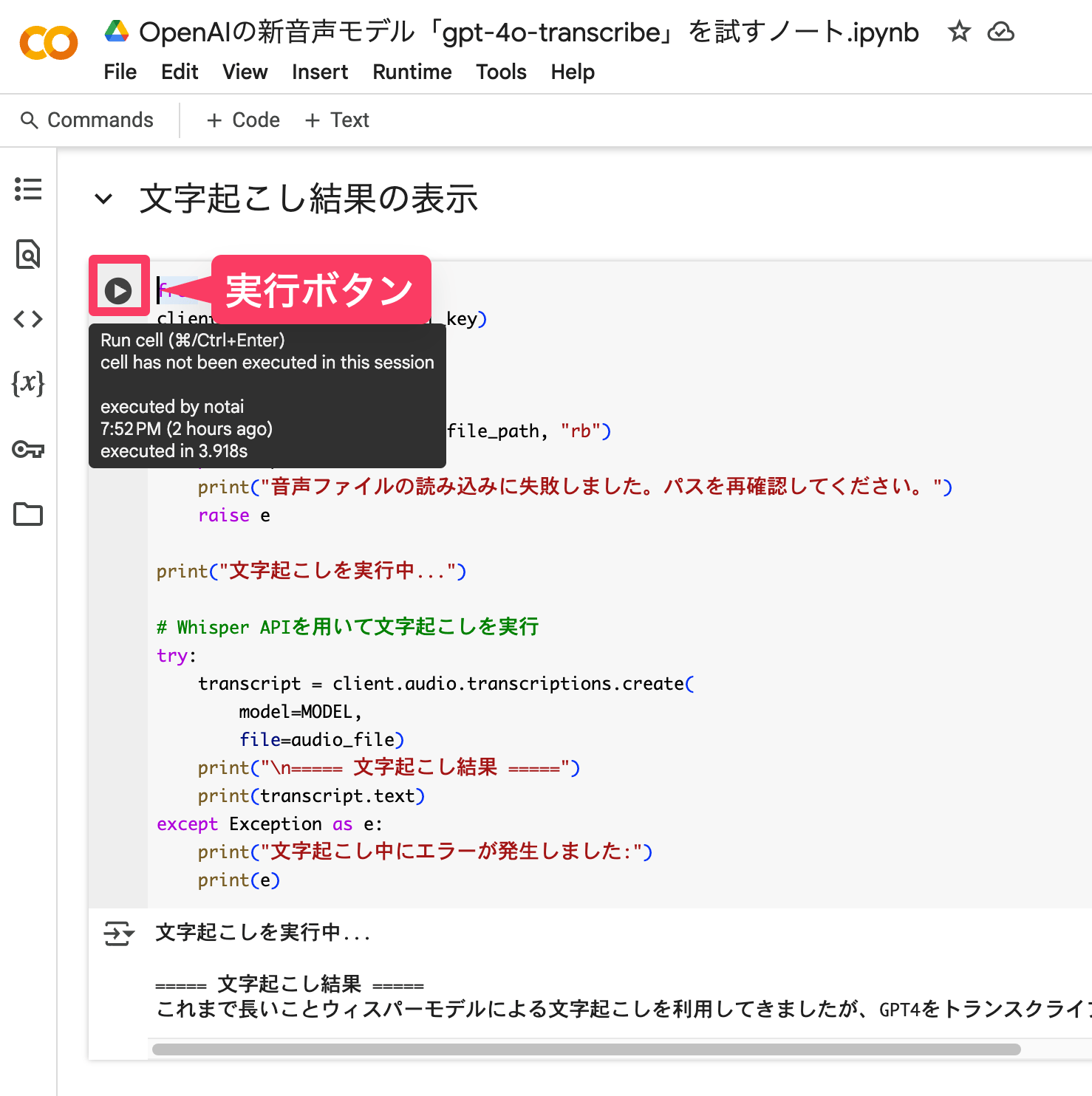

そこで、プログラミング経験のない初心者でも、GPT-4o Transcribeを使ってみることができるように、Googleドライブ上の音声ファイルを文字起こしできるノートブックを作成した。

OpenAIのAPIキーの作り方については過去の記事で解説しているので、まだAPIキーを持っていない人は過去記事を参照してほしい。

Googleアカウントにログインした状態で、上記のノートブックを開いたら、左側のメニューの鍵マークから、OpenAIのAPIキーを追加する。

また、Googleドライブのマイドライブのどこかに、テキスト化したい音声ファイルを保存しておく。

デフォルトではMyDrive/Colab Notebooks/sample.m4aというファイルを文字起こしするようになっているが、必要に応じてファイル名や保存先のフォルダパスを書き換えてほしい。

あとは、上から順に全てのセルの実行ボタンを押していくだけだ。

これだけで、最後に文字起こしの結果がテキストとして表示される。

実際使ってみたところ、日本語でもかなり精度が高く文字起こしされるので、動画の字幕付けや、会議やセミナーの文字起こしなどに非常に役立つだろう。

Whisperでは、YouTubeの字幕付けなどにも使えるタイムスタンプ付きのテキストなども出力可能だが、現在のところ、gpt-4o-transcribeはそういった詳細オプションには対応していないようだ(2025/03/21時点)。

gpt-4o-transcribe と miniの性能比較

gpt-4o-transcribeとgpt-4o-mini-transcribeには2倍の価格差があるので、もし安価なminiをメイン使用できるなら、コストメリットは非常に大きい。

そこで、日本語での性能を確認するため、iPhoneのボイスレコーダーアプリで、30秒のサンプル音声を録音して、両モデルで文字起こしを行なってみた。

まずは最も精度が高いと思われるgpt-4o-transcribeによる文字起こし結果が以下だ。

これまで長いことウィスパーモデルによる文字起こしを利用してきましたが、GPT-4をトランスクライブの性能はどれほどのものなのでしょうか。特に日本語での書き起こしの性能や、固有名詞を日本語とアルファベットをうまく書き分けることができるかなどに注目しています。これはだいたい30秒ぐらいのオーディオになっています。

一方、小型軽量のgpt-4o-mini-transcribeモデルによる結果は以下。

これまで長いことリスパーモデルによる文字起こしを利用してきましたが、GPT-4オートランスクライブの性能はどれほどのものなのでしょうか。特に日本語での書き起こしの性能や、固有名詞を日本語とアルファベットをうまく書き分けることができるかなどに注目しています。これはだいたい30秒ぐらいのオーディオになっています。

やはり若干、miniの方が精度が劣っていることが感じられる。特に、GPT-4o、Whisperモデルなどの固有名詞が聞き取れていない傾向にある。

ただ、それ以外の点は問題なく文字起こしが成功しており、このレベルであれば、固有名詞が少ない日常の会話等であれば、miniでも十分に実用的な精度で文字起こしができそうだと感じられる。

テキスト読み上げ(Text-to-Speech)モデルの詳細

新たに登場したgpt-4o-mini-ttsは、従来のTTSモデルから大きく進化して、口調などをプロンプトで制御することができるようになった。

最大の特徴は、単に「何を言うか」だけでなく「どのように言うか」を指示できるようになった点にある。

これによって、カスタマーサポート等として利用する際には丁寧で誠実な口調、動画のナレーション等として利用する際には元気よくハキハキとした口調、といったきめ細かいカスタマイズが可能になった。

価格は以下の通りで、非常に安価だ。動画のナレーション付けなどにも実用レベルで使えるかもしれない。

- 100万トークンあたり$0.60(OpenAIの試算では約1.5セント/分)

非常に安価に利用できるので、仮に1時間話し続けても$1以下なので、世の中のカスタマーサポートセンターなどは続々とAIに置き換えられていきそうだ。

現在も普及しているチャットボットより、音声による問い合わせを好むユーザーも多いであろうから、Text-to-Speechモデルの普及がどのような変化をもたらすのか楽しみだ。

GPT-4o mini TTSで色々な声色を作ってみる方法

現在、新たに登場した「GPT-4o mini TTS」を、無料で試すことのできるOpenAIの特設サイト「OpenAI.fm」が開設されている。

9種類の「Voice」からキャラクターを選択し、「Vibe」でトーンや感情、雰囲気などを制御することができる。そうして設定した声が、「Script」に書き込んだテキストを読み上げてくれる。

OpenAI公式のライブ配信では、マッドサイエンティスト風のデモが行われた。同じ音声でも、インストラクションによって大きく雰囲気を変えることができる。

VibeやScriptを設定したら、「Play」ボタンをクリックするだけで音声が生成される。音声ファイルはダウンロードすることも可能だ。

日本語にも対応しているので、例えば以下のような指示をしてみると、静かな声で喋りかけてくれた。

自分でVibeのプロンプトを考えるのが面倒な時は、ランダムに設定する機能も備えている。

眠ろうとする子どもに読み聞かせをするような優しく暖かい口調。

ささやき声を中心に、子どもを起こさないように気をつけながら喋る。もちろん、こうした遊び心あふれる特設サイトだけでなく、GPT-4o mini TTSモデルは、通常のAPIでも提供されている。

APIを利用すると、さらにスピードや音声ファイルのフォーマットなど、細かい設定を追加できる。

開発者向けのPlaygroundで、Transcribeモデルでは提供されていなかったWebインターフェースも用意されているので、OpenAIのAPIに登録するだけで、コードを書く必要なく利用できる。

文字起こし&読み上げAIが完全に実用レベルに

音声認識モデルも、テキスト読み上げモデルも、非常に高い性能に達しつつある。

GPT-4o Transcribeの日本語での単語エラー率は3%まで改善しており、人間に文字起こしをさせるよりも誤字脱字が少ない可能性すらある。

また、GPT-4o mini Transcribeのように、より低価格のモデルも登場。GPT-4o mini Transcribeを使用した場合、24時間365日を録音して全て文字起こししたとしても、1500ドル強しかかからない。

音声認識モデルの価格が年々低下していくので、そのうち24時間自分の生活を録音して記録しておく、なんてライフログの取り方が実現する日も近いだろう。

また、GPT-4o mini TTSによるテキスト読み上げは、感情の起伏まで非常にリアルに表現することができる。

あと数年もすれば、人間と全く区別がつかないAIコールセンターが実用化しているに違いない。