中国企業が開発したLLMである「DeepSeek R1」は、圧倒的な低コストと、OpenAI o1にも匹敵する世界トップレベルの性能で、大流行を見せている。

DeepSeek公式が提供しているWeb版やスマホアプリ版を使えば、非常に高性能な推論モデルであるR1を、無料で毎日50回も利用できてしまうので、多くのユーザーを惹きつけている。

また、API価格もOpenAIやAnthropicと比べて9割以上安価であるため、DeepSeek APIをコーディングアシスタント等として利用しているユーザーも多いのではないか。

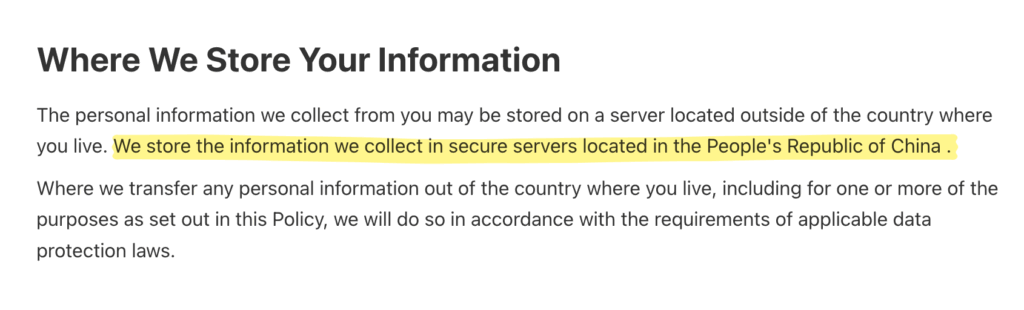

しかし、中国本土の企業が開発するサービスである以上、プライバシーの懸念は見過ごすことはできない。

実際、DeepSeekのプライバシーポリシーには、中国内のサーバーにユーザー情報が保管される、と明記されている。最悪の場合、ユーザーの個人情報も、プロンプト履歴も、アップロードしたファイルも、全てが記録・保管されている可能性もある。

いくら性能が高く、価格が安いといっても、プライバシーの懸念が強いと、ビジネスの現場で使用するのは躊躇される。Cursorなどのコードエディタで、うっかりDeepSeek公式のAPIを使ったら、すべてのコードベースが中国に送信されてしまう。

幸い、DeepSeek R1はオープンソースでモデルが公開されているため、プライバシーを重視した企業がホストするR1モデルを使えば、安心して利用できる。

そこで本記事では、以下の3点を満たすことを条件に、DeepSeek R1をAPI利用できる企業・サービスをまとめた。

- 米国に所在する企業であること

- プライバシーポリシーやTerms of Serviceの中で、ユーザーのプロンプトを保管・流用しないことが明記されていること

- 蒸留モデルではなく、DeepSeek R1 671B (フルモデル)を利用できること

現状、これらの条件を満たすのは、筆者が調べた限り、2社しか見つかっていない。

R1から派生して作られた小型のDistillモデルをホストしているサービスは複数存在するが、DeepSeek R1の”フルモデル”(671Bパラメータ)を利用できる選択肢は非常に希少だ。

なお、APIではなくチャットインターフェースを提供している企業としてはPerplexityがあり、以下の記事で詳しくDeepSeek R1 × Perplexityの使い方を解説しているので、そちらも参考にして欲しい。

”西側”のDeepSeek R1 / V3のAPIプロバイダまとめ

これだけ話題になっているDeepSeek R1だが、意外にも、671Bのフルモデルを、APIサービスとして提供開始できている企業の数は少ない。

まだDeepSeek R1がリリースされてから10日も経っていないことを考えれば、当然なのかもしれないが・・・。

以下が、DeepSeek R1をAPIで利用可能にしている、欧米諸国のAI推論向けのGPUクラスタプロバイダーの一覧だ。

| 企業名 | 所在地 | Input / 1M | Output / 1M |

|---|---|---|---|

| Together AI | 米国 | $7.00 | $7.00 |

| Fireworks AI | 米国 | $8.00 | $8.00 |

| DeepSeek | 中国 | $0.55 | $2.19 |

API価格を見比べると、やはりDeepSeek公式と比べると、かなり高額になってしまう。

DeepSeekは、モデルのトレーニングに掛かった費用が安いことで話題だが、GPUクラスタの運用価格として見ても、価格の下押し圧力となっている。

とはいえ、OpenAI o1の Input $15.00/Output $60.00 と比べれば、Together AIやFireworks AIも、依然として圧倒的に安価ではある。米国企業であることや、プライバシーポリシーの安心感を考えれば、妥協できる価格帯だ。

ちなみに、DeepSeek V3のAPIサービスプロバイダの一覧と料金表は、以下の通りだ。R1よりもV3の方が、よりDeepSeek公式に近い価格帯で、米国各社がAPI料金を設定していると言える。

| 企業名 | 所在地 | Input / 1M | Output / 1M |

|---|---|---|---|

| DeepInfra | 米国 | $0.85 | $0.90 |

| Fireworks AI | 米国 | $0.90 | $0.90 |

| Together AI | 米国 | $1.25 | $1.25 |

| DeepSeek | 中国 | $0.14 | $0.28 |

※DeepSeek公式のV3のAPI価格は、2月8日まで特別割引価格となっている。

※シンガポール企業である「NovitaAI」もDeepSeek R1 / V3のAPIサービスを類似の価格帯で提供しているが、上記表は、特に安全性・プライバシー重視のユーザーを想定し、米国または欧州のプロバイダに限定している。

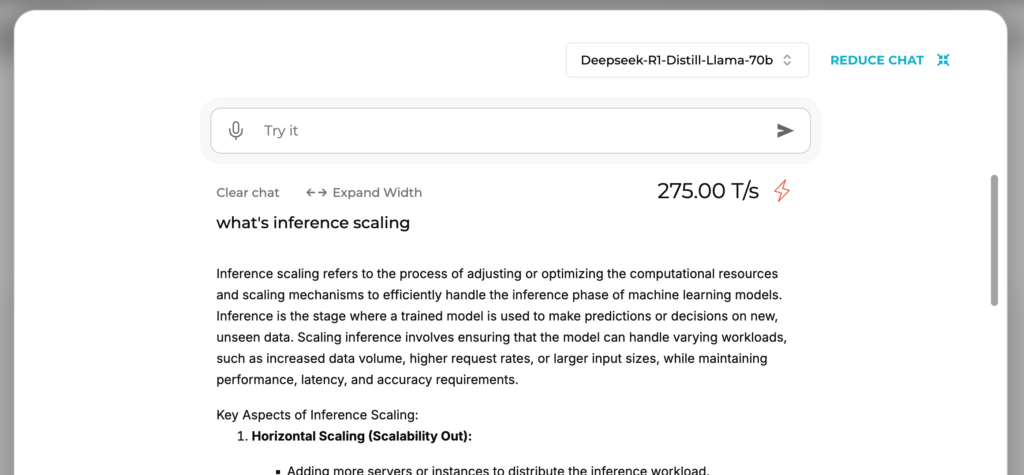

※より小型軽量のDistillモデル(蒸留モデル)であれば、deepseek-r1-distill-llama-70bを秒速275トークンというとんでもないスピードで利用できるGroqなどの選択肢もある。本記事では蒸留モデルは対象外なので、詳細は割愛する。

「Together AI」の高速APIでDeepSeek R1を使う

Together AIは、2022年にカリフォルニアで設立された、AI推論用のGPUクラスターを提供する米国企業だ。

LlamaなどのオープンソースLLMを高速なサーバーでホストしており、APIとして従量課金で利用可能である。また、オンデマンドでユーザー専用のGPU環境をデプロイする選択肢も用意されている。

Together AIで使うDeepSeek R1の安全性

Together AIでは、ユーザーのプロンプトの保管、Together AIによるモデルトレーニングでの使用について、設定画面で明確にオンオフを切り替えることができる。

FAQsの中で、以下のように明言されている。

Will my data be used to train other models? What’s your privacy policy?

No. Data sent to the endpoint will not be used to train models unless you grant us permission to.

We allow you to set your privacy settings to control whether or not Together AI retains training data, prompts or model responses, or uses any of your data for training our own models. You can adjust your privacy settings or request your data be deleted by going to Settings > Profile.

DeepSeek R1 モデルに送信したプロンプトが、他の目的に流用される心配がないため、安心して使用することができる。

Together AIのAPIでDeepSeek R1を使う方法

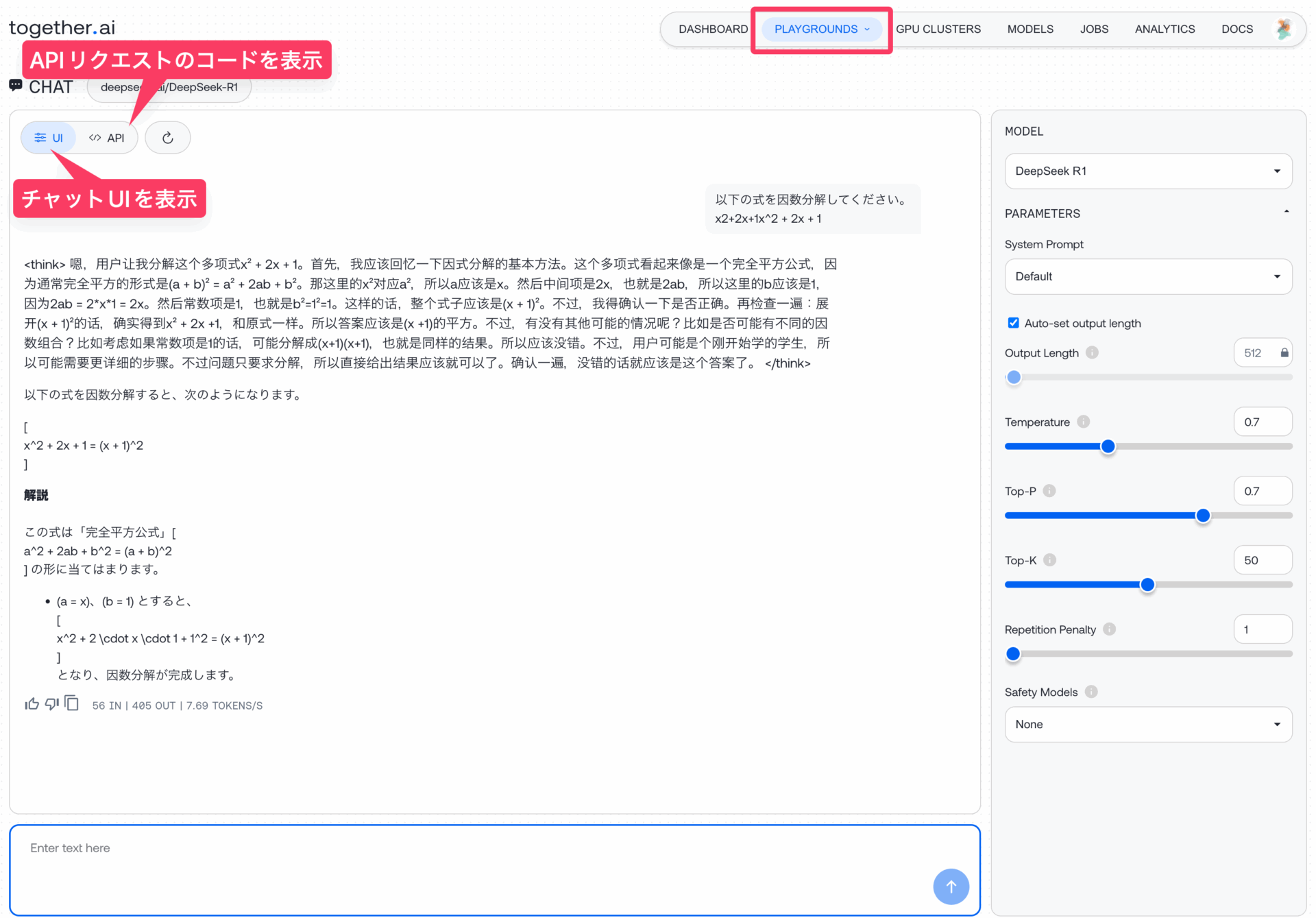

まずは、Together AIのトップページにアクセスし、「Get Started」からアカウントを作成する。

記事執筆現在、Together AI自身が、トップページで「DeepSeek R1使えるよ!プライバシーコントロール可能だよ!」とアピールしている。DeepSeek R1のプライバシー懸念が注目を集める中で、おそらくユーザーが増えているのだろう。

アカウントを作ると、1ドル分のAPIクレジットが無料でもらえるので、課金せずともAPIの使用感を試すことができる。

ログインすると「DASHBOARD」が開き、「POPULAR MODELS」に主要な人気オープンソースモデルが表示されている。

DeepSeek R1 にカーソルを合わせると、「OPEN IN PLAYGROUND」というボタンが現れるので、これをクリックしてみる。

Playgroundを開くと、「UI」タブでチャットインターフェースを表示、「API」タブでAPIリクエストのためのコードを表示してくれるテスト画面になる。

画面下のチャットボックスに質問を打ち込めば、DeepSeek R1が回答を生成してくれる。

画面右のスライダーで、DeepSeek R1のパラメータを変更できる。

簡単な因数分解の問題を聞いてみると、無事回答してくれた。秒速7.69トークンと、DeepSeek公式のWeb版と比べると、結構スピードは遅めな印象ではある。

「API」タブをクリックすれば、テスト中の設定通りに、Together AIにAPIリクエストを送信するためのコードが表示される。

Together AIのAPIはOpenAI互換で超便利

Together AIのAPIを利用するには、通常はTogether AI独自のライブラリtogetherを用いる必要がある。

しかし、幸いなことに、Together AIのAPIは、OpenAIのライブラリと互換性がある。

例えばPythonであれば、OpenAIのライブラリを使っている既存のプログラムにおいて、クライアント初期化を行う際にBase URLをTogether AIのURLに書き換えておき、使用するモデル名をmodel="deepseek-ai/DeepSeek-R1"に変更するだけで良い。

import os

import openai

client = openai.OpenAI(

api_key=os.environ.get("TOGETHER_API_KEY"),

base_url="https://api.together.xyz/v1",

)自分でコードを書かず、既存のAIツールを使用する場合でも、それがOpenAIのAPIに対応しており、Base URLの上書き設定が可能なプログラムであれば、なんでもDeepSeek R1を利用できるということになる。

したがって、AIアシスタント付きのテキストエディタである「Cursor」や、各社のLLMを一括で使える汎用チャットUIである「LibreChat」など、代表的なアプリにおいても、Together AI経由のDeepSeek R1を使うことができる。

「Fireworks AI」の高速APIでDeepSeek R1を使う

Fireworks AI も、Together AIと非常に出自が似ており、2022年にカリフォルニアで設立され、AI用のGPUクラスターを提供している米国企業だ。

LLamaやMixtralなどの主要なオープンソースモデルをホストしており、安価で高速なAPIを提供しているほか、ユーザーが自身のデータを用いてモデルのファインチューニングなどをクラウド上で実行できるサービスを提供している。

Fireworks AIで使うDeepSeek R1の安全性

Fireworksのドキュメントの中で、ユーザーの同意なく、プロンプトのログの記録・保管をしない旨が明言されている。

Fireworks does not log or store prompt or generation data for any open models, without explicit user opt-in.

More technically: prompt and generation data exist only in volatile memory for the duration of the request. If prompt caching is active, some prompt data (and associated KV caches) can be stored in volatile memory for several minutes. In either case, prompt and generation data are not logged into any persistent storage.

こちらもまた、ユーザーがR1に対して送ったプロンプトやファイルが、他の目的に流用されず、Fireworks AIによって保管もされないので、安心して使うことができる。

Fireworks AIのAPIでDeepSeek R1を使う方法

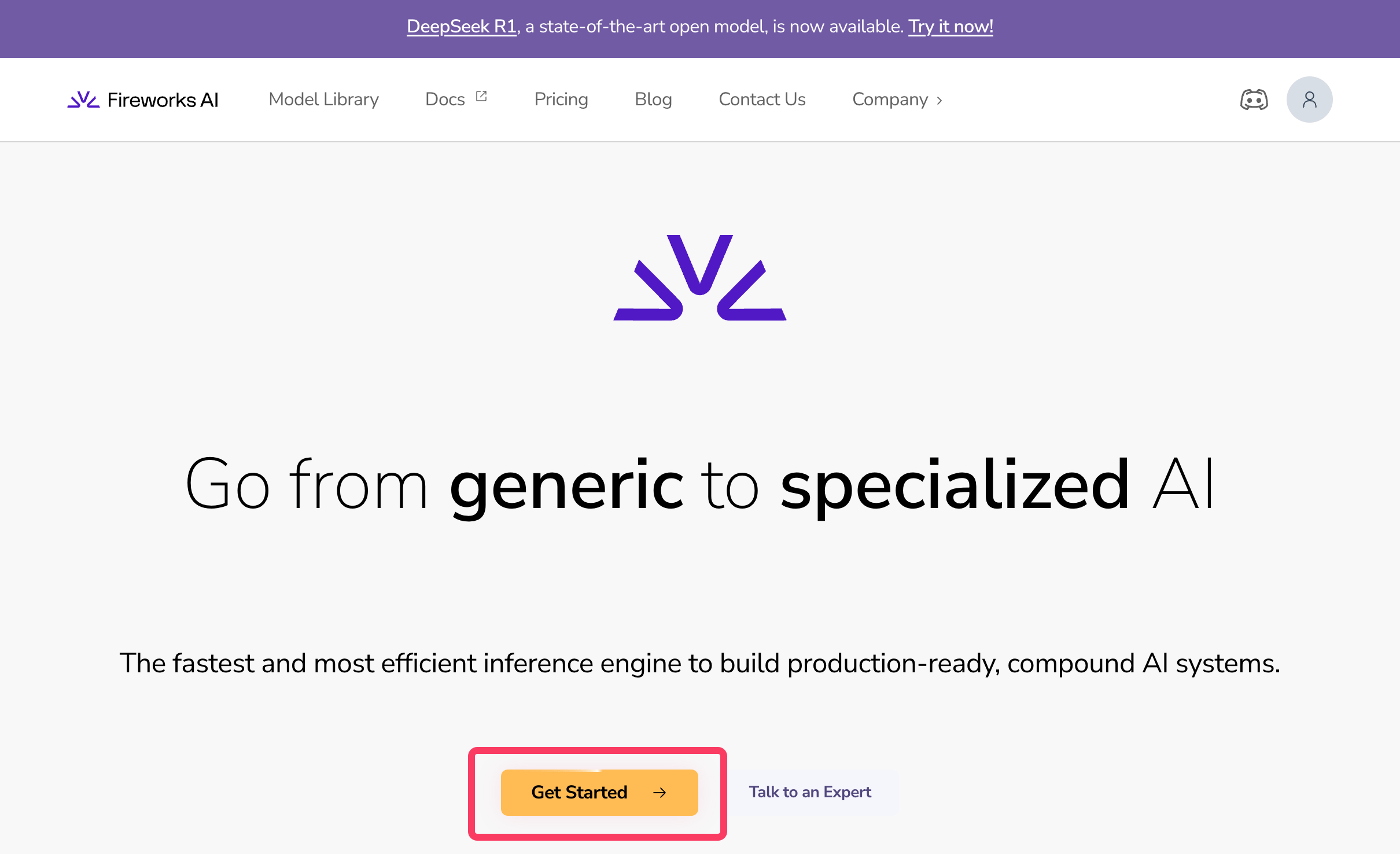

まずは、Fireworks AIのトップページにアクセスし、「Get Started」をクリックしてアカウントを作成する。

Fireworks AIも、DeepSeek R1が利用可能になったことを大々的にPRしており、米国での高い注目を伺わせる。

ログインすると、左上のメニューから「My Models」を選択し、利用したいモデルを選択する画面に移行する。

自分で大規模言語モデルをアップロードしたり、既存のモデルをファインチューニングしたりするオプションもあるが、ここでは「Explore the Model Library」からDeepSeek R1を指定する。

自分専用のGPUインスタンスを立ち上げるのではなく、APIとして使用する方法のことを、Fireworks AIでは「Serverless API」と呼ぶ。

モデル選択画面でDeepSeek R1の「Serverless」ボタンをクリックすると、モデルの詳細が表示される画面になる。

ここで「Playground」タブをクリックすれば、チャット風のインターフェースで、モデルの出力をテストできる画面になる。

Together AIとほぼ同じだが、プレイグラウンドの画面右側にある「View Code」をクリックすれば、APIリクエストに必要なコードサンプルが表示される。

Fireworks AI のAPIもOpenAI互換

これもまた、Together AIと非常に似ているが、Fireworks AIのAPIもまた、OpenAIのPython SDKと互換性がある。

以下のように、APIキーとBase URLをFireworksのものに差し替え、モデルとしてaccounts/fireworks/models/deepseek-r1を指定すれば、Fireworks AIのDeepSeek R1モデルを使用できる。

既存のプログラムのコードを殆ど書き換えることなく、そのままFireworks AIのモデルが利用できるのでとても便利だ。

import os

import openai

client = openai.OpenAI(

api_key=os.environ.get("FIREWORKS_API_KEY"),

base_url="https://api.fireworks.ai/inference/v1",

)Together AIと同じく、OpenAI互換のAPIに対応したCursorやLibreChatなどのアプリで活用する方法は、以下を参考にしてほしい。

CursorやLibreChatで、米国のDeepSeek R1を使おう

以上で紹介したように、Together AIやFireworks AIのAPIを利用すれば、米国企業が提供するDeepSeek R1を、簡単に利用することができる。

いずれの会社も、プライバシーポリシーなどで、ユーザーのプロンプトを保管したり、トレーニングに流用したりしないことが明言されているので、本家のDeepSeekよりも安心して利用することができる。

また、Together AIやFireworks AIのAPIサービスは、OpenAIのAPIと互換性があるため、OpenAIのAPIが使えるアプリやソフトウェアであれば、そのままDeepSeek R1のAPIを利用できる可能性がある。

Cursorで米国ホストのDeepSeek R1を使う方法

例えば、コードエディタのCursorでは、無料版のユーザーであっても、APIキーを登録することで、OpenAIのGPT-4oやo1などのLLMを、コーディングアシスタントとして使用できる。

OpenAIに対応しているということは、DeepSeekのAPIも行けるということだ。

Command + Shift + P で、Cursor Settingsを開き、APIキーの設定画面まで進む。

Cursor Settings > Models > OpenAI API Key > Override OpenAI Base URLで、Base URLを上書きできる。

Base URLをTogether AIのものに変更して、モデルにdeepseek-ai/DeepSeek-R1を足せば、Together AIのAPI経由のR1を利用できるはずだ。

LibreChatで米国ホストのDeepSeek R1を使う方法

LibreChat、Open WebUI、ChatbotUIなど、各社のAPIキーを登録して、チャットインターフェースで様々なモデルを一括で使えるアプリでも、カスタムエンドポイントとしてTogether AIやFireworks AIを追加すれば、安心安全の米国企業のDeepSeek R1を利用できる。

こうした汎用チャットUIアプリは、OpenAI, Anthropic, Googleなどあらゆる主要LLMを、各社のAPIキーを登録することで、1箇所でまとめて使えるのでオススメだ。

しかも、月額課金も不要で、使った分だけ支払う従量課金方式で、様々なモデルを使い分けられる。

もし導入していない人がいれば、この機会にインストールをオススメする。

筆者が気に入って使っているのは「LibreChat」だが、Together AIのホストするDeepSeek R1も、カスタムエンドポイントとして追加して、正常に動作してくれた。

ここでは、簡単にLibreChatにTogether AIのDeepSeek R1を追加する手順を解説する。

前提として、当サイトの過去記事で紹介している以下2つの初期設定は完了しているものとする。

- LibreChat自体のインストール作業が完了(こちらの記事を参照)

- カスタムエンドポイントの追加に必要なファイル2点の準備が完了(こちらの記事を参照)

docker-compose.override.ymllibrechat.yaml

まずは、librechat.yamlを編集していく。

カスタムエンドポイントとして、Together AIを追加するために、Together AIのAPIドキュメントにあるBase URLと、モデル名(deepseek-ai/DeepSeek-R1)を記載している。

version: 1.2.1

cache: true

endpoints:

custom:

# Together AI

- name: 'together'

apiKey: '${TOGETHERAI_API_KEY}'

baseURL: 'https://api.together.xyz/v1/'

models:

default:

[

'deepseek-ai/DeepSeek-R1',

]

fetch: false

titleConvo: true

titleModel: 'deepseek-ai/DeepSeek-R1'

modelDisplayLabel: 'together'

次に、APIキーを登録する。

APIキーは、Together AIのダッシュボードからAPI KEYSのページに進むとコピーできる。

コピーしてきたAPIキーを、.envファイルの77行目にあるTOGETHER_API_KEYの部分に、上記で作成したTogether AIのアカウントのAPIキーをコピペする。

以上の作業が終わったら、以下のコマンドをターミナルに打ち込み、LibreChatを再起動する(ついでにアップデートしている)。

docker compose down

git pull

docker compose pull

docker compose upこれで、Together AIのDeepSeek R1が、LibreChatのモデル選択画面で選択可能になっているはずだ。