Google DeepMindは2026年2月19日、Gemini 3シリーズの改良版「Gemini 3.1 Pro」をパブリックプレビューとしてリリースした。

AIが未知のパターンを見抜けるかを測る抽象推論ベンチマーク「ARC-AGI-2」で、前モデルの2倍超となる77.1%を記録し、独立評価機関Artificial Analysisの総合指数でも全モデル中1位を獲得した。

性能は大幅に向上しているが、API価格は据え置きだ。

入力$2.00/100万トークン、出力$12.00/100万トークンという設定は、Claude Opus 4.6(入力$5.00、出力$25.00)と比べて入力コスト60%オフ、出力コスト52%オフという計算になる。

性能が上がっても価格は変わらないという、APIユーザーにとっては理想的なアップデートである。

Geminiアプリでは、無料ユーザーも利用可能となっており、Google AI StudioやGemini CLIからもすぐに試せる。

本記事では、今回のアップデートの概要をまとめるとともに、実際に利用するための手順まで、スクリーンショットを交えて非エンジニアにも分かりやすく解説する。

Gemini 3.1 Proの概要:推論力・信頼性・エージェント性能を底上げ

Gemini 3.1 Proは、2025年11月リリースのGemini 3 Proをベースに改良されたモデルだ。Geminiシリーズとして初めて「.1」刻みのバージョン番号が採用されている。改善の柱は大きく4つ。ベンチマークの具体的な数値は次節で詳しく比較するが、まず全体像を整理しておこう。

- 推論能力の飛躍: 抽象推論、科学知識、コーディング、エージェントタスクのいずれでも前モデルから大幅にスコアが向上し、多くの指標でOpus 4.6やGPT-5.2を上回った

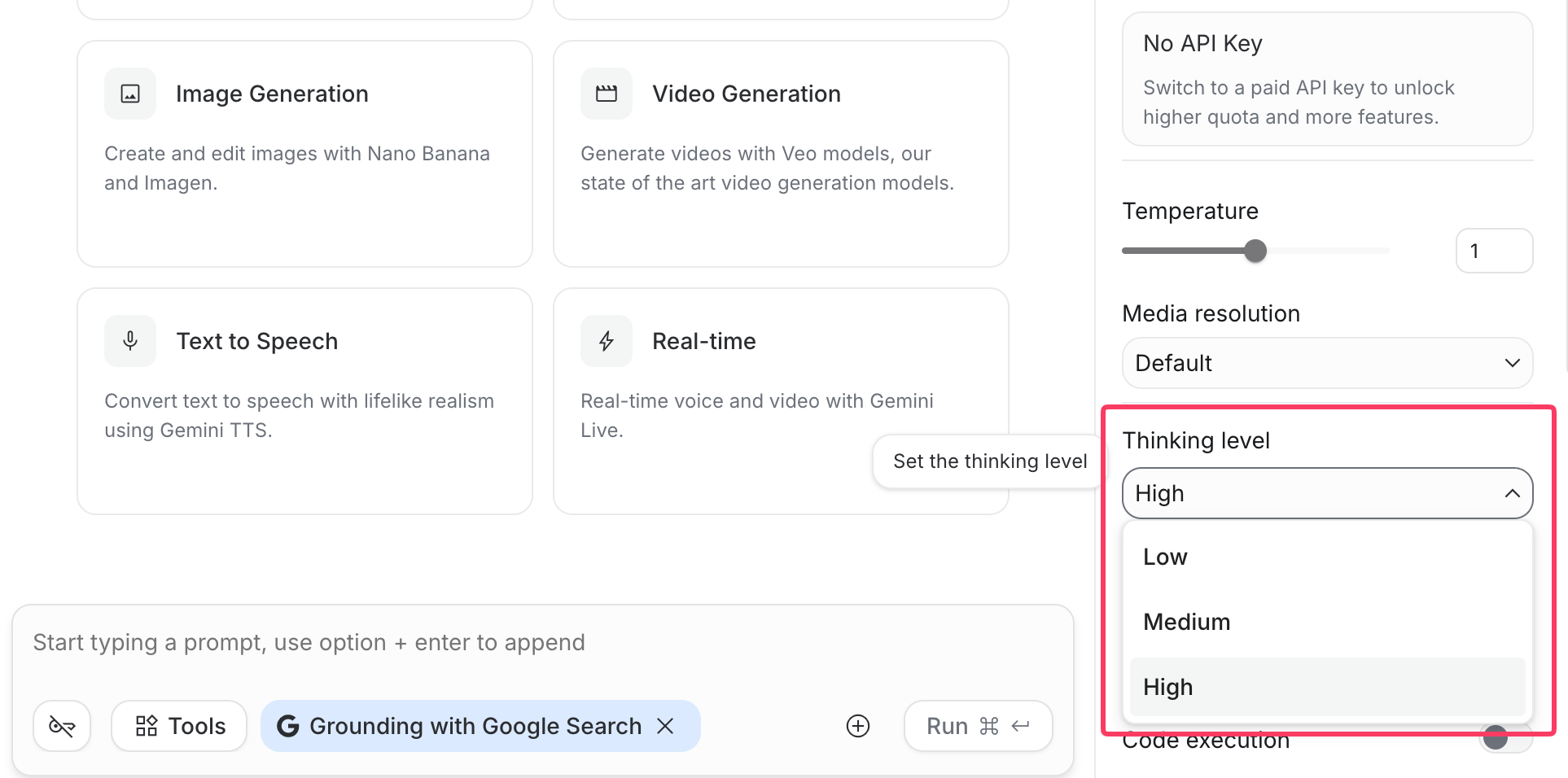

- 3段階の思考レベル: LOWとHIGHの2段階だった思考レベルにMEDIUMが追加された。API仕様によれば、HIGHではGemini Deep Thinkの「ミニ版」として動作し、1つのモデル内でタスクの複雑さに応じた思考の深さを選べる

- 幻覚の大幅削減: Artificial Analysisの評価によれば、幻覚率が88%から50%へと38ポイント改善。知識量の向上よりも、「わからないことをでっち上げなくなった」というキャリブレーション改善が主因とされている

- エージェント機能の強化: MCPワークフロー、Web検索、長期的な知識労働タスクなど、道具を使いこなすマルチステップ業務の性能が軒並み向上した

API仕様面では、MarkTechPostの技術記事によれば以下の変更も加わっている。

- ファイルサイズ上限が20MBから100MBへ拡大

- YouTube URLを直接メディアソースとして指定可能に

- Cloud Storageバケットやプリサインド付きプライベートDB URLに対応

コンテキスト窓(100万トークン)や出力上限(65,536トークン)、対応モダリティ(テキスト・画像・動画・音声・PDF)は3 Proから据え置きだ。

ベンチマーク徹底比較:Opus 4.6, GPT-5.2を全体的に上回る

ベンチマークの数値だけを並べても、それが何を意味するのかがわからなければ判断材料にならない。

ここではGoogle DeepMindのモデルカードに掲載された主要ベンチマークについて、「なにを測っているのか」を補足しながらポイントを整理していく。

推論・知識系

最も目を引くのはARC-AGI-2だ。前モデルの31.1%から77.1%へと2倍以上のジャンプを記録している。このベンチマークは「初見の論理パズルを解けるか」を測るもので、学習データの暗記では太刀打ちできない。Opus 4.6(68.8%)やGPT-5.2(52.9%)にも大差をつけており、今回のアップデートの目玉と言える。

一方、ツールを使える条件のHLEではOpus 4.6(53.1%)がトップに立ち、Gemini 3.1 Pro(51.4%)を上回っている点は見逃せない。「素の推論力」と「道具を使いこなす力」は別の能力であり、この差が後述するコミュニティ評価の温度差にもつながっている。

| ベンチマーク | 測定内容 | Gemini 3.1 Pro | Gemini 3 Pro | Opus 4.6 | GPT-5.2 |

|---|---|---|---|---|---|

| HLE(ツールなし) | 各分野の専門家が作成した超難問(テキスト+マルチモーダル) | 44.4% | 37.5% | 40.0% | 34.5% |

| HLE(ツールあり) | 上記+検索・コード実行が使える条件 | 51.4% | 45.8% | 53.1% | 45.5% |

| ARC-AGI-2 | 初見の論理パズル。学習データの暗記では解けない | 77.1% | 31.1% | 68.8% | 52.9% |

| GPQA Diamond | 大学院レベルの科学的知識問題 | 94.3% | 91.9% | 91.3% | 92.4% |

| MMMLU | 多言語での幅広い知識Q&A | 92.6% | 91.8% | 91.1% | 89.6% |

コーディング系

SWE-Bench Verifiedでは3社のフラッグシップが80%台でほぼ横並びとなり、「実際のGitHubイシューを直せるか」という点では差がつきにくくなってきた。

差が開くのは競技プログラミング(LiveCodeBench Pro)で、Gemini 3.1 ProのElo 2887はGPT-5.2の2393を約500ポイント上回る。アルゴリズム的な難問での推論力の高さがここにも表れている。

| ベンチマーク | 測定内容 | Gemini 3.1 Pro | Gemini 3 Pro | Opus 4.6 | GPT-5.2 |

|---|---|---|---|---|---|

| SWE-Bench Verified | 実際のGitHubイシューを修正するタスク | 80.6% | 76.2% | 80.8% | 80.0% |

| SWE-Bench Pro | より多様なコーディングタスク | 54.2% | 43.3% | — | 55.6% |

| Terminal-Bench 2.0 | ターミナル上でのエージェント型コーディング(Terminus-2ハーネス) | 68.5% | 56.9% | 65.4% | 54.0% |

| LiveCodeBench Pro | 競技プログラミング(Elo評価) | 2887 | 2439 | — | 2393 |

| SciCode | 科学研究向けのコーディング | 59% | 56% | 52% | 52% |

Terminal-Bench 2.0では、各社が自社最適のハーネスを用いた場合にスコアが大きく変わる。GPT-5.3-Codexは自社ハーネスで77.3%を記録しており、Gemini 3.1 Proの68.5%(Terminus-2ハーネス)を上回る。ベンチマーク比較では「どのハーネスで測定したか」に注意が必要である。

エージェント・ツール利用系

| ベンチマーク | 測定内容 | Gemini 3.1 Pro | Gemini 3 Pro | Opus 4.6 | GPT-5.2 |

|---|---|---|---|---|---|

| APEX-Agents | 長期間のプロフェッショナルタスク(実際の知識労働に近い) | 33.5% | 18.4% | 29.8% | 23.0% |

| MCP Atlas | MCPプロトコルを使ったマルチステップワークフロー | 69.2% | 54.1% | 59.5% | 60.6% |

| BrowseComp | エージェント型Web検索 | 85.9% | 59.2% | 84.0% | 65.8% |

| GDPval-AA | 実務的なエキスパートタスク(Elo評価) | 1317 | 1195 | 1606 | 1462 |

| τ2-bench(小売) | ツール利用を含むエージェントタスク | 90.8% | 85.3% | 91.9% | 82.0% |

APEX-AgentsやMCP Atlas、BrowseCompではGemini 3.1 Proが軒並みトップを取っている。特にBrowseCompは59.2%から85.9%への跳躍で、Web上の情報を自律的に探索する能力が一気に引き上げられた形だ。

ただし、GDPval-AAだけは例外で、Opus 4.6(1606 Elo)がGemini 3.1 Pro(1317 Elo)を約300 Elo引き離している。

GDPval-AAは「実務的なエキスパートタスク」を測るもので、ベンチマーク的なパズルではなく現実の知識労働に近い。「ベンチマークは強いが実務ではそこそこ」という初期ユーザーの体感に近い結果かもしれない。

LMArenaの人間投票リーダーボード(2月19日時点)では、テキスト部門でClaude Opus 4.6がGemini 3.1 Proを4ポイント上回って1位(1504 Elo)を維持している。コード部門でもOpus 4.6がリードしている。Arenaは人間の主観投票ベースであり、「正確さ」よりも「見た目の良さ」が有利に働く場合があるものの、ユーザーの体感としてはOpus優位なのも事実だ。

競合モデルとの価格・性能を踏まえた使い分け

ベンチマークの数値だけでなく、価格や速度を含めた総合的なポジションを比較してみる。

まず、Gemini 3.1 Proは、Opus 4.6やGPT-5.2と比べて大幅にコストが安い。

Artificial Analysisの評価でも、同機関の総合ベンチ(10項目の評価セット)を全モデルで実行した場合のコストは、Gemini 3.1 Proが$892に対し、Opus 4.6やGPT-5.2は$1,800超だったという。

同等のタスクを、半額以下で実行できる計算になる。

| 項目 | Gemini 3.1 Pro | Claude Opus 4.6 |

|---|---|---|

| 入力($/100万トークン) | $2.00 | $5.00 |

| 出力($/100万トークン) | $12.00 | $25.00 |

| コンテキスト窓 | 100万トークン | 20万トークン |

| 最大出力 | 65,536トークン | 128,000トークン |

| 出力速度 | 約107トークン/秒 | — |

以下のような使い分けが合理的だろう。

- Gemini 3.1 Proが向いているケース: 大量のトークンを消費するバッチ処理、100万トークンのロングコンテキストが必要な分析、MCP連携のワークフロー、コストを抑えたいプロトタイピング

- Claude Opus 4.6が向いているケース: 複雑なエージェント型の実務タスク(GDPval-AAで大差)、ツールを組み合わせた高度な問題解決(HLE+ツールで1位)、コーディングの実行品質を最重視する場面

- 併用で得意分野を使い分ける: 「Geminiで設計・推論、Claudeで実行」というハイブリッド戦略を採る開発者も増えている

無料で使える!Gemini 3.1 Proの始め方ガイド

Opus 4.6やGPT-5.2と同等以上のベンチマーク性能を持つモデルが、Googleアカウントさえあれば無料で使える。

トップモデルは、有料プラン限定であることも多い中、これは大きなアドバンテージだ。

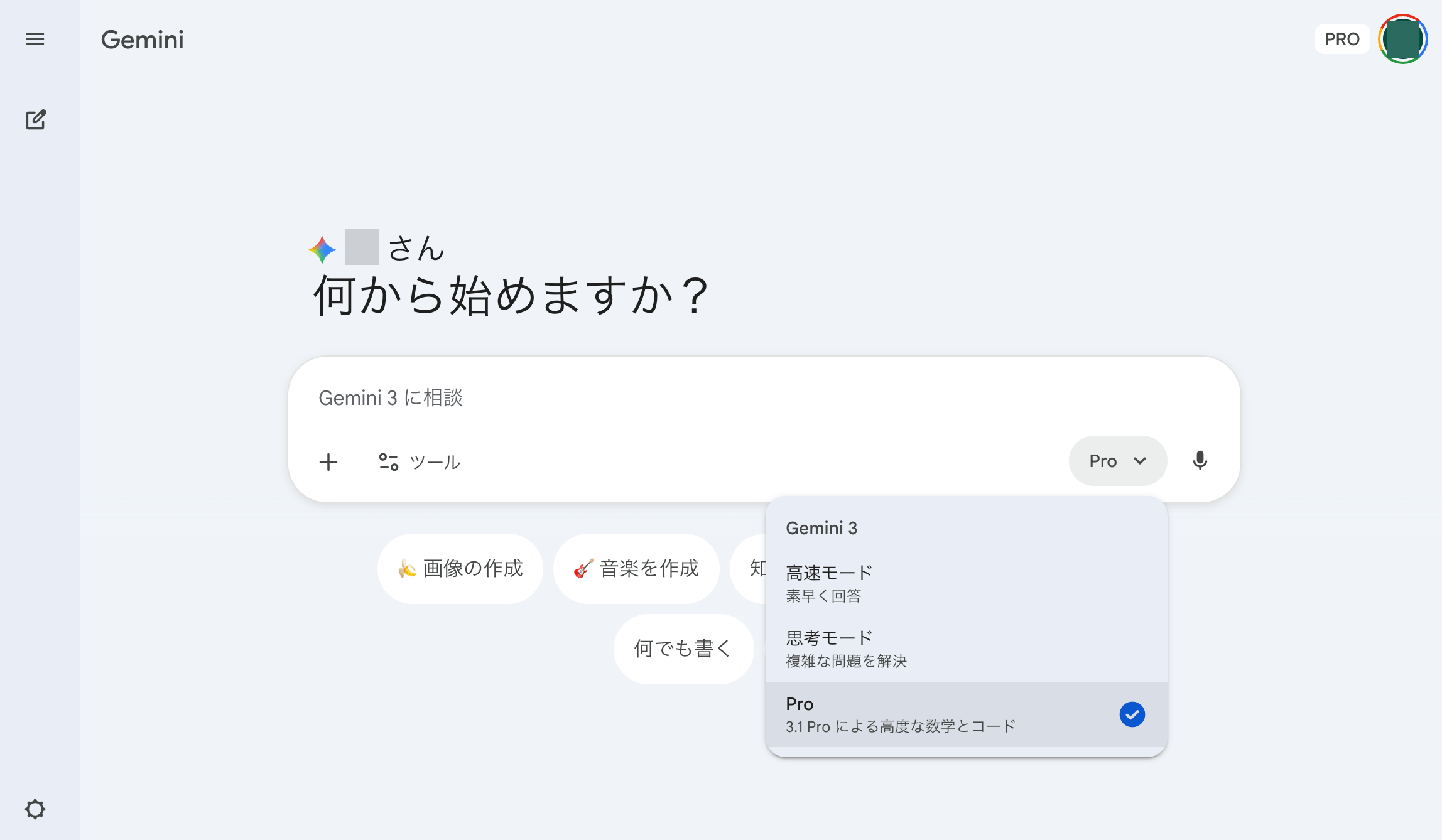

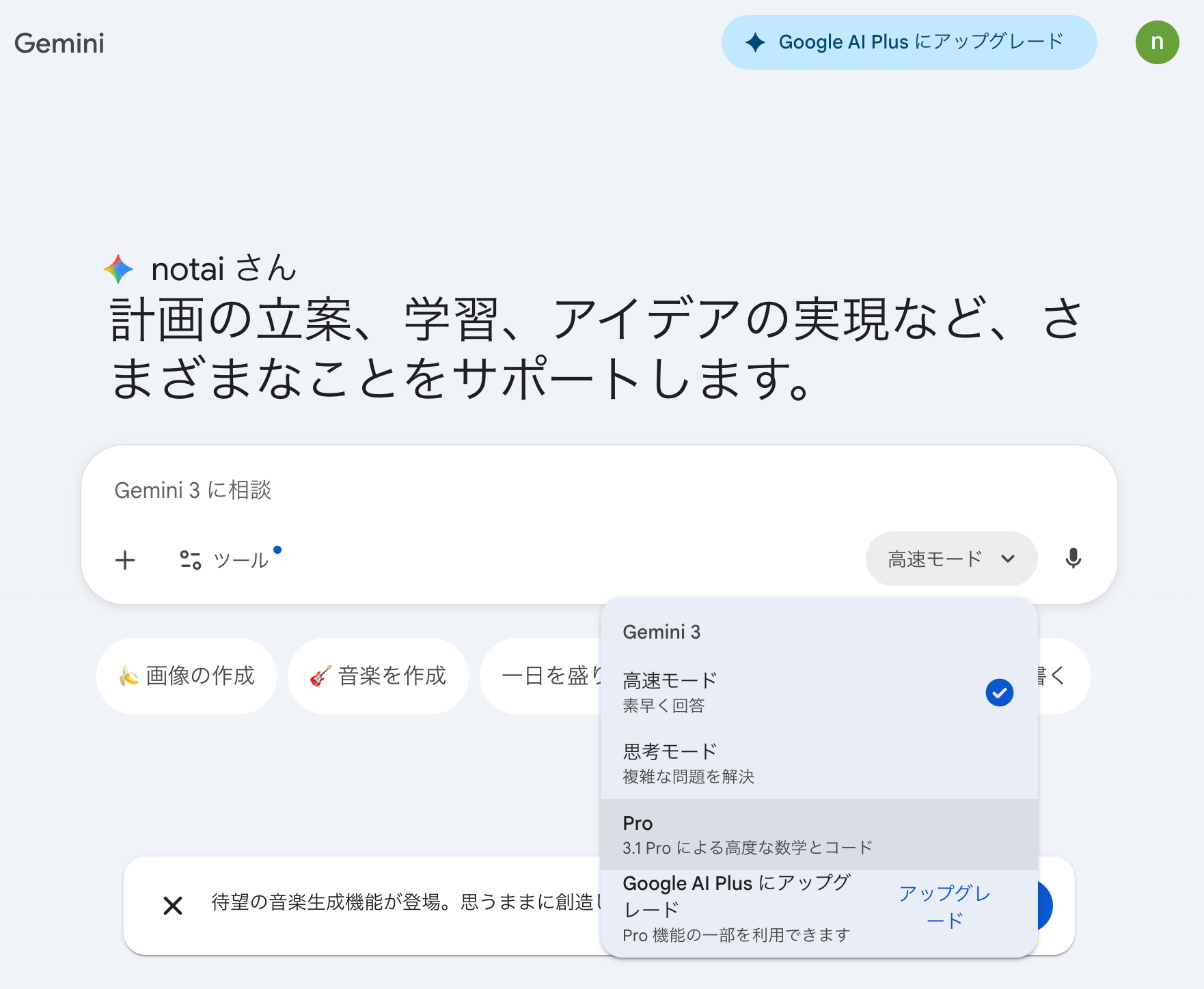

Geminiアプリ(最も手軽)

最も手軽なのは、gemini.google.comにGoogleアカウントでログインする方法だ。追加の登録や設定は一切不要で、すぐにGemini 3.1 Proとの対話を始められる。

無料ユーザーにはレート制限(一定時間あたりのメッセージ数の上限)があるが、日常的な質問や文章作成であれば十分に実用的だ。Google AI ProやUltraプランに加入すると、この上限が大幅に緩和される。

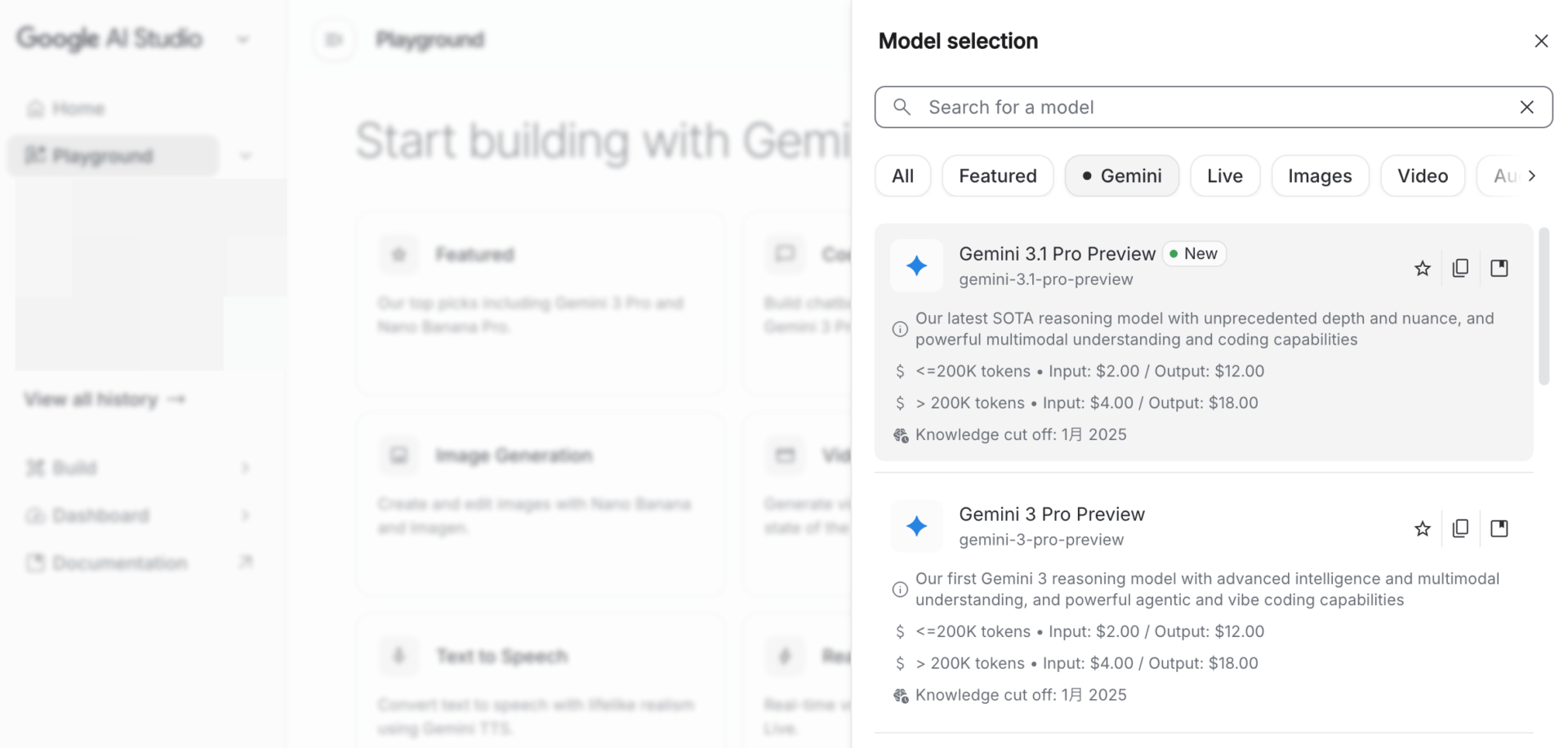

Google AI Studio(開発者以外にもおすすめ)

Google AI Studioは、Googleが提供するAIモデルの実験・開発環境だ。

「開発者向け」と銘打たれているが、Googleアカウントだけで無料で使え、Geminiアプリにはない細かな制御ができるため、一般ユーザーにもメリットが大きい。

最大の利点は、思考レベル(Thinking Level)をLOW / MEDIUM / HIGHの3段階から選べることだ。Geminiアプリではこの選択肢がなく、モデルが自動で思考の深さを決める。「簡単な質問には素早く、難しい問題にはじっくり考えさせたい」という使い分けをしたいなら、AI Studioを試す価値がある。

また、システムインストラクション(AIの振る舞いを事前に指定する設定)やTemperature(出力のランダム性)といったパラメータも自由に調整でき、同じプロンプトでも出力の質や傾向を細かくコントロールできる。

思考レベルの使い分けの目安としては、単純な要約・翻訳はLOW、一般的な分析・コーディングはMEDIUM、複雑な推論・数学・科学系の問題はHIGHが適している。HIGHではDeep Think Miniとして動作するため、思考時間が大幅に長くなる(SVG生成テストでは323.9秒かかった事例もある)。コストと速度のバランスを見て選択したい。

その他の利用手段

上記2つ以外にも、用途に応じて以下の方法が用意されている。

- Gemini CLI: ターミナルから

gemini -m gemini-3.1-pro-preview "プロンプト"で直接呼び出せる。リリース初日から対応済み - Gemini API: 既存APIユーザーはモデルIDを

gemini-3.1-pro-previewに変更するだけ。価格据え置きのため、コスト試算の変更も不要 - NotebookLM: Google AI ProまたはUltraプランの加入者限定で利用可能

ベンチマーク結果と、初期ユーザーの反応のギャップ

開発者コミュニティの声を拾ってみると、ネガティブな声として、エージェント型タスクでの実行力不足が頻繁に指摘されている。

Hacker Newsでは、元Google社員(spankalee氏)が「推論とコード生成は素晴らしいが、実際にタスクを遂行する際にはClaude Opusに大きく劣る」として、以下のような問題を指摘している。

- ファイル編集ツールを使わず、奇妙な方法でファイルを編集しようとする

- 思考トークンに偏重し、ユーザーへの説明が不足する

- ループに陥りやすく、前進できなくなる

ローンチ直後の不安定さも目立つ。単純な「hi」への応答に1分以上かかったり、エラーが頻発したりした。これはローンチ初日特有の問題である可能性が高いので、数日で解消されるだろう。

また、新しいGeminiのリリースは毎回、その時点のOpusをベンチマークで上回るが、実使用しているうちに結局Opusに戻ってしまう・・・というパターンは過去に筆者も体験しており、真の実力は、しばらく自分のユースケースに実投入しなければ見えてこない。

新機能:SVGアニメーション生成

リリース直後にX(旧Twitter)で最も話題となったのは、Gemini 3.1 ProによるSVGアニメーション生成の品質だ。

Google公式ブログでは、テキストプロンプトからWebサイトに直接埋め込めるアニメーションSVGを生成できることが紹介されている。

ピクセルベースの画像や動画と異なり、SVGはコードで構成されているため、どんなサイズに拡大しても劣化せず、ファイルサイズも極めて小さい。

「ペリカンが自転車に乗っている」プロンプトをあらゆるLLMに適用しているSimon Willison氏によるテストでは、脚の描写や魚のバスケットまで描き込まれた高品質なSVGが生成されている。

ベンチマーク最強、実務はこれから:Gemini 3.1 Proの現在地

ベンチマークでは文句なしの結果だ。ARC-AGI-2での2倍超の改善、Artificial Analysis総合指数1位、そしてOpus 4.6の半額以下という価格設定。数字だけ見れば、現時点で最もコストパフォーマンスの高いフラッグシップモデルと言える。

ただし、本記事で見てきたとおり、ベンチマークの強さがそのまま実務での強さに直結するわけではない。GDPval-AAではOpus 4.6に約300 Elo差をつけられ、コミュニティからはエージェント型タスクでの実行力不足も指摘されている。「推論力は高いが、道具を使いこなして仕事を完遂する力はまだ発展途上」というのが現時点での評価だろう。

Gemini 3.1 Proは現時点で「パブリックプレビュー」の位置付けであり、Google公式ブログでは「GA(一般提供)は近日中」としている。Preview段階では以下の点に留意したい。

- 仕様変更やAPIの破壊的変更が入る可能性がある

- 本番環境での稼働安定性はGA後に改めて評価すべき

- 知識カットオフが2025年1月であり、最新の出来事には対応していない

GA版での安定性改善と、エージェント型タスクの実行力強化が今後の注目ポイントになる。Googleには自社開発のTPUインフラという構造的な優位性があり、低コストで高性能なモデルを提供し続けられる土台は整っている。

まずはGoogle AI StudioやGeminiアプリで、自分のユースケースに合うかどうかを確かめてみてほしい。ベンチマークの数字以上に、自分の手で試した感触が最も信頼できる判断材料になるはずだ。