2026年2月12日、GoogleがGemini 3の特殊推論モード「Deep Think」の大型アップデートを発表した。

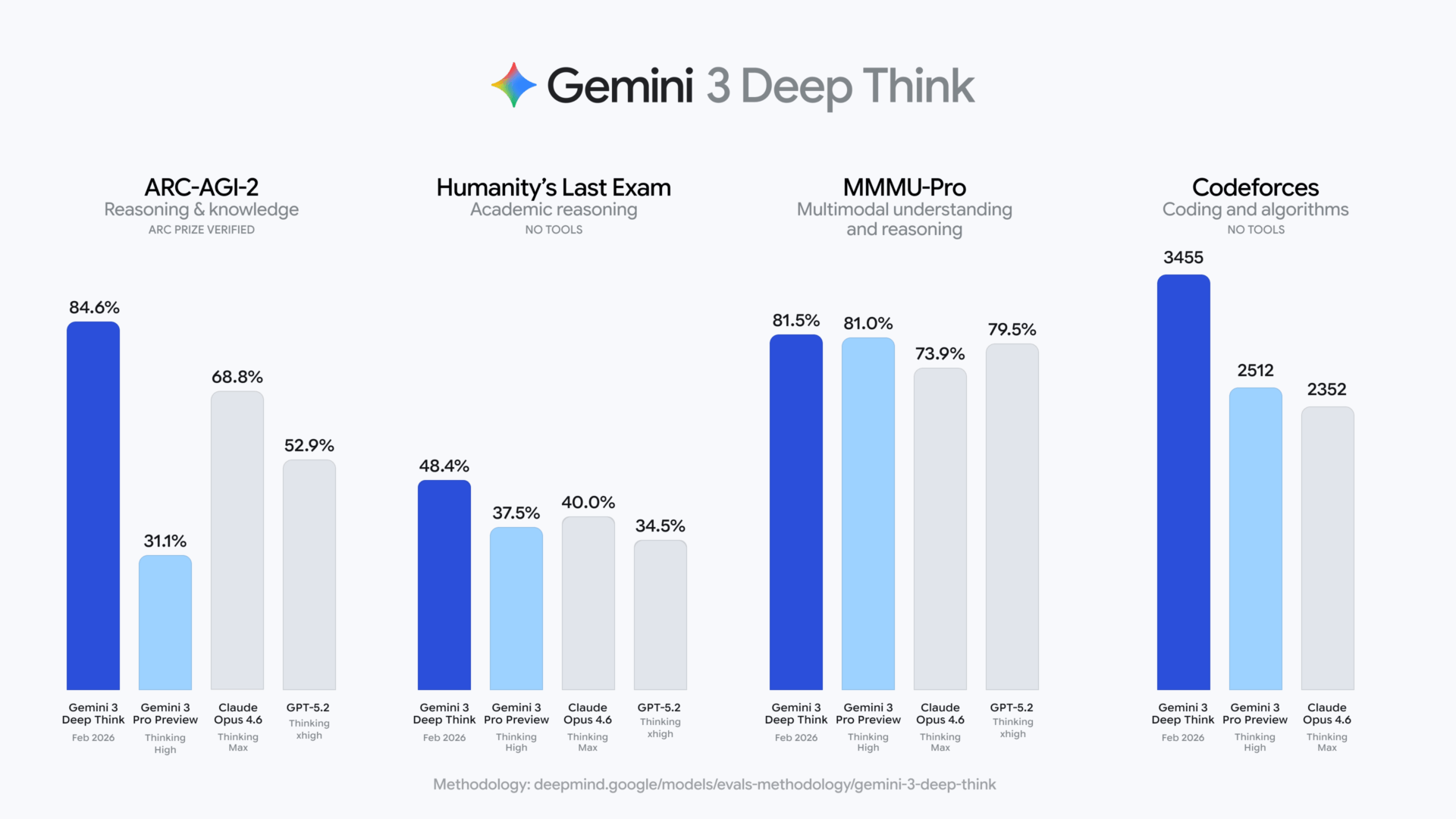

このモデルは、推論ベンチマーク「ARC-AGI-2」で84.6%という驚異的なスコアを記録した。

人間の平均正答率が約60%であるこのテストで、AIが人間を大幅に上回ったのは初めてのことだ。

わずか2ヶ月前(2025年12月)のDeep Think初回リリース時には45.1%だったスコアが、ほぼ2倍に跳ね上がっている。

本記事では、今回のアップデートで何が変わったのか、各ベンチマークの意味、競合モデルとの比較、そして実際にDeep Thinkを試す方法までを整理する。

そもそもGeminiの「Deep Think」とは何か

Deep Thinkは、Gemini 3 Proに搭載された「特殊推論モード」である。

通常のGeminiが汎用的なチャットや文章生成を得意とするのに対し、Deep Thinkは数学・科学・エンジニアリングなど、複雑な問題を深く考えて解くことに特化している。

技術的には「System 2」思考と呼ばれるアプローチを採用している。

人間にたとえると、暗算で瞬時に答えを出す(System 1)のではなく、紙とペンを使ってじっくり考える(System 2)ような思考スタイルだ。

Deep Thinkは以下の3段階で動作する。

- 問題分解: 与えられた問題をサブ問題に分割する

- 並列解探索: 複数の解法を同時に探索・評価する(たとえば動的計画法、貪欲法、グラフ理論的アプローチを並列に試す)

- 検証と出力: 論理的整合性やエッジケースを自己検証してから、最終回答を生成する

ここで重要なのが、Deep Thinkの核心技術である「推論時計算スケーリング(inference-time compute scaling)」だ。

従来のAI性能向上は、モデルを大きくする(パラメータを増やす)方向が主流だった。

Deep Thinkはそれとは異なり、回答前の「考える時間」に割り当てる計算量を増やすアプローチを採る。モデルそのものを巨大化するのではなく、推論にかけるリソースをスケールさせることで、より深い思考を実現しているのである。

「初見で解く力」で人間超え、科学・コーディングでも首位独走

主要ベンチマークの結果を、それぞれ「何を測っているのか」を含めて整理する。

「初見の問題を解く力」で人間の平均を大幅に上回る

今回最もインパクトがあるのはARC-AGI-2のスコアだ。ARC-AGI-2は、Kerasの生みの親Francois Cholletが考案した、AIの「本当の知能」を測るためのベンチマークである。

パターンの暗記では解けない未知の視覚パズルに対し、背景のルールを推論して正答を導く——つまり「初見で解く力」が問われる。

従来のAIモデルは20%前後で苦戦していた。人間の平均正答率が約60%であるところ、Deep Thinkの84.6%はARC Prize Foundationの検証を経た数値であり、人間の平均を大幅に上回る。競合のClaude Opus 4.6(68.8%)に対しても15.8ポイント差と、リードは大きい。

コーディングから理論物理まで、全領域で競合をリード

Deep Thinkの強みは抽象推論だけではない。競技プログラミングのCodeforcesではElo 3,455——「Legendary Grandmaster」(人間のプログラマーのごく一部しか到達できない領域)に相当する。

Gemini 3 Proの2,512、Claude Opus 4.6の2,352と比べて頭ひとつ抜けている。

| ベンチマーク | Deep Think (2月) | Deep Think (12月) | Gemini 3 Pro | Claude Opus 4.6 | GPT-5.2 |

|---|---|---|---|---|---|

| ARC-AGI-2 | 84.6% | 45.1% | 31.1% | 68.8% | 52.9% |

| Humanity’s Last Exam (ツールなし) | 48.4% | 41.0% | 37.5% | 40.0% | 34.5% |

| Codeforces (Elo) | 3,455 | — | 2,512 | 2,352 | — |

| 国際数学オリンピック 2025 | 81.5% | ゴールド | 14.3% | — | 71.4% |

| 国際物理オリンピック 2025 | 87.7% | — | 76.3% | 71.6% | 70.5% |

| 国際化学オリンピック 2025 | 82.8% | — | 69.6% | — | 72.0% |

| CMT-Benchmark (理論物理) | 50.5% | — | 39.5% | 17.1% | 41.0% |

科学領域での伸びも著しい。2025年の国際物理オリンピック(筆記)で87.7%、国際化学オリンピック(筆記)で82.8%と金メダルレベルのスコアを達成。

理論物理の専門ベンチマーク「CMT-Benchmark」でも50.5%を記録し、Claude Opus 4.6の17.1%やGPT-5.2の41.0%を大きく上回った。

唯一拮抗しているのが、専門家が「AIには解けない」意図で作成した学術横断テスト「Humanity’s Last Exam(HLE)」だ。

Deep Thinkはツールなしで48.4%(ツール併用で53.4%)、Claude Opus 4.6がツール併用で53.1%と僅差であり、広範な学術知識が問われる領域ではまだ一強とは言えない。

10年来の未解決予想を覆す「研究の相棒」

ベンチマークの数字だけでは伝わらないのが、Deep Thinkが実際の研究現場でどう使われているかという点だ。

GoogleのDeepMindは、2月11日にDeep Thinkによる科学研究の成果を2本の論文として発表している。

数学の未解決問題を「自力で」解くエージェント

なかでも注目すべきは、Deep Thinkを基盤に構築された数学リサーチエージェント「Aletheia」だ。

Aletheiaは単なる計算の高速化ツールではない。問題を解き、自分で答えを検証し、間違っていればやり直す。「この問題は解けない」と判断を下すこともできる。数学者の試行錯誤そのものを模倣しているのである。

その成果がすさまじい。Erdosの未解決予想データベースから700問を評価し、4つの未解決問題を自律的に解いた。そのうちの一つは、2015年に提示されて以来10年間、誰も証明も反証もできなかった予想だ。Aletheiaはこれを反例の構成によって覆した。

人間の数学者が10年かけても決着をつけられなかった問題を、AIが自力で解いた。研究論文の自律生成にも成功しており、「AIが数学の研究者として機能する」という段階に入りつつある。

査読エラーの発見から3Dプリントまで

応用は純粋数学にとどまらない。

ラトガース大学の数学者Lisa Carbone氏は、高エネルギー物理学に関する数学論文のレビューにDeep Thinkを使い、人間の査読者が見落としていた論理的欠陥を発見した。査読済みの論文からAIがエラーを見つけるという事例は、研究の品質保証のあり方そのものに影響しうる。

デューク大学のWang Labでは、半導体材料の結晶成長プロセスの最適化に活用し、従来の手法では達成が難しかった100μm超の薄膜成長レシピの設計に成功している。

より身近な例もある。Deep Thinkは手描きのスケッチから3Dプリンター用のファイルを生成できる。ラフな絵を描くだけで物理的なオブジェクトの出力までAIが橋渡しする。Google公式ブログにデモが掲載されているので、確認してみてほしい。

Deep Thinkを実際に試す方法

Geminiアプリで使う(Google AI Ultra加入者向け)

Deep Thinkを最も手軽に試せるのは、GeminiアプリからGoogle AI Ultraプラン経由で利用する方法だ。

- 料金: 月額$250(約37,500円)。Deep Thinkの利用に追加料金はかからない

- 手順:

- Geminiアプリを開く

- プロンプトバーから「Deep Think」を選択する

- モデルドロップダウンで「Gemini 3 Pro」を選ぶ

- 複雑な問題を入力して送信する

- 回答が準備されると通知される(通常数分かかる)

月額$250は一般ユーザーにとっては高額だが、数学や科学の研究者、ソフトウェアエンジニアにとっては、Legendary Grandmasterレベルのコーディング能力や金メダルレベルの科学的推論に常時アクセスできると考えれば、投資に見合う可能性はある。

Gemini API経由で使う(開発者向け・Early Access)

今回のアップデートで、初めてDeep ThinkがGemini API経由で利用可能になった。ただし現時点ではEarly Access Program(申請制)での提供であり、一般公開時期は未定である。

押さえておきたいのは、Deep Thinkは独立したモデルではなく、Gemini 3 Proの推論モードであるという点だ。API料金もGemini 3 Proの価格体系がそのまま適用される。

モデル自体は同じで、「考える時間」に使われる思考トークンが出力トークンとしてカウントされる分だけコストが上がる仕組みである。

- 料金: Gemini 3 Proと同一

- 入力: $2.00 / 100万トークン(200kトークン以下のプロンプト)

- 出力: $12.00 / 100万トークン(思考トークン含む)

- 推論の深さ制御:

thinkingLevelパラメータでlowまたはhighを指定できる

2ヶ月でスコア倍増—加速するLLMの進化

今回のアップデートで最も注目すべきは、個々のベンチマークスコアよりも進化の速度だろう。わずか2ヶ月前に45.1%だったARC-AGI-2が84.6%にほぼ倍増している。

推論時計算スケーリングというアプローチが有効であることが実証された以上、この方向での改善はまだ続くはずだ。

ただし、今のDeep Thinkの恩恵を直接受けるのは限られた層であると思われる。

数学や物理の研究者、競技プログラミングレベルの難問に取り組むエンジニアには明確な武器になりそうだ。

一方、日常的なチャットや一般的なコーディング支援においては、Deep Thinkと競合モデルの差はさほど大きくない。月額$250のGoogle AI Ultraも、その用途では割に合わないだろう。

筆者としては、Deep Thinkの真の意義は「人間超え」のスコアそのものよりも、この進化速度にあると考える。

10年来の未解決予想を覆し、査読済み論文のエラーを見つけ、半導体材料のレシピを設計する——こうした「玄人向け」の成果が出始めているということは、AIが科学技術の進歩を加速する未来の一端を見せてくれる。

研究者や高度な問題解決を日常的に行うエンジニアであれば、Google AI Ultra(月額$250)またはGemini APIのEarly Access Programから試してみる価値はあるだろう。

一般ユーザーは、Ultraに課金してまで使うべきかは微妙なところだ。