2026年2月12日、中国のAIスタートアップ「Z.ai」が、新世代の大規模言語モデル「GLM-5」をリリースした。

GLM-5は、Claude Opus 4.5やGPT-5.2に肉薄するほどの性能を持ちながら、オープンウェイトで誰でもモデル本体をダウンロードして無料で使えてしまう。

ベンチマークスコアを見ると、SWE-bench Verified(実際のGitHubバグ修正で測るコーディング指標)で77.8%を記録し、Claude Opus 4.5の80.9%に、わずか3.1pt差まで迫った。

Web情報の検索・統合を測るBrowseCompでは75.9と、Claude(67.8)やGPT-5.2(65.8)を引き離し、クローズドソースモデルを含む全モデル中1位だ。

これだけの性能を持ちながら、MITライセンスのオープンウェイトで、API利用の場合も価格はClaude Opusの約6分の1と圧倒的に低価格である。

しかも、GLM-5は、Claude Codeのモデルとして使用する裏技も存在する。大幅に安い価格で、コーディングエージェントをほぼ使い放題となるメリットもある。

本記事では、GLM-5の性能・ベンチマーク・価格を競合モデルと比較しつつ、今すぐ無料で試す方法をまとめていく。

GLM-5の概要:744Bパラメータの巨大オープンウェイトモデル

GLMシリーズは、中国・清華大学からスピンオフして設立されたAIスタートアップで開発されている大規模言語モデルだ。オープンソースで、モデル自体が公開されており、高性能なGPUがあれば誰でもダウンロードして利用できる。

GLMシリーズは4.5、4.6、4.7と進化を重ねてきたが、今回のGLM-5はアーキテクチャ自体が刷新された初のメジャーアップデートとなる。

なにはともあれ、GLM-5のすごいところは、ChatGPT, Gemini, Claudeなどの代表的な商用モデルに肉薄するほどの高い性能だ。

GLM-5のベンチマーク:分野によってClaude, GPT, Geminiすら超える

コーディング・エージェント・推論の各分野から代表的なベンチマークを抜粋し、主要なクローズドソースモデルと比較する。

| ベンチマーク | GLM-5 | Claude Opus 4.5 | GPT-5.2 | Gemini 3.0 Pro |

|---|---|---|---|---|

| SWE-bench Verified(コーディング) | 77.8% | 80.9% | 80.0% | 76.2% |

| SWE-bench Multilingual(多言語コーディング) | 73.3% | 77.5% | 72.0% | 65.0% |

| BrowseComp(Web情報の検索・統合) | 75.9 | 67.8 | 65.8 | 59.2 |

| Vending Bench 2(長期経営シミュレーション) | $4,432 | $4,967 | $3,591 | $5,478 |

| HMMT Nov. 2025(数学コンペ) | 96.9 | 91.7 | 97.1 | 93.0 |

| GPQA-Diamond(大学院レベル科学) | 86.0 | 87.0 | 92.4 | 91.9 |

SWE-benchは実際のGitHubリポジトリのバグ修正で測る実践的な指標であり、この水準のスコアを出せるオープンソースモデルはこれまで存在しなかった。

ClaudeやGPTのAPIに頼らずとも、十分に実用レベルのコーディングを任せられるモデルが手元に置ける時代になったということだ。

エージェント性能も見逃せない。Web上の情報を検索・統合する能力を測るBrowseCompでは75.9を記録し、Claude Opus 4.5(67.8)やGPT-5.2(65.8)を大きく引き離して全モデル中1位。

また、「Vending Bench 2」という一風変わったベンチマークは、AIに500ドルの初期資金を与えて自動販売機ビジネスを1年間経営させるシミュレーションで、仕入れや価格設定、不測のトラブル対応など数千回の意思決定を通じて長期的な判断力を測る。GLM-5はオープンソースモデルとして最高の$4,432を記録した。

数学コンペのHMMTではGPT-5.2に肉薄する96.9を記録した一方、大学院レベルの科学問題(GPQA-Diamond)ではGPT-5.2やGeminiに5〜6pt差をつけられている。推論性能は分野によって得手不得手がある。

第三者評価で裏付けられた性能、そして圧倒的に低いハルシネーション率

前セクションのベンチマーク値はZ.ai公式の発表に基づくものが多いが、AI分析機関Artificial Analysisによる独立評価でも、GLM-5の高い性能が裏付けられている。

| 指標 | GLM-5のスコア | 備考 |

|---|---|---|

| Intelligence Index | 50 | オープンウェイトモデルとして初の50到達 |

| Agentic Index | 63 | オープンウェイト1位、全体3位 |

| AA-Omniscience(ハルシネーション) | -1 | 全モデル中で最低のハルシネーション率 |

| LM Arena(テキスト) | 1452 | オープンウェイト1位(全体11位) |

中でも注目すべきはハルシネーション率だ。AA-Omniscience Indexでスコア-1を記録し、Google、OpenAI、Anthropicのモデルを含む全モデル中で最も低い値を達成している。

前世代のGLM-4.7から35ptもの改善が見られ、「嘘をつきにくいモデル」としてはトップクラスだ。

高性能でありながらAPI価格が圧倒的に安い

GLM-5のAPI価格を、主要なクローズドソースモデルと比較する。

| モデル | 入力(/100万トークン) | 出力(/100万トークン) | 合計コスト目安 |

|---|---|---|---|

| GLM-5 | $1.00 | $3.20 | $4.20 |

| GLM-5-Code | $1.20 | $5.00 | $6.20 |

| GPT-5.2 | $1.25 | $10.00 | $11.25 |

| Claude Opus 4.5 | $15.00 | $75.00 | $90.00 |

入力トークンでClaude Opus 4.5の15分の1、出力トークンでは23分の1。GPT-5.2と比べても出力は約3分の1だ。キャッシュヒット時の入力価格は$0.20/100万トークンまで下がる。

この低価格を支えているのがMoE(Mixture of Experts)アーキテクチャだ。GLM-5は総パラメータ744Bの巨大モデルだが、256個の「エキスパート」と呼ばれるサブネットワークのうち、推論時に活性化されるのはわずか8個。アクティブパラメータは40Bに抑えられるため、巨大モデルの知識量を保ちつつ推論コストを低く抑えられる。

なお、GLM-4.7(入力$0.60 / 出力$2.20)やGLM-4.7-Flash(完全無料)といった下位モデルも引き続き提供されている。ライトな用途なら、無料のFlashモデルから試すのもありだろう。

「オープンウェイト」だから実現できる3つのメリット

GLM-5が単なる「安い中華モデル」にとどまらない重要性を持っている理由は、オープンウェイト(MITライセンス)で公開されている点にある。

ClaudeやGPTといったクローズドソースモデルでは得られない、明確なメリットがある。

- ローカルデプロイ: 自社サーバーやクラウド環境にモデルを配置すれば、機密データを外部APIに送信する必要がなくなる。金融機関や医療機関など、データを社外に出せない組織にとっては決定的な利点だ。

- ファインチューニングの自由度: 自社のデータやタスクに合わせてモデルを追加学習させ、特定の業務に最適化できる。クローズドソースモデルのAPIでは、こうしたカスタマイズには大きな制約がある。

- ベンダーロックインの回避: MITライセンスなので、将来的にZ.aiのAPI価格が値上げされたり、サービスが終了したりしても、モデル自体は手元に残る。

ただし、GLM-5のローカルデプロイには凄まじい量のVRAMが必要で、最低でも8基のH200またはH100 GPUが要求される。

個人での運用は現実的ではなく、企業やクラウド環境での利用が前提となる。FP8量子化版(約744GB)も公開されているが、それでも相当な計算資源が必要だ。

GLM-5を今すぐ無料で試す方法

GLM-5を手軽に体験するなら、以下の2つの方法がおすすめだ。いずれも無料で利用できる。

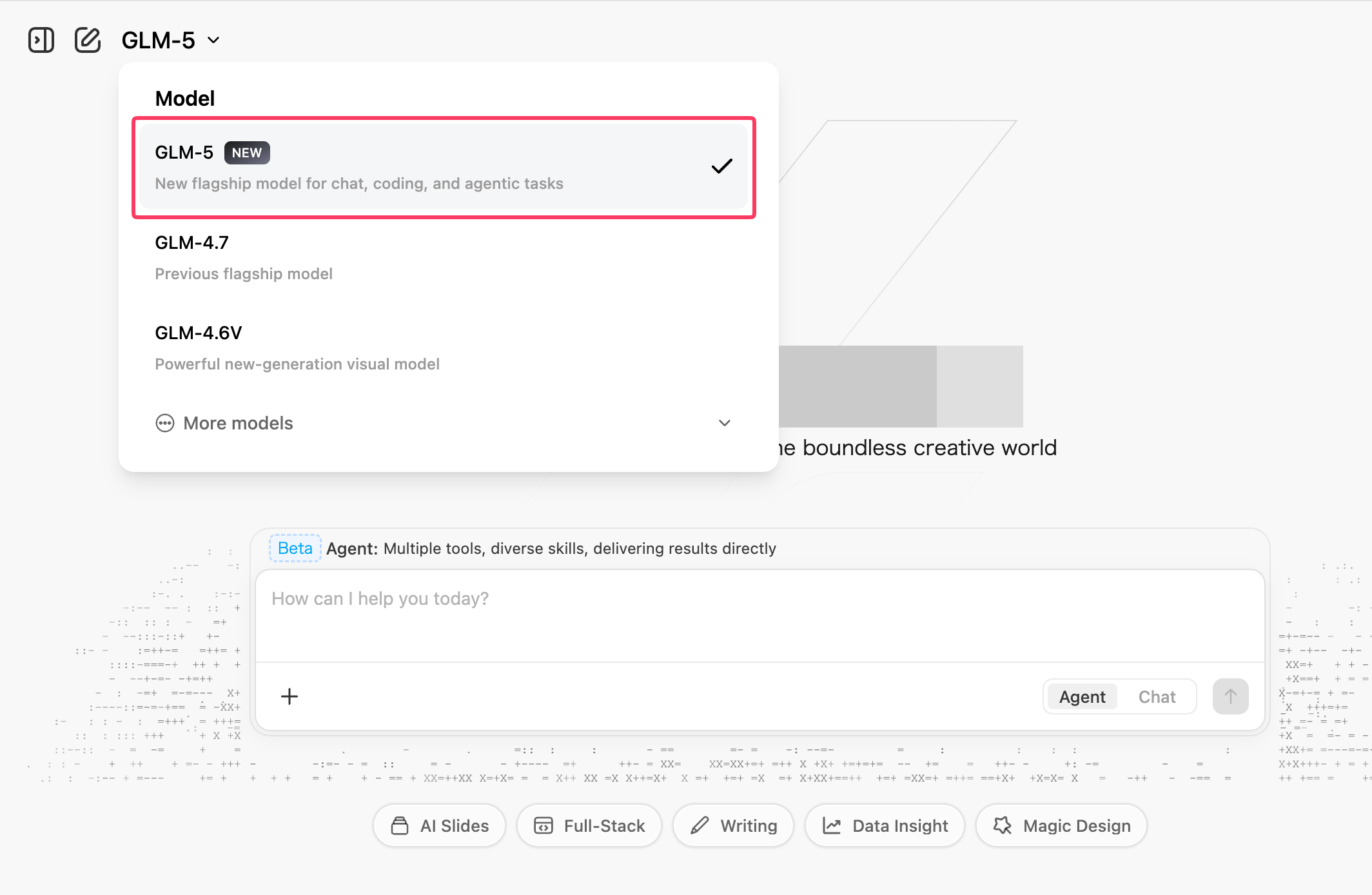

方法1:Z.aiの公式チャット(chat.z.ai)

最も手軽な方法は、Z.aiが提供する公式チャットインターフェース「chat.z.ai」だ。

アカウントを作成してログインしたら、モデル選択で「GLM-5」を選ぶだけで利用を開始できる。

chat.z.aiでは「Chatモード」と「Agentモード」の2つが用意されている。

Chatモードは通常のチャットで、質問に対してGLM-5がリアルタイムに回答を生成する。Agentモードでは、GLM-5がPDF・Word・Excelファイルを生成したり、より複雑なタスクを段階的にこなしたりできる。

たとえば「この資料をもとにPRD(製品要件定義書)をWord形式で作成して」といった指示にも対応するのは、従来のLLMチャットにはないユニークな機能だ。

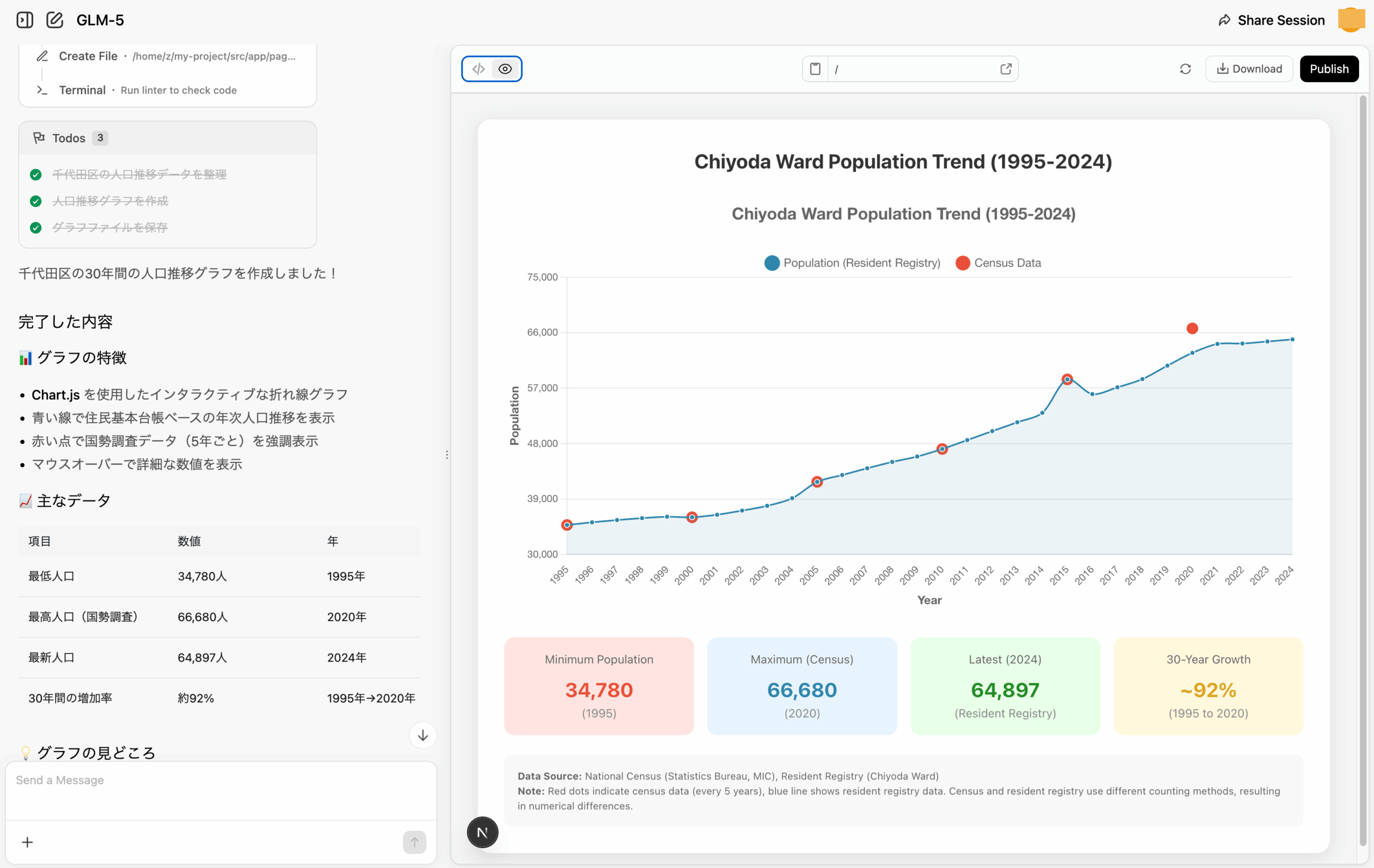

試しに、「千代田区の30年間の人口推移をグラフにして」とAgentモードで依頼してみると、ターミナルを立ち上げてデータを収集し、どんどん分析が進んでいく。

日本語が文字化けしているものの、最終的にいい感じの折れ線グラフが表示された。

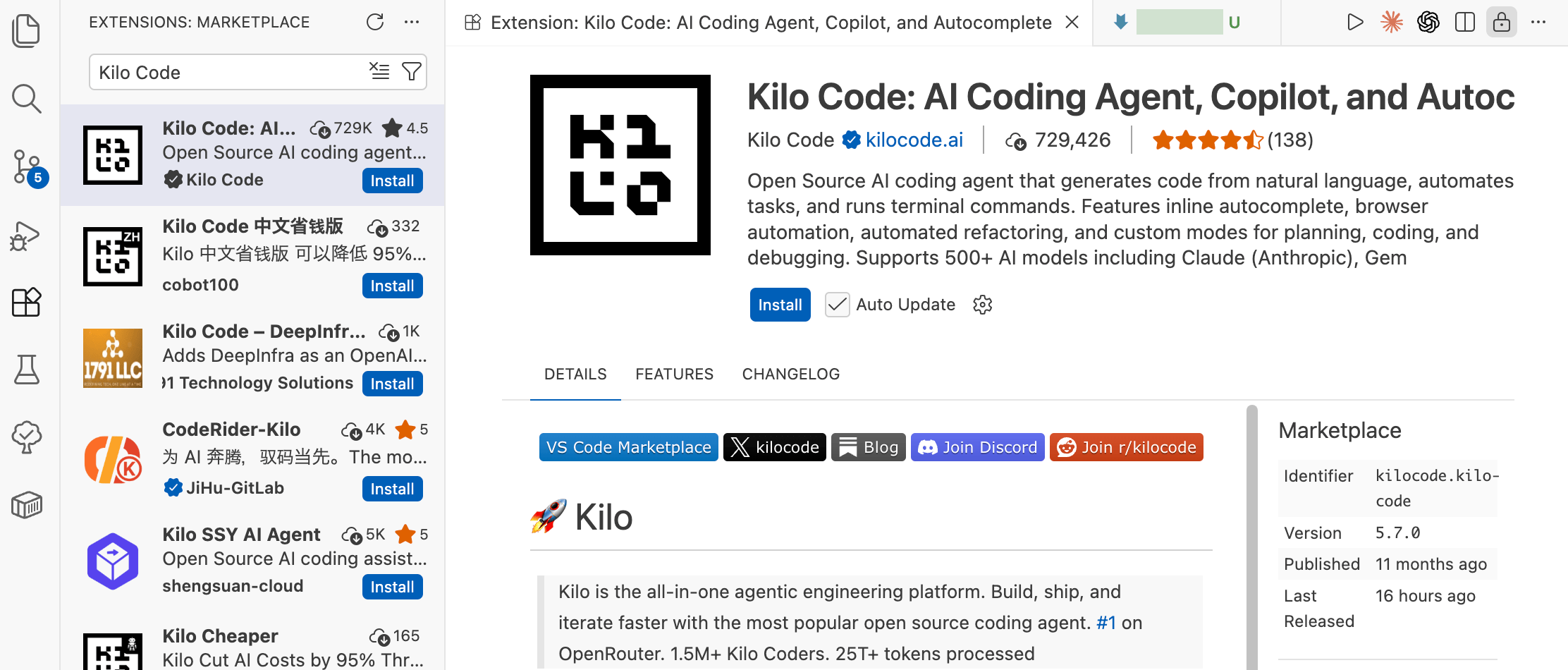

方法2:Kilo Code(VS Code拡張機能)で無料で使う

コーディング用途でGLM-5を試したいなら、VS Codeの拡張機能「Kilo Code」が便利だ。

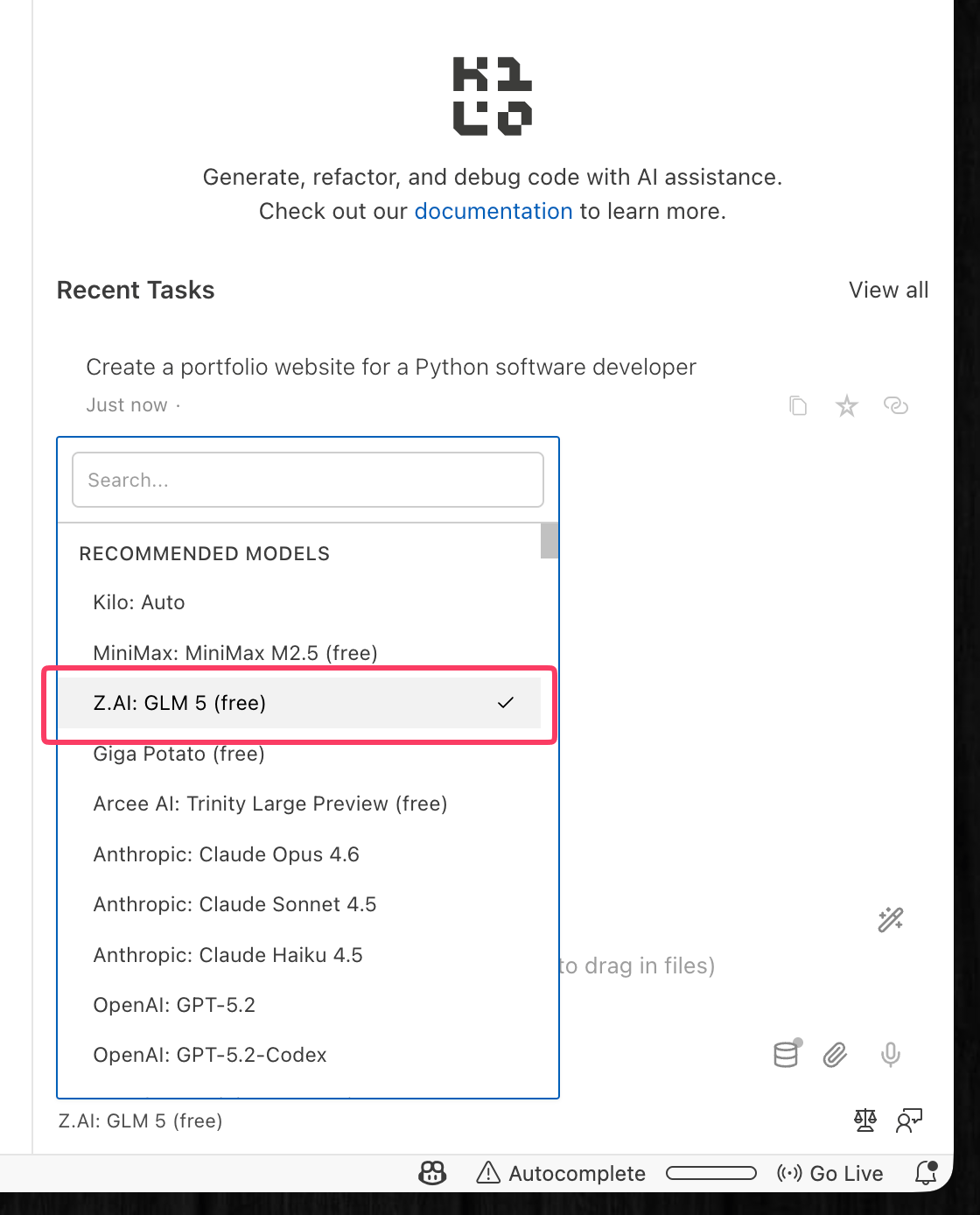

Kilo Codeは、元GitLab CEOのSid Sijbrandij氏が共同創業したオープンソースのコーディングエージェントだ。Claude、GPT、Geminiのほか、オープンソースモデルなど500以上のモデルに対応している。

Claude CodeやOpenAI Codexと同じような使い方が可能なエージェント型コーディングツールである。

このKilo Code上で、期間限定ながらGLM-5がAPIキー不要・サブスク不要で無料利用できる。

Kilo Codeは、AIモデルのプロバイダーと提携し、期間限定で無料モデルを提供することがある。Z.aiなどのプロバイダ側が推論コストを負担し、認知拡大を狙うプロモーション施策だ。

GLM-5も「期間限定(for a limited time)」と明記されているが、具体的な終了日は公表されていない。

無料期間が終了しても、自分のZ.ai APIキーを持ち込めば(BYOK: Bring Your Own Key)、Kilo Code上でGLM-5を引き続き利用できる。Kilo Codeの設定画面からZ.aiを選択してAPIキーを貼り付けるだけだ。

Z.aiの通常API料金(入力$1.00 / 出力$3.20 / 100万トークン)を払ったとしても、Claude Opus 4.6の数分の1の価格であり、無料期間終了後もコスパの高い選択肢であり続ける。

セットアップ手順

セットアップは非常にシンプルだ。

- VS Codeの拡張機能マーケットプレイスで「Kilo Code」を検索してインストール

- Kilo Codeのパネルが開いたら「Free models」を選択する

- モデル選択で「Z.AI: GLM 5 (free)」を選ぶ

これだけで、VS Code上でGLM-5にコードの生成・修正・レビューを依頼できるようになる。

方法3:API経由で利用する

より本格的な利用や、自作のアプリケーションにGLM-5を組み込みたい場合は、Z.aiのAPIを利用する。

Z.aiのAPI管理画面でアカウントを作成し、APIキーを発行する。OpenAI互換のAPIフォーマットを採用しているため、既存のOpenAI SDKやツールからエンドポイントとモデル名を差し替えるだけで利用できる。

Pythonでの利用例は以下の通りだ。

from openai import OpenAI

client = OpenAI(

api_key="your_zai_api_key",

base_url="https://api.z.ai/v1"

)

response = client.chat.completions.create(

model="GLM-5",

messages=[

{"role": "user", "content": "Write a Python function to sort a list"}

]

)

print(response.choices[0].message.content)実はClaude CodeからGLM-5を使うことも可能

意外と知られていないが、Claude Codeは裏側でAnthropicのAPIサーバーと通信しているだけなので、接続先のURLとAPIキーを差し替えれば、別のモデルをバックエンドとして利用できる。

Z.aiはClaude Code互換のAPIエンドポイントを提供しているため、設定ファイルを書き換えるだけでGLM-5に切り替えが可能だ。

~/.claude/settings.json に以下を記述する。

{

"env": {

"ANTHROPIC_AUTH_TOKEN": "your_zai_api_key",

"ANTHROPIC_BASE_URL": "https://api.z.ai/api/anthropic",

"API_TIMEOUT_MS": "3000000",

"ANTHROPIC_DEFAULT_OPUS_MODEL": "GLM-5"

}

}Z.aiは「GLM Coding Plan」というサブスクリプションプランも提供しており、Maxプラン(初月$30/月、通常$60/月)では現在GLM-5が利用可能だ。

Claude Code、Roo Code、Kilo Code、Clineなど20以上のコーディングツールに対応している。

元のClaudeモデルに戻したくなった場合は、~/.claude/settings.json から上記の "env" ブロック内の4項目(ANTHROPIC_AUTH_TOKEN、ANTHROPIC_BASE_URL、API_TIMEOUT_MS、ANTHROPIC_DEFAULT_OPUS_MODEL)を削除するだけでよい。

これらの環境変数が存在しなければ、Claude Codeは自動的にAnthropicの公式APIに接続し、デフォルトのClaudeモデルを使用する。設定変更後はClaude Codeを再起動すること。

米国サーバー経由で使いたい場合

Z.aiのAPIサーバーは中国にあるため、プライバシー面が気になるという人もいるかもしれない。

GLM-5がオープンウェイトであることの利点は、米国でホストされたGLM-5を利用できる点も大きい。

例えば以下のサードパーティプラットフォームは、自社の米国インフラでGLM-5をホストしている。

- OpenRouter(300以上のモデルを単一APIキーで切り替え可能なアグリゲーター。GLM-5とClaudeを同じプロジェクトで併用したい場合に便利)

- DeepInfra(FP8量子化版を提供。Artificial Analysisの比較でGLM-5の全プロバイダー中最低レイテンシ・最安値を記録。入力$0.80 / 出力$2.56)

- Together AI(米国発のオープンソースモデル特化プラットフォーム。ファインチューニングにも対応しており、GLM-5を自社データで追加学習したい場合の選択肢になる)

GLM-5の知っておくべき注意点と弱点

GLM-5は間違いなく強力なモデルだが、万能ではない。現時点で把握されている注意点を整理しておく。

まず、推論速度はやや遅い。Z.ai自身も「計算リソースをフル稼働させている」と公言しており、需要に対してGPUの供給が追いついていない状況のようだ。特にリリース直後は、APIのレイテンシが気になる場面もあるかもしれない。

また、出力が冗長となる傾向も指摘されている。第三者評価機関のArtificial Analysisの評価では、GLM-5がIntelligence Index測定中に約1.1億トークンを生成したと報告されており、平均的なモデルの1,400万トークンと比較してかなり多い。簡潔な回答が欲しい場面では、プロンプトで出力長を制御する工夫が必要だろう。

コーディング性能の評価もマチマチだ。Hacker Newsのスレッドでも開発者の評価は割れており、「かなり感心した。推論もツール使用もよくできている」という声がある一方で、「自分のベンチマークではダメだった。カスタムツール呼び出しのフォーマットに全く従ってくれない」「6ヶ月前のAnthropicモデルのような印象」といった報告も見られる。タスクの種類や使い方によって体感品質に差が出やすいモデルと言えそうだ。

また、画像入力(ビジョン)には対応していない。マルチモーダル機能が必要な場合は、Kimi K2.5やGemini 3.0 Proなど他のモデルを検討する必要がある。

コンテキストウィンドウは200Kトークンで、GPT-5.2の400Kトークンと比べると半分だ。超長文のドキュメント処理が必要な用途では、この差がボトルネックになり得る。

中国と米国の差、オープンとクローズドの差は縮まっている

GLM-5は、Huaweiチップだけで学習された初のフロンティアモデルだ。

米国の輸出制限により、NVIDIAの最先端チップを入手できない中で、世界最高水準のオープンソースモデルを完成させたことは、中国のAI産業にとって一つの転換点と言えるだろう。

また、オープンウェイトモデルとクローズドソースモデルの性能差が、再び縮小しているとも言えよう。

SWE-bench VerifiedでClaude Opus 4.5との差がわずか3.1pt。BrowseCompではClaude・GPTを含む全モデルを上回って1位。ハルシネーション率でも全モデル中最低。これが、MITライセンスで誰でも無料で使えるオープンウェイトモデルの実力だ。

API価格もClaude Opusの数分の1で、コスト面でも大きな優位性がある。

一方で、推論速度の遅さ、出力の冗長さ、ビジョン非対応など、現時点では弱点もある。

万能の「Claude/GPTキラー」というよりは、「特定の領域ではトップクラスの性能を発揮する、コスパ最強のオープンウェイトモデル」というのが現時点での正確な評価だろう。

chat.z.aiで無料で試せるし、Kilo Codeなら期間限定で無料のコーディングエージェントとしても使える(無料期間終了後もAPIキーを持ち込めば継続利用可能だ)。

まずは自分の手で触ってみて、その実力を確かめてみてほしい。