2025年7月は、Qwen3, GLM-4.5, Kimi K2 など、脅威的な性能を持つオープンソース・オープンウェイトモデルの新リリースが、中国のAI開発企業から相次いだ目まぐるしい一ヶ月だった。

中でも「Qwen3」モデルファミリーは、中国アリババグループのAlibaba Cloudが開発するオープンソースの大規模言語モデルである。

2025年4月末に最初のモデル群がリリースされたQwen3だが(c.f. 当サイトでも4月リリースをまとめた記事を公開)、2025年7月中に、さらに6つの新たなモデルがリリースされた。

Qwen3 の7月の一連のリリースでは、まずは従来から存在したモデル(235B / 30B)について、性能が改善した7月版(Instruct / Thinking)がリリースされた。

また、全く新しいモデルとして、プログラミング・コーディングに特化した、シリーズ最大の4,800億パラメータにも及ぶ特大モデル「Gwen3-Coder」がラインナップに加わった。

ざっくり新たな6モデルを分類すると、以下のようになる。

- 新・プログラミング特化版

- Qwen3-Coder-480B-A35B-Instruct – 7/22登場 (4800億パラメータ)

- Qwen3-Coder-30B-A3B-Instruct – 7/31登場 (300億パラメータ)

- 汎用モデルの改善版(推論モード)

- Qwen3-235B-A22B-Thinking-2507 – 7/25登場 (2350億パラメータ)

- Qwen3-30B-A3B-Thinking-2507 – 7/30登場 (300億パラメータ)

- 汎用モデルの改善版(推論モードなし)

- Qwen3-235B-A22B-Instruct-2507 – 7/21登場 (2350億パラメータ)

- Qwen3-30B-A3B-Instruct-2507 – 7/29登場 (300億パラメータ)

すべてのQwen3モデルは、Apache 2.0ライセンスの下で公開されており、商用環境であっても自由に使用・デプロイすることができるのが大きなメリットだ。

本記事では、Qwen3の一連のリリースの中でも、特にコーディングアシスタントとしての実用性の高さや、オープンソースモデルのSOTAとして重要性の高い「Gwen3-Coder」「Qwen3 Coder Flash」につき深掘りして紹介する。

Qwen3 Coder:オープンソース史上最高のコーディング特化モデル

Qwen3 Coderは、プログラミングの能力に特化して学習することで、コーディングアシスタントとして、モデルサイズに対して非常に高い性能を獲得している。

オープンソースという特性上、Qwen3の公式はもちろん、他のクラウド企業が独自に高速なQwen3 CoderのAPIを提供したり、コーディングIDEに組み込んで提供したりと、Qwen3の登場がエコシステム全体を活性化している。

Claude 4 Sonnet / GPT-4.1 に並ぶベンチマークスコア

アリババによる公式リリース内で、コーディング分野の主要なベンチマークテストについて、AnthropicのClaude 4 SonnetやOpenAIのGPT-4.1などとの比較表が公開されている。

SWE-benchは、GitHubの実在のバグに基づいて作られたコーディングエージェントの能力を測るベンチマークだ。多くのベンチマークで、Claude 4 Sonnet 僅差か、または上回っていることがわかる。

コーディングアシスタントとして根強い人気を誇るClaude 4 Sonnetにここまで肩を並べる性能を持つAIモデルが、オープンソースで、GPUさえあれば無料で利用できてしまうのは中々衝撃的な進歩である。

| Benchmark | Qwen3 Coder (480B) | Claude 4 Sonnet | OpenAI GPT-4 .1 |

|---|---|---|---|

| Terminal-Bench | 37.5 | 35.5 | 25.3 |

| SWE-bench Verified — w/ OpenHands 500 turns | 69.6 | 70.4 | – |

| SWE-bench Verified — w/ OpenHands 100 turns | 67.0 | 68.0 | 48.6 |

| SWE-bench Live | 26.3 | 27.7 | – |

| SWE-bench Multilingual | 54.7 | 53.3 | 31.5 |

| Multi-SWE-bench mini | 25.8 | 24.8 | – |

| Multi-SWE-bench flash | 27.0 | 25.0 | – |

| Aider-Polyglot | 61.8 | 56.4 | 52.4 |

| Spider2 | 31.1 | 31.1 | 16.5 |

また、ブラウザ使用、ツール呼び出しといった「エージェント能力」系を測定する各種ベンチマークでも、Claude 4 Sonnetと肩を並べている印象である。

| Benchmark | Qwen3 Coder (480B) | Claude 4 Sonnet | OpenAI GPT-4 .1 |

|---|---|---|---|

| WebArena | 49.9 | 51.1 | 44.3 |

| Mind2Web | 55.8 | 47.4 | 49.6 |

| BFCL-v3 | 68.7 | 73.3 | 62.9 |

| TAU-Bench Retail | 77.5 | 80.5 | – |

| TAU-Bench Airline | 60.0 | 60.0 | – |

実際、様々なAIモデルのAPIサービスを提供しているOpen Routerが公開している「プログラミング」分野での使用量ランキングでも、Qwen3 Coderは、Claude Sonnet 4に次ぐ人気となっている。

ベンチマークテストの数値上の評価だけでなく、実際にコーディングアシスタントとして実用している人からの評判もいい証拠だ。

※2位にある「Horizon Alpha」は、7月30日に登場した正体不明のコミュニティモデル。OpenAIなどの次世代クローズドモデルと噂されている。

ちなみに、公式リリース内では、他にKimi-K2やDeepSeek V3などのオープンモデルとの比較も行われているが、Qwen3 Coderが概ね圧勝している。

同性能で価格は3分の1!圧倒的に安いAPI価格

効率化しているといっても、4800億パラメータ(MoEにより活性化するのは350億パラメータ)と大型なので、流石に個人レベルのPCで実用的なスピードで動かすのは難しい。

実際には、開発元であるアリババクラウドの公式APIサービスや、他社がオープンソースのモデルをホストするAPIサービスを利用することになるだろう。

アリババクラウドのAPI価格は、公式ドキュメントによれば、以下の通りだ。

| Input token count | Input price (1Mトークン) | Output price (1Mトークン) |

|---|---|---|

| 0-32K | $1 | $5 |

| 32K-128K | $1.8 | $9 |

| 128K-256K | $3 | $15 |

| 256K-1M | $6 | $60 |

トークン数によって価格が変動するが、12.8万もの長大なトークンを送信することは中々ないであろうから、基本的にはインプットで$1〜1.8程度の価格帯だ。

Claude Sonnet 4の価格は、トークン数を問わず、インプット$3/アウトプット$15である。

Qwen3 Coderは、Sonnet 4と同等の性能を持ちながら、最大3分の1以下のコストで運用できることになる。

Qwen3 Coderを実際に使う方法

Qwen3を実際に使ってみる方法はいくつか存在するが、ここではアリババ公式の提供するWebアプリやAPIを使う方法と、さらに高速なサードパーティーのクラウドサービスで利用する方法を紹介する。

Web上のチャットUIで使ってみる

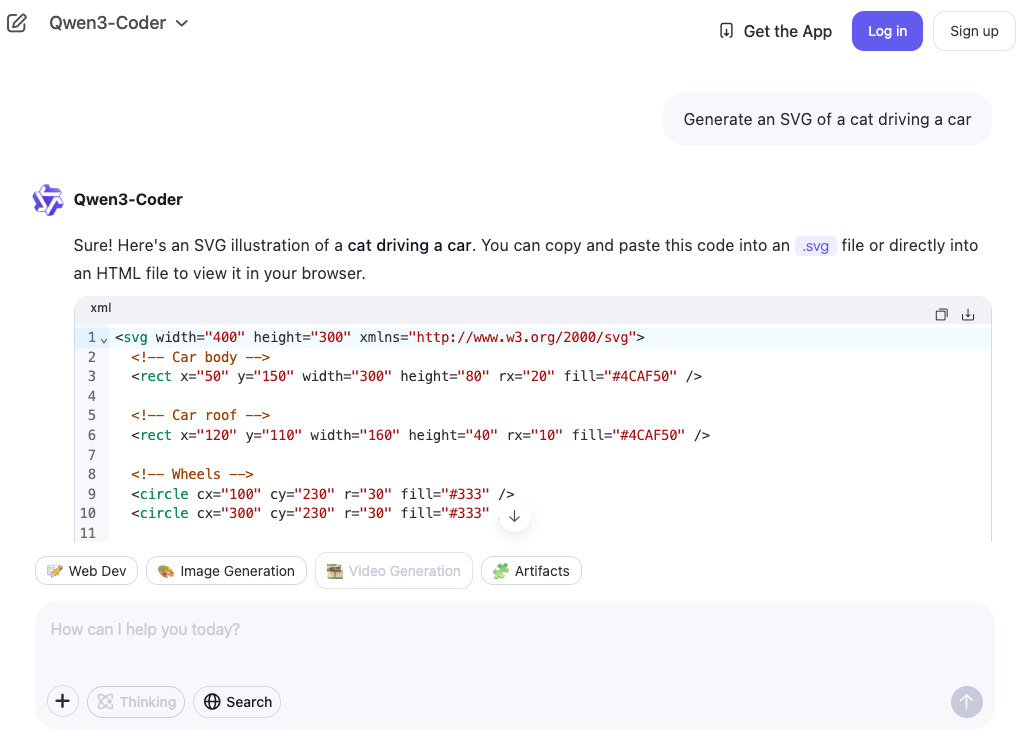

最も手軽なのは、ChatGPTのようなブラウザ上で動作するチャットUI「Qwen Chat」を利用することだ。

「Qwen Chat」では、Qwenの各モデルをプルダウンメニューで選んでチャットできるので、そこからQwen3 Coderも利用することができる。

会員登録すらも不要で、ブラウザ上で無料で利用することができる。履歴などを保存しておきたい場合には、ログインした方が便利だ。

とりあえず、車を運転している猫のSVGイラストをコーディングしてもらってみた。

非常に高速に動作して、サクサクとコードが生成されていく。

完成した猫のイラストは以下の通りで、結構ちゃんと描けている。

API経由でIDE/CLIツールのコーディングエージェントとして使う

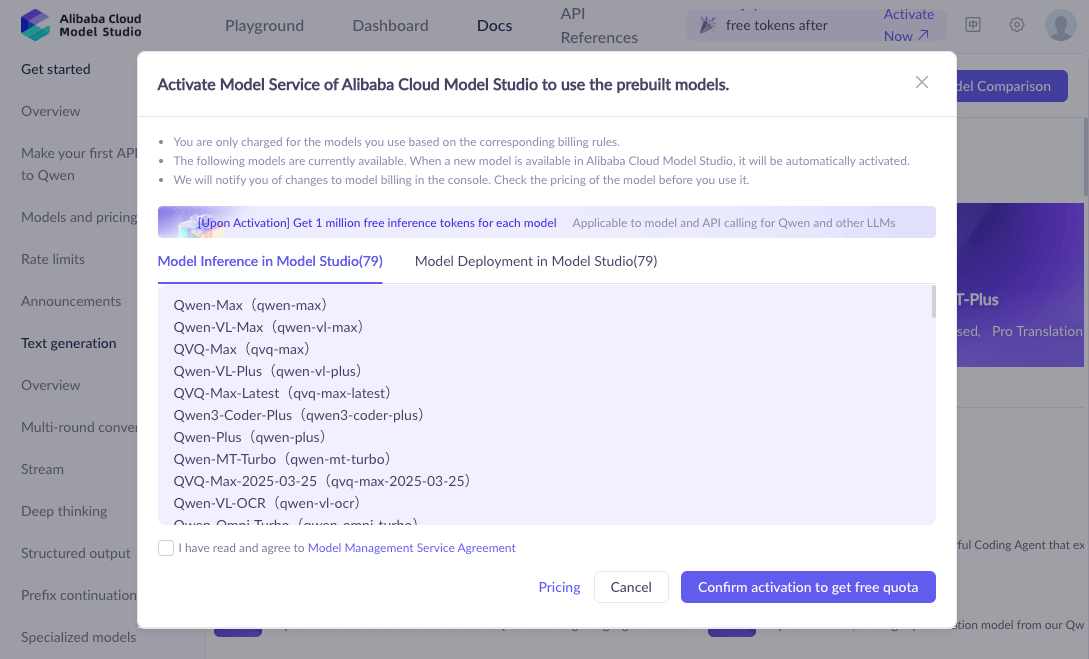

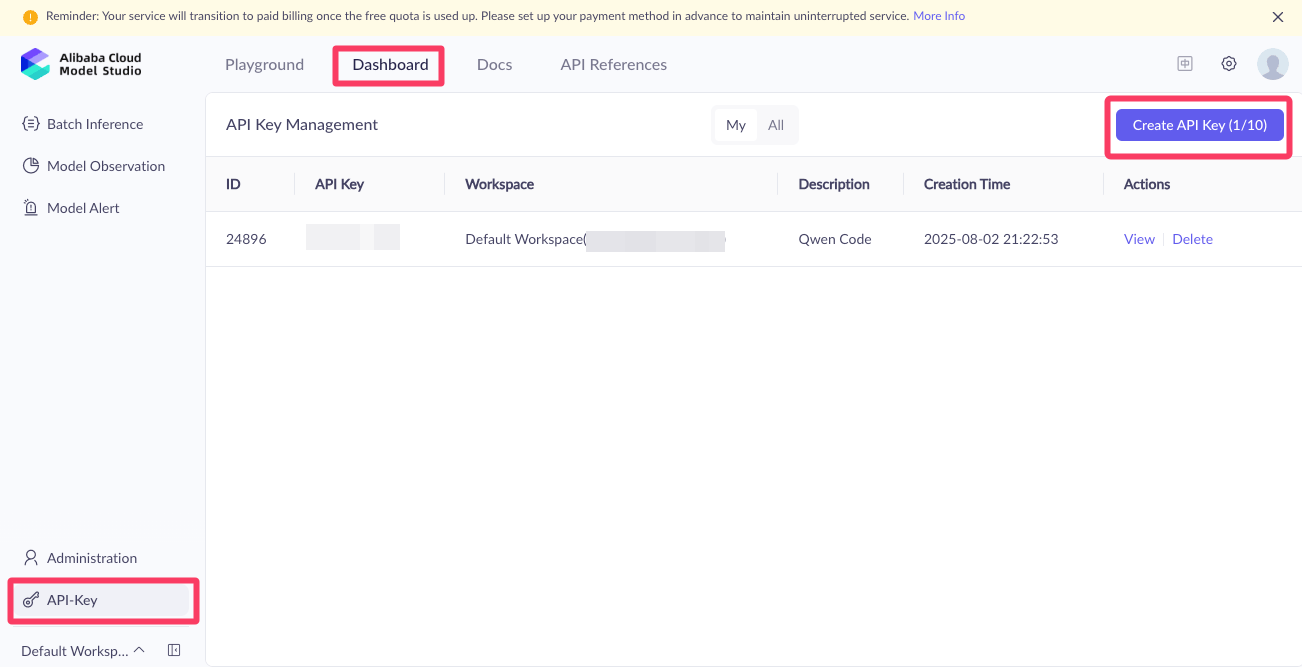

Qwenシリーズのモデルは、アリババクラウドのAPI経由で利用すると、会員登録時に各モデル100万トークンの無料枠がもらえる。

Qwen3のAPIは、OpenAI SDKに準拠・互換しているので、Claude CodeやClineなど、カスタムBase URLを設定可能なアプリであれば、あらゆるアプリ・ツールでQwen3 Coderを使用することができる。

せっかくなので、この機会にアリババクラウドに登録して、各モデルをAPI経由でも使ってみることを勧める。

無事に会員登録ができたら、ダッシュボードからAPIキーを新規作成できる。

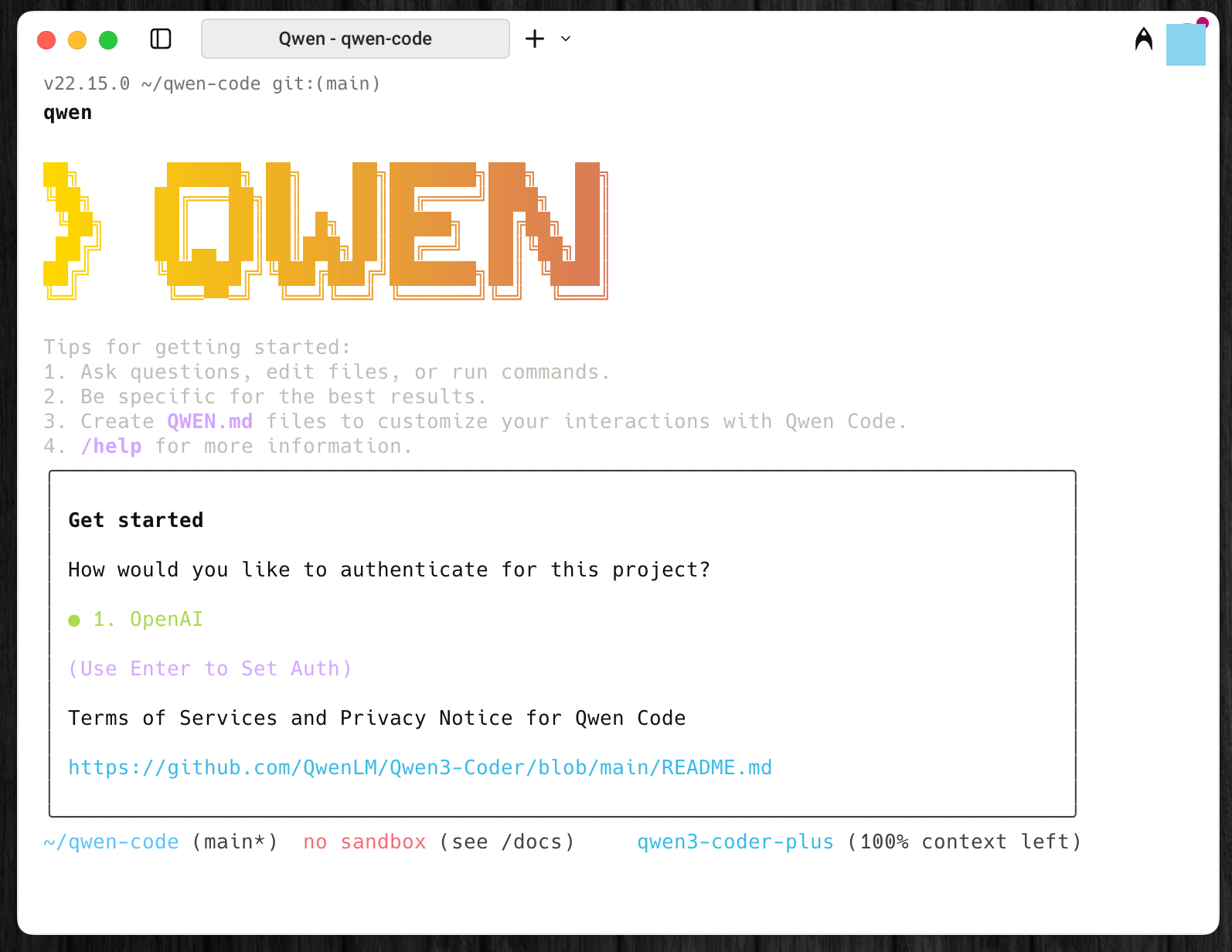

ちなみに、Qwen Coderのリリースに合わせて、アリババクラウド自身も、Gemini CLIからフォークした「Qwen Code」というCLIツールもリリースしている。

せっかくなので、Claude Codeではなく、公式のQwen Codeで使ってみることにする。

Qwen Codeのインストールは非常に簡単で、ターミナルで以下のように打ち込んでGitHub上にあるQwen Codeをインストールするだけだ。

git clone https://github.com/QwenLM/qwen-code.git

cd qwen-code && npm install && npm install -g次にアリババクラウドで作成したAPIキーを、ターミナルで以下のように打ち込み、環境変数として保存しておく。

export OPENAI_API_KEY="ここに自分のAPIキーをコピペ"

export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus"あとは、ターミナルでqwenと打ち込むだけで、以下のようにCLIツールのQwen Codeが起動する。

秒速2,000トークンという異次元の高速サービスも

Qwen3 Coderは、モデル自体が公開されており、商用利用も可能なので、アリババ以外の企業がホストしてAPIサービスを提供することも可能だ。

モデルリリースからわずか1週間強しか経っていないが、早速、Qwen3 Coderをクラウド上で提供するサービスが登場している。

中でも脅威的なパフォーマンスを誇っているのが、Cerebras Systemsが提供する「 Cerebras Code」である。

Cerebrasは、GPUよりも高速に機械学習が可能なAI専用のスーパーコンピューターをクラウドで提供する企業である。

「Cerebras Code」は、Qwen3 Coderを、秒速2,000トークンという脅威的な速度で利用可能にしたサービスで、月額50ドルの「Cerebras Code Pro」プラン、月額200ドルの「Cerebras Code Max」プランがある。

- Cerebras Code Pro : 月額$50、1日1,000メッセージ、目安として3-4時間の連続コーディング

- Cerebras Code Max : 月額$200、1日5,000メッセージ、目安として丸一日のフルタイムコーディング

実際に、Cerebras公式が、Clineでqwen-3-coder-480bを使用している様子の動画も公開しているが、そのコードの生成スピードは異次元の高速だ。

CursorやClineなど、どのようなIDEでも利用可能だ。

コーディングアシスタントを多用している人であれば、速度が上がれば生産性があがるのはほぼ間違いない。

アリババクラウドの公式APIの無料枠を使ってみて、生成されるコードの品質に満足できたら、Cerebras Codeを使ってみるのもアリだろう。

Qwen3 Coder Flash:32GB Macでも動く軽量版も登場

オープンソースモデルであるQwen3に最も期待したいのは、やはり自分のPCローカルで動くオフライン・コーディングエージェントとしての活躍だ。

そうは言っても、超大型モデルの「Qwen3-Coder-480B-A35B-Instruct」はフルサイズでは1TB近く、基本的に個人PCのメモリ上で動かすことは不可能だ。

そこに登場したのが、「Qwen3 Coder Flash」とも呼ばれている軽量・小型版のQwen3 Coderモデル「Qwen3-Coder-30B-A3B-Instruct」だ。

- プログラミング特化版Qwen3の種類

- Qwen3-Coder-480B-A35B-Instruct – 7/22登場 (4800億パラメータ)

- Qwen3-Coder-30B-A3B-Instruct – 7/31登場 (300億パラメータ)

ローカルLLM運用に最適なApple Silicon Mac

Apple Siliconを採用したMacは、ユニファイドメモリによってCPU・GPUがメモリを共有している(RAM=VRAM)。

通常は、大容量のVRAMを搭載した高額なGPUがなければ動かすことができないLLMだが、Macであれば、メモリ容量が大きいモデルを買うだけで、ローカルLLMを結構動かすことができてしまう。

ローカルLLMをMacに容易に導入できるアプリ「LM Studio」のQwen3 Flashのページを見ると、最も精度の低い4bit量子化(サイズ圧縮のようなこと)が行われたモデルは「17.19GB」しかないことがわかる。

ということは、32GB以上のメモリを積んだMacであれば動かすことが可能なので、Mac StudioやMacBook Proユーザーであれば、割と現実的ではないだろうか?

Qwen3 は MoE (Mixture-of-Expert) 構造で高速動作

Qwen3 Coderは、モデルを複数のエキスパートに分割し、クエリに応じて一部のエキスパートだけを活性化させる「MoE」という効率的なアーキテクチャを採用している。

例えば、「Qwen3-Coder-30B-A3B-Instruct」という名前は、全体では「300億」パラメータを持つが、アクティブになるのは「30億」パラメータだけ、ということを意味している。

モデル全体をメモリ上にロードしておくため大容量のメモリを消費するものの、活性化され使用されるのはその10分の1なので、動作自体は非常に高速なのがMoEモデルのメリットである。

筆者がメモリ16GBのMacBook AirでQwen3 1.7B(17億アクティブパラメータ)を実際に試してみた際には、かなりサクサク動作した。

Qwen3 Flashはアクティブパラメータ数が30億なので、メモリ容量さえ足りていれば、動作スピードは同じくサクサクのはずだ。

つまり、32GB以上のメモリを積んだハイスペックなMacを所有している人は、Qwen3 Flash(またはその量子化版)を、実用的なスピードでローカル環境で動かすことができる。