OpenAIは日本時間の2024年12月21日、新たなフロンティアモデル「o3」と「o3-mini」を発表した。

o3は非常に高度な知能を持つモデルで、難易度の高い推論を要するベンチマークテストで、他のモデルが到達したことのない異次元のパフォーマンスを示している。

これは、OpenAIの新製品・新機能発表のライブ配信シリーズ「12 Days of OpenAI」で発表されたものである。最終日である12日目たる本日、o2でもGPT-5でもなく、「o3」が登場することになった。

本記事では、驚異的な性能を示すo3, o3-miniについて、OpenAIのライブ配信中に紹介されたベンチマークスコアと、それらのスコアが意味することを紹介しながら、o3モデルへの期待をまとめる。

なお、他の12日間の発表内容の総まとめ・解説記事は、こちらのタグ「12 Days of OpenAI」から確認することができる。

OpenAI「o3」の概要とベンチマーク結果

前提として、o3, o3-miniはいずれも未リリースで、o3-miniが来年1月末からロールアウトされるという。現時点では、安全性の検証のため、専門家のみが参加できる評価プログラムの募集が行われている。

「12 Days of OpenAI」のライブ配信の中では、o3モデルと他のモデルを比較する様々なベンチマークテストの結果が紹介された。

o3は、コーディング、数学、推論などのタスクで、o1やGPT-4oなど従来のモデルを突き放す結果を示している。

我々自身はまだo3を手元で試すことができないが、以下、OpenAIによって紹介された各種ベンチマークと、その意味・解釈を詳細に解説していく。

o3のコーディングベンチマーク:人間の99.95%を超える

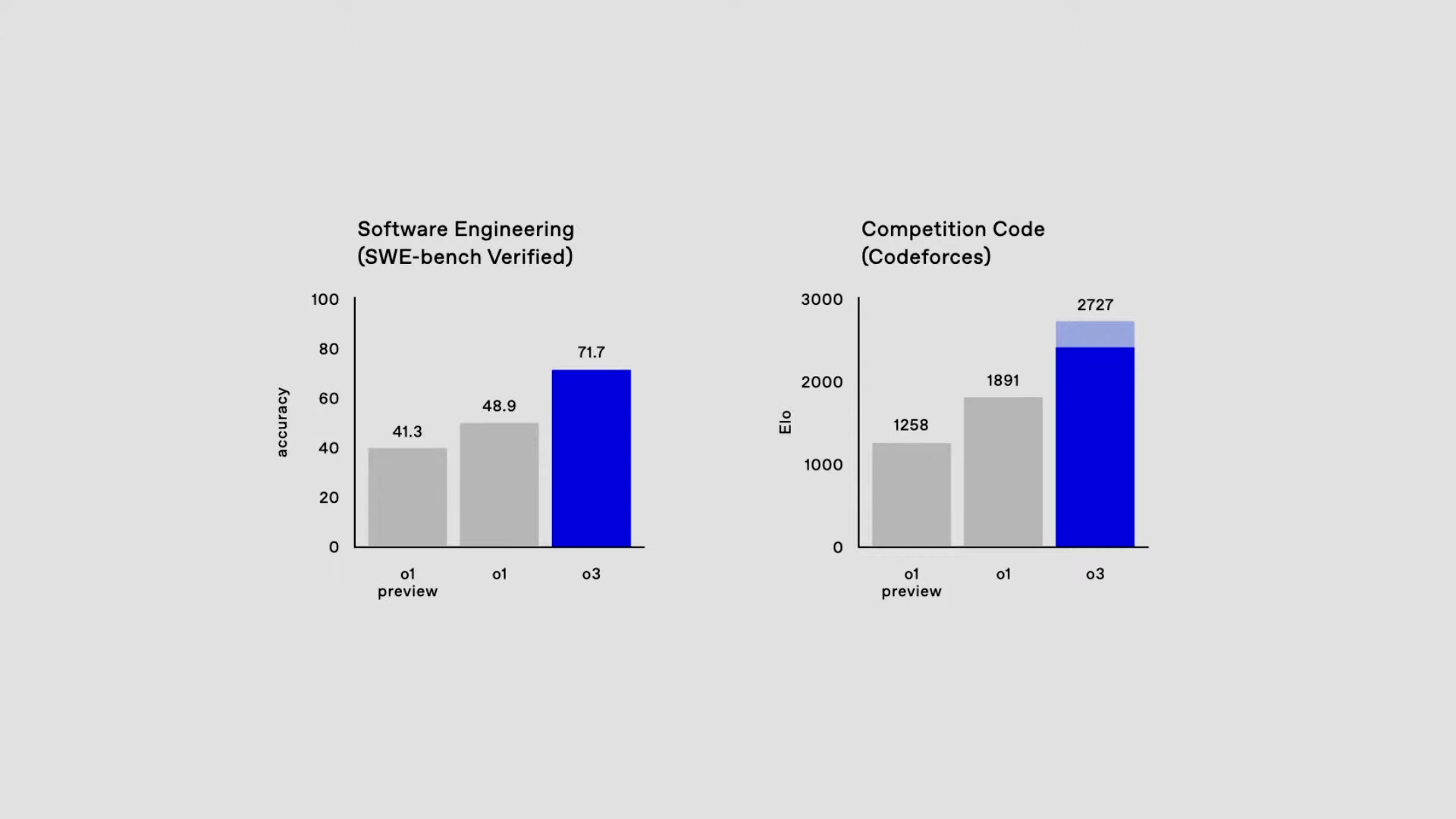

配信では、2つのコーディング関連のベンチマーク結果が紹介された。

現実世界のソフトウェアタスクからなるテストであるSWE-bench Verifiedと、競技プログラミングサイトCodeforcesでのレーティングの2点である。

o3は、SWE-bench Verifiedにおいて、71.7%の精度を達成した。

これは、前モデルのo1と比べて20%以上の改善になる。既にo1モデルも、プログラミング時に非常に役立つと評判であるところ、o3が登場すると、ソフトウェア開発の現場でAIに頼めることがもっと増えそうだ。

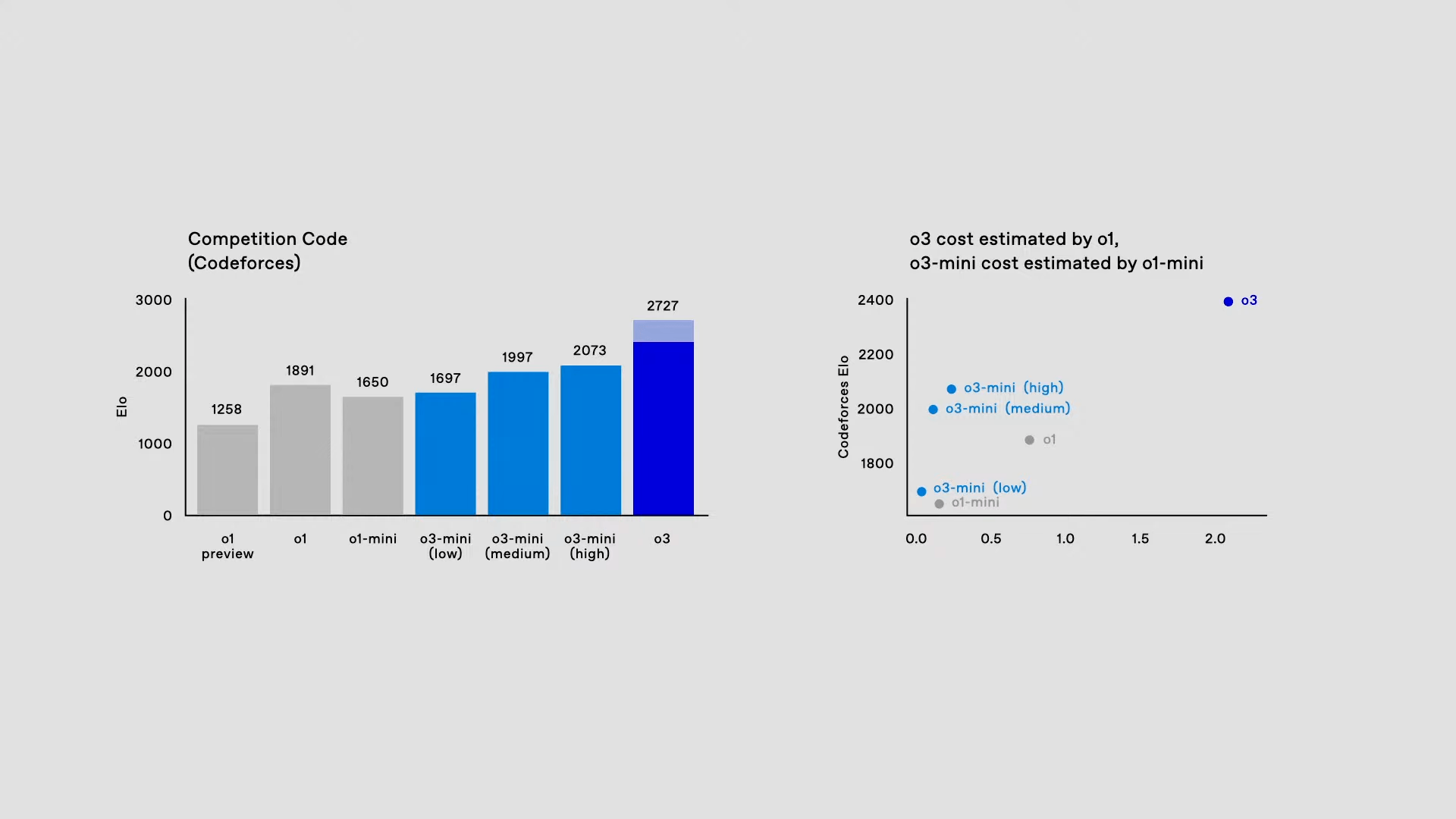

また、競技プログラミングサイトであるCodeforcesのスコア(ELOレート)において、o3は2727を達成した。これは、現在のモデルo1のELOレート1891を大幅に上回るスコアである。

ライブ配信に参加したOpenAIのMark Chen氏は、MIT卒の競技プログラマーで、彼のベストスコアは2500だという。2700台というのは、Codeforcesのパーセンタイル統計によれば、人間の99.95%を上回るスコアである。

OpenAIには3000台のスーパーコーダーもいるそうで、配信内では「あと数ヶ月は楽しめる」とのジョークも。まだギリギリ人間のトップオブトップのプログラマーの能力は超えていないが、既に大部分の人間のコーディング能力は超えてしまっているのだ。

o3の数学ベンチマーク:数学オリンピックも余裕

数学関連のベンチマーク結果として、アメリカ数学オリンピック予選の問題セットである「AIME2024」における正答率と、博士課程レベルの科学の問題セット「GPQA Diamond」の結果が紹介された。

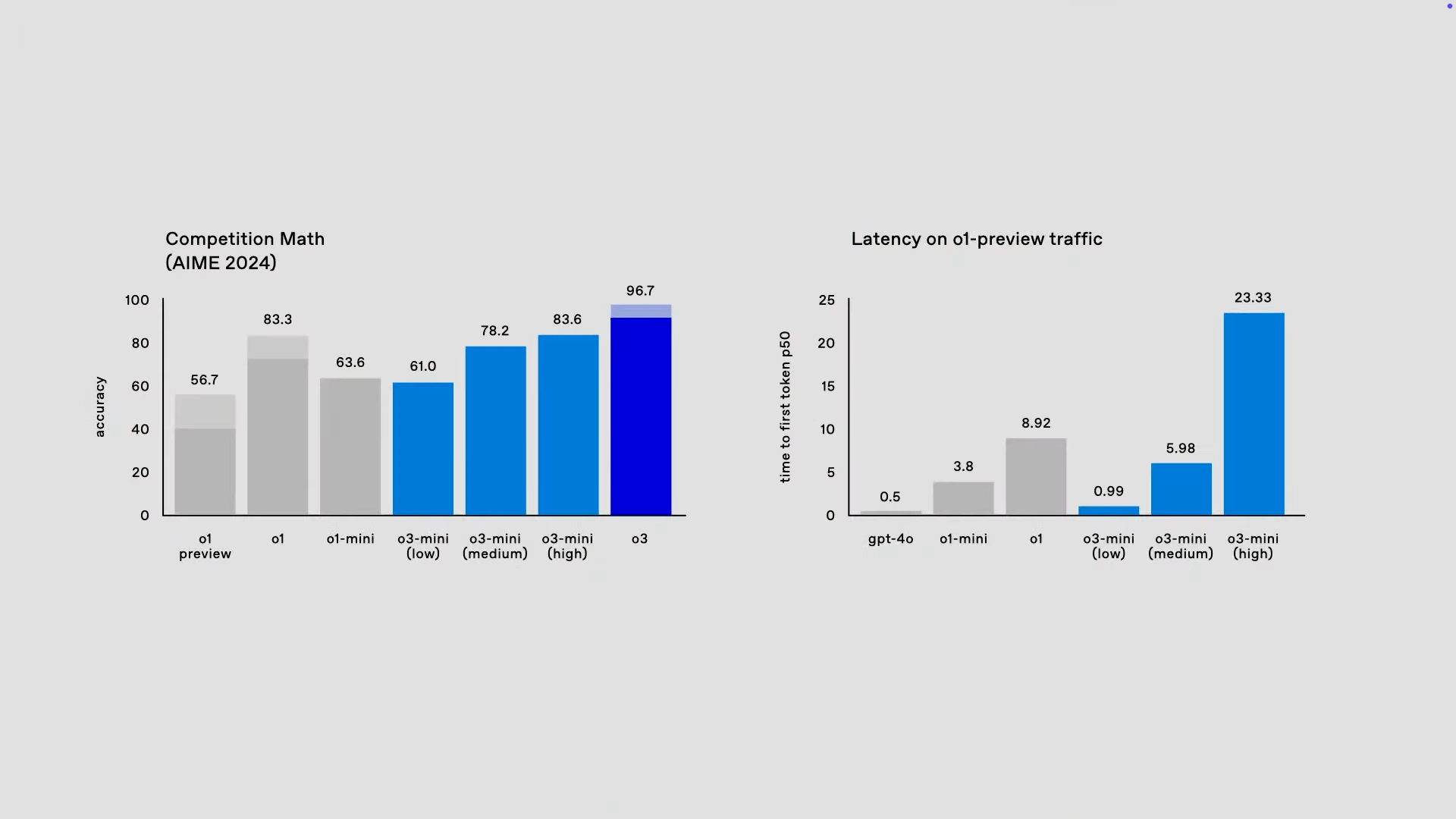

o3は、AIME 2024において、96.7%の正答率を達成し、o1の83.3%を大きく上回っている。

96.7%という水準は、アメリカ数学オリンピックの予選で、テストを受ける度に1問だけ間違える正答率ということである。

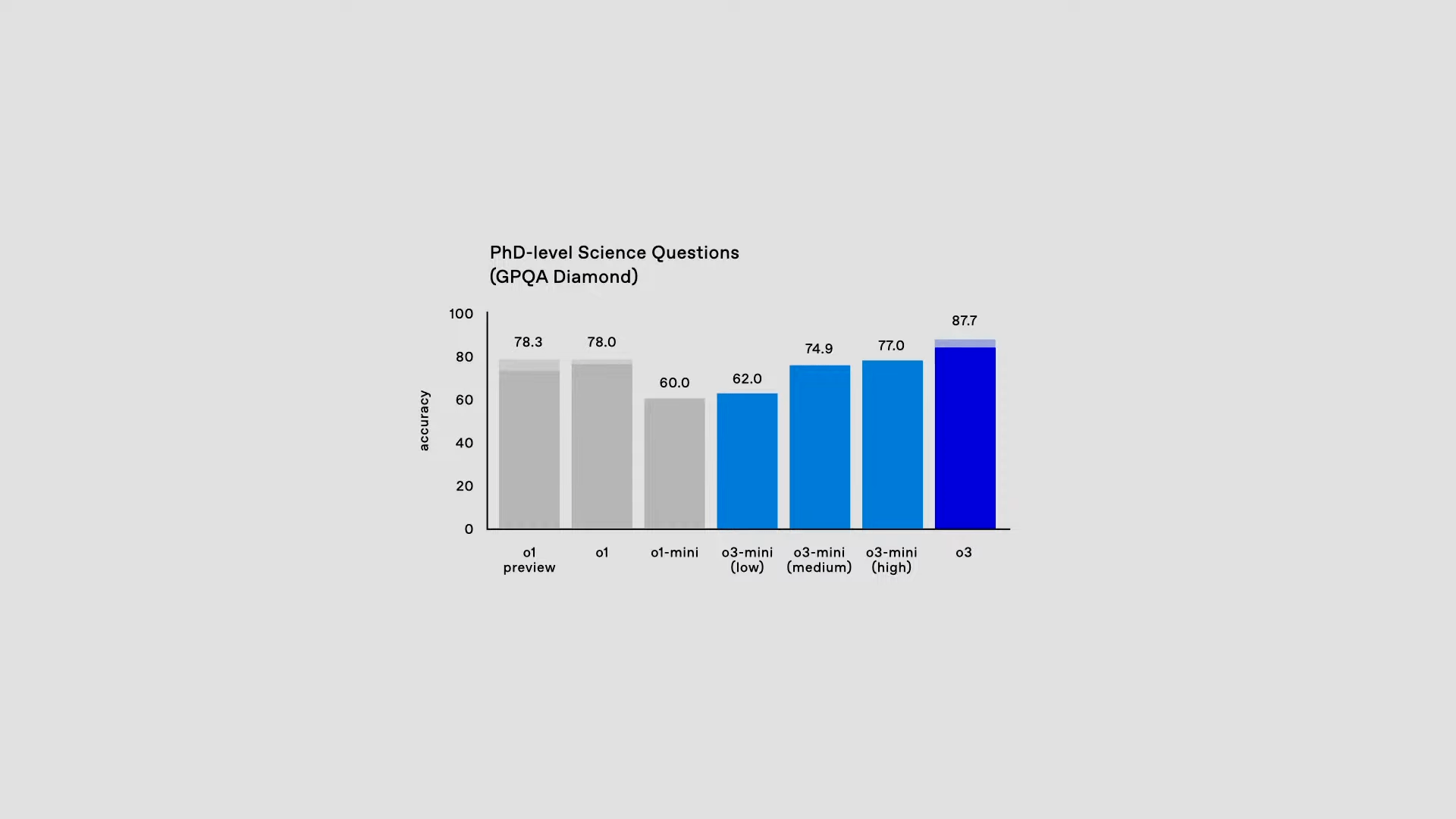

また、GPQA Diamondでは、o3は87.7%の正答率を達成し、これまた、o1の78%を約10%上回る結果となっている。

人間がGPQA Diamondに解答する場合、ある分野の博士号保有者が、自身の専門分野の問題に答えたとしても、通常は約70%の正答率に留まるとのことで、これもまた驚異的な性能である。

さらに、従来AIの評価にあまり使用されてこなかった、極めて高い難易度を持つテストである「EpochAI Frontier Math」というベンチマークの結果も紹介された。

「EpochAI Frontier Math」は、まだ公開されていない新しいベンチマークテストで、人間の数学者が取り組んだとしても、解くのに数時間から数日を要する非常に難しい問題群で構成されている。

o3の設定(高負荷モード〜低負荷モード)によってもスコアは変動するが、o3の最も高いスコアは、25.2%という驚異的な正答率を達成している。

これまで存在した全てのAIモデルは、このテストで2%未満の正答率しか出すことができておらず、o3のパフォーマンスは全く異次元の世界に到達していると言える。

未知の問題を解く「ARC-AGI」でもスコア上限を叩き出す

AI業界でよく使用されるベンチマークテストは、o1, o3の様なモデルの性能が高まりすぎたことで、スコアの上限に達しつつある。実際、上記で登場した「AIME2024」や「GPQA Diamond」は、ほぼ満点に近づいており、これ以上の性能の評価に使うことができない。

そこで、AGIクラスの超高性能なモデルを適切に評価するため、新しいベンチマークを開発する試みもいくつか行われている。

中でも、「ARC-AGI」は、2019年に米Googleの研究者であるFrançois Chollet氏によって開発されたベンチマークであり、汎用人工知能(AGI)のパフォーマンスの測定を目指すテストだ。

このベンチマークは、新たなスキルを即座に学習し、記憶していないタスクに対して、当意即妙に対応できるモデルの能力を測定するためのものだ。

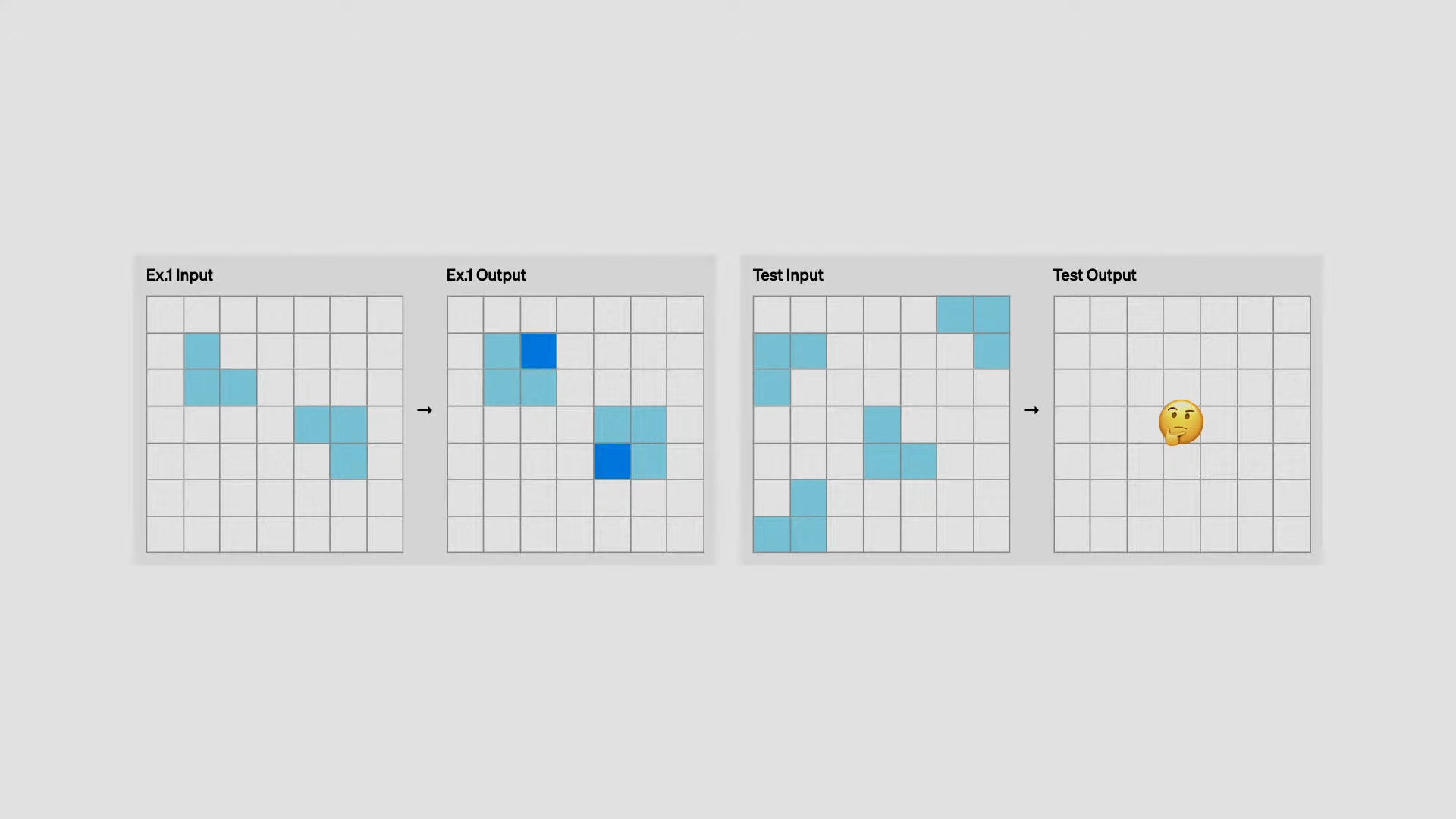

例えば、問題の例として紹介されたのが以下のクイズ。

左側で示されたインプットとアウトプットの関係を踏まえて、右側のアウトプットがどうあるべきかを予測する問題。人間であれば、欠けている角に濃い青を塗る、という回答が簡単に出せるが、AIモデルにとっては解くのが非常に難しいのだという。

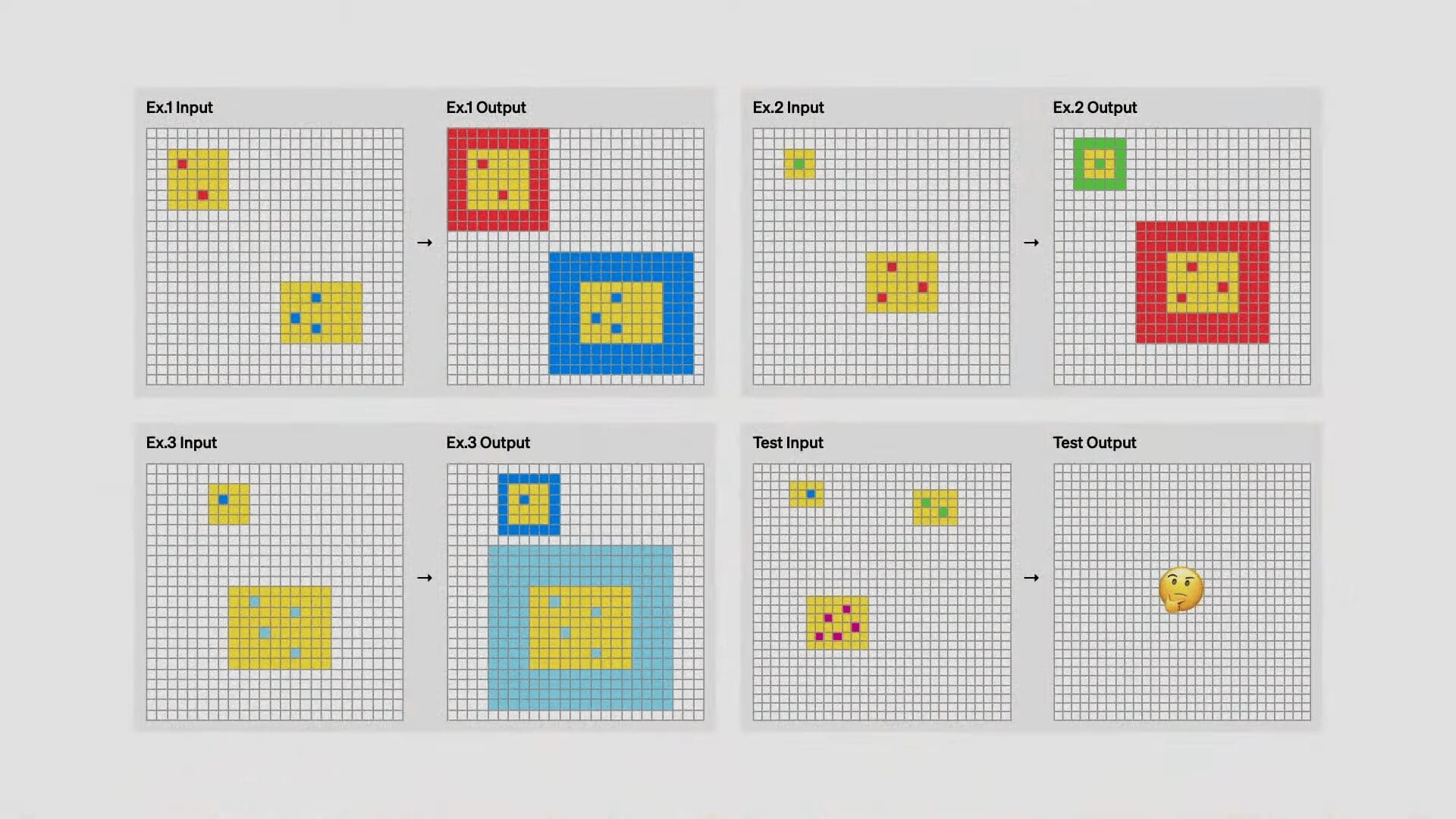

また別の問題では、以下の様なものもある。先ほどと同じく、示されたInput-Outputの例から、正解のOutputを考える問題だ。

答えは、黄色エリアの中にある別の色のパネル数を数え(ex. 赤セルが2個)、黄色エリアの周囲をその幅で囲う(ex 赤2行分の幅)というものだ。

これは先に示された例の「角を青くする」のとは、全く別のスキルが必要になる問題だ。

このように、ARC-AGIは、意図的にすべてのタスクが全く異なるスキルを要する問題群で構築されている。

ARC-AGIが目指すのは、すでに記憶している回答を引き出すのではなく、新しい課題を示された際に、即座に新しいスキルを学習する能力をテストすることであるからだ。

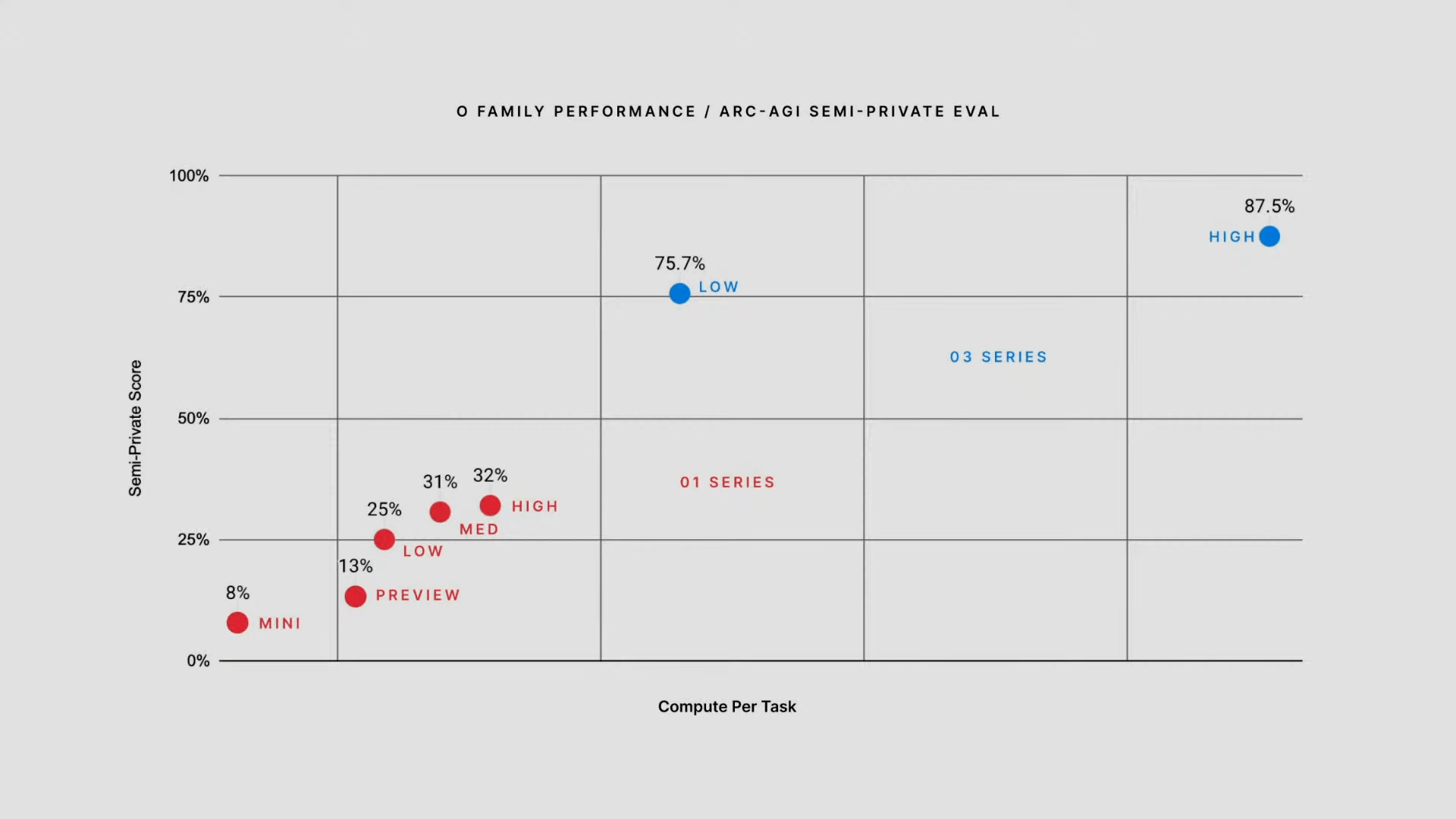

o3は、このARC-AGIで、低負荷設定で75.5%、高負荷設定で87.5%ものスコアを達成したという。以下のグラフの赤い点がo1モデルで、青い点がo3モデルである。

ARC-AGIに、人間の子どもが解答すると、85%〜100%のスコアになるという。

つまり、o3は、人間の知能のラインを超えるパフォーマンスを示しているということだ。

o3の登場により、ARC-AGIのスコアすら飽和状態になってしまうので、今後、ARCとOpenAIが共同して新しいベンチマークテストの開発に取り組むという。

o3モデルは計算コストも半端ないらしい

なお、OpenAIのライブ配信の中では触れられなかった点だが、ARC-AGIのテストスコアのプロットのX軸「Compute Per Task」とは、一体何を示しているのだろうか。グラフ内に単位も書いておらず、フワっとした指標だ。

その答えが、ARC財団がX上で公開したプロット画像に載っていた。こちらのプロットでは、OpenAIのライブ配信とは異なり、X軸を「計算コスト」として「USドル」の金額にしている。

これによれば、最も高スコアを出した「o3 (高負荷設定)」のARC-AGIの計算にかかったコストは、なんと1,000ドル(15万円)を超えている。

o3モデルが一般公開されても、このレベルの推論能力を備えた「高負荷設定」モデルは、一般の人には手の届かない価格帯になりそうだ。

とはいえ、各社とも新モデル発表のたびにAPI料金を引き下げ続けており、計算コストの削減が進めば、いつかo3の最高負荷のモデルも、現実的な価格帯で使える時も来るかもしれない。

OpenAI「o3-mini」の概要とベンチマーク結果

o3-miniは、o1-miniと同様に、o3よりも小型・高速で、非常にコストパフォーマンスが高いモデルである。

adaptive thinking timeとして、思考時間をカスタマイズすることが可能で、ユーザーは、低、中、高の3つのオプションを選択できる。

もちろん、思考時間が長ければ長いほど性能が上がり、費用も上がる。

ユースケースごとに思考時間を調整することで、複雑な問題にはモデルに長く考えてもらい、簡単なものには短く考えてもらう、ということが可能になる。

o3-miniのコーディングベンチマーク:o1をさらっと超える

先ほども登場した競技プログラミングサイトであるCodeforcesにおけるELOレートで、o3-miniのそれぞれのモデルは以下のスコアを記録している。

左図のスコアを見ると、

- o3-mini (low) : 1697

- o3-mini (medium) : 1997

- o3-mini (high) : 2073

中程度の計算負荷のo3-mini (medium)ですら、o1のスコアである1891を上回っている。

また、右図はコストとELOレーティングのトレードオフを示している。o3はELOスコアは非常に高いものの、o1と比べてコストが非常に高い。

一方、o3-miniは、コストをo1と同水準に抑えながら、o1よりも高いパフォーマンスを達成していることを示している。

ライブ配信中では、o3-mini (high) を使って、複雑なアプリケーションを作成するデモも示された。

このアプリは以下の様な機能を持つものだ。

- o3-miniにPythonを使ってコードジェネレーターとエグゼキューターを実装するように依頼

- このPythonスクリプトを実行すると、テキストボックスを含むUIを持つサーバーがローカルに起動

- テキストボックスに解決して欲しいタスクの概要を打ち込む

- o3-mini APIが呼び出され、タスクを解決するスクリプトを作成

- 自動的にスクリプトをローカルに保存し、ターミナルでそのスクリプトを実行

ライブ配信中に、非常に高速にコードが生成され実装されていく様子が示されていた。

o3-miniの数学ベンチマーク

コーディングのベンチマークに続き、アメリカ数学オリンピック予選を用いたベンチマークAIME 2024でも、o3-mini (high) が 83.6% と、o1を上回る性能を示している。

また、右図は回答までのレイテンシーを他のモデルと比較したもので、o3-mini (low) のスピードは推論モデルですらないGPT-4oに近い水準で、瞬時に近い回答が可能だという。

また、先ほども登場した博士課程クラスの科学問題セットのGPQA Diamondでも、o3-mini (high) はo1に匹敵する性能を示している。

o3-miniは関数呼び出し、構造化出力なども網羅

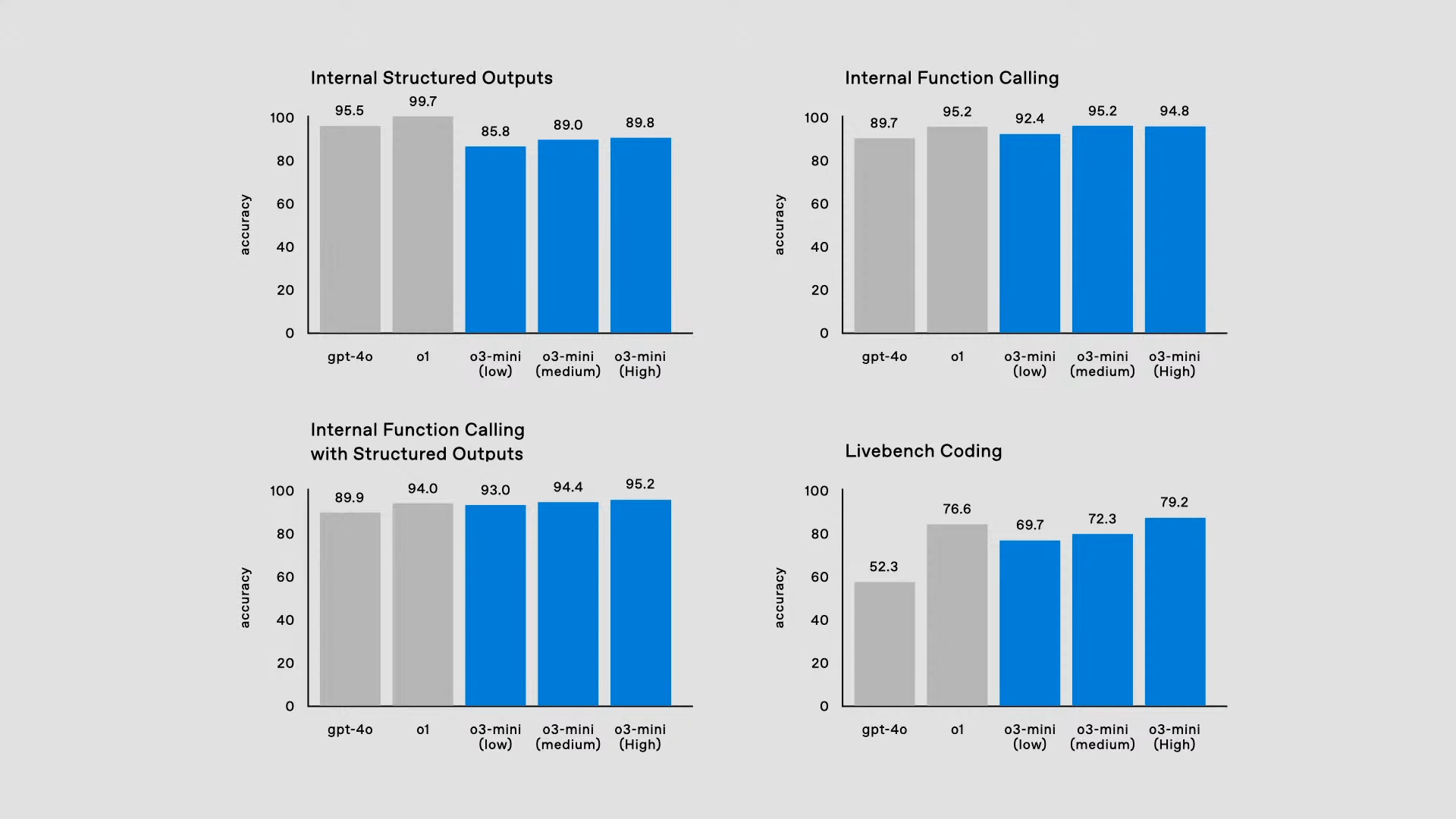

o3-miniは、関数呼び出し、構造化出力など、APIの機能を完全にサポートするという。

これにより、開発者はよりコスト効率が高く、また性能も優れたソリューションを利用することができるようになる。

「Deliberative Alignment」の導入

ユーザーから悪意のあるプロンプトが与えられた時に、安全か安全でないかの判断を行うために、通常は、単に良い例・悪い例をたくさん学習することによって、AIモデルがこの判断ラインを設定する。

この様な従来型のアプローチだと、複雑な状況で誤った判断をすることも多い。例えば、AIモデルを騙す意図を持ったユーザーによる有害なプロンプトに対して誤って応答してしまったり、逆に無害な質問を拒否してしまうという問題だ。

o3を発表するライブ配信内では、「Deliberative Alignment」の手法が紹介された。同時に、OpenAIのサイト上に論文も掲載されている。

「Deliberative Alignment」の手法は、要するに、AIに人間が作成した明確で理解しやすい安全ガイドラインを直接教えるものだ。

その上で、AIが応答を生成する前に、そのガイドラインに基づいて自分で「考える」ことによって、安全性を判断するように訓練する。「このユーザーは自分を騙そうとしているぞ」、ということに、モデル自身が推論によって気付くことができるようになるのだ。

o1の安全性を、他の先進的なAIモデルであるGPT-4o、Claude 3.5 Sonnet、Gemini 1.5 Proと比較しているのが以下のプロットである。

AIをだまして有害な出力を引き出す「脱獄(jailbreak)」攻撃への耐性、ポリシーに違反する要求を適切に拒否できるか、また逆に無害なプロンプトに適切に回答できるかも評価される。

正確に拒否できるように拒否性能を高めていくと、無害なプロンプトも拒否してしまう、というように、一方を改善すると他方が悪化するトレードオフがある。

他のモデルを見てみると、Gemini 1.5 Proなどは、無害な質問に回答できているが、悪意のあるJailbreakにもうっかり回答してしまうため、プロットの左端に位置している。

ここで比較されているのはo1モデルだが、o1モデルはプロットの右上に位置しており、このトレードオフを克服し、両方を同時に改善できたことを意味している。

o1は、有害な出力を回避する能力も高いし、Overrefusal(無害な質問を拒否してしまう)も減らすことができているのだ。

o3シリーズの展望とリリーススケジュール

今回のo3とo3-miniの発表は、汎用人工知能(AGI)への道を一歩前進させる出来事だと感じられる。数学やコーディング、未知の問題解決能力において、o3は人間を凌駕するパフォーマンスを達成しつつある。

特に、ARC-AGIテストで、他モデルを引き離し、人間の子どもに匹敵するスコアを出したことは驚異的だ。o3の最高負荷設定は計算にかかる費用が非常に高いようなので、我々一般消費者が、このレベルのAIモデルを自由に使えるまでには、まだまだ時間がかかりそうであるが。

直近では、o3-miniが1月末ごろにリリースされる予定だ。o3-miniは、低コストでありながらo1を超える性能を両立したモデルであって、多くの人がo1からo3-miniに乗り換えることになるだろう。

一方、o3の一般公開は、安全性テストの進捗によって前後し、o3-miniの後に登場する予定だ。o3-miniと同じく、低負荷〜高負荷の思考時間(adaptive thinking time)を選べるようになるのかもしれない。o3 (high)の性能が楽しみでもありつつ、利用料金が一体どれだけ高額なのか、気になるところだ。

o3とo3-miniを実際に使える日も楽しみであるし、ここから一体どんな応用アプリが生まれていくのか、非常に楽しみである。